Динамическое обновление экрана что это

Что такое G-Sync, FreeSync, V-Sync и HDMI VRR? — Разбор

Всех ПК-геймеров планеты Земля, да и консольных игроков тоже, объединяет одна проблема — вертикальные разрывы изображения. И вроде бы есть куча технологий которые решают эту проблему:

Давайте сегодня раз и навсегда разберемся в технологиях адаптивной синхронизации изображения.

Для тех кто не в курсе. А в чём собственно проблема?

Чтобы изображение появилось на экране, должно произойти, как минимум, две вещи:

Обычные мониторы работают на частоте 60 Гц, то есть способны выводить 60 кадров в секунду, а игровые на 144 Гц и выше.

А вот графический процессор живет в совершенно ином мире. В играх постоянно всё меняется: колышется листва, журчит ручеёк, враги выпрыгивают из-за угла. Каждый кадр отличается по своей сложности, поэтому на их просчет уходит разное количество времени.

Иными словами, у монитора частота кадров постоянная, а у видеокарты переменная.

Вот и выходит, что за один цикл обновления монитора видеокарта может подготовить больше одного кадра или меньше.

Из-за этого мало того что страдает плавность картинки, так еще и появляются артефакты в виде вертикальных разрывов изображения. Кстати, при просмотре фильмов тоже могут появляться такие артефакты, потому что кино снимают в 24 к/с.

V-Sync

Очевидно проблема требовала решения, и еще на заре компьютерных игр оно появилось! Название у этого решения — вертикальная синхронизация или V-Sync. Наверняка вы встречали такую опцию как в настройках видеокарты, так и в играх.

Работает эта штука достаточно топорно. Фактически она просто принуждает видеокарту выводить кадры с частотой кратной частоте обновления экрана. Например, если у вас монитор 60 Гц, то максимальное количество кадров в секунду тоже будет 60, даже если ваша видеокарта способна на большее. И в общем-то часто такое ограничение вполне уместно, если у видеокарты хватает мощи и нет просадок ниже 60 к/с, но если они есть — начинаются проблемы.

При включенной вертикальной синхронизации, следующее кратное значение — это 30 к/с. Поэтому даже если ваш фреймрейт просел фактически всего на пару кадров, вы всё равно увидите падение до 30 к/с. Такой перепад мало того, что большой и очень визуально ощутимый, так ещё и будет происходить с небольшим лагом. Поэтому если стабильного FPS в 60 к/с или 30 не достичь, то включать V-Sync вообще нет никакого смысла.

Справедливости ради, чем выше герцовка монитора, тем больше мы имеем кратных значений, на которых может работать синхронизация. Поэтому на игровых мониторах V-Sync работает куда лучше.

Но история с кратными значениями — не самая главная проблема технологии. Есть другой неочевидный недостаток: вертикальная синхронизация — увеличивает задержку ввода, то есть создаёт Input Lag.

Игра медленнее реагирует на ваши действия, всё происходит с задержками и как-то плывёт в молоке, поэтому прицелиться становится гораздо сложнее. Почему так происходит?

Это интересно, смотрите! Каждый кадр рассчитывается и выводится на экран через один и тот же конвейер. Упростим его до трёх этапов.

Ну и в чём проблема, спросите вы? Дело в том, что ЦП не берется за подготовку следующего кадра, пока предыдущий не будет выведен на экран. Поэтому ограничивая количество выводимых кадров в угоду синхронизации с дисплеем, мы фактически увеличиваем задержки с которыми обновляется состояние игры! И если в каких-то простеньких играх типа пасьянса такие вещи допустимы, то в соревновательных играх вертикальная синхронизация может стать серьёзной помехой.

G-Sync

Но переживать не стоит, так как решение появилось еще в 2013 году. Именно тогда компания NVIDIA представила свою технологию адаптивной синхронизации — G-Sync. В отличие от старой технологии, G-Sync позволяет подстраивать не видеокарту под частоту обновления монитора, а наоборот заставляет монитор менять свою частоту под видеокарту!

Представляете? Так тоже можно было!

В результате мы получаем потрясающе плавную картинку без вертикальных разрывов и задержки ввода! Просто сказка! G-Sync также работает в огромном диапазоне частот. Изначально это было от 30 до 144 Гц, а сейчас уже есть поддержка до 360 Гц и может даже выше, тут скорее всё зависит от монитора.

А если фреймрейт падает ниже 60 Гц G-Sync умеет дублировать пропущенные кадры.

Получаются сплошные плюсы и проблема решена еще в 2013 году? Так почему же мы до сих пор об этом говорим?

Ну как сказать. Во-первых, эта технология закрытая, соответственно, G-Sync работает только с карточками NVIDIA, но это пол беды.

Все волшебные функции G-Sync стали возможны благодаря специальному чипу, который необходимо встроить в монитор. Естественно, эти чипы производит тоже NVIDIA и стоят они недешево. Поэтому мониторы с поддержкой G-sync в среднем стоят на 250-300$ дороже и таких моделей очень мало. То есть получилась классная, и для 2013 года революционная технология, но не универсальная и дорогая.

VESA Adaptive Sync

Поэтому уже спустя год, в 2014, Ассоциация стандартизации Video Electronics Standards Association или VESA представила открытую технологию Adaptive Sync, которая умеет, в принципе, всё то же самое, что и G-Sync, но без дорогостоящих чипов и работает на частотах от 9 до 240 Гц! Неплохо да?

Но для внедрения технологии нужно, чтобы её поддержку внедрили в прошивку и драйвер монитора, драйвер видеокарты, операционной системы и в игры!

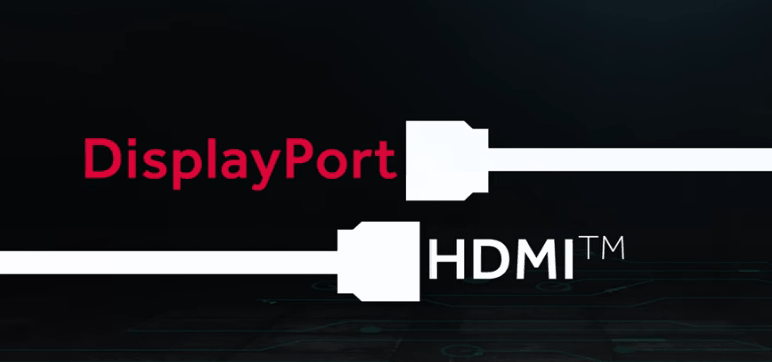

А также необходимо наличие DisplayPort версии не ниже 1.2a, так как технология стала частью именно Display Port. Как видите, чтобы технология взлетела, нужно было проделать много работы. И этой работой занималась компания AMD.

AMD FreeSync

В 2015 году AMD внедрили Adaptive Sync в драйвера своих видеокарт и назвали технологию FreeSync. Реализация от AMD быстро получила очень широкое распространение. Добавить поддержку FreeSync в монитор оказалось настолько дешево, что сейчас сложнее найти игровой монитор без этой фичи, чем с ней.

Но AMD не остановились на просто внедрении стандарта от VESA. Также они добавили поддержку HDMI, начиная с версии 1.4. А в 2017 выпустили FreeSync 2, в который добавилась поддержка HDR и компенсацию низкой частоты кадров, как в G-SYNC.

Кстати, чуть позже, FreeSync 2 переименовали в более элитное FreeSync Premium Pro, а обычный FreeSync для мониторов с частотой 120 Гц и выше стали называть FreeSync Premium. Хотя такие маркетинговые финты я не одобряю, но в остальном сплошной респект AMD за популяризацию стандарта.

Кстати, NVIDIA также в 2017 году добавила поддержку HDR и назвала это всё G-Sync Ultimate.

И вроде бы всё классно, в команде у красных и у зеленых есть по своей шикарной технологии. Но что делать, если у тебя видеокарта от NVIDIA, ты хочешь нормальную поддержку G-Sync, но покупать дорогущий монитор с этой технологией совсем не хочется? Или наоборот — не покупать же Radeon только потому что у тебя монитор с FreeSync?

G-Sync Compatible

Но в 2019 году NVIDIA пошли навстречу покупателям и добавили поддержку стандарта VESA Adaptive Sync в драйвера для своих видеокарт серии RTX, а также для карточки GTX 1080. А значит теперь можно легко насладиться лучшим из двух миров: взять себе карточку от NVIDIA и монитор с FreeSync по вкусу. Вот только есть проблема. Если на FreeSync мониторе не написано G-Sync Compatible — значит он не был протестирован NVIDIA на совместимость и никаких гарантий, что всё будет работать нормально, вам никто не даёт. А NVIDIA тестирует далеко не все, и далеко не самые доступные модели.

Поэтому инициативу по тестированию в свои руки взяло интернет-сообщество. Они составили табличку с огромным списком протестированных пользователями мониторов.

Причём всё будет работать и с видеокартами от NVIDIA и с Radeon. Всё потому, что VRR — это та же самая технология VESA Adaptive Sync, но теперь она стала ещё и частью стандарта HDMI 2.1. Именно таким образом адаптивная синхронизация реализована в консолях нового поколения. А также, вы удивитесь, в Xbox One S и One X. Да, в коробки текущего поколения от Microsoft VRR завезли даже раньше, чем HDMI 2.1.

Итоги

Что, в итоге спустя 6 лет после своего появления, технология Adaptive Sync стала фактически отраслевым стандартом. Захватив видеокарты от AMD и NVIDIA, телевизоры и даже интегрированная графика от Intel в 11-м поколении процессоров теперь поддерживает эту технологию. А это значит, что в светлом будущем мы будем жить без единого разрыва, по крайней мере, вертикального!

Почему играть с AMD Freesync лучше, чем без него. AMD FreeSync vs Nvidia G-Sync

Трехмерные игры завораживают. Новейшие технологии погружения в виртуальное пространство практически стерли границы между рисованным и живым мирами, а о том, что наше физическое тело всё еще здесь, по эту сторону экрана, и игровые образы – лишь картинка, напоминает… отсутствие поддержки монитором AMD Freesync.

Какой бы дорогущей ни была видеокарта, каким бы шустрым ни был игровой компьютер, без этой чудо-технологии изображение будет дергаться и подвисать. Итак, разберемся, что такое AMD Freesync и почему он так важен для игр, а также сравним его с аналогом конкурента Nvidia G-Sync.

Такой же важный, как FPS

Чем выше частота смены кадров в секунду (FPS), тем лучше качество графики, тем более реалистично и плавно меняется геймплэй. Это аксиома. Когда FPS достигает 60 и выше, по логике вещей изображение должно приближаться к идеалу, ан нет: от дрожи и лагов это не спасает. И дело здесь вовсе не в криворукости разработчиков игр, а в отсутствии синхронности работы GPU (графического процессора) и монитора.

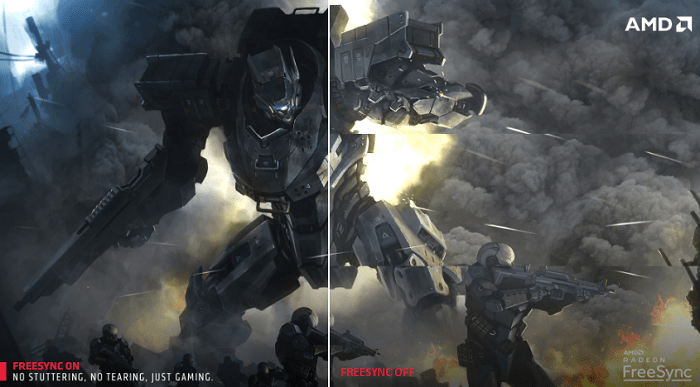

Обычные мониторы без поддержки AMD Freesync обновляют картинку с одной постоянной частотой, а GPU «рисует» каждый кадр с различной скоростью, причем разница довольно значительная. На рендеринг сложных изображений может уходить в 2-10 раз больше времени, чем простых. Если передача кадра на монитор не совпадает со временем обновления экрана (а в реальных условиях так и происходит), то вывод этого кадра задерживается до следующего обновления или его готовая часть совмещается с частями предыдущих кадров. И в том, и в другом случае на экране возникают артефакты – разрывы, дефекты и рывки изображения.

Попытки сгладить картинку при помощи V-Sync – синхронизации вертикальной развертки монитора и частоты кадров, проблему не только не решают, а усугубляют – в этом режиме к артефактам добавляется снижение FPS, а обновление экрана и скорость рендеринга все равно остаются рассогласованными.

AMD FreeSync – и есть та палочка-выручалочка, которая убирает этот камень преткновения. Она заставляет монитор обновлять картинку с той же частотой, с какой происходит отрисовка кадров. Управление синхронизацией берет на себя графический процессор AMD Radeon.

FreeSync обеспечивает плавность картинки без влияния на частоту смены кадров и значительно повышает уровень зрительного комфорта в процессе игры.

В 2017 году AMD FreeSync сделал еще один шаг в развитии – дорос до версии 2. Первое отличие второго поколения этой технологии – интеграция функционала HDR 10, который открывает разработчикам игр возможность встраивать в свои продукты функцию автонастройки дисплея – установки оптимальных параметров для конкретной игры без участия пользователя.

Кроме того, во FreeSync 2 реализована технология LFR. Она устраняет артефакты геймплэя, возникающие при низкой скорости рендеринга, путем вставки в видеоряд дополнительных сглаживающих кадров.

Какие мониторы и видеокарты поддерживают AMD FreeSync

Совместимые мониторы несложно опознать по лейблу с логотипом AMD FreeSync, который изображен на картинке в начале статьи. Сегодня их выпускают практически все производители, причем у Acer, Asus, AOC, Philips, Samsung, LG, HP и некоторых других в ассортименте не единицы, а десятки моделей таких аппаратов с разными характеристиками. Например:

Мониторов с поддержкой FreeSync 2 HDR пока не слишком много. На начало 2019 года в продажу поступило 11 моделей, среди которых:

Для работы в режиме FreeSync монитор должен подключаться к видеокарте через интерфейсы HDMI или DisplayPort 1.2a и выше – в них реализован протокол Adaptive-Sync, необходимый для управления динамической частотой обновления дисплея.

Видеокарты AMD Radeon имеют поддержку FreeSync, начиная с серии R9 3xx, в том числе R9 Nano, Fury и Fury X. Кроме того, она есть у R7 360, некоторых представителей серии R9 2xx, мобильных GPU RX 5xx и у процессоров AMD A10 со встроенным видеоядром Radeon R7 и новее.

Функционал FreeSync реализован в видеодрайвере AMD Catalyst версии 15.3 и более поздних. Драйвер выпускается для операционных систем Windows 7, 8, 8.1 и 10.

AMD FreeSync vs Nvidia G-Sync

Технология динамического изменения частоты обновления экрана есть и у конкурента AMD – компании Nvidia, и называется она G-Sync. Принцип работы FreeSync и G-Sync во многом похож, но у AMD управление синхронизацией возложено на видеопроцессор, а у Nvidia – на монитор, в который встроен специальный контроллер. Это обуславливает достоинства и недостатки обеих технологий.

Итак, за счет чего FreeSync выигрывает у G-Sync и наоборот:

Так что же лучше: FreeSync или G-Sync? Применение обеих технологий дает картинку примерно одинакового качества, поэтому назвать одну явным лидером, а вторую отстающей, увы, не получится. Графика в игре зависит от многих факторов и в большей степени – от характеристик, производительности, сочетания железа, также от свойств самой игры. Технологии улучшения графики только раскрывают заложенный в устройства потенциал. Если вам больше нравится продукция Nvidia, значит, для вас лучше G-Sync, если AMD – то FreeSync. И то, и другое однозначно неплохо, так что лучший помощник в выборе – ваш личный вкус.

Правда, мифы и особенности игровых мониторов — часть №1

В последние несколько лет явно прослеживается тренд на игровые комплектующие, и если с процессорами и видеокартами все вполне понятно, то игровые корпуса и игровые вентиляторы вызывают много вопросов. И, разумеется, стали появляться и игровые мониторы, причем массово: так, на CES 2020 было представлено около десятка моделей. Отношение к ним, в общем и целом, достаточно скептическое — дескать, обычных решений с FHD и 60 Гц полностью хватает, зачем эти навороты? Давайте разбираться, так ли это.

Раз глаз не видит больше 24 кадров, то зачем 144 Гц мониторы?

Когда речь заходит про герцовку монитора, то тут всплывают множество мифов. Самый популярный заключается в том, что раз фильмы показывают в 24 кадра в секунду, то, значит, нашему глазу этого достаточно, чтобы видеть не слайдшоу, а плавную картинку — а, значит, все эти 120 и даже 240 Гц мониторы — баловство. Однако тут важно понимать, что кадр из фильма и кадр, который видеокарта выводит на экран, сильно различаются. Кадр в фильме снимался с некоторой выдержкой, то есть он в любом случае слегка смазан и показывает движение, иными словами — внутри каждого кадра из фильма есть информация о предыдущем. Поэтому мозгу хватает всего 24 таких кадров секунду, что бы «слепить» из них плавное видео.

А вот кадр, который выводит на экран видеокарта, всегда четкий (разумеется, если мы не говорим о программном размытии в движении — motion blur), поэтому 24 таких кадра распознаются нашим мозгом как слайдшоу. Но сколько тогда нужно «компьютерных» кадров для плавности? А вот тут уже все индивидуально: в большинстве своем игроки на консолях вполне довольны 30 fps. Но на деле практически все люди замечают разницу между 30 и 60 Гц, а порог распознаваемости отдельных кадров лежит далеко за сотню — как показала презентация Nvidia на CES 2020, хватает людей, которые видят разницу между 240 и 360 Гц мониторами!

Но, разумеется, не стоит сразу бросаться покупать 240 Гц монитор. Проблема в том, что все его прелести вы сможете увидеть только в том случае, если контент будет выводиться со схожей частотой кадров. Иными словами, видео в 60 fps на YouTube будет выглядеть одинаково что на 60 Гц мониторе, что на 120 Гц, и даже на 360 Гц. В общем и целом, единственный контент, в котором вы можете увидеть под две сотни и больше кадров в секунду — это некоторые киберспортивные игры, и то для этого обычно потребуются быстрые процессоры и видеокарты.

В общем и целом, если вы не киберспортсмен, имеет смысл ограничиться 100-144 Гц мониторами. Выдать около сотни кадров в секунду в современных и не очень играх могут уже куда больше видеокарт, а разница с 60 Гц матрицами будет видна невооруженным глазом.

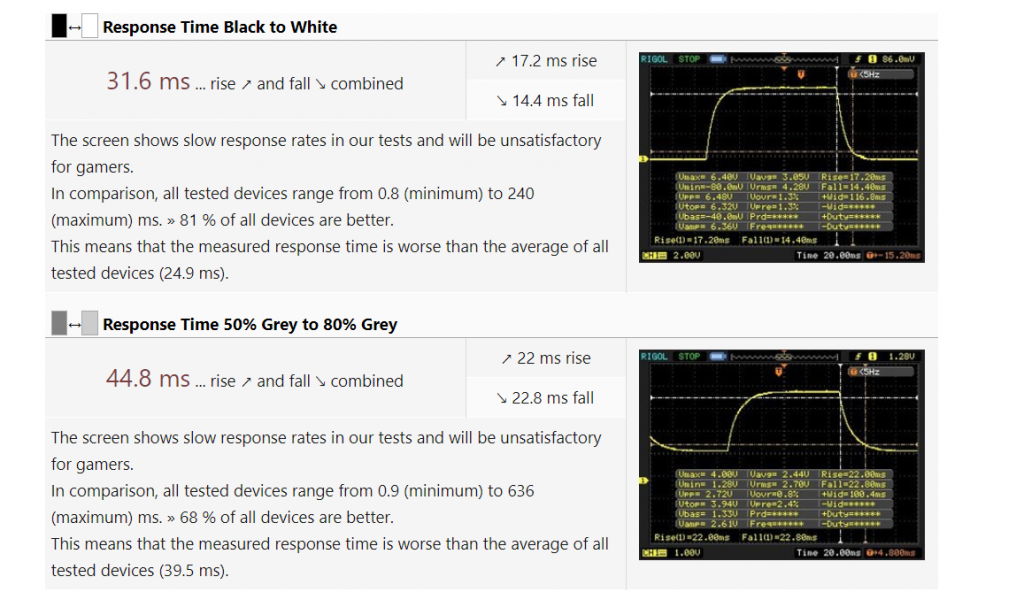

Время отклика монитора — не менее важный параметр, чем частота обновления

Думаю, многие замечали, что если быстро передвигать какое-либо окно по экрану, то за ним тянутся шлейфы. Это происходит из-за того, что пиксели в жидкокристаллических мониторах не могут изменять цвет моментально, им на это нужно определенное время — так называемая задержка матрицы или время отклика монитора.

Считать ее можно разными способами, в основном используют показатель grey-to-grey, или GtG: время, которое требуется пикселям, чтобы снизить яркость серого цвета с 80-90% до 10-50% (увы — каждый производитель тут использует свою методику). Данный показатель оказывается наиболее интересным, так как близок к реальному применению: очень редко в играх картинка резко сменяется с белой на черную (BtW, black-to-white), а вот смена яркости цветов происходит постоянно.

Типичная 60 Гц панель в достаточно дорогом ноутбуке с Core i5 и GTX 1660. Играть за ней в динамические игры будет не слишком приятно.

У обычных 60 Гц матриц такой показатель в среднем на уровне 30-50 мс. Много это или мало? Давайте посчитаем. В случае с 60 Гц монитором один кадр отображается на экране 1000 мс/60 = 17 мс. То есть время отклика соответствует отображению двух, а то и трех кадров на экране. К чему это приводит? Да ни к чему хорошему: в динамических играх матрица просто не будет успевать обновлять информацию на экране, что приведет к замыливанию картинки и шлейфам, а в худшем случае в этом цветовом месиве вы просто проглядите врага. В случае со 144 Гц мониторами все еще хуже: на каждый кадр отводится всего 7 мс.

Поэтому, выбирая игровой монитор, стоит внимательно отнестись к его времени отклика, причем не стоит смотреть на рекламные цифры в виде 1-3 мс: производители мониторов измеряют задержку различными хитрыми способами, и на деле по обзорам GtG может у таких матриц быть и 5, и 10 мс. Крайне желательно, чтобы время отображения кадра было больше времени задержки матрицы — это позволит свести шлейфы в динамических играх к минимуму.

Overdrive — разгон матрицы

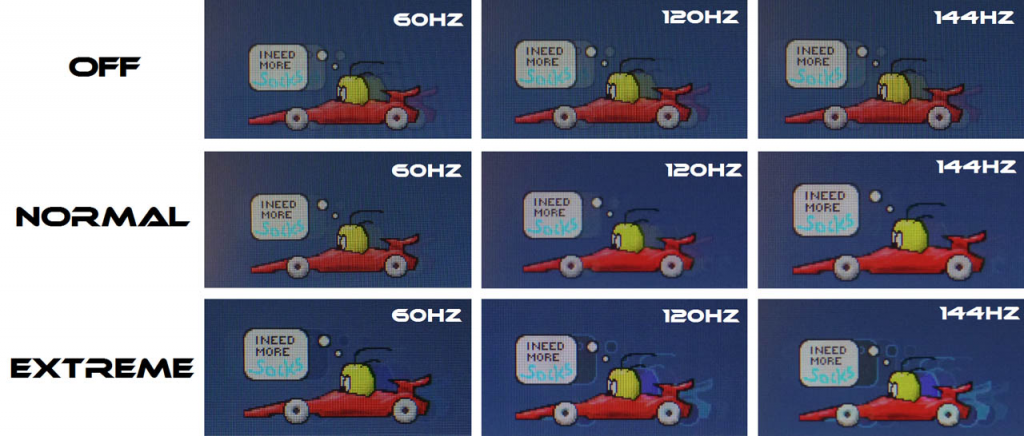

Вот мы и перешли к чисто игровым функциям. Как я писал выше, большое время отклика = смаз картинки, поэтому производители придумали технологию компенсации времени отклика, которую назвали Overdrive. В чем ее суть? Обычно переход от черного цвета к белому для LCD-матриц происходит быстрее, чем между двумя градациями серого. Причина в том, что скорость изменения состояния пикселя зависит от приложенного к нему напряжения, а переход в «белое» состояние — это подача максимального напряжения, поэтому BtW быстрее GtG (что, к слову, и используют маркетологи при указании времени отклика матриц).

Отсюда возникает простая идея: а что если в начале каждого нового кадра подавать на пиксель высокие «разгонные» импульсы напряжения, которые значительно выше тех, которые нужны для реального нового значения цвета? Это даст «толчок» пикселю и позволит ему быстрее перейти в новое положение, существенно снизив задержку матрицы. Однако ложка дегтя в том, что такое резкое повышение напряжения не может пройти бесследно: нет, пиксели от этого не выгорают, просто могут появиться различные артефакты изображения типа светлого мерцания на серых фонах в динамических играх.

Хорошо видно, что при включенном Overdrive в режиме Normal меньше всего артефактов изображения. При этом включение этой функции на Extreme начинает инвертировать цвета, что еще менее приятно, чем выключение этой опции.

По этой причине производитель монитора обычно делает несколько настроек Overdrive, в том числе и возможность полностью его выключить. И уже для конкретного монитора нужно смотреть, что лучше — опять же, об этом пишут в развернутых обзорах.

Высокая частота + низкое время отклика = приятный геймплей

Теперь сложим все воедино и посчитаем общую задержку, которую мы получаем в играх. Она складывается из времени, которое нужно процессору и видеокарте, чтобы обработать ваше нажатие и передать картинку на дисплей. Оно составляет около 50 мс и его вполне можно считать константой. Далее в дело вступает монитор: у нас есть задержка при выводе нового кадра + время отклика.

Посчитаем этот показатель для «стандартной» 60 Гц панели со временем отклика в 40 мс. Худшее время задержки при выводе нового кадра — это если только что на экран вывелся кадр, и теперь нужно ждать 1000 мс/60 = 17 мс, чтобы вывести новый (это на деле не совсем так, но мы рассматриваем наихудший случай). Далее — время отклика, еще 40 мс. В итоге общая задержка получается 50 + 17 + 40 = 107 мс.

Теперь возьмем «игровую» 144 гц матрицу с задержкой GtG в 7 мс (это опять же достаточно много для современных матриц, но мы берем худший случай). Задержка при выводе нового кадра — 1000 мс/144 = 7 мс. Еще 7 мс время отклика. В итоге получаем общую задержку в 50 + 7 + 7 = 64 мс.

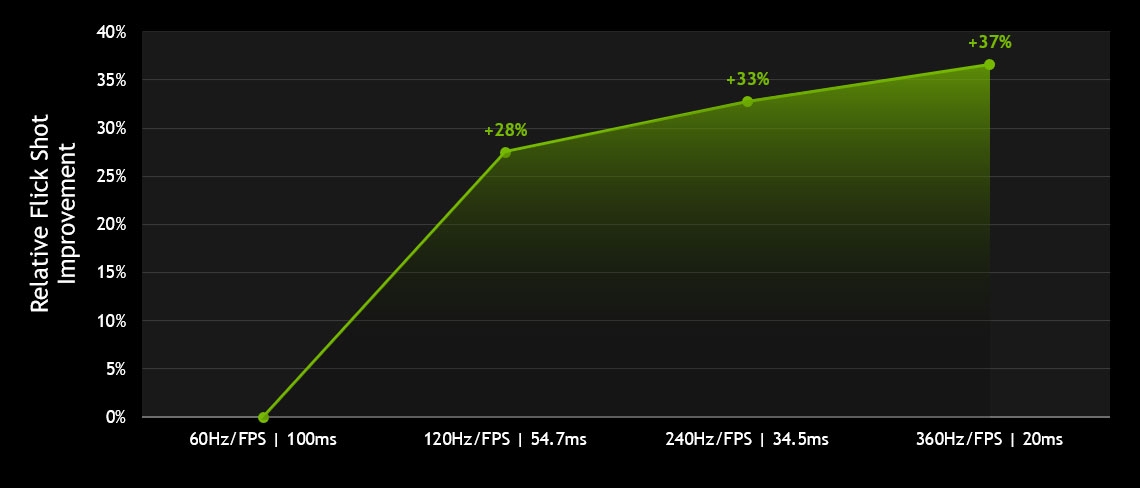

Сложно сказать, как Nvidia считала задержку, однако статистика по флик-шотам (быстрым выстрелам с разворота) вполне красноречива: чем быстрее матрица, тем их больше. Причем основной прирост идет при переходе с 60 Гц на 120, что еще раз говорит о том, что переплачивать за более быстрые панели стоит только киберспортсменам.

В итоге выигрыш в задержке более полутора раз. И это главная причина того, что на быстрых матрицах вам проще играть и попадать во врагов. Так что, как видите, игровые мониторы действительно могут так называться, и это не маркетинг.

AMD FreeSync и Nvidia G-Sync — убираем разрывы в изображении

Большая часть мониторов имеют фиксированную герцовку, однако в динамическом контенте, таком как игры, количество кадров в секунду постоянно меняется. К чему это приводит? Опять же ни к чему хорошему: изображение выводится на дисплей даже в том случае, если вывод части предыдущего кадра ещё не закончен полностью — оставшаяся часть буфера приходится на текущее обновление экрана. Именно поэтому каждый выведенный на монитор кадр при несовпадении частоты и fps будет по сути состоять из двух кадров, отрендеренных видеокартой.

Выглядит это как разрыв изображения, что очень некрасиво:

Как можно в этим бороться? Ну, самый простой способ — это включить вертикальную синхронизацию, то есть принудительно выводить на экран столько кадров, сколько в нем герц. В случае, если видеокарта может выдать большее количество fps, она будет простаивать, а вы получите приятную нерваную картинку. Ну а если монитор 60 Гц, а видеокарта может выдать всего 30-40 fps? В таком случае некоторые кадры будут отображаться на экране вдвое дольше, чем должны, то есть задержка вывода будет скакать между 17 и 34 мс. Разумеется, это будет ощущаться на деле как «вязкое» управление, и играть так будет неприятно.

Какой выход из данной ситуации? Принудительно синхронизировать частоту обновления монитора с количеством кадров, выводимых видеокартой. Иными словами, монитор будет подстраиваться под видеокарту и выводить кадр столько времени, сколько нужно видеокарте на рендеринг следующего, который он снова выведет без всяких задержек. Как итог — вы получаете по сути вертикальную синхронизацию при любом fps. Ну, почти любом.

На данный момент существуют две технологии, которые позволяют убрать разрывы при выводе динамического контента — это AMD FreeSync и Nvidia G-Sync. Разница между ними в том, что первая технология использует для синхронизации частоты развертки и fps видеокарту, а данные об этом передаются по DisplayPort. Вторая технология требует в мониторе наличия специального чипа, который пропускает через себя видеопоток с видеокарты и «подгоняет» под него частоту обновления монитора. Очевидно, что второй подход дороже, причем временами значительно: переплата за чип от Nvidia доходит до 10-20 тысяч рублей.

Что же лучше? Еще год назад я бы сказал, что этот вопрос не корректен: видеокарты от AMD умеют работать только с FreeSync, а видеокарты от Nvidia умели тогда работать только с G-Sync. Однако с учетом того, что видеокарты GTX 1000 и RTX 2000 используют видеоинтерфейс DisplayPort 1.2, дабы соответствовать требованиям VESA компании Nvidia пришлось некоторое время назад добавить в вышеуказанные видеокарты поддержку FreeSync под видом G-Sync Compatible.

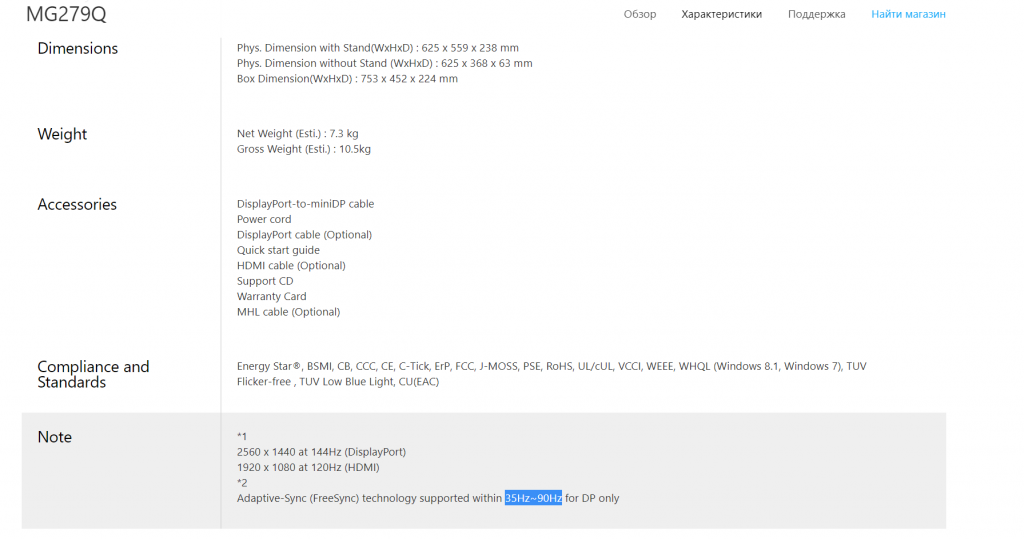

Выходит, что переплачивать за G-Sync теперь нет смысла? Опять же не совсем так. В теории, FreeSync может работать на частотах обновления монитора от 9 до 240 Гц, чего более чем достаточно для подавляющего большинства мониторов и игр. Но что мы видим на практике? Многие даже достаточно дорогие мониторы с ценником выше 1000 долларов поддерживают адаптивную герцовку лишь в узком диапазоне 48-90 Гц (весь список мониторов есть тут). И это при том, что сами они могут быть и 144 Гц! То есть получается, что или вы теряете преимущества быстрой матрицы и играете с

60 fps, или же вы забываете про FreeSync и играете со 100+ fps, но терпите разрывы изображения.

144 Гц, IPS, разрешение 2К — и поддержка FreeSync мелким текстом внизу: от 35 до 90 Гц. Смысл в ней в таком диапазоне не совсем понятен.

Разумеется, есть и такие мониторы, которые поддерживают FreeSync в диапазоне от 48 до 240 Гц, но их очень немного. При этом у мониторов с G-Sync такой проблемы нет: все они гарантированно поддерживают адаптивную герцовку в диапазонах от 30 Гц до родной частоты обновления матрицы. Согласитесь, это куда приятнее и охватывает весь диапазон «играбельного» fps.

В итоге ситуация получается следующей: для пользователей видеокарт от AMD выбора нет, не хотите видеть разрывы — берите монитор с FreeSync, хотите при этом высокую герцовку — придется поискать подходящее решение, которое зачастую может быть дороже видеокарты. Для пользователей видеокарт от Nvidia ситуация интереснее: если хотите плавную картинку без разрывов при любом нормальном fps — имеет смысл переплатить за монитор с G-Sync. Но если есть желание сэкономить — можете окунуться в мир FreeSync мониторов, которых на данный момент около 1000 штук. Драйвером поддерживаются они все, так что выбор по герцовке остается только за вами.

Во второй и заключительной части статьи мы поговорим про остальные «фишки» игровых мониторов, такие как многозонная подсветка, вставка черного кадра и некоторые другие.