Дипфейк что это такое простым

Deepfake: краткая история появления и нюансы работы технологии

Немного истории

Технологии синтезирования видео и аудио нельзя назвать новыми. Они разрабатываются с конца 90-х годов XX века. Конечно, разные попытки делались и до этого, но мы говорим о тех технологиях, которые получили продолжение. Так, в 1997 году компания Video Rewrite представила технологию, которая позволяла сформировать видео, где артикуляция лица совпадала с синтезированной аудиодорожкой. Т.е. моделировалась артикуляционная мимика лица, которая полностью соответствовала синтезированной компьютером аудиодорожкой.

Но это были лишь первые попытки, которые активно развивались в течение двух десятков лет. Сейчас нам доступны технологии обработки голоса, объединения компьютерной графики с реальными видео и многое другое. Не везде применяется ИИ, но все же самые реалистичные системы сформированы на базе машинного обучения.

Появление «настоящих» дипфейков

Технология Deepfake упрощает процесс синтезирования изображения и создания звуковых дорожек с заданными параметрами за счет использования нейронных сетей. Они обучаются на сотнях или даже тысячах примеров лиц и голосов, с ними связанными. После этого ИИ показывает весьма впечатляющие результаты.

Нет сомнения, что с течением времени будут появляться все более реалистичные дипфейки. Уже сейчас они никого не удивляют, а в ближайшем будущем и вовсе станут привычным делом. Но кто отвечает за развитие технологий, где они используются, как работают и чего нам ожидать в будущем?

Современные игроки

Большинство крупнейших технологических игроков и развлекательных компаний активно исследуют отрасль «синтетических медиа». Amazon стремится сделать голос Алексы более реалистичным, Disney изучает, как использовать технологию смены лица в фильмах, а производители оборудования, такие как Nvidia, расширяют границы синтетических аватаров, а также услуг для кинопроизводства и телевидения.

Но есть и организации, которые создают технологии, позволяющие отличить подделку от реальности. В их число входят, например, Microsoft и DARPA.

К слову, у большинства ПО по созданию дипфейков открытый исходный код, что дает возможность работать с дипфейками даже небольшим компаниям. Проектов достаточно много. Это, например, Wombo, Аvatarify, FaceApp, Reface, MyHeritage и многие другие.

Как создаются дипфейки

Классическая компьютерная обработка изображений использует сложные алгоритмы, созданные при помощи традиционного программного обеспечения. Эти алгоритмы чрезвычайно сложны. Как говорилось выше, совсем недавно дипфейки представляли собой контролируемую модель, которой управляют разработчики. Подавляющее большинство элементом артикуляционной мимики жестко прописывалось в алгоритмах.

Правда, для того, чтобы создать убедительный дипфейк, требуются большие объемы видео, статические изображения, голосовые записи, а иногда даже сканирование головы реального актера с последующим анализом в качестве обучающих вводных данных. Например, клиенты Synthesia в течение примерно 40 минут снимают на видео, как они зачитывают заранее подготовленную речь, чтобы потом этот контент использовался для обучения нейронными сетями.

Несмотря на весьма впечатляющие результаты, дипфейки, создаваемые ИИ, не являются идеальными. У дипфейков есть ряд хорошо заметных (не для человека, для специализированного ПО) признаков, которые пока еще позволяют отличить реальность от вымысла. Это, например, нюансы освещения и теней, мигание, артикуляция, выражение и тон голоса. Для создания убедительного дипфейка все это нужно правильно комбинировать.

Изображения и видео

Достаточно часть в этом направлении используется Variational Autoencoder – VAE. Это генеративная модель, которая находит применение во многих областях исследований: от генерации новых человеческих лиц до создания полностью искусственной музыки. Что касается видео, то VAE позволяет достаточно быстро перенести особенности мимики и артикуляции определенного человека на сформированную объемную модель. VAE используется достаточно давно, но дипфейк, созданный при помощи этой технологии, несложно выявить.

А вот с 2017 года развиваются генеративные состязательные сети (GAN). Здесь в единое целое объединены, по сути, две нейронные сети. Одна, «дискриминатор», определяет реалистичность модели, созданной другой нейросетью. На выходе получается модель, которая была «одобрена» и является наиболее реалистичной.

Что дальше?

Дипфейки также поднимают множество вопросов о том, кому какой контент принадлежит, что делать с лицензиями и как наказывать нарушителей. Так, уже сейчас актеры заключают контракты с компаниями, разрешая использовать их образ и голос в рекламе или фильмах. Но, вероятно, некоторые компании будут использовать дипфейки знаменитостей в своих целях без всяких разрешений.

Дипфейки: кому и зачем они нужны

Дипфейк (deepfake) – производная от «глубокого обучения» и «подделки»; штука, про которую сегодня большинство говорит с опаской. Само название как бы кричит: «Я зло!». А наша гипотеза в том, что это технология с огромнейшим позитивным потенциалом, которая пока используется в основном как игрушка в руках неразумного человека. Что это и как на самом деле? Давайте разбираться.

Дипфейки используют технологии искусственного интеллекта для синтеза изображений, в результате чего один персонаж как бы накладывается на другого и получается «комбо»: оживает Мона Лиза или Терминатором становится Бред Питт.

Эта технология позволяет легко манипулировать аудио- и видеоконтентом, а по мере того, как она развивается, разобраться, где правда, а где фейк – становится всё сложнее. Так в прогремевшем на весь интернет видео Барак Обама критикует Дональда Трампа, называя его «полным провалом». В США считается, что дипфейки представляют угрозу национальной безопасности. В Калифорнии некоторые виды дипфейков даже запретили законодательно.

Чаще всего дипфейки создаются с помощью генеративно-состязательной сети (GAN), в ней 2 системы: генератор и дискриминатор. Они работают как пара студентов в университетской микрогруппе: один предлагает идеи, другой их критикует. Генератор создаёт изображения, а обученный на реальных фотографиях дискриминатор подсказывает, что нужно исправить.

Заметим, что технология постоянно развивается. Так, например, алгоритм BigGAN от Google и NVIDIA позволяет не просто воссоздавать, а создавать лица несуществующих людей, которые невозможно отличить от настоящих.

Недавно разработчики из Samsung и Сколково представили алгоритм на основе BigGAN, который позволил «оживить» Мону Лизу, то есть для (относительно) хорошего результата нейросети достаточно одного кадра. Нейросеть работает лучше всего, если дать ей несколько изображений человека, снятых под разными углами.

Сейчас на рынке десятки приложений, с помощью которых любой может сделать дипфейк, самые известные – Zao, DeepFaceLab, Deepfakes web β.

Конкурентные преимущества приложений похожи на классический треугольник «цена-качество-скорость»:

– Скорость. Одни выполняют конверсию за секунды, другим нужны часы.

– Необходимое количество исходного материала. Некоторым достаточно одной фотографии.

– Точность итогового результата. Обычно чем больше исходного материала и дольше идёт процесс анализа, тем точнее получается результат.

Год назад NVIDIA представила нейросеть, которая может превращать скетчи в реальные изображения. Технологию назвали GauGAN в честь Поля Гогена. Такую штуку можно использовать в архитектуре, дизайне, создании игр, да где угодно.

Технологию, которая лежит в основе дипфейков, можно использовать и в киноиндустрии, рекламе или при реконструкции исторических событий. Например, с её помощью была сделана социальная реклама, в которой Дэвит Бэкхем рассказывает об опасности малярии на 9и языках.

Музей Сальвадора Дали во Флориде «оживил» художника с помощью всё той же технологии. В результате зрители могли пообщаться с Дали, послушать его истории и даже получить совместное селфи. Для этого потребовалось 6000 фотографий Дали, 1000 часов машинного обучения и 145 видео с актером похожих пропорций, а ещё горы интервью и писем художника, чтобы воспроизвести голос, акцент и манеру речи.

Кстати, алгоритм GAN предлагается использовать и в астрофизике для того, чтобы избавляться от помех и шумов при съёмке космических объектов и получать качественные изображения.

Если вы тоже считаете, что человеческий интеллект создан для творчества, а машинный – для работы, присоединяйтесь к нам на YouTube или в Facebook!

«Блокнот» рассказывает о современных технологиях и предупреждает, что использовать их могут мошенники.

В современном мире никого не удивишь фотографией, обработанной с помощью фотошопа, — политики таким образом убирают дорогие часы, а звезды — лишние килограммы. А вот видео с цифровым двойником — новый тренд, «Блокнот» рассказывает, кто и зачем использует подобные технологии.

Дипфейк — это технология, позволяющая с помощью машинного обучения моделировать поведение и внешность человека на видеозаписи. Имя технология получила от сочетания deep learning («глубокое обучение») и fake («подделка»).

Фейковые видео могут быть вполне легальными. Лондонский стартап Synthesia занимается созданием видеоаватаров реальных людей. В основном — для корпоративных видеороликов, а также для общения с клиентами и внутреннего обучения. Например, британская компания Ernst & Young (EY) уже использует видеоаватары для общения сотрудников с клиентами вместо личных встреч.

Видео создаются на основе записи человека, где он запечатлен с разных ракурсов — алгоритмы учатся на данных о мимике и голосе человека, чтобы затем их скопировать. Цифровая копия может воспроизвести текст любого объема, а также на разных языках — это помогает в общении с иностранными партнерами. В Ernst & Young делают копии только тех сотрудников, которые дали на это согласие.

А что закон?

Эксперты уверены, что через 10-15 лет сгенерированные нейросетями видео станут повседневными. Правда, есть опасность, что такие ролики будут использовать мошенники. В фантастических фильмах уже показано такое — в блокбастере Федора Бондарчука «Вторжение» дипфейки использовали инопланетяне, чтобы натравить землян на главную героиню картины.

В большинстве стран мира не существует четкого регулирования дипфейков, хотя об их опасности говорят повсеместно.

В Китае с 2020 года запрещено публиковать дипфейки без специальных пометок, это считается уголовным преступлением. Похожий закон принят в штате Калифорния — он запрещает публиковать аудио, видео и изображения, которые могут повлиять на восприятие слов или действий политиков.

В России есть закон о фейках, теоретически он может быть распространен и на фейковые видео, но только в том случае, если информация, распространяемая с его помощью, угрожает жизни, здоровью, безопасности, общественному порядку, а также работе важных объектов (например, транспорта, больниц и банков).

Дипфейки уже ближе, чем кажется

Дипфейки активно используют во всем мире во время презентаций, а также в индустрии развлечений. Например, компания Nvidia во время одной из презентаций использовала технологии подмены образа генерального директора Дженсена Хуанга. Его заменили на 14 секунд и зрители так и не узнали бы об этом, если бы компания сама не рассказала.

В TikTok стали популярными ролики с цифровой копией Тома Круза, созданной искусственным интеллектом. Их разработал бельгийский специалист по визуальным эффектам Кристофер Уме, который основал собственную студию дипфейк-технологий Metaphysic. Студия создает различные визуальные эффекты для крупных заказчиков.

В августе этого года в рунете стал вирусным ролик о выборах с министром иностранных дел РФ Сергеем Лавровым, главврачом больницы №40 в Еоммунарке Денисом Проценко и министром обороны РФ Сергеем Шойгу. В действительности в съемках ролика они не участвовали, использовались их цифровые копии.

В 2020 году в Великобритании жителей страны с новым годом поздравляли сразу две королевы. Настоящая произнесла речь на BBC, а фейковая — на канале Channel 4. Руководство канала заявило, что их акция призвана проинформировать людей о том, как далеко вперед продвинулись современные технологии, и как широки стали их возможности для дезинформации.

В 2018 году в интернете появилось поддельное видео с Бараком Обамой, который критиковал действующего на тот момент президента США Дональда Трампа. Роль Обамы в действительности исполнил комик и режиссер Джордан Пил.

Как выявить дипфейк

Но кроме развлечений, такие видео могут быть использованы мошенниками — например, для шантажа или введения в заблуждение.

«Пока технология не идеальна. Искусственный интеллект не умеет создавать 3D-модели лиц, а лишь работает с двухмерными изображениями — пытается их повернуть, изменить размер или исказить и так далее, — отметил Павел Коростелев, эксперт компании «Код безопасности». — Стоит обращать внимание на различные артефакты изображения: мерцания, слишком гладкую кожу, явное искажение границ. Microsoft представила для этого инструмент Video Authenticator».

В «Лаборатории Касперского» также советуют обращать внимание на характерные признаки подделки: неровные движения, перемены в освещении соседних кадров, различия в оттенках кожи. Если человек на видео моргает странно или не моргает вообще, то велика вероятность того, что это фейк. Также признаками дипфейка являются плохая синхронизация движения губ с речью и цифровые артефакты в изображении — например, излишняя пикселизация.

Ранее «Блокнот» рассказывал о том, что власти определились с фейками о коронавирусе, за которые будут карать россиян. Среди них — искажение статистики, ложь о смертях после прививки, а также теории заговора и чипизация населения с помощью вакцин. За распространение такой информации физическим лицам и СМИ будет грозить уголовная ответственность и административные штрафы. Мониторингом соцсетей и мессенджеров сейчас занимается Росздравнадзор — посты антипрививочников ищут в популярных соцсетях.

Дипфейки и другие поддельные видео – как защитить себя?

Дипфейки: новые технологии обмана

Слово дипфейк (Deepfake) является составным и происходит от deep learning (глубинное обучение) и fake (фейк, подделка). Глубинное обучение – это сложный метод на базе искусственного интеллекта, который использует многоуровневые алгоритмы машинного обучения для извлечения все более сложных характеристик из необработанных входных данных. При этом ИИ способен обучаться на неструктурированных данных – таких как изображения лиц. Например, ИИ может собрать данные о движениях вашего тела.

Затем эти данные могут быть обработаны для создания дипфейк-видео при помощи так называемой генеративно-состязательной сети (Generative Adversarial Network, или GAN). Это еще одна специализированная система машинного обучения. В ней задействовано две нейросети, которые состязаются друг с другом, изучая характеристики учебных наборов данных (например, фотографий лиц) и создавая новые данные на базе этих характеристик (то есть новые «фотографии»).

Поскольку такая сеть постоянно сверяет создаваемые образцы с исходным учебным набором, поддельные изображения выглядят все более и более правдоподобно. Именно поэтому угроза, которую представляют дипфейки, постоянно растет. Кроме того, сети GAN могут создавать и другие поддельные данные помимо фотографий и видео. Например, дипфейк-технологии могут использоваться для имитации голоса.

Примеры дипфейков

Качественные дипфейки с участием знаменитостей найти несложно. Один из примеров – фейковое видео, выложенное актером Джорданом Пилом. Он записал небольшую речь голосом Барака Обамы, которая затем была совмещена с видеосъемкой реального выступления этого политика. Затем Пил продемонстрировал, как выглядят обе составляющие этого видео, и призвал своих зрителей критически относиться ко всему, что они видят.

Видео с руководителем Facebook Марком Цукербергом, в котором тот якобы говорит о том, как Facebook «управляет будущим» с помощью украденных данных пользователей, появилось в Instagram. На оригинальном видео запечатлена его речь в связи со скандалом о «русском следе» в выборах президента США – для создания фейка оказалось достаточно фрагмента длиной всего в 21 секунду. Однако голос Цукерберга был сымитирован не так хорошо, как в пародии Джордана Пила на Обаму, и фальшивку было легко распознать.

Впрочем, даже менее качественные подделки могут вызвать живой отклик. Видео с «пьяной» Нэнси Пелоси, спикером Палаты представителей США, набрало миллионы просмотров на YouTube – а это был всего лишь фейк, сделанный с помощью замедления реального видео, чтобы создать видимость невнятной речи. Кроме того, немало известных женщин внезапно обнаружили себя в роли порнозвезд – их лица были вмонтированы в порнографические ролики и изображения.

Мошенничество и шантаж с использованием дипфейков

Дипфейк-видео неоднократно использовались в политических целях, а также как способ мести. Однако сейчас к этим технологиям все чаще стали прибегать для шантажа и проворачивания крупных афер.

У генерального директора британской энергетической компании мошенники смогли выманить 220 000 евро с помощью дипфейковой имитации голоса руководителя головной компании, якобы запросившего срочно перевести указанную сумму. Подмена была настолько натуралистичной, что обманутый директор не стал перепроверять информацию, хотя средства переводились не в головной офис, а на сторонний счет. Только когда «босс» запросил еще один трансфер, его собеседник заподозрил неладное, но переведенные деньги уже бесследно исчезли.

Во Франции недавно прогремела афера, в которой, правда, технология дипфейков не использовалась, – мошенник по имени Жильбер Шикли выдавал себя за министра иностранных дел Франции Жана-Ива Ле Дриана, с большой точностью воссоздав не только его внешность, но и обстановку рабочего кабинета. Аферист от имени министра обращался к состоятельным частным лицам и руководителям компаний с просьбой выделить средства на выкуп французских граждан, оказавшихся в заложниках террористов в Сирии. Таким образом ему удалось выманить несколько миллионов евро. Сейчас это дело рассматривается в суде.

Авторы дипфейков могут шантажировать руководителей крупных компаний, угрожая опубликовать фейковое видео, способное подорвать их репутацию, если те не заплатят отступные. Также мошенники могут, например, проникнуть в вашу сеть, сымитировав звонок от IT-директора и обманом заставив сотрудников предоставить пароли и привилегии доступа, после чего ваши конфиденциальные данные окажутся в полном распоряжении хакеров.

Фейковые порноролики уже использовались с целью шантажа женщин-репортеров и журналисток, как, например, произошло в Индии с Раной Айюб, которая занималась разоблачением злоупотреблений властью. Технологии производства дипфейков дешевеют, так что можно прогнозировать рост их использования в целях шантажа и мошенничества.

h2>Как защититься от дипфейков?

Проблему дипфейков уже пытаются начать решать на законодательном уровне. Так, в штате Калифорния в прошлом году было принято два закона, ограничивающих использование дипфейков: законопроект AB-602 запретил использование технологий синтеза изображений человека для изготовления порнографического контента без согласия изображаемых, а AB-730 – подделку изображений кандидатов на государственные посты в течение 60 дней перед выборами.

Но окажутся ли эти меры достаточными? К счастью, компании в сфере безопасности постоянно разрабатывают все более совершенные алгоритмы распознавания. Они анализируют видеоизображения и замечают незначительные искажения, возникающие в процессе создания фальшивки. Например, современные генераторы дипфейков моделируют двумерное лицо, а затем искажают его для встраивания в трехмерную перспективу видеоролика. По тому, куда направлен нос, легко распознать подделку.

Пока что технологии создания дипфейков еще недостаточно совершенны, и признаки подделки зачастую видны невооруженным глазом. Обращайте внимание на следующие характерные признаки:

Однако по мере совершенствования технологий ваши глаза все реже будут распознавать обман – а вот хорошее защитное решение обмануть будет куда сложнее.

Уникальные антифейковые технологии

Некоторые развивающиеся технологии уже помогают создателям видеоконтента защищать его аутентичность. С помощью специального шифровального алгоритма в видеопоток с определенными интервалами встраиваются хеши; если видео будет изменено, хеши также изменятся. Создавать цифровые сигнатуры для видео также можно, используя ИИ и блокчейн. Это похоже на защиту документов водяными знаками; в случае с видео, правда, трудности заключаются в том, что хеши должны оставаться неизменными при сжатии видеопотока различными кодеками.

Еще один способ борьбы с дипфейками – использовать программу, вставляющую в видеоконтент специальные цифровые артефакты, маскирующие группы пикселей, по которым ориентируются программы для распознавания лиц. Этот прием замедляет работу дипфейк-алгоритмов, и в результате качество подделки будет более низким, что, в свою очередь, снизит вероятность успешного использования дипфейка.

Лучшая защита – соблюдение правил безопасности

Технологии – не единственный способ защититься от дипфейк-видео. В борьбе с ними весьма эффективны даже базовые правила безопасности.

Так, например, встраивание автоматических проверок во все процессы, связанные с перечислением денежных средств, позволило бы предотвратить множество мошеннических действий, в том числе и с использованием дипфейков. Также вы можете:

Помните, что, если хакеры начнут активно использовать дипфейки для проникновения в домашние и корпоративные сети, соблюдение базовых правил кибербезопасности станет важнейшим фактором в минимизации рисков:

Как будут развиваться дипфейки?

Дипфейки эволюционируют угрожающими темпами. Еще два года назад подделки легко было отличить по низкому качеству передачи движения; кроме того, люди в таких видео практически никогда не моргали. Однако технологии не стоят на месте, и дипфейки последнего поколения выполнены заметно более качественно.

По приблизительным оценкам, сейчас по Сети гуляет более 15 000 дипфейк-видео. Некоторые из них шуточные, но есть и такие, которые создавались для манипуляций общественным сознанием. Сейчас изготовление нового дипфейка занимает от силы пару дней, так что вскоре их может стать намного больше.

Дипфейки: дезинформация или шаг в будущее?

Фейки на выборах и «воскрешение» из мертвых

Совсем недавно, на рубеже XX и XXI веков, сверхпопулярной была программа Photoshop. Теперь на смену ей пришли нейросети, а именно дипфейки (Deepfake). Эта технология куда опаснее, но также перспективнее прежней возможности грубо вырезать лица людей с фотографий и приклеивать их на другие снимки.

Другая история произошла в 2020 году на выборах в Индии. В Дели лидер одной из оппозиционных партий Маноджа Тивари сделал заявление на хинди и на диалекте хариани. При этом говорить на этом языке он не умел. Пойти на обман Маноджа Тивари решился скорее всего из-за желания завоевать голоса рабочих-мигрантов в Дели. Они как раз говорят на диалекте хариани.

И подобных случаев уже много. В истории с лидером индийской оппозиции интересно то, что он так и не признался в использовании технологии: доказать это довольно сложно, вот и признаваться необязательно.

Еще один пример — фильм «Би-би-си» «Добро пожаловать в Чечню» про активистов, критикующих власть. Создатели картины не стали «замазывать» лица оппозиционеров, а наложили на них дипфейки активистов, живущих в Нью-Йорке.

Можно ли вычислить дипфейки

Сложность в борьбе с нечестным использованием технологии заключается в том, что подделки будут становиться только качественнее.

Дипфейк — это генеративно-состязательная сеть. В ней есть генератор и дискриминатор. Генератор создает подделку, а дискриминатор критикует и указывает на ее недостатки. После этих замечаний генератор снова приступает к работе. В итоге появляется очень точный фейк.

Некоторые страны приняли решение регулировать дипфейки законом.

В 2020 году Калифорнийский и Стэндфордский университеты смогли повысить точность выявления дипфейков до 97%. Ученые исследовали виземы и фонемы.

Виземы — визуальное выражение того, как произносится тот или иной звук. Условно — мы говорим что-то и наш рот как-то движется. Филологи пытаются сравнить виземы в дипфейках и в оригинальных видео. Действительно, виземы в дипфейках выглядят немного иначе. Если обучить алгоритмы на таком поле данных, точность распознавания подделки будет достаточно высокая.

Другой способ вычисления обмана — изучение того, как шумит реальное и поддельное видео. Шум в дипфейках немного другой, и часто это удается услышать.

Другая сторона дипфейков

С помощью генеративных нейронных сетей можно создавать контент, используя минимальное количество данных. С этой точки зрения технология связана совсем не с «пересадкой» лиц для веселья, а с практической целью. Сейчас по одной фотографии и тексту возможно генерировать видео. Текст синтезируется в аудио, по аудио анимируются фотографии — в итоге мы получаем говорящего спикера. С помощью этого комплекса алгоритмов можно очень быстро создавать видеоконтент.

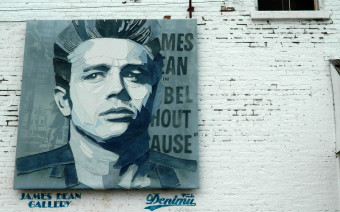

Дипфейки могут «воскрешать» любимых актеров. Например, Филип Сеймур Хоффман и Пол Уокер, умершие во время съемок фильмов с их участием («Голодные игры: Сойка-пересмешница» и «Форсаж 7» соответственно), были воссозданы в цифровом виде. А Кэрри Фишер «воскресили» для съемок в девятом эпизоде «Звездных войн».

Мария Чмир, гендиректор Deepcake.io, утверждает, что скоро появится инструмент, который полностью изменит интерактивность. Сегодня все, что дают зрителям, — это выбрать концовку сериала. В будущем с помощью дипфейков мы сможем оказаться внутри киновселенной вместе со своими друзьями. Будет возможность и менять надоевших актеров. Ведь генеративные нейросети позволяют существенным образом редактировать, видоизменять и трансформировать контент.

Именно поэтому дипфейки — это не только манипуляция и дезинформация. С помощью них можно будет снимать фильмы со спецэффектами, оживлять персонажей и в целом добавить новый опыт потребления контента.