Дискретный возраст что это

Значение слова «дискретный»

Источник (печатная версия): Словарь русского языка: В 4-х т. / РАН, Ин-т лингвистич. исследований; Под ред. А. П. Евгеньевой. — 4-е изд., стер. — М.: Рус. яз.; Полиграфресурсы, 1999; (электронная версия): Фундаментальная электронная библиотека

дискре́тный

2. спец. изменяющийся между несколькими различными стабильными состояниями, существующий лишь в отдельных точках

Фразеологизмы и устойчивые сочетания

Делаем Карту слов лучше вместе

Спасибо! Я стал чуточку лучше понимать мир эмоций.

Вопрос: теснение — это что-то нейтральное, положительное или отрицательное?

Синонимы к слову «дискретный»

Предложения со словом «дискретный»

Сочетаемость слова «дискретный»

Что (кто) бывает «дискретным»

Понятия со словом «дискретный»

О дискретном эквиваленте преобразования Лапласа см. Z-преобразование.В математике дискретный оператор Лапласа — аналог непрерывного оператора Лапласа, определяемого как отношения на графе или дискретной сетке. В случае конечномерного графа (имеющего конечное число вершин и рёбер) дискретный оператор Лапласа имеет более общее название: матрица Лапласа.

Отправить комментарий

Дополнительно

Предложения со словом «дискретный»

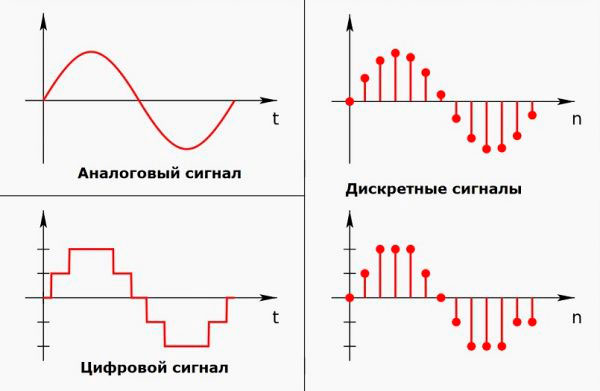

Она началась ещё в 1980-е годы с переходом с аналоговых на дискретные значения с целью их хранения и обработки, и первыми цифровыми продуктами были электронные часы, CD-проигрыватели и интернет-маршрутизаторы.

Однако имеется много видов машин, которые удобно считать машинами с дискретными состояниями.

Наша модель для описания ритмической активности ансамбля является дискретной – это делает её гораздо более интерпретируемой, чем непрерывные модели, и гораздо менее вычислительно сложной, а значит, легко масштабируемой.

Что такое дискретность (дискретная математика, сигнал, величины, видеокарты, а так же дискретность в биологии)

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Знать все обо всем попросту невозможно. Человек на протяжении всей жизни стремится познать себя и окружающую его действительность.

Вот и сегодня мы продолжим свой познавательный процесс, поговорим о новом (для многих) термине – « дискретность», и о сферах, где он применяется.

Дискретность – это …

Наш мир непрерывен, мы живем в постоянно меняющемся времени и пространстве. Наша жизнь тоже непрерывна до своего конечного момента. Согласитесь, невозможно сейчас жить, через час не жить, а потом вновь возродиться.

В противопоставлении непрерывности существует дискретность. В переводе с «вечно живого» латинского языка «дискретность» (discretus) обозначает прерывность, разделенность.

Дискре́тность (от лат. discretus — разделённый, прерывистый) — свойство, противопоставляемое непрерывности, прерывистость. Синонимы к слову дискретный: корпускулярный, отдельный, прерывистый, раздельный и т. п.

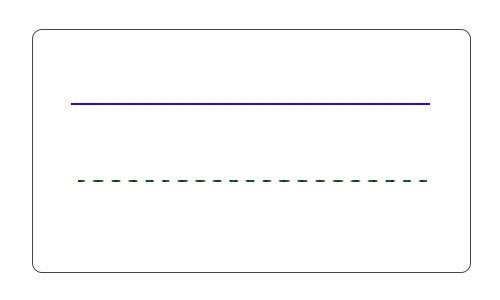

Например, линия непрерывна (на определенном промежутке), пунктир – прерывистая линия. Поэтому пунктир можно назвать дискретной линией. Проиллюстрирую понятие дискретности:

Дискретность можно толковать следующим образом:

Далее проанализируем особенности применения термина в различных областях.

Дискретная математика

Если коротко и простыми словами, то дискретная математика (ДМ)– это наука, которые изучает математические объекты, принимающие отдельные (дискретные) значения.

ДМ условно подразделяется на пять направлений:

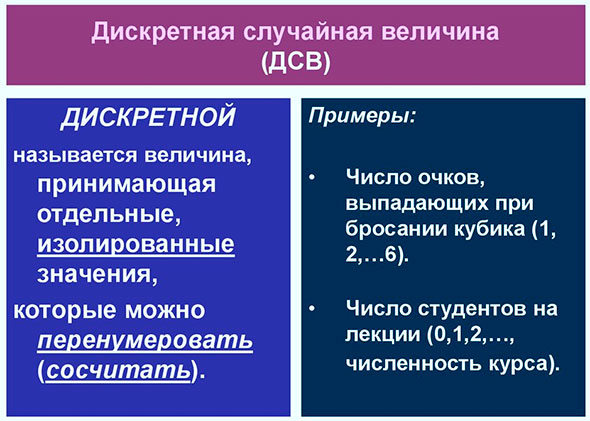

Дискретная величина

Дискретность какой-либо величины подразумевает, что ее значения можно пронумеровать, измерить и посчитать.

Такими величинами оперирует, например, экономика. Различные экономические показатели фиксируют и рассчитывают с определенной периодичностью (например, раз в месяц, квартал, полугодие и т.д.). Таким образом, изменение показателей происходит не непрерывно во времени, а как бы «скачками» через установленные интервалы времени.

Дискретность в информатике

Программирование – это создание программ с использованием различных алгоритмов и языков программирования. Алгоритмы являются дискретными объектами, потому как представляют собой четкое последовательное выполнение ранее разработанных упрощенных шагов-действий (подпрограмм).

Только исполнение шага № 1 дает возможность выполнить шаг № 2 и т.д. Таким образом, этот процесс дискретен.

Как пример – алгоритм умывания (компьютерные программы создаются по тому же принципу):

Дискретная видеокарта

Видеокарта – один из важнейших элементов компьютера, отвечающий за визуализацию информации. Конструкция компа может быть оснащена либо интегрированной (встроенной) видеокартой, либо дискретной. Встроенная размещается в процессоре или на материнской плате, т.е. она неотделима от конкретного компьютера.

Дискретная видеокарта выполнена на отдельной плате, снабжена индивидуальным графическим процессором и памятью. Поэтому она более производительна, чем интегрированная.

Часто в компьютерах применяются видеокарты обоих видов, что позволяет пользователю при необходимости переключаться с одной на другую.

Дискретность в биологии

Все биологические объекты состоят из отдельных (дискретных) «кирпичиков», которые в совокупности образуют единый организм. Например, скелет человека состоит из костей, кости –из костной ткани, она, в свою очередь – из клеток.

Автор статьи: Елена Копейкина

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Эта статья относится к рубрикам:

Комментарии и отзывы (1)

Благодарю за дискретное изложение материала

Про вероятности

(source)

Иногда мне приходится рассказывать другим людям как работает машинное обучение и, в частности, нейронные сети. Обычно я начинаю с градиентного спуска и линейной регрессии, постепенно переходя к многослойным перцептронам, автокодировщикам и свёрточным сетям. Все понимающе кивают головой, но в какой-то момент кто-нибудь прозорливый обязательно спрашивает:

А почему так важно, чтобы переменные в линейной регрессии были независимы?

А почему для изображений используются именно свёрточные сети, а не обычные полносвязные?

«О, это просто», — хочу ответить я. — «потому что если бы переменные были зависимыми, то нам пришлось бы моделировать условное распределение вероятностей между ними» или «потому что в небольшой локальной области гораздо проще выучить совместное распределение пикселей». Но вот проблема: мои слушатели ещё ничего не знают про распределения вероятностей и случайные переменные, поэтому приходится выкручиваться другими способами, объясняя сложнее, но с меньшим количеством понятий и терминов. А что делать, если попросят рассказать про батч нормализацию или генеративные модели, так вообще ума не приложу.

Так давайте не будем мучить себя и других и просто вспомним основные понятия теории вероятностей.

Случайные переменные

Представим, что у нас есть анкеты людей, где указаны их возраст, рост, пол и количество детей:

| age | height | gender | children |

|---|---|---|---|

| 32 | 175 | 1 | 2 |

| 28 | 180 | 1 | 1 |

| 17 | 164 | 0 | 0 |

| . | . | . | . |

Каждая строчка в такой таблице — это объект. Каждая ячейка — значение переменной, характеризующей этот объект. Например, возраст первого человека — 32 года, а рост второго — 180см. А что, если мы хотим описать некоторую переменную сразу для всех наших объектов, т.е. взять целую колонку? В этом случае у нас будет не одно конкретное значение, а сразу несколько, каждое со своей частотой встречаемости. Список возможных значений + соответсвующая вероятность и называется случайной переменной (random variable, r.v.).

Дискретные и непрерывные случайные переменные

Чтобы это отложилось в голове, я повторю ещё раз: случайная переменная полностью задаётся распределением вероятностей своих значений. Есть 2 основных типа случайных переменных: дискретные (discrete) и непрерывные (continuous).

Дискретные переменные могут принимать набор чётко разделимых значений. Обычно я изображаю их как-нибудь так (probability mass function, pmf):

А текстом это обычно записывается так (g — gender):

Т.е. вероятность того, что случайно взятый человек из нашей выборки окажется женщиной () равна 0.3, а мужчиной (

) — 0.7, что эквивалентно тому, что в выборке было 30% женщин и 70% мужчин.

К дискретным же переменным относятся количество детей у человека, частота встречаемости слов в тексте, количество просмотров фильма и т.д. Результат классификации на конечное число классов, кстати, — это тоже дискретная случайная переменная.

Непрерывные переменные могут принимать любое значение в определённом интервале. Например, даже если мы записываем, что рост человека — 175см, т.е. округляем до 1 сантиметра, на самом деле он может быть 175.8231см. Изображают непрерывные переменные обычно с помощью кривой плотности вероятности (probability density function, pdf):

График плотности вероятности — штука хитрая: в отличие от графика массы вероятности для дискретных переменных, где высота каждой колонки показывает непосредственно вероятность получить такое значение, плотность вероятности показывает относительное количество вероятности вокруг некоторой точки. Саму же вероятность в этом случае можно посчитать только для интервала. Например, в этом примере вероятность, что случайно взятый человек из нашей выборки будет иметь рост от 160 до 170см равна примерно 0.3.

Вопрос: может ли плотность вероятности в какой-то точке быть больше единицы? Ответ — да, конечно, главное, чтобы общая площадь под графиком (или, говоря математически, интеграл плотности вероятности) был равен единице.

где (мат. ожидание, mean) и

(дисперсия, variance) — параметры распределения. Т.е. имея всего 2 числа мы можем полностью описать распределение, посчитать его плотность вероятности в любой точке или суммарную веростность между двумя значениями. К сожалению, далеко не для любого набора данных найдётся распределение, которое сможет его красиво описать. Есть много способов бороться с этим (взять хотя бы смесь нормальных распределений), но это уже совсем другая тема.

Другие примеры непрерывного распределения: возраст человека, интенсивность пикселя на изображении, время ответа от сервера и т.д.

Совместное, маргинальное и условное распределения

Обычно мы рассматриваем свойства объекта не по одному, а в комбинации с другими, и здесь появляется понятие совместного распределения (joint probability) нескольких переменных. Для двух дискретных переменных мы можем изобразить его в виде таблицы (g — gender, c — # of children):

| c=0 | c=1 | c=2 | |

|---|---|---|---|

| g=0 | 0.1 | 0.1 | 0.1 |

| g=1 | 0.2 | 0.4 | 0.1 |

Согласно этому распределению, вероятность встретить в нашем наборе данных женщину с 2-мя детьми равна , а бездетного мужчину —

.

Для двух непрерывных переменных, например, роста и возраста, нам снова придётся задать аналитическую функцию распределения , аппроксимировав его,

например, многомерным нормальным. Таблицей это не запишешь, зато можно нарисовать:

Имея совместное распределение, мы можем найти распределение каждой переменной по отдельности, просто суммировав (в случае дискретных) или интегрировав (в случае непрерывных) остальные переменные:

Это можно представить в виде суммирования по каждой строке или столбцу таблицы и вынесением результат на поля таблицы:

| c=0 | c=1 | c=2 | ||

|---|---|---|---|---|

| g=0 | 0.1 | 0.1 | 0.1 | 0.3 |

| g=1 | 0.2 | 0.4 | 0.1 | 0.7 |

Так мы снова получаем и

. Процесс вынесения на поля (margin) даёт название и самому получившемуся распределению — маргинальное (marginal probability).

А что, если мы уже знаем значение одной из переменных? Например, мы видим, что перед нами мужчина и хотим получить распределение вероятностей количества его детей? Таблица совместной вероятности и тут нам поможет: поскольку мы уже точно знаем, что перед нами мужчина, т.е. , мы можем выбросить из рассмотрения все остальные варианты и рассматривать только одну строчку:

| c=0 | c=1 | c=2 | |

|---|---|---|---|

| g=1 | 0.2 | 0.4 | 0.1 |

Поскольку вероятности так или иначе должны суммироваться в единицу, получившиеся значения нужно нормализовать, после чего получится:

Распределение одной переменной при известном значении другой называется условным (conditional probability).

Правило цепи

А соединяются все эти вероятности одной просто формулой, которая называется правилом цепи (chain rule, не путать с правилом цепи в дифференцировании):

Формула эта симметричная, поэтому так тоже можно:

Интерпретация правила очень простая: если — вероятность того, что я пойду на красный свет, а

— вероятность того, что человек, переходящий на красный свет, будет сбит, то совместная вероятность пойти на красный свет и быть сбитым как раз и равна произведению вероятностей этих двух событий. Но вообще лучше ходите на зелёный.

Зависимые и независимые переменные

Как уже говорилось, если у нас есть таблица совместного распределения, то мы знаем про систему всё: можно вычислить маргинальную веростность любой переменной, можно условное распределение одной переменной при известной другой и т.д. К сожалению, на практике составить такую таблицу (или просчитать параметры непрерывного распределения) в большинстве случаев невозможно. Например, если мы захотим посчитать совместное распределение встречаемости 1000 слов, то нам понадобится таблица из

107150860718626732094842504906000181056140481170553360744375038837035105112493612

249319837881569585812759467291755314682518714528569231404359845775746985748039345

677748242309854210746050623711418779541821530464749835819412673987675591655439460

77062914571196477686542167660429831652624386837205668069376

(чуть больше 1e301) ячеек. Для сравнения, количество атомов в наблюдаемой вселенной равно примерно 1e81. Пожалуй, покупкой дополнительной планки памяти тут не обойдёшься.

Но есть одна приятная деталь: не все переменные зависят друг от друга. Вероятность того, пойдёт ли завтра дождь, вряд ли зависит от того, перехожу ли я дорогу на красный свет. Для независимых переменных условное распределение одной от другой равно просто маргинальному распределению:

По-честному, совместная вероятность 1000 слов записывается так:

А вот если мы «наивно» предположим, что слова не зависят друг от друга, то формула превратится в:

А чтобы сохранить вероятности для 1000 слов нужна таблица всего с 1000 ячеек, что вполне приемлемо.

Почему тогда не считать все переменные независимыми? Увы, так мы потеряем массу информации. Представим, что мы хотим посчитать вероятность того, что пациент болен гриппом в зависимости от двух переменных: боли в горле и повышенной температуры. Отдельно боль в горле может говорить как о болезни, так и том, что пациент только что громко пел. Отдельно повышенная температура может говорить как о болезни, так и о том, что человек только что вернулся с пробежки. А вот если мы одновременно наблюдаем и температуру, и боль в горле, то это уже серьёзная причина выписать пациенту больничный.

Логарифм

Очень часто в литературе можно увидеть, что используется не просто вероятность, а её логарифм. Зачем? Всё довольно прозаично:

В примере со словами вероятность встретить любое слово , как правило, сильно меньше единицы. Если мы попробуем перемножить много маленьких вероятностей на компьютере с ограниченной точностью вычислений, догадываетесь что будет? Ага, очень быстро наши вероятности округляться к нулю. А вот если мы сложим много отдельных логарифмов, то выйти за пределы точности вычислений будет практически невозможно.

Условная вероятность как функция

Если после всех этих примеров у вас сложилось впечатление, что условная вероятность всегда вычисляется подсчётом количества раз, которое встретилось некоторое значение, то спешу развеять это заблуждение: в общем случае условная вероятность — это некоторая функция одной случайной переменной от другой:

где — это некоторый шум. Виды шума — это тоже отдельная тема, в которую мы сейчас влезать не будем, а вот на функции

остановимся поподробней. В примерах с дискретными переменными выше в качестве функции мы использовали простой подсчёт встречаемости. Это само по себе хорошо работает во многих случаях, например, в наивном байесовском классификаторе для текста или поведения пользователей. Чуть более сложная модель — линейная регрессия:

Здесь тоже делается предположение о том, что переменные независимы друг от друга, но распределение

уже моделируется с помощью линейной функции, параметры которой

нужно найти.

Многослойный перцептрон — это тоже функция, но благодаря промежуточным слоям, на которые влияют все входные переменные сразу, MLP позволяет моделировать зависимость выходной переменной от комбинации входных, а не только от каждой из них по отдельности (вспомните пример с болью в горле и температурой).

Свёрточная сеть работает с распределением пикселей в локальной области, покрываемой размером фильтра. Рекуррентные сети моделируют условное распределение следующего состояния от предыдущего и входных данных, а также выходной переменной от текущего состояния. Ну, в общем, вы поняли идею.

Теорема Байеса и умножение непрерывных переменных

Помните правило сети?

Если убрать левую часть, то получим простое и очевидное равенство:

А если теперь перенесём направо, то получим знаменитую формулу Байеса:

Итересный факт: русское произношение «байес» в английском звучит как слово «bias», т.е. «смещение». А вот фамилия учёного «Bayes» читается как «бэйс» или «бэйес» (лучше послушать в Yandex Translate).

Формула настолько избитая, что каждая её часть имеет своё название:

Байесовская статистика — штука жутко интересная, но влезать в неё сейчас мы не будем. Единственный вопрос, который хотелось бы затронуть, — это перемножение двух распределений непрерывных переменных, которое у нас встречается, например, в числителе формулы Байеса, да и вообще в каждой второй формуле над непрерывными переменными.

Допустим, что у нас есть два распределения и

:

И мы хотим получить их произведение:

Мы знаем плотность вероятности обоих распределений в каждой точке, поэтому, по-честному и в общем случае, нам нужно перемножить плотности в каждой точке. Но, если мы вели себя хорошо, то и

у нас заданы параметрами, например, для нормального распределения 2-мя числами — матожиданием и дисперсией, а для их произведения придётся считать вероятность в каждой точке?

К счастью, произведение многих известных распределений даёт другое известное распределение с легко вычислимыми параметрами. Ключевое слово здесь — conjugate prior.

Как бы мы не вычисляли, произведение двух нормальных распределений даёт ещё одно нормальное распределение (правда, ненормализованное):

Ну и просто для сравнения распределение смеси 3х нормальных распределений:

Вопросы

Раз уж это туториал и кто-нибудь наверняка захочет запомнить то, что здесь было написано, вот несколько вопросов для закрепления материала.

Пусть рост человека — нормально распределённая случайная переменная с параметрами

и

. Какова вероятность встретить человека ростом ровно 178см?

Правильными ответами можно считать «0», «бесконечно мала» или «не определена». А всё потому что вероятность непрерывной переменной считается на некотором интервале. Для точки интервал — это её ширина, в зависимости от того, где вы учили математику, длину точки можно считать нулём, бесконечно малой или вообще не определённой.

Пусть

— количество детей у заёмщика кредита (3 возможными значения),

— признак того, отдал ли человек кредит (2 возможных значения). Мы используем формулу Байеса для предсказания, отдаст ли конкретный клиент с 1 ребёнком кредит. Сколько возможных значений может принимать априорное и апостериорное распределения, а также правдоподобие и маргинальное правдоподобие?

Таблица совместного распредления двух переменных в данном случае небольшая и имеет вид:

| c=0 | c=1 | c=2 | |

|---|---|---|---|

| s=0 | p(s=0,c=0) | p(s=0,c=1) | p(s=0,c=2) |

| s=1 | p(s=1,c=0) | p(s=1,c=1) | p(s=1,c=2) |

где — признак успешно отданного кредита.

Формула Байеса в данном случае имеет вид:

Если все значения известны, то:

Нейронные сети, оптимизирующие расстояние между двумя расспределениями

и

, зачастую используют в качестве оптимизационной цели кросс-энтропию (cross entropy) или расстояние Кульбака-Лейблера (Kullback-Leibler divergence). Последнее определяется как:

— это мат. ожидание по

, а почему в основной части —

— используется деление, а не просто разница между плотностями двух функций

?

Другими словами, это и есть разница между плотностями, но в логарифмическом пространстве, которе является вычислительно более стабильным.