Для чего нужен фрисинк

Технология FreeSync: для чего нужна, как включить

Геймеры – народ привередливый: для них удобство игрового процесса настолько важно, что они готовы многим жертвовать, лишь бы иметь достойное оборудование, которое не будет их подводить в самые ответственные моменты. Но технологии развиваются слишком быстро и то, что было топовым вчера, сегодня переходит в массовую категорию, будь то видеокарта или монитор.

В результате можно наблюдать прерывания игрового процесса, подвисания, разрывы картинки. Зачастую покупка более мощного графического адаптера не всегда приводит к ожидаемым результатам по причине несовпадения характеристик видеоадаптера и монитора.

В таких случаях помогает вертикальная синхронизация, но эта технология должна внедряться в оба типа устройств, задействованных в игровом процессе.

AMD FreeSync на мониторе: что это за технология

Работы над тем, чтобы синхронизировать работу графического акселератора и компьютерного монитора, ведутся с 2009 года. Поначалу для этих целей применялся отдельный модуль, занимавшийся масштабированием кадров.

Позже технология начала внедряться непосредственно в видеокарты, и первым это сделала компания AMD, что позволило использовать функцию FreeSync без необходимости подключения дополнительного устройства.

Вывод картинки на экран происходит после того, как этот кадр был просчитан (прорисован) видеокартой. Делает она это в широком диапазоне частот – от 10 до 250 Гц. Мало какие мониторы способны работать в таких скоростных режимах, отсюда и возникают артефакты, которых хотелось бы избежать.

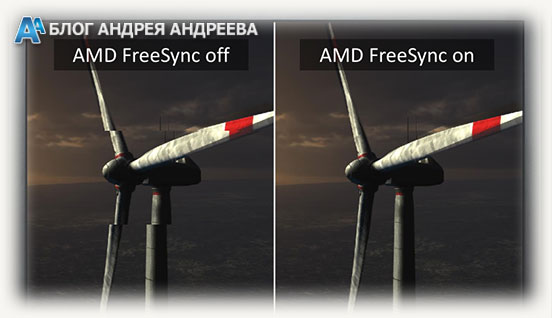

Частично эту проблему решает технология FreeSync, которая начинает работать на частотах от 40 Гц. И ещё одним условием её активации является несовпадения частот обновления дисплея и рендеринга кадров графическим адаптером. Если видеокарта отрендерила кадр и послала его на экран, который в это время только заканчивает прорисовку предыдущего, то он будет отображен с искажениями, а если рассинхронизация серьёзная, то есть вероятность, что этот кадр вообще будет пропущен. В первом случае получим характерную картинку с разрывами, смещениями части кадра. Во втором – фактическое снижение количества прорисовываемых кадров в секунду, что отразится на качестве картинки, а также на реакции на действия игрока.

Но не стоит ожидать чудес: полностью избежать проблем не удастся. Дело в том, что технология AMD FreeSync вообще-то нужна только для синхронизации частот графической карты и монитора. Если имеются недостатки в самом игровом движке, она с ними не справится. Точно так же она бессильна, если со своей частью обработки данных не будет справляться CPU. Но если с этими двумя факторами всё в порядке, синхронизация на уровне видеоадаптера действительно избавит игру от артефактов.

Не стоит искать технологию FreeSync на ноутбуках и тем более на планшетах, поскольку там о мониторах с большим разрешением и частотами речь не идёт. Только настольные ПК с мониторами! Стоит упомянуть о ещё одном ограничении: для активации режима монитор нужно подключать либо через интерфейс Display Port, начиная с версии 1.2а образца 2013 года, либо через HDMI. К тому же игра должна быть запущена в полноэкранном режиме, иначе ничего не получится.

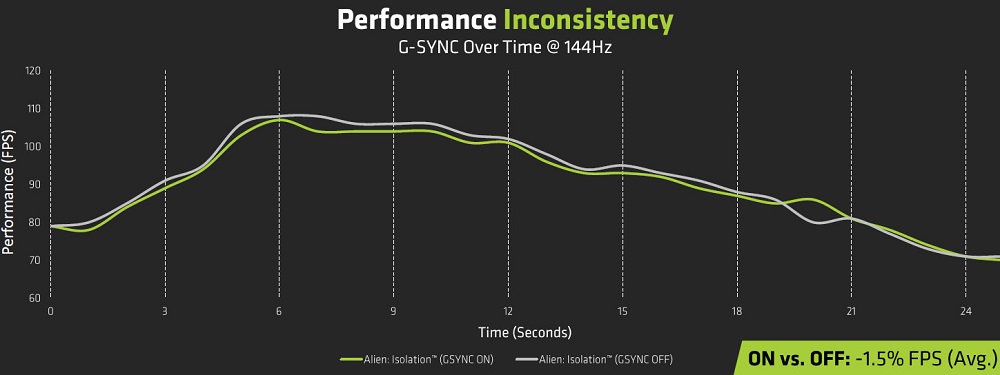

Вслед за AMD подобную технологию разработал и основной конкурент в сфере графического оборудования, компания nVidia. Она получила название G-Sync и предоставляется вендорам на платной основе, из-за чего мониторы, поддерживающие G-Sync, имеют более высокие ценники, чем такие же модели с FreeSync.

Синхронизация от nVidia до сих пор менее распространена, и не только из-за платного использования для разработчиков и в конечном итоге для покупателей оборудования.

Видеокарты с G-Sync не умеют правильно выполнять корректировку, если частота кадров, выдаваемых адаптером, оказывается выше пороговых значений для дисплея. Это значит, что FreeSync более универсальна, к тому же у неё имеется возможность менять режимы и цветовые профили монитора, чем G-Sync тоже пока похвастаться не может.

А использовать обе технологии одновременно до недавних пор не представлялось возможным: если заявлено, что ваш монитор поддерживает FreeSync, то он будет работать только с видеокартами от AMD. И наоборот, мониторы с G-Sync подходили только для работы с графическими адаптерами от Nvidia.

Поскольку этот факт сдерживал распространение продукции последней, она была вынуждена как-то решать проблему. В итоге ей последние модели видеокарт стали поддерживать технологию синхронизации от конкурента, и такие изделия начали маркировать как G-Sync Compatible. Правда, совместимость оказалась далеко не полной, многие мониторы с FreeSync синхронизироваться с видеокартами Nvidia не смогут. С полным списком официально поддерживаемых технологией G-Sync Compatible мониторов можно ознакомиться на официальном сайте Nvidia.

Нужно также отметить, что хотя FreeSync дает возможность избавиться от зависаний, разрывов и пропусков кадра, а также прочих артефактов, вызванных рассинхронизацией рабочих частот монитора и GPU, за это придётся расплачиваться покупкой более дорогого монитора, обеспечивающего поддержку этой технологии.

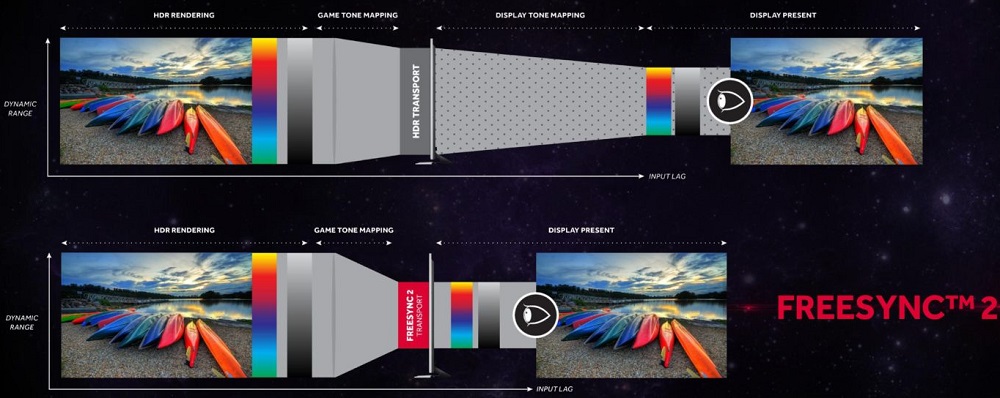

Впрочем, AMD не останавливается на достигнутом. Динамическое обновление частоты кадров на мониторе было усовершенствовано в более продвинутых технологиях, FreeSync Premium/FreeSync 2 HDR, которые уже были анонсированы компанией в рамках мероприятия CES 2020. Использование этих режимов позволяет справляться и с низкими частотами рендеринга кадров, а также работать с мониторами, способными работать на частотах 120 Гц и оснащённых технологией HDR. Nvidia тоже не стоит в сторонке, её последняя разработка в этой сфере называется G-Sync Ultimate.

Рассмотрим системные требования, предъявляемые к устройствам, поддерживающим технологию FreeSync:

| Устройство | Системные требования |

| Монитор | — дисплей ноутбука, монитор или телевизор, в спецификации которых указана поддержка FreeSync; — самый свежий драйвер; — гибридный или чисто графический процессор с поддержкой FreeSync. |

| Видеокарта | — AMD: Radeon серии RX200 и выше (все потребительские графические адаптеры Radeon, построенные с использованием архитектуры GCN, начиная с версии 2.0); — NVIDIA: GeForce начиная с 10 серии с поддержкой DisplayPort Adaptive-Sync или совместимых с AMD FreeSync. |

| Интерфейс | — HDMI или DisplayPort; — соответствующий разъём на материнской плате; — совместимый процессор. |

Как включить FreeSync на мониторе

При условии поддержки монитором данной технологии её включение осуществляется через его меню (последовательность действий описана в пользовательской инструкции, обычно это последовательность Меню–Картинка–Настройка игры–FreeSync, после чего функцию необходимо включить).

Некоторые производители мониторов поставляют их вместе с фирменным ПО, позволяющим включать FreeSync. В частности, это утилита OnScreenControl от LG, где нужно придерживаться следующего алгоритма:

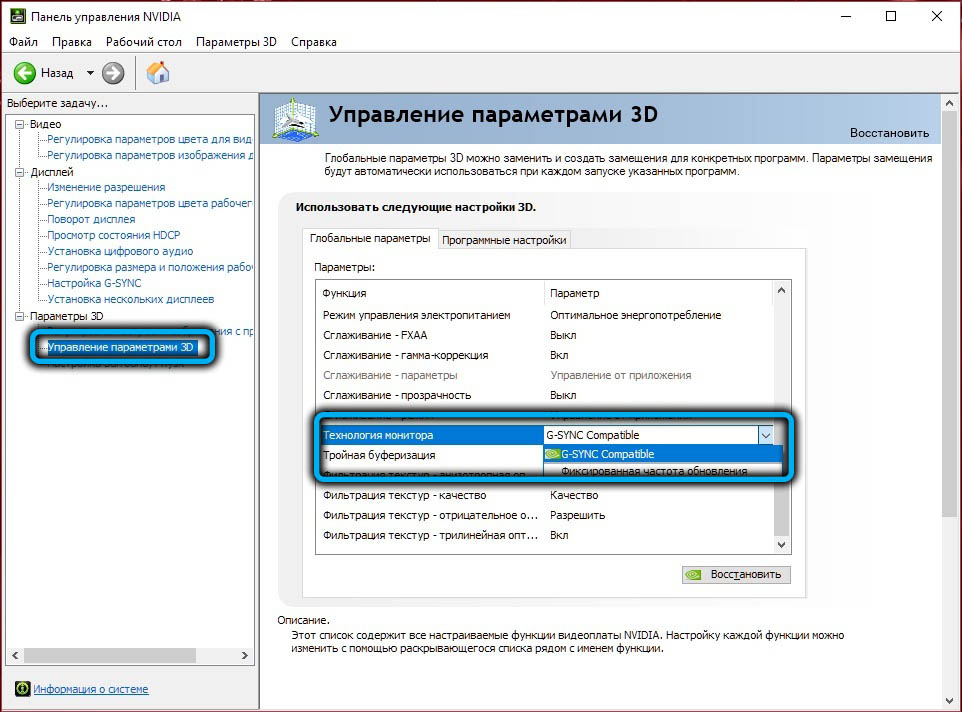

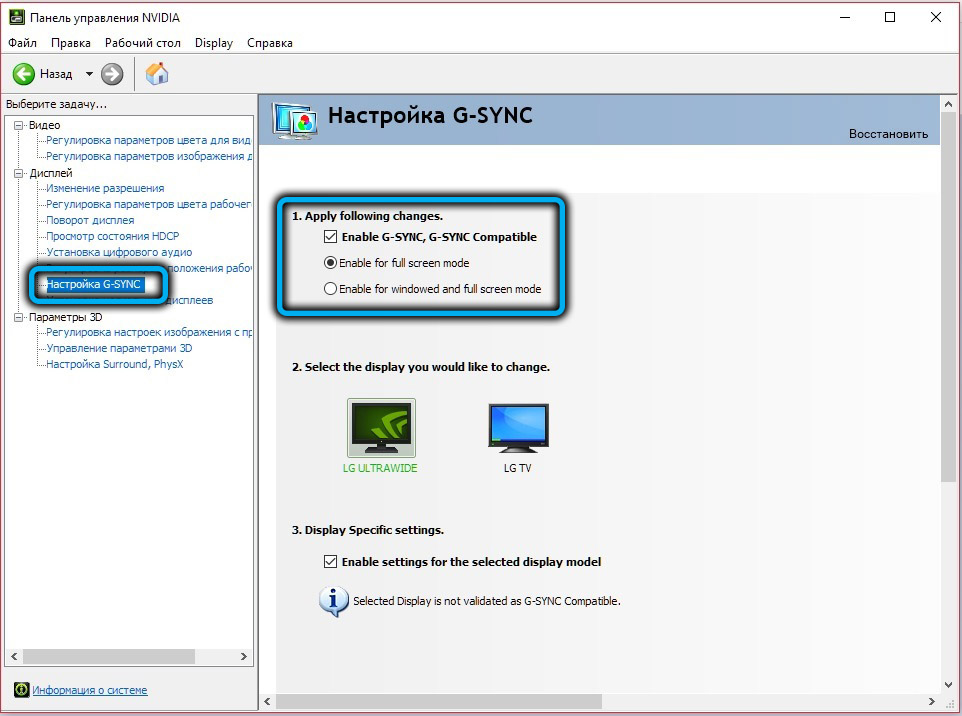

Если у вас стоит видеокарта Nvidia последних поколений, вы сможете включить G-Sync на мониторах с поддержкой FreeSync. Для этого нужно установить драйвер в. 417.71 или свежее и активировать в меню монитора режим переменной частоты обновления.

Как включить AMD FreeSync на видеоадаптере Radeon

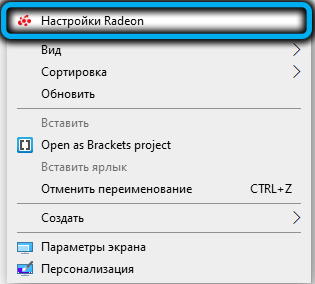

Для начала необходимо установить самый свежий драйвер для свой видеокарты с официального сайта. Её название можно подсмотреть в Диспетчере устройств.

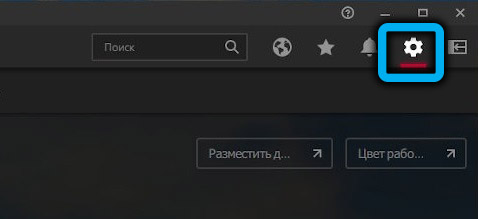

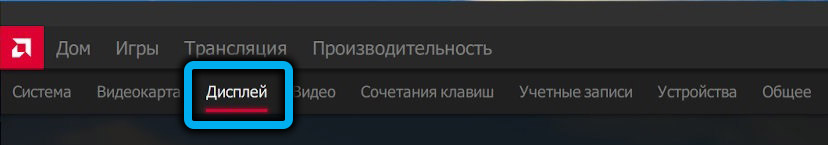

Затем открываем утилиту AMD Radeon Software, выбираем вкладку «Настройки», кликаем по пункту меню «Дисплей» и устанавливаем переключатель возле надписи AMD Radeon FreeSync в положение «Включить».

Отключить FreeSync можно так же, как и активировать.

Как включить AMD FreeSync на видеоадаптерах Nvidia

Мы уже рассказывали, что на современных видеокартах Nvidia технология FreeSync работает, при условии установки свежего драйвера. К сожалению, для большинства старых карт поддержка со стороны компании была прекращена, так что для них драйвера в Windows инсталлируются автоматически.

Попытка установить свежий драйвер вручную окажется безрезультатной: инсталлятор определит, что оборудование устаревшее и завершит работу. Так что обладателям старых видеоадаптеров Nvidia в этом плане не повезло. Какие именно видеокарты не поддерживают AMD FreeSync, можно посмотреть на сайте производителя.

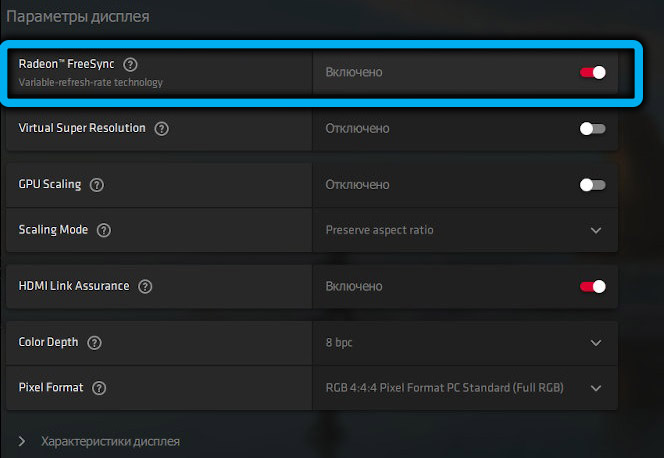

Включение режима осуществляется через фирменное ПО Nvidia Control Panel. Нужно зайти во вкладку Display, выбрать пункт Set up G-SYNC, после чего для параметров Enable G-SYNC, а также G-SYNC Compatible установить полноэкранный режим (Enable for full screen mode).

Заключение

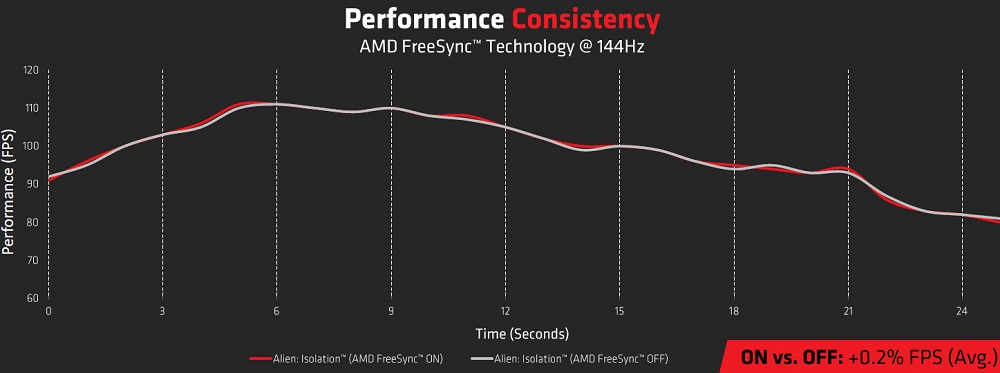

Практически во всех современных игровых мониторах в спецификации указывается поддержка AMD FreeSync, а в самых новых – и FreeSync Premium. При активации этого режима частота обновления экрана будет динамической, что и позволит драйверу видеокарты синхронизировать работу обоих устройств. И это действительно помогает убрать различные артефакты без использования фоновых утилит или дополнительного железа, практически не влияя на производительность графической подсистемы.

Включение режима обычно предусмотрено в меню монитора, но если этого там нет, активировать технологию можно программно, через управляющие утилиты AMD и NVIDIA.

Технология AMD Freesync: что это и как работает?

Всем привет, уважаемые читатели! Все уже давно привыкли к тому, что почти все мониторы имеют фиксированную частоту развертки (на что влияет герцовка, читайте здесь) – как минимум 60 Гц. Такая особенность перекочевала еще с ЭЛТ-телевизоров, у которых частота обновления была как минимум 24 Гц.

Это удобно, например, при просмотре фильма, сделанного профессиональной командой, где каждый кадр выверен и занимает свое место. В играх же ФПС не является постоянной величиной: он «плавает» в зависимости от текущей ситуации.

Например, замечено, что в любой ММОРПГ, как бы идеально она не была оптимизирована, наблюдается снижение ФПС при большом скоплении игроков в одном месте. Почему так происходит?

Потому, что это – не базовые модели: большинство игроков старается подчеркнуть собственную индивидуальность, используя разные элементы одежды и доспехов, их покраску, прическу, бороду персонажа и так далее. Все это приходится просчитывать видеокарте, получая сигнал с сервера.

Если частота развертки не совпадает с частотой рендеринга графики видеокартой, появляются разрывы изображения и различные артефакты.

Сегодня мы поговорим о технологии freesync на мониторе — что это такое и в чем преимущество ее использования и работает ли она с видеокартой от nvidia.

Немного о вертикальной синхронизации

При несовпадении герцовки монитора с ФПС, выдаваемым видеокартой, обычно изображение выводится на экран, даже если показ предыдущего кадра еще не закончен. По сути, каждый из кадров на мониторе состоит из двух кадров, отрендеренных видеокартой.

То есть, если монитор имеет частоту покадровой развертки 60 Гц, а видеокарта выдает 60 ФПС, пользователь получает изображение без единого разрыва и артефакта, при этом видеокарта не будет загружена на 100%.

Однако может появиться другая проблема – задержка вывода картинки, когда видеокарта подготавливает кадры быстрее, чем обновляется покадровая развертка монитора. Управление становится «вязким», что затрудняет игровой процесс в динамичных играх: прицел двигается не плавно, а с рывками, персонаж перемещается так же.

Еще хуже дела обстоят, если видеокарта не выдает необходимые 60 ФПС и ограничивается, например, 50. В итоге картинка становится еще более «дерганной», часто в такой степени, что играть становится невозможно.

Поэтому большинство геймеров со временем приходят к выводу, что вертикальная синхронизация – зло, и отключают функцию вообще.

Amd freesync и nvidia G-Synk

Компания АМД первой додумалась синхронизировать покадровую развертку и ФПС видеокарты в принудительном порядке. В чем ее суть: если, например, видеокарта отрендерила кадр за 5 мс, то монитор на эти же 5 мс и выводит изображения, не ожидая генерации следующего.

Если время, необходимое для рендеринга, увеличивается, соответственно, увеличивается и время демонстрации кадра.

Что это дает пользователю? Монитор выдает полностью готовые кадры, и вы видите изображение на экране без артефактов, разрывов и прочих неприятных побочных эффектов. Во-вторых, пропадает «вязкость» управления, о которой говорилось выше – становится возможным нормальное позиционирование прицела.

Закономерный вопрос: нужен ли процессор amd для freesync? Нет, не нужен, как и видеокарта именно этого бренда – с технологией прекрасно «дружат» и графические ускорители Нвидиа. Однако следует отметить, что функция контролируется самой видеокартой.

А для подключения используется Display Port. Недостаток такого решения в том, что технологию невозможно реализовать на графическом ускорителе без аппаратной поддержки freesync – то есть все видеокарты старше R7 R9 и RX, выпущенные еще, каких-то лет 7 назад.

«За бортом» остаются чипы серии HD 7000, которые, вообще-то, почти ничем не отличаются от 200-й линейки и продолжают использоваться. А мобильные версии видеокарт эту технологию не поддерживают вообще.

Производители geforce пошли немного другим путем – коррекцию частоты покадровой развертки выполняет специальный чип, который установлен в мониторе. Технология работает с nvidia начиная с серии GTX 650 Ti.

Однако такой монитор стоит дороже – именно из-за наличия дополнительного чипа. Стоит отметить, что технология, все-таки, проигрывает предыдущей – иногда наблюдаются задержка кадров и мерцание экрана.

Частично проблема устранена в дисплеях с поддержкой freesync 2, однако все равно технологию еще нужно «дорабатывать напильником».

И еще один момент, о котором стоит упомянуть. Наличие или отсутствие любой из этих технологий не влияет на производительность в играх – за это отвечает, в первую очередь, видеокарта, и некоторые другие компоненты компа.

Freesync же позволяет добиться более плавной картинки.

Еще советую почитать про угол обзора монитора и его время отклика. А на сегодня все. Буду признателен, если вы поделитесь этой публикацией в социальных сетях. До завтра!

Для чего нужен фрисинк

Когда во время игры на экране появляется горизонтальный разрыв изображения это всегда неприятно! Недавно компания AMD представила новую технологию FreeSync, позволяющую сделать движение в играх максимально плавным. Преимущества технологии FreesSync уже несколько недель активно обсуждаются в социальных сетях и на других онлайн ресурсах Интернета. Возможно, вы задаетесь вопросом, как эта новейшая технология может изменить вашу геймерскую жизнь? Давайте познакомимся с FreeSync немного поближе!

Что же такое AMD FreeSync?

FreeSync- это новейшая технология AMD, призванная решить проблему разрыва изображения в играх и при просмотре видео. Данная технология позволяет видеокарте синхронизировать частоту обновления изображения с частотой кадров совместимого монитора. Технология FreeSync, основана на индустриальном стандарте ‘Adaptive Sync’, который обеспечивает обмен данными между монитором и графическим процессором видеокарты через VESA 1.2a DisplayPort. Благодаря использованию протоколов синхронизации Display Adaptive, увеличивается плавность в играх, исключая разрывы изображения. При использовании технологии FreeSync, также исключается какое либо дрожание изображения, поскольку частота обновления будет равняться частоте генерации новых кадров. Кроме того, развитие индустриального стандарта Adaptive Sync, является полностью открытым и не требует лицензионных отчислений и дополнительных контрактов для участвующих сторон. Таким образом, стоимость производства таких решений становится значительно ниже, что позволит вам сэкономить бюджет, наслаждаясь игровыми баталиями или просмотром видео без искажения картинки и эффекта мерцания. FreeSync также поддерживает различную частоту обновления изображения, что позволит вам выбрать наиболее подходящую настройку для вашего конкретного случая.

[iframe src=»https://www.youtube.com/embed/p7_ZiVY8vwE» width=»500″ height=»281″]

Почему технология AMD FreeSync так интересна геймерам?

Вы случайно не один из тех, кто жалуется на разрывы изображения и его дрожание во время игры? AMD FreeSync избавит вас от этих неприятных ощущений. Имея видеокарту от AMD с поддержкой FreeSync и соответствующий совместимый монитор позволит добиться максимальной плавности в играх. Более того, включение FresSync, также позволит оптимизировать производительность видеокарты.

Как же получить все преимущества технологии?

Для этого вам необходимо использовать монитор, совместимый с DisplayPort Adaptive-Sync, совместимую видеокарту на базе графического процессора AMD Radeon с разъемом DisplayPort и конечно самый последний драйвер AMD Catalyst. Мониторы, с поддержкой технологии AMD FreeSync уже доступны на рынке. Все что вам остается, это выбрать подходящую модель и наслаждаться плавным геймингом без разрывов!

Для того чтобы помочь вам сделать правильный выбор мы обновили информацию о продуктах серии AMD Radeon R9 и R7 GAMING с поддержкой AMD FreeSync.

Правда, мифы и особенности игровых мониторов — часть №1

В последние несколько лет явно прослеживается тренд на игровые комплектующие, и если с процессорами и видеокартами все вполне понятно, то игровые корпуса и игровые вентиляторы вызывают много вопросов. И, разумеется, стали появляться и игровые мониторы, причем массово: так, на CES 2020 было представлено около десятка моделей. Отношение к ним, в общем и целом, достаточно скептическое — дескать, обычных решений с FHD и 60 Гц полностью хватает, зачем эти навороты? Давайте разбираться, так ли это.

Раз глаз не видит больше 24 кадров, то зачем 144 Гц мониторы?

Когда речь заходит про герцовку монитора, то тут всплывают множество мифов. Самый популярный заключается в том, что раз фильмы показывают в 24 кадра в секунду, то, значит, нашему глазу этого достаточно, чтобы видеть не слайдшоу, а плавную картинку — а, значит, все эти 120 и даже 240 Гц мониторы — баловство. Однако тут важно понимать, что кадр из фильма и кадр, который видеокарта выводит на экран, сильно различаются. Кадр в фильме снимался с некоторой выдержкой, то есть он в любом случае слегка смазан и показывает движение, иными словами — внутри каждого кадра из фильма есть информация о предыдущем. Поэтому мозгу хватает всего 24 таких кадров секунду, что бы «слепить» из них плавное видео.

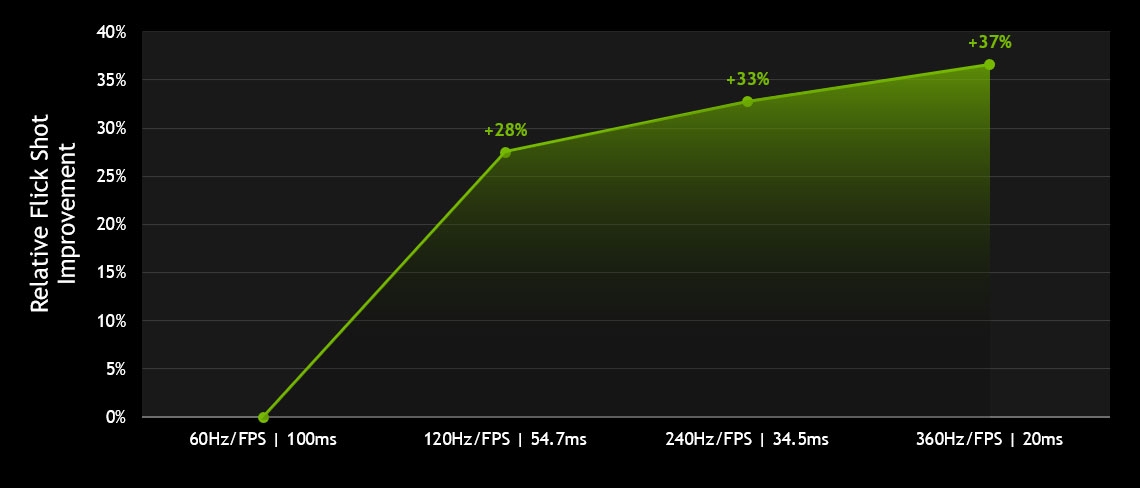

А вот кадр, который выводит на экран видеокарта, всегда четкий (разумеется, если мы не говорим о программном размытии в движении — motion blur), поэтому 24 таких кадра распознаются нашим мозгом как слайдшоу. Но сколько тогда нужно «компьютерных» кадров для плавности? А вот тут уже все индивидуально: в большинстве своем игроки на консолях вполне довольны 30 fps. Но на деле практически все люди замечают разницу между 30 и 60 Гц, а порог распознаваемости отдельных кадров лежит далеко за сотню — как показала презентация Nvidia на CES 2020, хватает людей, которые видят разницу между 240 и 360 Гц мониторами!

Но, разумеется, не стоит сразу бросаться покупать 240 Гц монитор. Проблема в том, что все его прелести вы сможете увидеть только в том случае, если контент будет выводиться со схожей частотой кадров. Иными словами, видео в 60 fps на YouTube будет выглядеть одинаково что на 60 Гц мониторе, что на 120 Гц, и даже на 360 Гц. В общем и целом, единственный контент, в котором вы можете увидеть под две сотни и больше кадров в секунду — это некоторые киберспортивные игры, и то для этого обычно потребуются быстрые процессоры и видеокарты.

В общем и целом, если вы не киберспортсмен, имеет смысл ограничиться 100-144 Гц мониторами. Выдать около сотни кадров в секунду в современных и не очень играх могут уже куда больше видеокарт, а разница с 60 Гц матрицами будет видна невооруженным глазом.

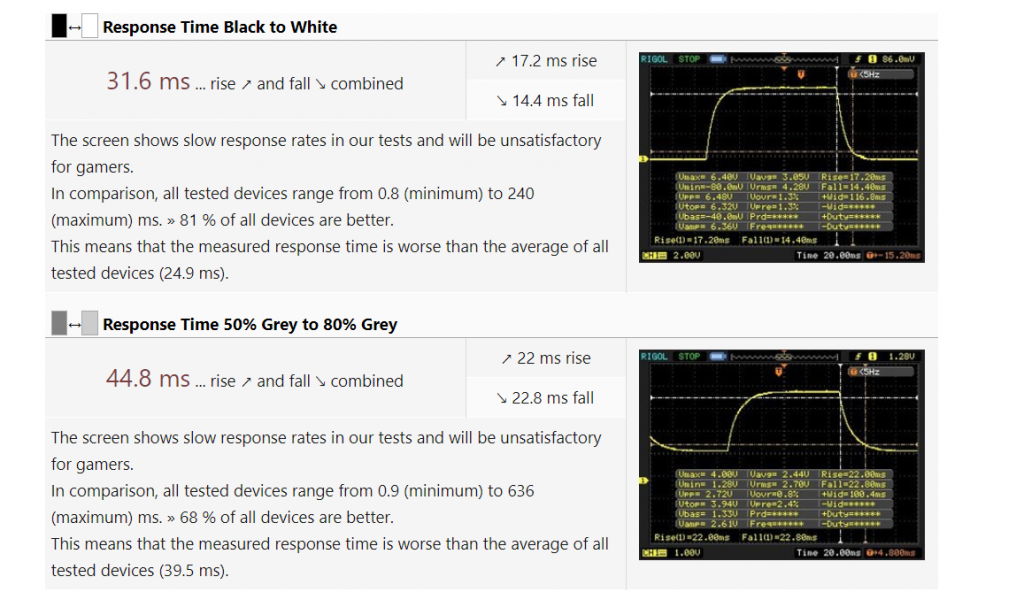

Время отклика монитора — не менее важный параметр, чем частота обновления

Думаю, многие замечали, что если быстро передвигать какое-либо окно по экрану, то за ним тянутся шлейфы. Это происходит из-за того, что пиксели в жидкокристаллических мониторах не могут изменять цвет моментально, им на это нужно определенное время — так называемая задержка матрицы или время отклика монитора.

Считать ее можно разными способами, в основном используют показатель grey-to-grey, или GtG: время, которое требуется пикселям, чтобы снизить яркость серого цвета с 80-90% до 10-50% (увы — каждый производитель тут использует свою методику). Данный показатель оказывается наиболее интересным, так как близок к реальному применению: очень редко в играх картинка резко сменяется с белой на черную (BtW, black-to-white), а вот смена яркости цветов происходит постоянно.

Типичная 60 Гц панель в достаточно дорогом ноутбуке с Core i5 и GTX 1660. Играть за ней в динамические игры будет не слишком приятно.

У обычных 60 Гц матриц такой показатель в среднем на уровне 30-50 мс. Много это или мало? Давайте посчитаем. В случае с 60 Гц монитором один кадр отображается на экране 1000 мс/60 = 17 мс. То есть время отклика соответствует отображению двух, а то и трех кадров на экране. К чему это приводит? Да ни к чему хорошему: в динамических играх матрица просто не будет успевать обновлять информацию на экране, что приведет к замыливанию картинки и шлейфам, а в худшем случае в этом цветовом месиве вы просто проглядите врага. В случае со 144 Гц мониторами все еще хуже: на каждый кадр отводится всего 7 мс.

Поэтому, выбирая игровой монитор, стоит внимательно отнестись к его времени отклика, причем не стоит смотреть на рекламные цифры в виде 1-3 мс: производители мониторов измеряют задержку различными хитрыми способами, и на деле по обзорам GtG может у таких матриц быть и 5, и 10 мс. Крайне желательно, чтобы время отображения кадра было больше времени задержки матрицы — это позволит свести шлейфы в динамических играх к минимуму.

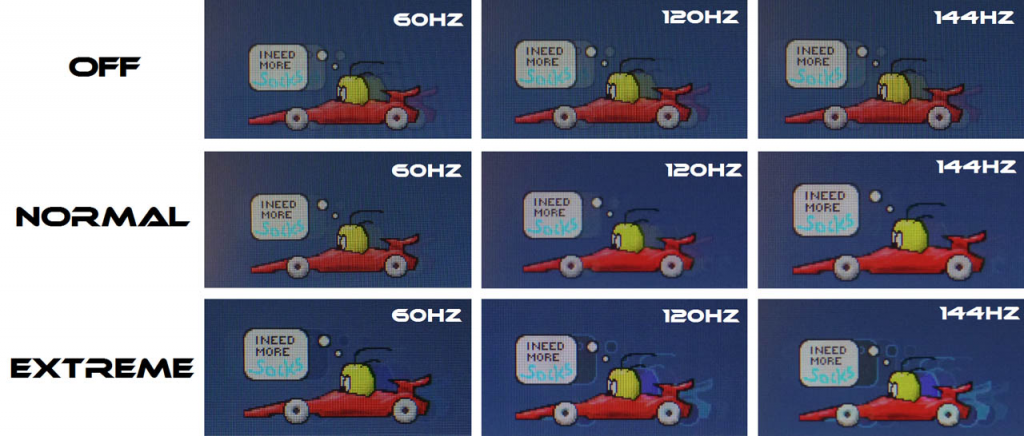

Overdrive — разгон матрицы

Вот мы и перешли к чисто игровым функциям. Как я писал выше, большое время отклика = смаз картинки, поэтому производители придумали технологию компенсации времени отклика, которую назвали Overdrive. В чем ее суть? Обычно переход от черного цвета к белому для LCD-матриц происходит быстрее, чем между двумя градациями серого. Причина в том, что скорость изменения состояния пикселя зависит от приложенного к нему напряжения, а переход в «белое» состояние — это подача максимального напряжения, поэтому BtW быстрее GtG (что, к слову, и используют маркетологи при указании времени отклика матриц).

Отсюда возникает простая идея: а что если в начале каждого нового кадра подавать на пиксель высокие «разгонные» импульсы напряжения, которые значительно выше тех, которые нужны для реального нового значения цвета? Это даст «толчок» пикселю и позволит ему быстрее перейти в новое положение, существенно снизив задержку матрицы. Однако ложка дегтя в том, что такое резкое повышение напряжения не может пройти бесследно: нет, пиксели от этого не выгорают, просто могут появиться различные артефакты изображения типа светлого мерцания на серых фонах в динамических играх.

Хорошо видно, что при включенном Overdrive в режиме Normal меньше всего артефактов изображения. При этом включение этой функции на Extreme начинает инвертировать цвета, что еще менее приятно, чем выключение этой опции.

По этой причине производитель монитора обычно делает несколько настроек Overdrive, в том числе и возможность полностью его выключить. И уже для конкретного монитора нужно смотреть, что лучше — опять же, об этом пишут в развернутых обзорах.

Высокая частота + низкое время отклика = приятный геймплей

Теперь сложим все воедино и посчитаем общую задержку, которую мы получаем в играх. Она складывается из времени, которое нужно процессору и видеокарте, чтобы обработать ваше нажатие и передать картинку на дисплей. Оно составляет около 50 мс и его вполне можно считать константой. Далее в дело вступает монитор: у нас есть задержка при выводе нового кадра + время отклика.

Посчитаем этот показатель для «стандартной» 60 Гц панели со временем отклика в 40 мс. Худшее время задержки при выводе нового кадра — это если только что на экран вывелся кадр, и теперь нужно ждать 1000 мс/60 = 17 мс, чтобы вывести новый (это на деле не совсем так, но мы рассматриваем наихудший случай). Далее — время отклика, еще 40 мс. В итоге общая задержка получается 50 + 17 + 40 = 107 мс.

Теперь возьмем «игровую» 144 гц матрицу с задержкой GtG в 7 мс (это опять же достаточно много для современных матриц, но мы берем худший случай). Задержка при выводе нового кадра — 1000 мс/144 = 7 мс. Еще 7 мс время отклика. В итоге получаем общую задержку в 50 + 7 + 7 = 64 мс.

Сложно сказать, как Nvidia считала задержку, однако статистика по флик-шотам (быстрым выстрелам с разворота) вполне красноречива: чем быстрее матрица, тем их больше. Причем основной прирост идет при переходе с 60 Гц на 120, что еще раз говорит о том, что переплачивать за более быстрые панели стоит только киберспортсменам.

В итоге выигрыш в задержке более полутора раз. И это главная причина того, что на быстрых матрицах вам проще играть и попадать во врагов. Так что, как видите, игровые мониторы действительно могут так называться, и это не маркетинг.

AMD FreeSync и Nvidia G-Sync — убираем разрывы в изображении

Большая часть мониторов имеют фиксированную герцовку, однако в динамическом контенте, таком как игры, количество кадров в секунду постоянно меняется. К чему это приводит? Опять же ни к чему хорошему: изображение выводится на дисплей даже в том случае, если вывод части предыдущего кадра ещё не закончен полностью — оставшаяся часть буфера приходится на текущее обновление экрана. Именно поэтому каждый выведенный на монитор кадр при несовпадении частоты и fps будет по сути состоять из двух кадров, отрендеренных видеокартой.

Выглядит это как разрыв изображения, что очень некрасиво:

Как можно в этим бороться? Ну, самый простой способ — это включить вертикальную синхронизацию, то есть принудительно выводить на экран столько кадров, сколько в нем герц. В случае, если видеокарта может выдать большее количество fps, она будет простаивать, а вы получите приятную нерваную картинку. Ну а если монитор 60 Гц, а видеокарта может выдать всего 30-40 fps? В таком случае некоторые кадры будут отображаться на экране вдвое дольше, чем должны, то есть задержка вывода будет скакать между 17 и 34 мс. Разумеется, это будет ощущаться на деле как «вязкое» управление, и играть так будет неприятно.

Какой выход из данной ситуации? Принудительно синхронизировать частоту обновления монитора с количеством кадров, выводимых видеокартой. Иными словами, монитор будет подстраиваться под видеокарту и выводить кадр столько времени, сколько нужно видеокарте на рендеринг следующего, который он снова выведет без всяких задержек. Как итог — вы получаете по сути вертикальную синхронизацию при любом fps. Ну, почти любом.

На данный момент существуют две технологии, которые позволяют убрать разрывы при выводе динамического контента — это AMD FreeSync и Nvidia G-Sync. Разница между ними в том, что первая технология использует для синхронизации частоты развертки и fps видеокарту, а данные об этом передаются по DisplayPort. Вторая технология требует в мониторе наличия специального чипа, который пропускает через себя видеопоток с видеокарты и «подгоняет» под него частоту обновления монитора. Очевидно, что второй подход дороже, причем временами значительно: переплата за чип от Nvidia доходит до 10-20 тысяч рублей.

Что же лучше? Еще год назад я бы сказал, что этот вопрос не корректен: видеокарты от AMD умеют работать только с FreeSync, а видеокарты от Nvidia умели тогда работать только с G-Sync. Однако с учетом того, что видеокарты GTX 1000 и RTX 2000 используют видеоинтерфейс DisplayPort 1.2, дабы соответствовать требованиям VESA компании Nvidia пришлось некоторое время назад добавить в вышеуказанные видеокарты поддержку FreeSync под видом G-Sync Compatible.

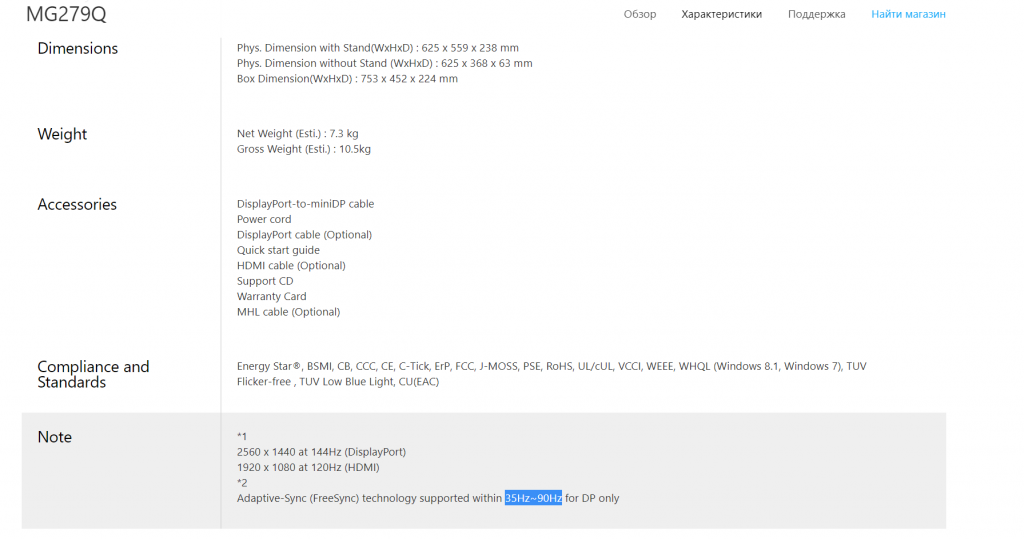

Выходит, что переплачивать за G-Sync теперь нет смысла? Опять же не совсем так. В теории, FreeSync может работать на частотах обновления монитора от 9 до 240 Гц, чего более чем достаточно для подавляющего большинства мониторов и игр. Но что мы видим на практике? Многие даже достаточно дорогие мониторы с ценником выше 1000 долларов поддерживают адаптивную герцовку лишь в узком диапазоне 48-90 Гц (весь список мониторов есть тут). И это при том, что сами они могут быть и 144 Гц! То есть получается, что или вы теряете преимущества быстрой матрицы и играете с

60 fps, или же вы забываете про FreeSync и играете со 100+ fps, но терпите разрывы изображения.

144 Гц, IPS, разрешение 2К — и поддержка FreeSync мелким текстом внизу: от 35 до 90 Гц. Смысл в ней в таком диапазоне не совсем понятен.

Разумеется, есть и такие мониторы, которые поддерживают FreeSync в диапазоне от 48 до 240 Гц, но их очень немного. При этом у мониторов с G-Sync такой проблемы нет: все они гарантированно поддерживают адаптивную герцовку в диапазонах от 30 Гц до родной частоты обновления матрицы. Согласитесь, это куда приятнее и охватывает весь диапазон «играбельного» fps.

В итоге ситуация получается следующей: для пользователей видеокарт от AMD выбора нет, не хотите видеть разрывы — берите монитор с FreeSync, хотите при этом высокую герцовку — придется поискать подходящее решение, которое зачастую может быть дороже видеокарты. Для пользователей видеокарт от Nvidia ситуация интереснее: если хотите плавную картинку без разрывов при любом нормальном fps — имеет смысл переплатить за монитор с G-Sync. Но если есть желание сэкономить — можете окунуться в мир FreeSync мониторов, которых на данный момент около 1000 штук. Драйвером поддерживаются они все, так что выбор по герцовке остается только за вами.

Во второй и заключительной части статьи мы поговорим про остальные «фишки» игровых мониторов, такие как многозонная подсветка, вставка черного кадра и некоторые другие.