Dmp системы что это

Что такое платформа управления данными (DMP)?

Если сказать кратко, DMP — это платформа, которая помогает собрать, упорядочить, активировать данные из различных источников и представить их в удобном виде. Хотя платформы DMP могут получать различные типы данных и управлять ими, чаще всего их используют для работы с неперсональными данными.

По мере накопления данных клиентов важно найти решения для управления и хранения, однако соответствующее решение обеспечивает не только эти возможности. Платформы DMP помогают собирать сложные наборы данных из всех источников и управлять ими. Кроме того, благодаря им можно анализировать данные для принятия решений, упростить перенос и покупку внешних данных, а также подключиться к сторонним рекламным сетям и биржам для покупки целевой рекламы.

Однако у платформ DMP действительно есть определенные ограничения, поэтому важно сразу проверить, подходит ли выбранное решение для хранения и анализа данных в компании. В зависимости от типа обрабатываемых данных может потребоваться другая система хранения.

Какие возможности мне предоставит DMP?

Платформа DMP предлагает несколько способов применения полезной аналитики, полученной на основе данных.

Определяйте свою целевую аудиторию и размещайте рекламные объявления, направленные на заинтересованных клиентов.

Разрабатывайте содержимое и обслуживание, адаптируя их для сегментированных аудиторий.

Подключайтесь к рекламным биржам для размещения целевой рекламы.

Приобретайте, собирайте и анализируйте данные из вторичных и сторонних источников, а также продавайте свои данные как вторичные.

Какими типами данных можно управлять с помощью DMP?

Вы можете собирать и анализировать три различных типа данных с помощью DMP.

Собственные данные

Первичные данные включают в себя все информацию, собранную при прямом взаимодействии с клиентами, например адреса электронной почты, поведение, демографические данные и история покупок. Первичные данные можно собирать непосредственно от клиентов с помощью форм, регистраций и прямых взаимодействий. Однако часто их также собирают с помощью отслеживания пикселей, файлов cookie и идентификаторов устройств.

Несмотря на то что платформы DMP собирают и анализируют первичные данные, они выполняют это только для создания анонимных профилей пользователей и анализа аудитории. Обычно первичными данными управляют с помощью платформа данных клиентов (CDP), которая собирает и упорядочивает их, а затем может передавать в DMP для включения в профили аудитории.

Партнерские данные

Как и первичные, вторичные данные обычно содержат сведения о клиентах и их поведении и собираются с помощью прямых взаимодействий, отслеживания пикселей или файлов cookie. Основное отличие заключается в том, что данные изначально были собраны другой организацией.

Вторичные данные дают возможность анализировать клиентов за пределами своего существующего клиентского пула и получить сведения о более широкой аудитории, которая представляет интерес для маркетинга. Вторичные данные можно приобрести или обменяться ими между компаниями через взаимовыгодные договоры. Фактический обмен вторичными данными можно упростить с помощью платформ DMP.

Поскольку DMP не может работать только с первичными данными, в дополнение к ним можно использовать вторичные данные, что получить возможность создавать профили аудитории и аналитику, даже если текущий клиентский пул слишком мал для крупномасштабного анализа.

Сторонние данные

Сторонние данные — это данные из различных источников, которые объединены и доступны для покупки. Фактически, агрегаторы больших данных приобретают первичные данные у издателей и других владельцев данных и собирают их в большие наборы данных, которые затем будут доступны для покупки через платформы DMP. Сторонние данные используются как дополнение к первичным и вторичным данным, чтобы расширить и повысить точность профилей целевых клиентов.

Как анализировать данные с помощью DMP?

Анализируйте данные в четыре этапа с помощью платформы управления данными.

Используйте DMP, чтобы собрать все первичные данные, получить вторичные и сторонние данные. Затем DMP упорядочит все данные по категориям и таксономиям на основе заданных бизнес-целей и маркетинговых моделей.

DMP анализирует данные и создает сегменты аудитории, которые точно представляют клиентскую базу в широком диапазоне каналов на основе различных общих характеристик.

Используйте DMP для подключения других аналитических инструментов и глубокого анализа аудитории. Выявляйте новые потенциальные аудитории и принимайте решения о разработке и создании содержимого.

Применяйте аналитику и аудитории, созданные на основе ваших данных. Используйте DMP для подключения к рекламным биржам, платформам со стороны предложения (SSP) и спроса (DSP) и размещайте целевую рекламу. Собирайте и продавайте первичные данные как вторичные с помощью DMP.

Какие ограничения накладываются на работу с DMP?

Несмотря на все преимущества платформы управления данными, в определенных случаях ее возможности уступают другим вариантам анализа данных.

Уровень анализа на платформах DMP обычно требует больше времени на обработку для получения и анализа новых данных. В отличие от платформ CDP, данные в DMP невозможно просмотреть в реальном времени.

Поскольку данные DMP часто зависят от файлов cookie, обычно их хранят только 90 дней.

DMP не может работать только с первичными данными, поэтому обычно необходимо приобретать дополнительные данные.

Несмотря на возможность просматривать аналитику, созданную в DMP, данные, на основе которых она создана, доступны не всегда.

Профили клиентов основаны только на атрибутах, а не на отдельных удостоверениях. Вы можете размещать рекламу для аудитории на основе профилей клиентов, однако не имеете возможности отслеживать или запускать целевую рекламу для отдельных пользователей с помощью DMP.

В чем различия между DMP и CDP?

Платформы управления данными имеют все необходимые возможности для хранения и анализа больших коллекций вторичных и сторонних данных, упрощают сбор и перенос внешних данных. Для хранения и анализа первичных данных оптимально подойдет платформа CDP, поскольку она обеспечивает доступ к необходимому хранилищу данных и предоставляет ряд дополнительных преимуществ.

Основное назначение платформы DMP — анонимное сегментирование и категоризация клиентов с целью рекламы. С помощью CDP можно создавать постоянные профили клиентов. Таким образом, можно создать отдельную запись для каждого клиента на основе уникального идентификатора, например имени, IP-адреса или адреса электронной почты, и получить доступ к его данным.

Создание постоянных профилей клиентов с помощью CDP позволяет упорядочить персональные данные клиентов и получить доступ к ним для целевого использования. Кроме того, платформа CDP поможет упорядочить первичные данные и передать их в DMP для определения профилей аудитории.

Эффективное использование первичных данных в CDP

Обойдите ограничения платформ DMP с помощью CDP. Унифицируйте первичные данные по всем источникам, оптимизируйте взаимодействие и получайте аналитику, чтобы обеспечить персонализированное обслуживание с помощью Dynamics 365 Customer Insights.

Узнайте, как приложение Dynamics 365 Customer Insights использует первичные данные и помогает найти особый подход к каждому клиенту.

DMP часть 1. Микросегментирование аудитории с помощью ключевых слов

Авторы статьи: Данила Перепечин DanilaPerepechin, Дмитрий Чеклов dcheklov.

Здравствуйте.

Data management platform (DMP) — это наша любимая тема во всей истории про онлайн рекламу. RTB is all about the data.

В продолжение цикла рассказов о технологическом стеке Targetix (SSP, DSP), сегодня я опишу один из инструментов, входящих

в DMP — Keyword Builder.

Микросегментирование

Keyword Builder помогает рекламодателям создавать очень узкие аудиторные сегменты (их еще называют микросегментами). Для построения таких аудиторий мы решили использовать следующий механизм: рекламодатель задает список ключевых слов, а на выходе получает аудиторию, состояющую из тех пользователей, которые посещали страницы с указанными ключевыми словами или искали эти слова в поиске. С одной стороны это очень простой инструмент, с другой — он дает маркетологам довольно большие возможности для экспериментов.

Основное преимущество этого инструмента — полный контроль над созданием аудитории. Рекламодатель четко понимает, какие пользователи в итоге увидят рекламу. Например, можно создать аудиторию на основе такого списка ключевых слов: ford focus, opel astra, toyota corola.

Как это выглядит со стороны рекламодателя:

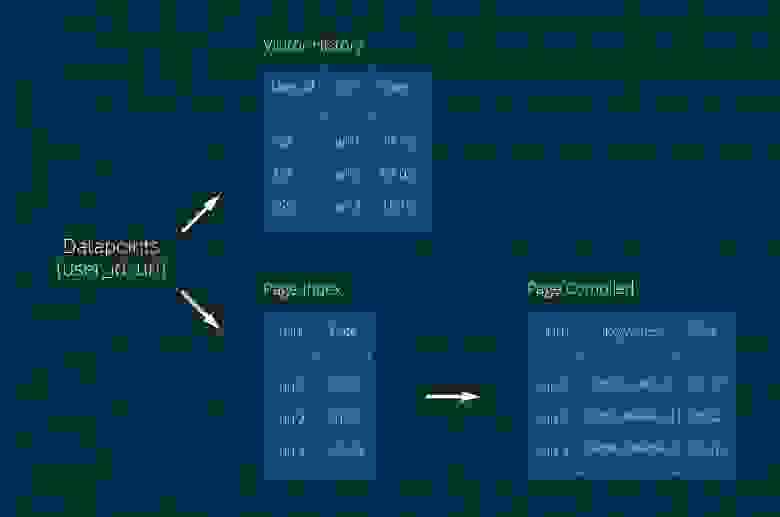

В первую очередь, для решения этой задачи мы от всех возможных поставщиков данных (Raw Data Suppliers) получаем clickstream (история посещения страниц пользователем). Данные приходят к нам в таком виде:

Цели и требования

Основное требование, которое мы предъявляли к инструменту — скорость создания аудитории. Этот процесс не должен занимать больше 5 минут даже для самых высокочастотных слов. Также важно, чтобы рекламодатель в интерфейсе при указании ключевого слова мог оценить размер аудитории. Оценка размера должна происходить в реальном времени при вводе слов (не более 100 мс, как видно на видео выше).

Первая архитектура, которая учит, «как не надо делать»

Вначале использовали MongoDB и всё шло довольно неплохо.

В коллекцию Visitor History записывали данные о пользователе, в Page Index — о страницах. URL страницы сам по себе ценности не представляет — страницу надо скачать и извлечь ключевые слова. Тут возникла первая проблема. Дело в том, что коллекции Page Compiled сначала не было, а ключевые слова записывались в Page Index, но одновременная запись ключевых слов и данных от поставщиков создавала слишком высокую нагрузку на эту коллекцию. Поле Keywords обычно большое, по нему необходим индекс, а в MongoDB той поры (версия 2.6) существовал lock на коллекцию целиком при операции записи. В общем, пришлось вынести ключевые слова в отдельную коллекцию Page Compiled. Пришлось — ну и что же, проблема решена — мы рады. Сейчас уже трудно вспомнить количество и характеристики серверов… что-то порядка 50 shard’ов.

Для создания аудитории по ключевым словам мы делали запрос в коллекцию Page Compiled, получали список URL’ов, на которых встречались эти слова, с этим списком шли в коллекцию Visitor History и искали пользователей, которые посещали эти страницы. Работало всё хорошо (сарказм) и мы могли создать 5, а то и 10(. ) аудиторных сегментов в сутки… если, конечно, ничего не упадёт. Нагрузка в то время была около 800 млн. datapoint’ов в сутки, TTL индекс — 2 недели: 800*14… данных было много. Работа спорилась и за 3 месяца нагрузка возросла вдвое. Но брать ещё N серверов для поддержания жизни этой странной конструкции было не комильфо.

Самый большой и очевидный минус этой архитектуры — вышеописанный запрос, связанный с получением списка URL. Результатом этого запроса могли быть тысячи, миллионы записей. А главное, по этому списку нужно было сделать запрос в другую коллекцию.

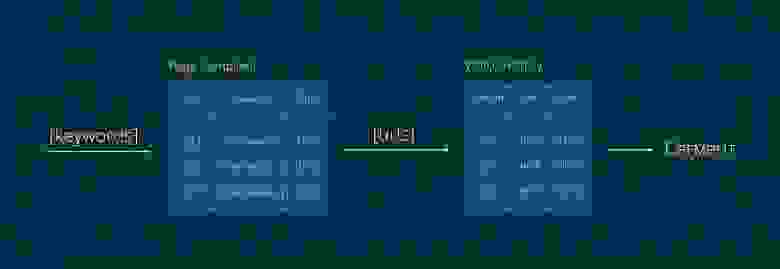

К чему мы пришли

Вообще, с самого начала было понятно, что что-то пошло не так, но теперь это стало очевидно. Мы пришли к выводу, что необходима таблица, которая будет обновляться в режиме реального времени и содержать записи следующего вида:

Проанализировав возможные решения, мы выбрали не на одну базу данных, а их комбинацию с небольшим дублированием данных. Сделали мы это потому, что издержки на дублирование данных были не сопоставимы с тем, какие возможности нам давала эта архитектура.

Первое решение — это платформа полнотекстового поиска Solr. Позволяет создавать распределенный индекс документов. Solr — популярное решение, имеющее большое количество документации и поддерживаемое в сервисе Cloudera. Однако работать с ним как с полноценной БД не получилось, мы решили добавить в архитектуру распределённую колоночную БД HBase.

В начале решили, что в Solr в качестве документа будет выступать user, в котором будет индексируемое поле keywords со всеми ключевыми словами. Но так как мы планировали удалять старые данные из таблицы, то решили в качестве документа использовать связку user+date, что стало полем User_id: то есть каждый документ должен хранить все ключевые слова пользователя за день. Такой подход позволяет удалять старые записи по TTL-индексу, а также строить аудитории с разной степенью «свежести». Поле Real_Id — настоящий id пользователя. Это поле используется для агрегации в запросах с указанной длительностью интереса.

Кстати, чтобы не хранить лишние данные в Solr, поле keywords сделали только индексируемым, что позволило нам существенно сократить объем хранимой информации. При этом сами ключевые слова, как вы уже поняли, можно достать из HBase.

Таким образом мы смогли сократить издержки, связанные с тяжёлыми запросами. Но это не все элементы, которые оказались нам необходимы и стали нашим фундаментом. В первую очередь мы нуждались в обработке больших объёмов данных на лету и тут как нельзя кстати пригодился Apache Spark с его streaming-функционалом. А в качестве очереди данных мы выбрали Apache Kafka, которая как нельзя лучше подошла для этой роли.

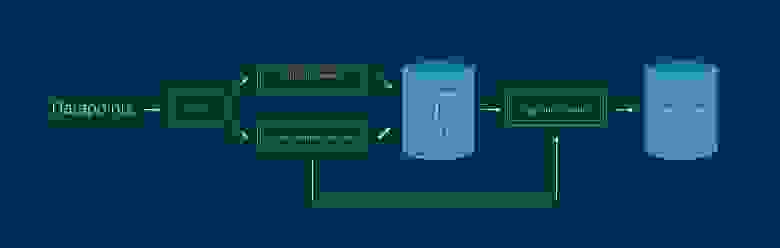

Теперь рабочая схема выглядит следующим образом:

1. Из Kafka данные выбирают два процесса. Функционал очереди позволяет читать её нескольким независимым процессам, каждый из которых имеет свой курсор.

Особенностью PageIndexer является выбор ключевых слов со страницы, для разных типов страниц — разные наборы слов.

Работает на 1-2 серверах 32GB RAM Xeon E5-2620, скачивает 15-30К страниц в минуту. При этом выбирая из очереди 200-400К записей.

А основным достоинством VisitorActionReceiver, то что помимо добавления записей в Solr/HBase, данные так же пересылаются в Segment Builder и новые пользователи добавляются в аудитории в реальном времени.

100 ГБ. Solr занимает

250 млн записей TTL индекс 7 дней. (Все цифры без учёта репликации).

Коротко напомним основные элементы инфраструктуры:

Kafka — умная и устойчивая очередь, HBase — быстрая колоночная БД, Solr — давно зарекомендовавший себя поисковый движок, Spark — распределённые вычисления, включая streaming, а главное, всё это находится на HDFS, прекрасно масштабируется, мониторится и очень устойчиво. Работает в окружении Cloudera.

Заключение

Может показаться, что мы усложнили рабочую схему большим разнообразием инструментов. На самом деле мы пошли по пути наибольшего упрощения. Да, одну монгу мы поменяли на список сервисов, но все они работают в той нише, для которой и создавались.

Теперь Keyword Builder действительно отвечает всем требованиям рекламодателей и здравому смыслу. Аудитории в 2.5 млн людей создаются за 1-7 минут. Оценка размера аудитории происходит в реальном времени. Задействовано всего 8 серверов (i7-4770, 32GB RAM). Добавление серверов влечёт за собой линейный рост производительности.

А получившийся инструмент вы всегда можете попробовать в ретаргетинговой платформе Hybrid.

Выражаю горячую благодарность пользователю dcheklov, за помощь в создании статьи и наставлении на путь истинный =).

Тема DMP начата и остаётся открытой, ждите нас в следующих выпусках.

DMP-платформы в рекламе: как это работает и что может пойти не так

Объединение FMCG-производителей и ритейлеров ECR провело рабочую группу, посвященную монетизации данных, где свои DMP-платформы представили «Магнит» и «Эвотор», а специалисты из Dentsu Aegis Network объяснили, какие подводные камни встречаются при работе с подобными площадками

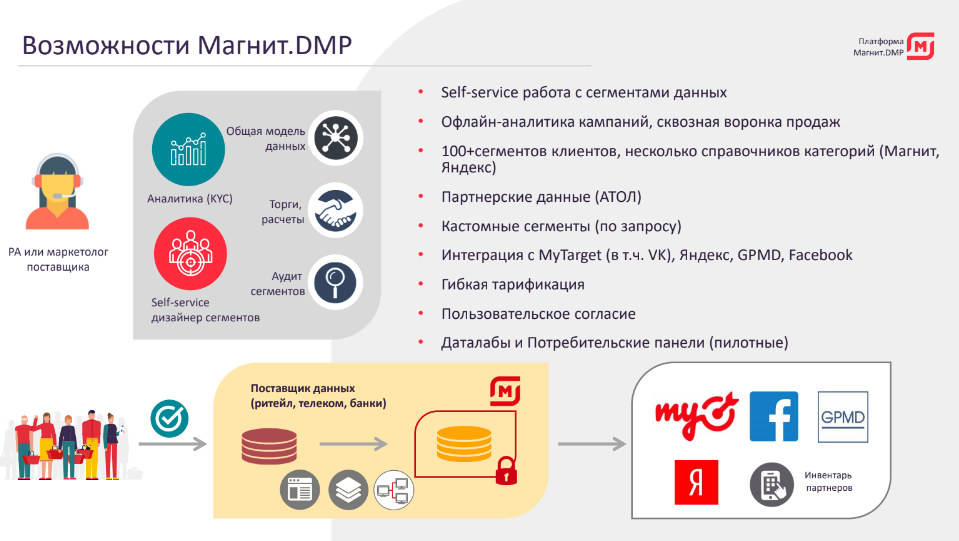

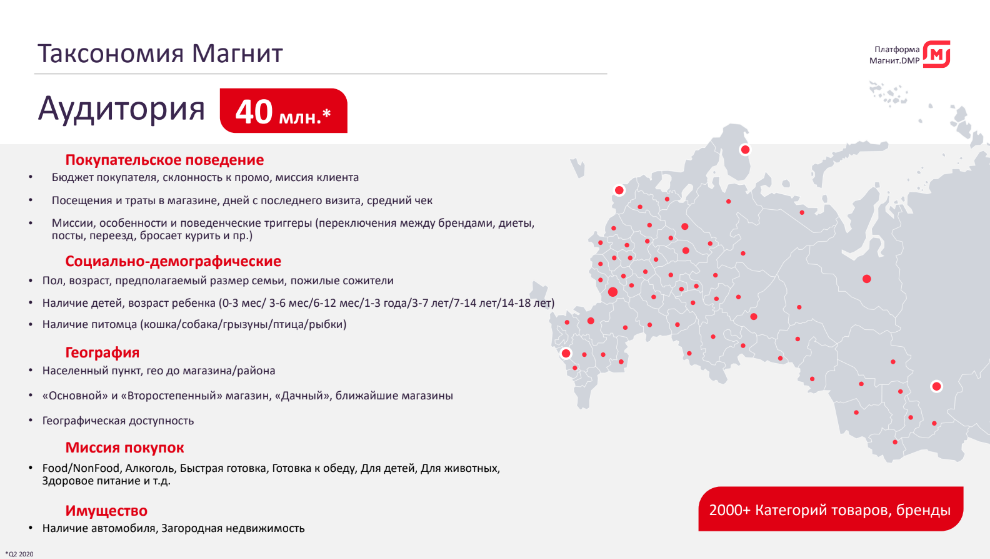

Артем Алексеев, директор департамента аналитики и управления данными «Магнита», рассказал, как на DMP-платформе ритейлера можно сформировать целевой портрет аудитории, запустить для нее таргетированную рекламу и замерить эффективность кампании.

Платформа представляет собой аналитический портал, где собираются агрегированные данные о поведении покупателей во всех форматах торговых площадок «Магнита»: гипермаркетах, супермаркетах, магазинах косметики, малых форматах и аптеках. Это позволяет видеть кросс-форматное потребление покупателей. В ближайшее время компания собирается выпустить для пользователей купоны, привязанные к приложению, где в том числе будут размещаться предложения партнеров. Там же планируется запуск потребительских опросов, в том числе с использованием сегментов, сформированных в DMP-платформе.

На данный момент решение доступно рекламным группам, и в будущем возможно использование платформы для производителей, которые сами занимаются цифровым маркетингом.

Платформа работает на данных «Магнита» и партнера ОФД «Атол». Ритейлер планирует расширить список такими поставщиками данных, как банки, компании из телеком-сектора, ОФД и другими.

Перед началом работы пользователь выбирает одного или обоих поставщиков в личном кабинете, а затем настраивает сегмент. Его можно подобрать с помощью конструктора по различным атрибутам: выбрать возраст, географию и другие социально-демографические показатели аудитории (пол, семейный статус и т. д.), а также наличие детей и их возраст, есть ли домашнее животное. Пользователь может выбрать ценовой сегмент и долю промотоваров, преобладающих в корзине покупателя, а также форматы торговых точек сети «Магнит», которые посещает потребитель.

В кабинете можно выбрать миссию — с какой целью человек пришел на магазин: покупка алкоголя, быстрая готовка или приготовление обеда, взять что-то к чаю или приобрести здоровое питание. Использование этой опции дает возможность, не указывая конкретные категории или бренды, выбрать сегмент людей, для которых характерны определенные покупательские привычки. Например, для бренда пельменей может быть релевантна миссия «Быстрая готовка» в целом, так как позволяет охватить более широкую целевую аудиторию, не перечисляя категории по отдельности (вареники, сосиски, лапша и пр.). Кроме этого, платформа позволяет сформировать динамические аудитории по событию (триггеру), например, потребитель бросает курить, переехал или у него приближается день рождения и пр.

Для более точного таргетинга указываются конкретные категории и товары, частота их покупок и период. Это позволяет не только выбрать покупателей определенной категории, но и реализовать другие механики:

— Пополнение. Реклама адресуется покупателям, у которых наверняка заканчивается купленный товар (например, шампунь).

— Кросс-продажи. Выбрать покупателей, которые покупают шампунь, но не берут бальзам.

— Up-sell. Перевод покупателя на более дорогой товар

— Выбрать покупателей с низкой лояльностью или в оттоке.

Пользователь может настроить таргетинг либо на бренд, участвующий в самой цифровой рекламе, либо на категорию без этого бренда, однако нацелить рекламную кампанию на конкретного конкурента платформа не позволит.

Сформировав сегмент, пользователь выбирает, в какую площадку его импортировать: myTarget, Facebook, «Яндекс.Аудитории», Gazprom-Media Digital. После этого в рекламном кабинете на выбранных ресурсах появляется новый сегмент, на который можно таргетировать рекламу. По итогу кампании в платформе отображаются основные метрики. При работе с myTarget можно подключить «Магнит» для панельного исследования (с аналитикой по основным действиям пользователей в онлайн).

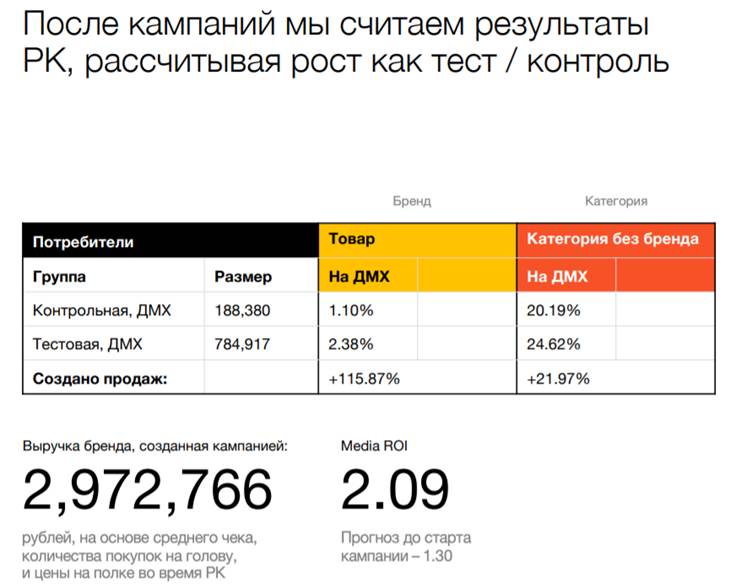

В базовом аналитическом отчете клиент увидит результаты онлайн-кампании: количество показов, просмотров, кликов, CTR. Результаты в офлайн: количество визитов в магазин, объем покупок, средняя покупка в штуках и в рублях по рекламируемому бренду и др. Все показатели приростов и эффективности рекламы оцениваются методом AB-тестирования с выделением статистически сформированных тестовой и контрольной групп. Для проверки различных гипотез, оптимизации рекламы, в том числе в ходе проведения рекламной кампании, общая аудитория кампании может быть разбита на множество сегментов, каждый из которых оценивается отдельно.

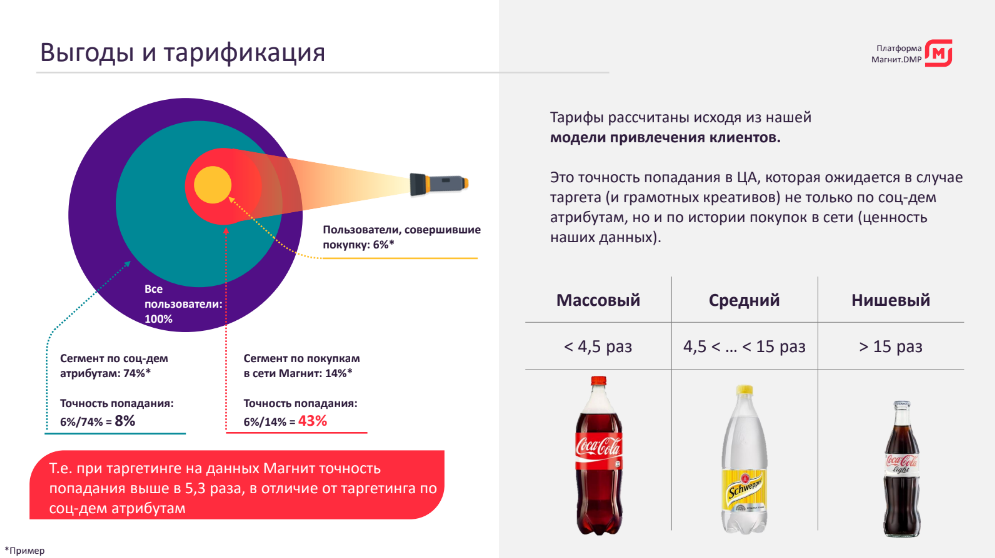

Тарифы по использованию сегментов на данных ритейлера рассчитываются на основании ценности данных ритейлера для итогового «попадания» в целевую аудиторию и делятся на три категории — «Массовый», «Средний» и «Нишевый».

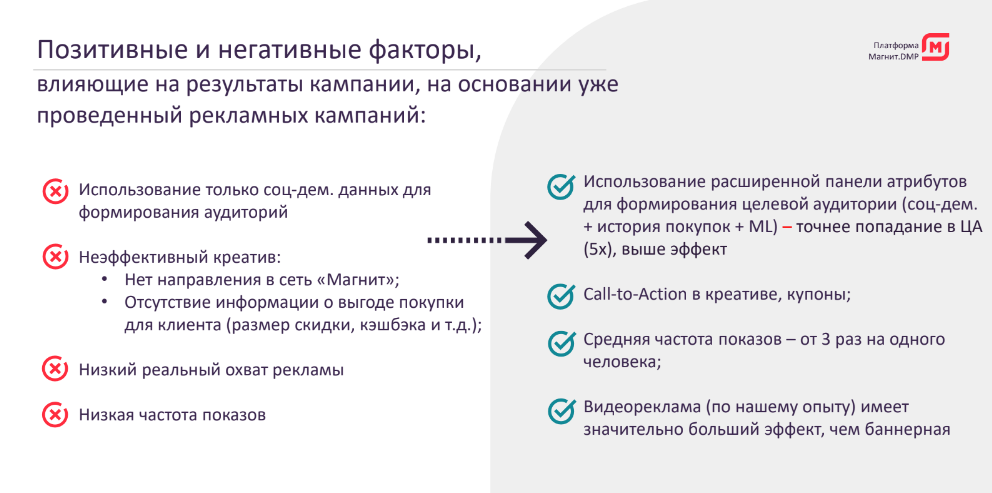

По результатам проведенных кампаний «Магнит» отмечает наибольший эффект рекламы, в которой выполняются следующие условия: точный подбор аудитории на основе аналитики клиентов бренда, использование более продвинутых механик пополнения, кросс-продаж, создание интересного креатива с призывом к действию (сроки акции, участвующие сети и форматы), настройка достаточно высокой частоты показов рекламы — не меньше трех раз.

В будущем среди прочего ритейлер планирует настроить на платформе более глубокую оценку эффективности кампаний, реализовать аналитику по аудиториям бренда (в том числе сравнение с категорией, в динамике до и после кампаний), подбор и оптимизацию сегментов с использованием машинного обучения, подключить новых дата-провайдеров и настроить потребительские панели, которые позволят верифицировать результаты рекламы и оценить приросты brand awareness.

Платформа DMP «Магнит» построена на основе решений компании Aggregion, специализирующейся на разработке продуктов для управления цифровыми объектами, и облачных технологий Microsoft.

Как найти аудиторию в офлайне нестандартным способом

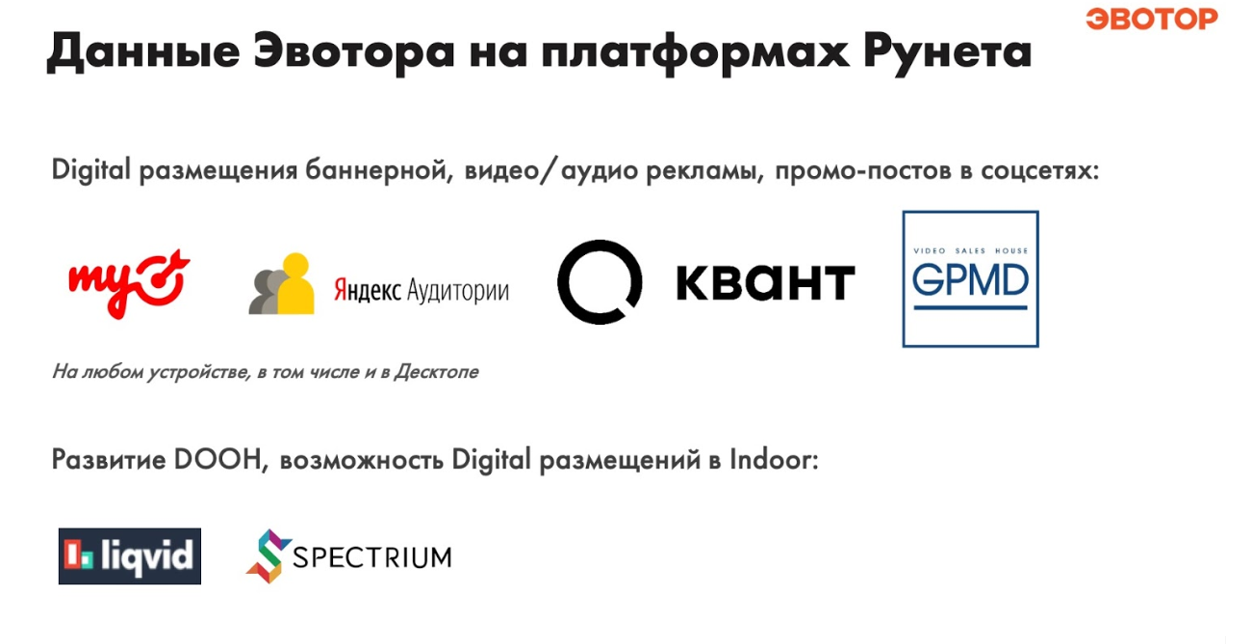

DMP-платформа от «Эвотора» помогает персонализировать рекламу исходя из мест, которые посещают люди, и услуг, которыми они пользуются. Как это работает, объяснил директор по развитию рекламных продуктов Игорь Оганесян.

За основу берутся данные, собираемые компанией с фирменных смарт-терминалов, работающих в режиме сбора МАС-адресов в радиусе 70 м. Чеки покупателей помогают определить категории торговых точек и сегментировать аудиторию. Сейчас в эксплуатацию запущено 600 тыс. таких терминалов. Покрытие — средний и малый бизнес.

Полученные сегменты аудитории импортируются на цифровые площадки или используются для таргетинга цифровой наружной рекламы и индор-размещений.

Целевую аудиторию бренда компания ищет не только в профильных магазинах, но и в других точках посещения.

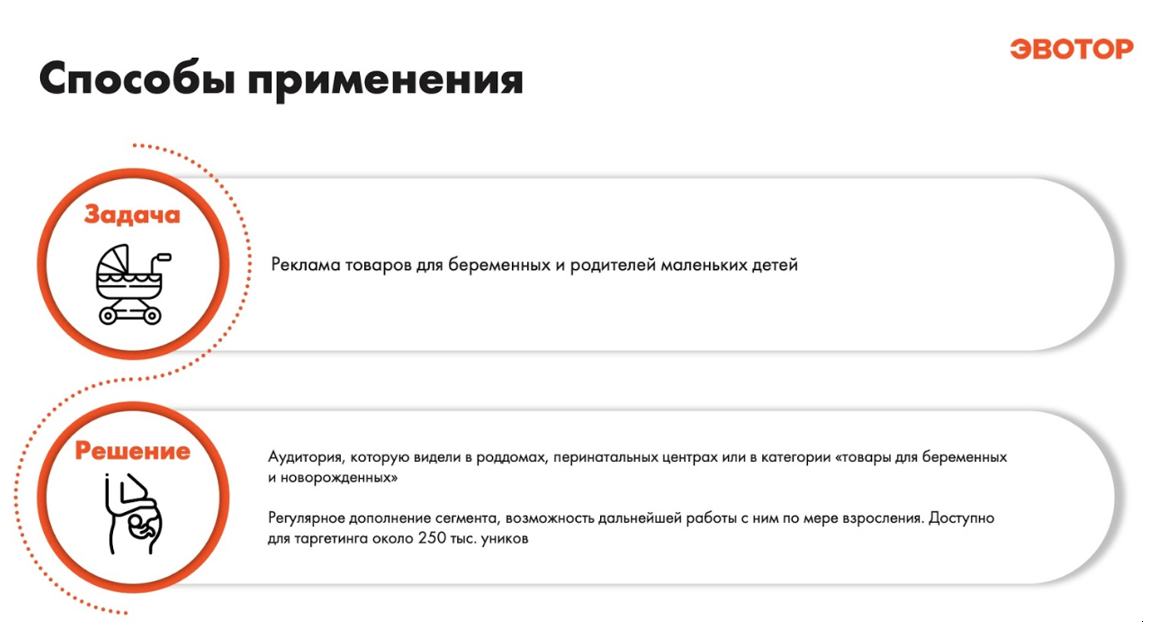

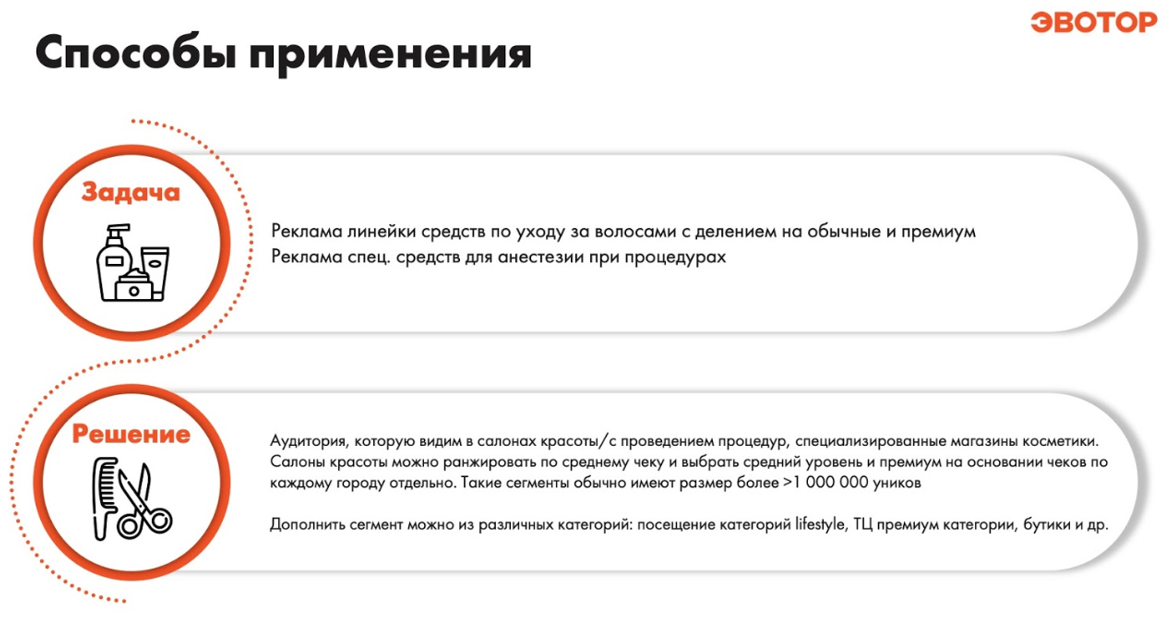

Например, покупателей товаров для беременных можно найти с помощью платформы «Эвотора» в роддомах и перинатальных центрах, где есть какие-либо коммерческие услуги.

Если необходимо сделать рекламу средств по уходу за волосами с делением на обычные и премиум-товары, то аудиторию можно найти в салонах красоты, торговых центрах и бутиках, разбив их на две категории по среднему чеку, который будет отличаться в разных городах.

Данные «Эвотора» также использовались в рекламной кампании бренда Naked, который принадлежит PepsiCo. Задача рекламной кампании — повысить узнаваемость среди целевой аудитории и увеличить продажи смузи Naked на аудиторию, ведущую здоровый образ жизни.

Площадкой для размещения рекламы стали бизнес-центры, в которых расположены цифровые экраны BrandBoard компании Spectrum. «Эвотор» собрал MAC-адреса посетителей гастромаркетов в центре Москвы («Даниловский», «Депо», «Цветной» и других) и объединил эту аудиторию с посетителями бизнес-центров, рядом с которыми есть точки продаж смузи Naked. После запуска кампании в DOOH рекламное сообщение ретаргетировалось в соцсетях Instagram и Facebook (через технологического партнера).

По данным OMD OM Group, которое проводило эту кампанию, продажи в магазинах, рядом с которыми было indoor-размещение, выросли по отношению к остальным магазинам в этот же период в среднем на семь процентных пунктов. Группа видевших indoor-рекламу показала почти в три раза выше CTR и в 2,5 раза выше Engagement Rate по сравнению с теми, кто ее не видел.

Подводные камни монетизации данных

Михаил Шкляев, Chief Transformation Officer Dentsu Aegis Network, перечислил шесть основных трудностей, с которыми команда столкнулась при работе с большими данными.

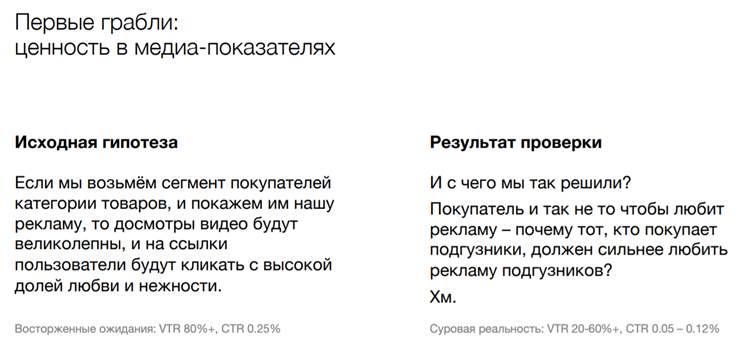

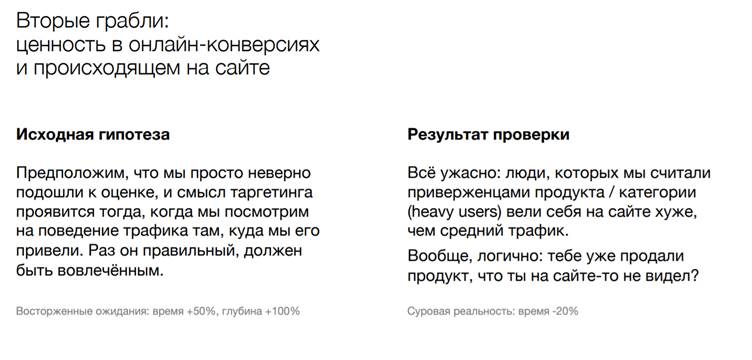

1. Заблуждение, что покупатель категории будет охотнее смотреть рекламу о товаре. На поверку оказывается, что люди в целом не жалуют рекламу. Даже если они лояльны категории. На практике оказалось, что длительность просмотра рекламы в таких кампаниях была ниже среднего.

2. Ошибочное представление о том, что лояльные категории люди будут чаще кликать рекламу. Человек мог уже купить товар, тогда объявление не даст результата. Кроме того, сам сайт, где покупатель видит креатив, в 98% случаев не связан с продуктом, поэтому пользователю непонятно, зачем кликать на баннер или видео. Более того, человек может не знать, что у него есть возможность взаимодействовать с баннером.

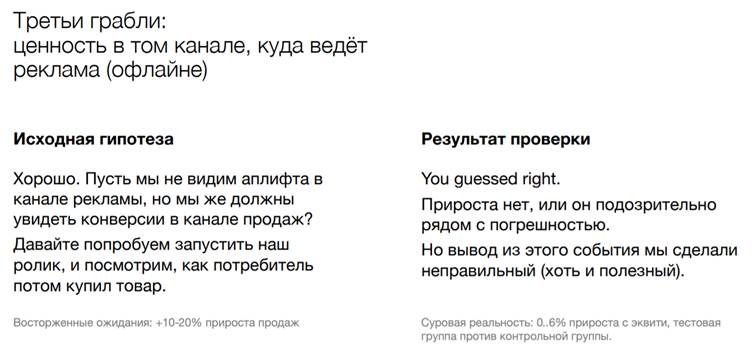

3. Попытка оценить эффективность кампании через офлайн-канал. Команда запустила ролик, где призвала пользователей посетить определенного ритейлера, что дало прирост продаж в 6% — это низкий показатель.

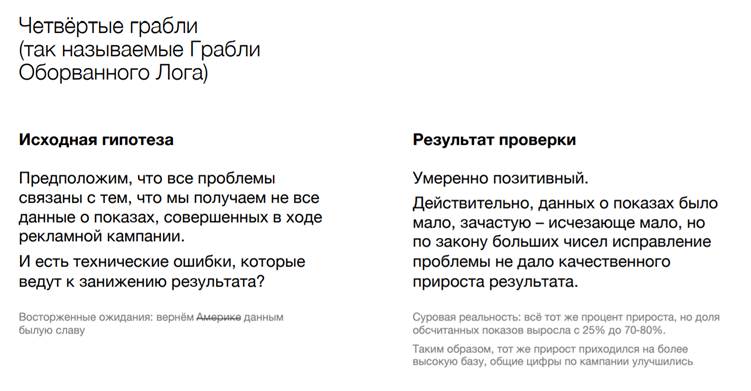

4. Для более полной оценки рекламы нужно собрать больше логов, тогда и выяснится, что результат кампании выше. По факту при большем объеме информации прирост остался тем же.

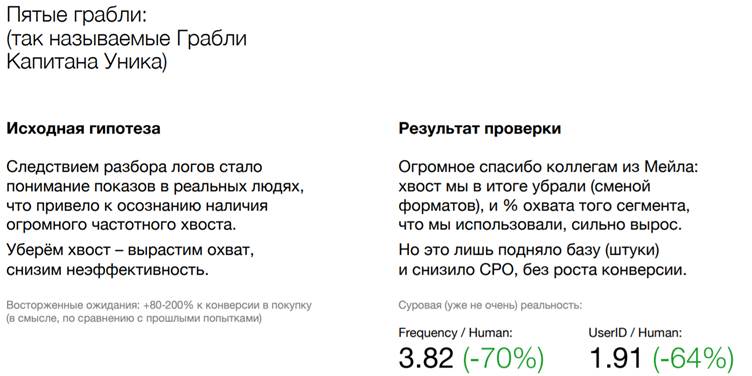

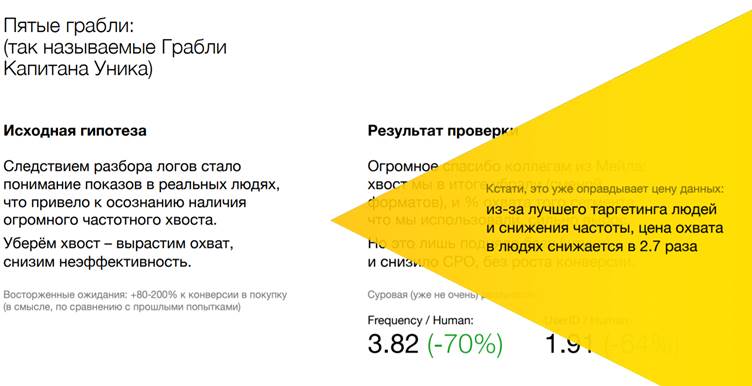

5. Налаживание частоты показа рекламы. Изначально объявления показывались уникам, однако известный факт, что на одного реального человека приходится несколько уников. В результате команда нашла человека, которому реклама была показана больше пяти тысяч раз, при этом с технической стороны как унику креативы ему показывались в разумных количествах. В итоге показ рекламы потом перевели на условные универсальные ID, предоставляемые Mail.ru Group. Это помогло снизить частоту показа и цену охвата.

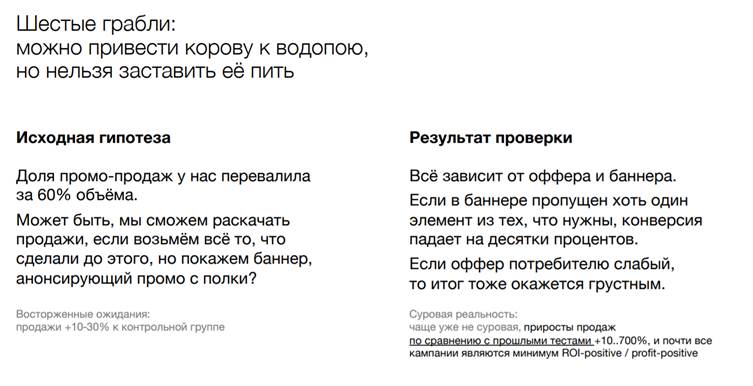

6. Человек приходит к полке, но как заставить его купить именно ваш продукт? В этот момент должен начать работать сам бренд, но в последнее время при принятии решения о покупке потребители все чаще смотрят на цену и легко могут выбрать стоящего рядом конкурента, если его предложение более привлекательно. Поэтому пользователям начали сообщать в рекламе, что необходимо прийти к конкретному ритейлеру в определенные сроки, чтобы получить специальное предложение. И тогда результат оказался выше.

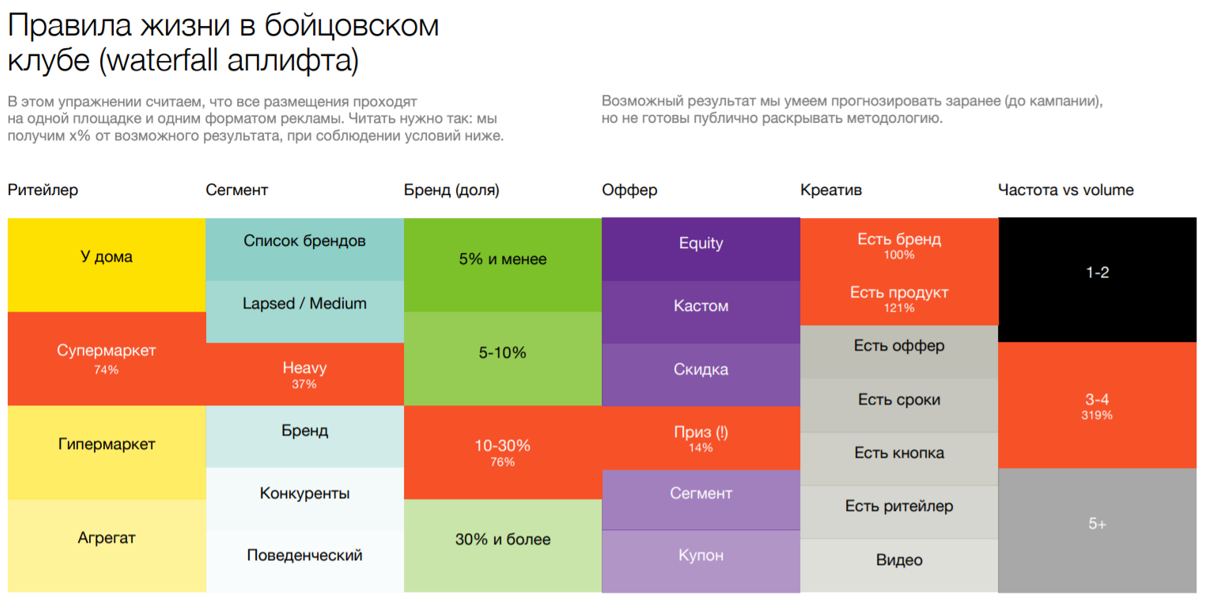

На результат рекламы влияет несколько ключевых критериев.

• Категория товара. Например, эффективность рекламы кофе за год упала в три раза. Из-за высокого промодавления люди перестали видеть разницу между товарами этой категории и стали плохо реагировать на рекламу.

• Тип ритейлера, к которому отправляет реклама. Человек скорее купит товар в магазине у дома, чем в гипермаркете, куда ему придется ехать, — пока он туда доберется, рекламное сообщение уже забудется.

• Сегмент аудитории. Чаще всего клиенты просят взять в качестве целевой аудитории «хеви юзеров» (активные пользователи) товара, но это люди с уже сформированными привычками, они уже кого-то любят. Их сложно переключить. Поэтому проще всего это работает на «медиум-юзерах» — их предпочтения легче менять.

• Доля бренда в категории. Если бренд маленький и потребитель его не знает, конверсия будет той же, а вот база для конверсии — ниже; как следствие, абсолютный эффект от кампании будет слабее. Для таких марок или продуктов важен «зонтик», то есть крупный и сильный «материнский» бренд. Команда много раз тестировала этот подход, и он всегда повышает результат кампании. Но в целом, когда бренд или продукт небольшие, результаты стабильно ниже.

• Предложение. Часто бренды любят показывать автомобиль, который можно выиграть в рамках промо. Но у кампаний с призами — худшие конверсии. Люди на них не реагируют. Им понятнее скидки и бонусы — пусть и маленький, но достижимый и гарантированный результат.

• Креатив. Должны быть выполнены минимальные требования: бренд, продукт, предложение, сроки, кнопка, указание ритейлера, подобран правильный формат. На удивление, видео работает хуже, потому что рекламу показывают в соцсетях, а там пользователи не успевают ее досмотреть, поэтому если цель — продажи прямо здесь и сейчас, лучше использовать баннерные креативы.

• Частота показа. Промокампанию достаточно показать потребителю один-два раза, при этом реклама продемонстрирует высокие показатели ROI. Если продемонстрировать объявление 3–4 раза, ROI окажется ниже, но в абсолютных показателях продажи вырастут — это хороший вариант, когда нужно освободить полку под другой товар.

ECR (объединение FMCG-производителей и ритейлеров) регулярно проводит рабочие группы по монетизации данных, где участники обмениваются опытом, вырабатывают стандарты и инициируют коллаборативные проекты. В работе принимают участие FMCG-производители, сети, отраслевые ассоциации, исследовательские компании, ОФД, кассы, банки, телеком, консалтинг, интеграторы, data-сервис-провайдеры, медийные агентства.