Дубли страниц на сайте чем плохо

Дубли страниц на сайте – почему это опасно и как их убрать!

Здравствуйте, уважаемые друзья и гости блога! Сегодня очень важная тема для всех, кто занимается блоггингом и сайтостороением, а также для начинающих и может быть для уже бывалых блоггеров, которые об этом еще не знают – ДУБЛИ СТРАНИЦ на сайте, почему они появляются, на что влияют дубли страниц и как с ними бороться и искоренить их раз и на всегда!

Вот какой обширный и важный вопрос, который не терпит отлагательств. Потому, что дубли страниц на вашем сайте сыграют очень злую шутку и Вы в конце концов можете даже лишиться своего сайта или блога! Я ни сколько не пугаю Вас, друзья. Это горькая правда!

А лишиться сайта или блога из-за дублей страниц можно потому, что ваш ресурс просто не будет продвигаться и Вы его рано или поздно, но все равно когда-то забросите, попросту вам станет не интересно им заниматься, так как посетителей у Вас будет очень мало и видимость его в поисковиках будет столь ничтожной, что вам самим станет этот сайт не интересен.

Вот такова доля тех сайтов, которые плодят дубли страниц, а таких большинство – поверьте мне!

Переходим к самому важному и интересному …

Как найти дубли страниц на сайте?

Сначала давайте с вами разберемся, что такое дубли страниц на сайте?

Поиск дублей страниц на сайте заключается в следующем. Вам нужно набрать в поисковике Google вот такие комбинации:

site:site.ru replytocom

site:site.ru feed

site:site.ru tag

site:site.ru page

site:site.ru comment-page

site:site.ru attachment

site:site.ru attachment_id

site:site.ru category

site:site.ru trackback

Где, site.ru – адрес вашего сайта!

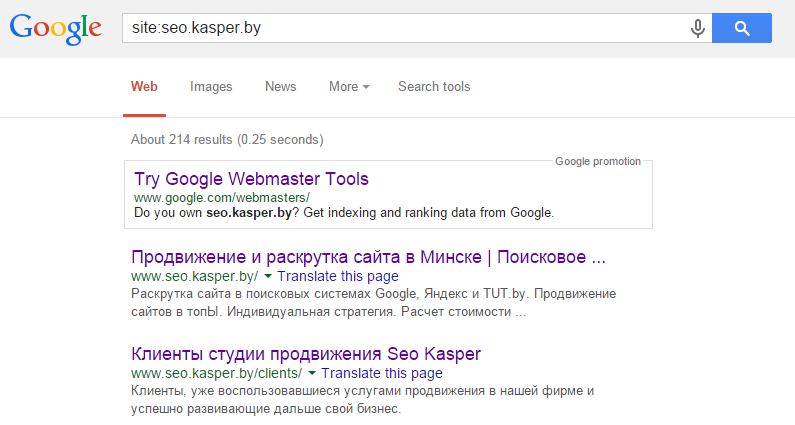

И по очередно, набирая эти комбинации своего сайта и этих тегов, искать в поисковике Гугла до самого конца, проходя по страницам, которые будут под номерами высвечиваться внизу. А когда вылезет вот такое “Показать скрытые результаты”, то нажмите и на него! Вот тогда Вы сами убедитесь, есть у Вас дубли страниц на сайте или нет. Пример поиска дублей страниц:

Я взял сайт для примера чисто наугад, да простит меня автор этого сайта, но в конце концов, может быть это ему пригодится?!

Вот так вот и проделайте со всеми предложенными мной примерами набора тегов для поиска дублей страниц на вашем сайте и Вы узнаете есть ли они у Вас.

Как избавиться раз и на всегда от противных и ненужных дублей страниц?

Чтобы дубли страниц не появлялись у вас на сайте, вам нужно перво наперво сделать правильный файл robots.txt для вашего сайта. О нем я уже писал на своем блоге, смотрите в статье “Правильный robots.txt“.

Затем в файл function.php своей активной темы оформления на сайте добавить вот такой не хитрый код:

Внесите все эти изменения на своем сайте и Вы больше никогда не увидите дубли страниц!

Дубликаты страниц

Почему дубли страниц плохо влияют на ранжирование сайта?

Откуда берутся дубли?

Самая распространенная причина – это генерация дублей страниц системой управления из-за неправильных настроек. Самый известный пример – CMS Joomla, с проблемой дублей на ней приходится сталкиваться чуть ли не на каждом сайте.

Частичные дубли часто встречаются на сайтах интернет-магазинов:

Как найти дубли страниц?

Есть несколько способов поиска дубликатов страниц, каждый из которых может дать разные результаты.

1. Некоторые распространенные варианты дублей можно проверить вручную.

2. Проанализировать страницы, проиндексированные поисковыми системами.

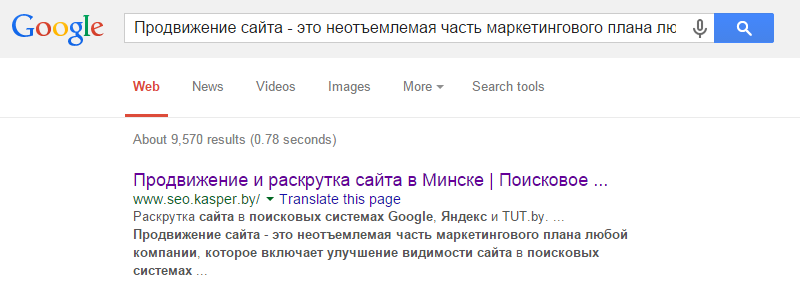

3. Поиск по фрагменту текста

Вбивая в поиск длинные фрагменты текста, можно найти места, где он повторяется (а заодно и сайты, которые скопировали ваш текст). Но здесь есть два минуса: метод подходит, если на сайте мало страниц, и то, что поисковая система может анализировать запрос до определенной длины.

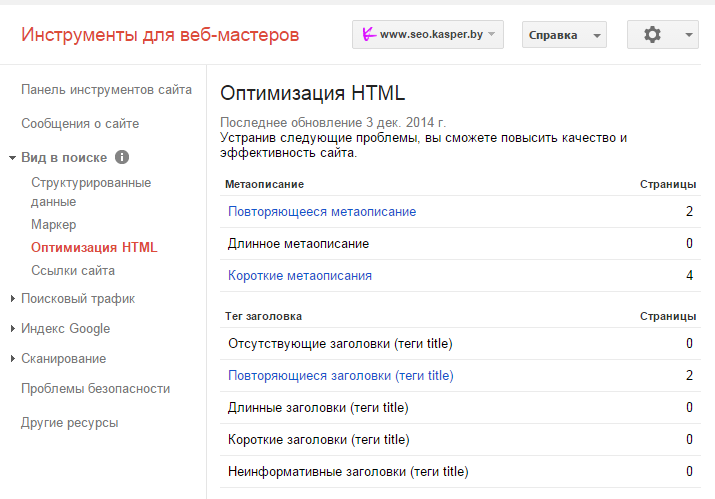

4. Заглянуть в панель вебмастера Google

В разделе «Вид в поиске» находим вкладку «оптимизация HTML» и ищем значение поля «Повторяющиеся метаописания» и «Повторяющиеся заголовки». Нажав на них, можно увидеть список всех страниц с повторяющимися тегами title и description и сами заголовки и описания.

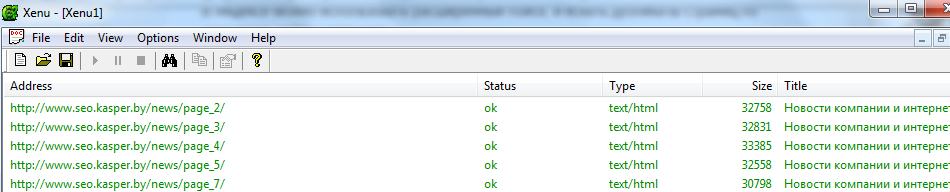

5. Воспользоваться программой Xenu`s Link Sleuth

Программа распространяется бесплатно и способна определить url всех страниц сайта, включая скрипты и картинки, а также внешние ссылки. Кроме дубликатов в ней удобно искать битые ссылки – страницы, которые возвращают код 404.

Как устранить дубли страниц?

Для этого существует 4 действенных способа, самыми жесткими из которых. По нашему мнению, являются первые два.

Это можно сделать на небольших сайтах, хорошенько разобравшись в своей системе управления и сделав правильные настройки, чтобы предотвратить последующее появление дубликатов страниц.

2. Настройка 301 редиректа

301 редирект – это постоянное перенаправление пользователей с одной страницы на другую, что приводит к их склеиванию. Он позволяет передать странице до 99% ссылочного веса, как внутреннего, так и внешнего.

Чтобы настроить главное зеркало, необходимо прописать следующий код:

Чтобы склеить нечеткие дубли со / и без него, воспользуйтесь кодом:

Постраничный редирект выглядит так:

Для формирования более сложных редиректов потребуется воспользоваться правилами. Существуют специальные сервисы, где можно сгенерировать код для настройки редиректа по определенному шаблону:

3. Использовать Rel=”Canonical”

Этот вариант лучше использовать в случае частичных дублей, так как неканоническая страница при этом не удаляется физически с сайта и доступна пользователям.

«link rel=»canonical» href=»http://site.com/kopiya»/»

4. Настройка Robots.txt

Также действенный способ, но удалить уже проиндексированные дубликаты таким образом будет сложно.

С помощью директивы Disallow указываются все адреса и их типы, на которые роботам поисковых систем не стоит заходить для индексации. Например:

— говорит о том, что поисковому боту Яндекс не стоит заходить на страницы, url которых содержит index.

Найти и устранить все дубликаты – основная задача на первых этапах продвижения сайта, иначе можно взяться просто не за те страницы, и долго искать проблему.

Как найти и удалить дубли страниц на сайте? Инструкция

24.03.2020 Время прочтения: 8 минут

Почему дубли страниц — это плохо?

Дубли — это страницы с одинаковым содержимым, т.е. они дублируют друг друга.

Причины, по которым страницы дублируются, могут быть разными:

Дубли страниц — это плохо для продвижения и раскрутки сайта, даже несмотря на то, что они могут появляться по естественным причинам. Дело в том, что поисковые роботы хуже ранжируют страницы, контент которых мало чем отличается от других страниц. И чем больше таких страниц, тем больше сигналов поисковым ботам, что это сайт не достоин быть в топе выдачи.

Что происходит с сайтом, у которого есть дубликаты страниц?

В общем, становится понятно, что дубли никому не нужны. Давайте разбираться, как найти и обезвредить дублирующиеся страницы на сайте.

Как найти дубли страниц?

Кирилл Бузаков,

SEO-оптимизатор компании SEO.RU:

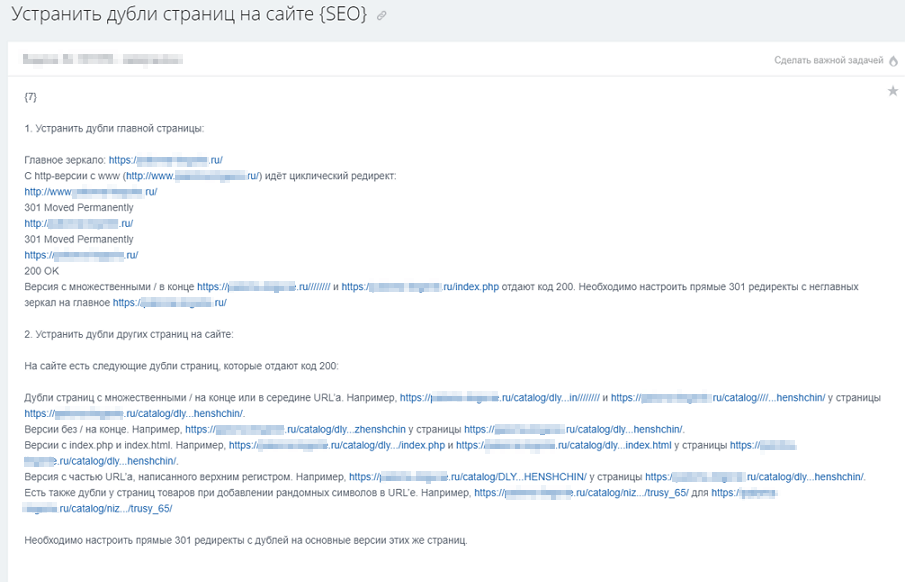

«Когда мы получаем в работу сайт, мы проверяем его на наличие дублей страниц, отдающих код 200. Разберем, какие это могут быть дубли.

Возможные типы дублей страниц на сайте

Дубли страниц с протоколами http и https.

Например: https://site.ru и http://site.ru

Дубли с www и без.

Например: https://site.ru и https://www.site.ru

Дубли со слешем на конце URL и без.

Например: https://site.ru/example/ и https://site.ru/example

Дубли с множественными слешами в середине либо в конце URL.

Прописные и строчные буквы на различных уровнях вложенности в URL.

Например: https://site.ru/example/ и https://site.ru/EXAMPLE/

Дубли с добавлением на конце URL:

Например: https://site.ru/example/ и https://site.ru/example/index.html

Дубли с добавлением произвольных символов либо в качестве нового уровня вложенности (в конце или середине URL), либо в существующие уровни вложенности.

Например: https://site.ru/example/saf3qA/, https://site.ru/saf3qA/example/ и https://site.ru/examplesaf3qA/

Добавление произвольных цифр в конце URL в качестве нового уровня вложенности.

Например: https://site.ru/example/ и https://site.ru/example/32425/

Дубли с добавлением «звездочки» в конце URL.

Например: https://site.ru/example/ и https://site.ru/example/*

Дубли с заменой дефиса на нижнее подчеркивание или наоборот.

Например: https://site.ru/defis-ili-nizhnee-podchyorkivanie/ и https://site.ru/defis_ili_nizhnee_podchyorkivanie/

Дубли с некорректно указанными уровнями вложенности.

Например: https://site.ru/category/example/ и https://site.ru/example/category/

Дубли с отсутствующими уровнями вложенности.

Например: https://site.ru/category/example/ и https://site.ru/example/

Как обнаружить дубли страниц?

Поиск дублей страниц можно произвести разными способами. Если вы хотите собрать все-все дубли и ничего не упустить, лучше использовать все нижеперечисленные сервисы совместно. Но для поиска основных достаточно какого-то одного инструмента, выбирайте, какой вам ближе и удобнее.

Парсинг сайта в специализированной программе

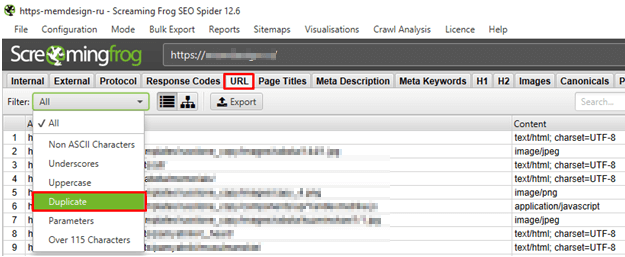

Для поиска дубликатов подходит программа Screaming Frog SEO Spider. Запускаем сканирование, а после него проверяем дубли в директории URL → Duplicate:

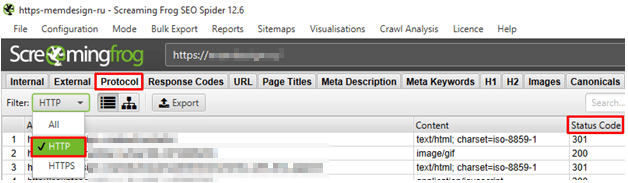

Кроме того, в директории Protocol → HTTP проверяем страницы с протоколом http — есть ли среди них те, у которых Status Code равен 200:

Онлайн-сервисы.

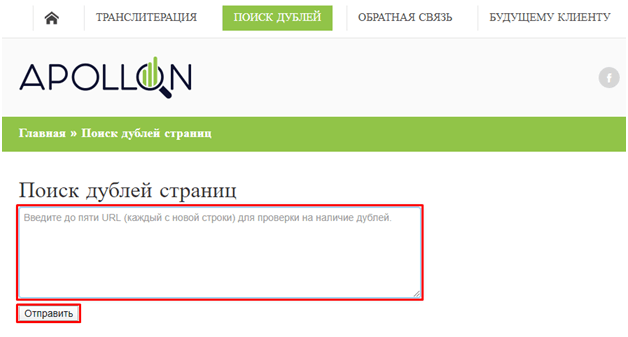

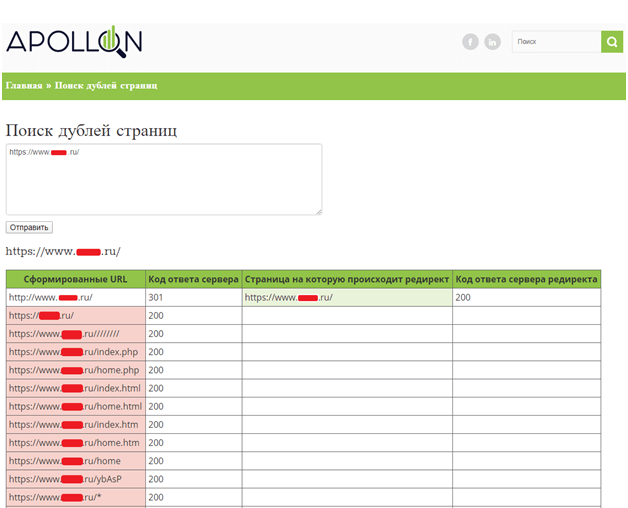

Первый, подходящий нашим целям сервис, — это ApollonGuru.

Кроме того, необходимо проверять, что с дублей настроены прямые 301 редиректы на основные версии этих же страниц.

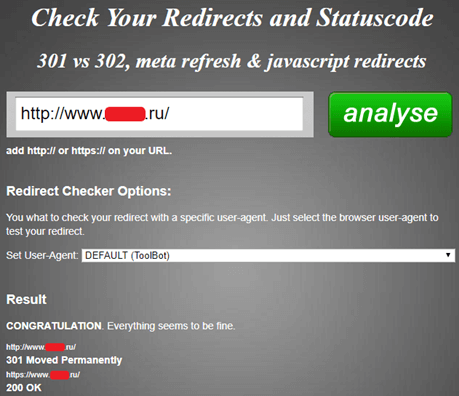

Также проверка дублей сайта возможна онлайн-сервисом Check Your Redirects and Statuscode, но он подходит только в том случае, если нужно проанализировать один URL-адрес:

Панели веб-мастеров Яндекса и Google.

Найти дублирующиеся страницы можно с помощью собственных инструментов поисковиков — Яндекс.Вебмастера и Google Search Console.

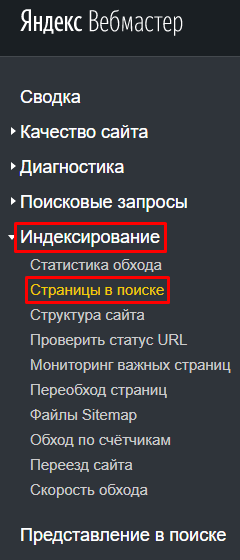

В Яндекс.Вебмастере анализируем раздел «Индексирование», далее — «Страницы в поиске»:

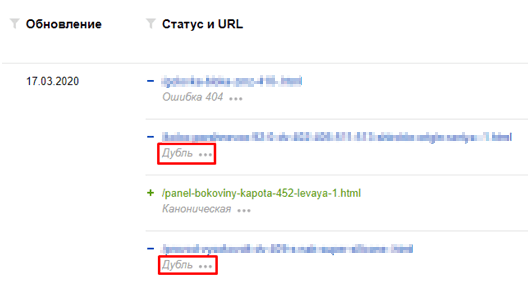

Там можно увидеть текущую индексацию сайта и искомые дубли страниц:

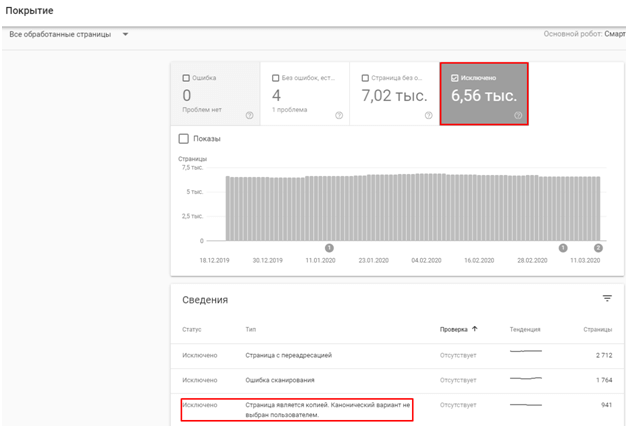

В Search Console анализируем раздел «Покрытие», а именно пункт с исключенными из индекса страницами:

Собираем все дубли в одну таблицу или документ. Затем отправляем их в работу программисту:

Старайтесь подробнее объяснить программисту задачу, так как адресов может быть много».

Как убрать дубли страниц на сайте?

Евгений Костырев,

веб-программист компании SEO.RU:

«С дублирующимися страницами бороться можно разными способами. Если есть возможность, стоит использовать ручной метод. Но такая возможность есть не всегда, потому что здесь нужны серьезные навыки программирования: как минимум, нужно хорошо разбираться в особенностях CMS своего сайта.

Другие же методы не требуют специализированных знаний и тоже могут дать хороший результат. Давайте разберем их.

301 редирект

301 редирект — это самый надежный способ избавления от дублей, но при этом самый требовательный к профессиональным навыкам программиста.

Как это работает: если сайт использует сервер Apache, то нужные правила в файле .htaccess с помощью регулярных выражений.

Самый простой вариант 301 редиректа с одной страницы на другую:

Redirect 301 /test-1/ http://site.ru/test-2/

Устанавливаем 301 редирект со страницы с www на страницу без www (главное зеркало — домен без www):

Организуем редирект с протокола http на https:

Прописываем 301 редирект для index.php, index.html или index.htm (например, в Joomla), массовая склейка:

RewriteCond %

RewriteRule^(.*)index\.(php|html|htm)$ http://site.ru/$1 [R=301,L]

Если же сайт использует Nginx, то правила прописываются в файле nginx.conf. Для перенаправления также нужно прописывать правила с помощью регулярных выражений, например:

location = /index.html <

return 301 https://site.com

>

Вместо index.html можно указать любой другой URL-адрес страницы вашего сайта, с которого нужно сделать редирект.

На этом этапе важно следить за корректностью новой части кода: если в ней будут ошибки, исчезнут не только дубли, но и вообще весь сайт из всего интернета.

Создание канонической страницы

Использование canonical указывает поисковому пауку на ту единственную страницу, которая является оригинальной и должна быть в поисковой выдаче.

Чтобы выделить такую страницу, нужно на всех URL дублей прописать код с адресом оригинальной страницы:

Можно прописывать их вручную, но это займет много времени, поэтому есть смысл использовать плагины. Например, в WordPress это YoastSEO или AllinOneSEOPack.

В 1С-Битрикс это делается с помощью языка программирования PHP в соответствующих файлах. Такая же история и с CMS Joomla: без вмешательства программиста или собственных навыков программирования здесь не обойтись.

Директива Disallow в robots.txt

В файле robots.txt содержатся инструкции для поисковых краулеров, как именно индексировать сайт.

Если на сайте есть дубли, можно запретить краулеру их индексировать с помощью директивы:

User-agent: *

Disallow: site.ru/contacts.php?work=225&s=1

Такой способ практически не требует навыков программиста, однако он не подходит, если дублей много: очень много времени уйдет на изменение robots.txt каждого дубля».

Выбирайте способ, исходя из собственных навыков программирования и личных предпочтений, и не давайте поисковикам повод сомневаться в релевантности и качестве вашего сайта.

Дубликаты страниц на сайте: чем вредны и как от них избавиться?

Примечание: если вы знаете что такое дубли страниц и чем они вредны для продвижения, можно сразу перейти в четвертый раздел «Как выявить дубли страниц».

Разберем общее понятие:

Дубликаты страниц — это полная или частичная копия основной веб-страницы на сайте, которая участвует в продвижении. Как правило копия находится на отдельном URL-адресе.

Чем вредны дубликаты страниц при продвижении сайта?

Многие владельцы сайтов даже не подозревают о том, что на сайте может присутствовать большое количество дубликатов, наличие которых плохо сказывается на общем ранжировании сайта. Поисковые системы воспринимают данные документы как отдельные, поэтому контент страницы перестает быть уникальным, тем самым снижается ссылочный вес страницы.

Наличие небольшого количества дублей страниц не будет являться большой проблемой для сайта. Но если их число зашкаливает, то от них необходимо избавляться в срочном порядке.

Виды дубликатов страниц

Существуют различные виды дубликатов страниц, самые распространенные из них представлены в рисунке 1:

Рис. 1. Виды дубликатов страниц

Разберем подробнее представленные виды дублей страниц.

Полные дубликаты страниц — полное дублирование контента веб-документа, различия только в URL-адресе.

Частичные дубликаты страниц — частичное дублирование контента веб-документов, когда дублируется наполнение сайта с небольшими различиями. Например, большие фрагменты текстов дублируются на нескольких страницах сайта — это уже частичные дубликаты или похожие карточки товаров, которые отличаются только одной незначительной характеристикой.

Внешние дубликаты страниц — полное или частичное дублирование контента на разных сайтах.

Технические дубликаты — это дубликаты, которые генерируются автоматически из-за неправильных настроек системы управления сайтом.

Дубликаты, созданные человеком — это дубликаты страниц, которые были созданы по невнимательности самим вебмастером.

Как выявить дубли страниц?

Способов обнаружить дубликаты страниц — множество. В данной статье рассмотрим несколько основных методов, которые используются в работе чаще всего.

1. Парсинг сайта в сервисе

При парсинге сайта в каком-либо сервисе (в последнее время чаще всего используют сервис Screaming Frog) наглядно можно увидеть страницы-дубликаты.

К примеру, когда не склеены зеркала либо у страниц есть какие-то параметры, которые добавляются автоматически при отслеживании эффективности рекламных кампаний и др.

Рис. 2. Пример парсинга сайта в сервисе Screaming Frog при не склеенных зеркалах

Небольшой лайфхак для работы с сервисом Screaming Frog: если у сайта огромное количеством страниц, и вы сразу заметили, что зеркала не склеены и поставили проект на парсинг, естественно процесс замедлится и уменьшит скорость работы вашей системы (если у вашего ПК, конечно, не мощные системные характеристики).

Чтобы этого избежать можно использовать функцию Configuration – URL Rewriting – Regex Replace.

В вкладке Regex Replace создаем следующее правило (используя регулярное выражение, «говорим» сервису, как нужно склеивать зеркала, чтобы он выводил только страницы с HTTPS):

Рис. 3. Скриншот из сервиса Screaming Frog — Использование функции URL Rewriting

Далее нажимаем кнопку «ОК» и переходим во вкладку «Test». В данной вкладке сервис вам покажет, правильно ли вы задали правило и как будут склеиваться зеркала. В нашем случаем должен выходить такой результат:

Рис. 4. Скриншот из сервиса Screaming Frog — Использование функции Test

Таким же способом можно склеивать страницы с «www» и без «www», а также задавать различные параметры, чтобы не выводить ненужные страницы (например, страницы пагинации).

После всех операций спокойно запускаем парсинг сайта без дополнительной нагрузки на систему.

2. Использование панели Яндекс.Вебмастер

Рис. 5. Скриншот из панели Яндекс.Вебмастер — Использование функции Страницы в Поиске

Для полного анализа дубликатов страниц рекомендуется выгрузить xls-файл всех страниц, которые присутствуют в поиске:

Рис. 6. Выгрузка страниц в поиске из панели Яндекс.Вебмастер

Открываем наш xls-файл и включаем фильтр: Данные – Фильтр:

Рис. 7. Скриншот из xls-файла «Выгрузка страниц в поиске из панели Яндекс.Вебмастер»

В фильтре выбираем «DUPLICATE», и перед нами будет список дубликатов страниц. Рекомендуется проанализировать каждую страницу или один тип страниц, (если, например, это только карточки товаров) на предмет дублирования.

Например: поисковая система может признать дубликатами похожие карточки товаров с незначительными отличиями. Тогда необходимо переписать содержание страницы: основной контент, теги и метатеги, если они дублируются, либо такие карточки склеить с помощью атрибута rel=”canonical”. Другие рекомендации по избавлению от дубликатов страниц подробно описаны в пункте 5.

3. Использование Google Search Console

Заходим в Google Search Console, выбираем свой сайт, в левом меню кликаем «Вид в поиске» – «Оптимизация HTML» и смотрим такие пункты, которые связаны с термином «Повторяющееся»:

Рис. 8. Скриншот из панели «Google Console»

Данные страницы могут и не являются дубликатами, но проанализировать их нужно и при необходимости устранить проблемы с дублированием.

4. Использование операторов поиска

Для поиска дубликатов также можно использовать операторы поиска «site:» и «inurl», но данный метод уже устарел. Его полностью заменила функция «Страницы в поиске» в Яндекс.Вебмастере.

Рис. 9. Скриншот из поисковой выдачи – использование поисковых операторов

5. Ручной поиск

Для ручного поиска дубликатов страниц необходимо уже обладать знаниями о том, какие дубликаты могут быть. Вручную обычно проверяются такие типы дубликатов, как:

一 URL-адрес с “/” и без “/” в конце. Проверяем первую страницу сайта с “/” и без “/” в конце в сервисе bertal. Если обе страницы отдают код ответа сервера 200 ОК, то такие страницы являются дубликатами и их необходимо склеить 301 редиректом

一 добавление в URL-адрес каких-либо символов в конце адреса или в середине. Если после перезагрузки страница не отдает 404 код ответа сервера или не настроен 301 Moved Permanently на текущую основную страницу, то перед нами, по сути, тоже дубликат, от которого необходимо избавиться. Такая ошибка является системной, и ее нужно решать на автоматическом уровне.

Как избавиться от дубликатов страниц: основные виды и методы

В данном пункте разберем наиболее часто встречающиеся виды дубликатов страниц и варианты их устранения:

一 Настроить 301 Moved Permanently на основное зеркало, обязательно выполните необходимые настройки по выбору основного зеркала сайта в Яндекс.Вебмастер.

Выполнить следующие действия:

一 Использовать теги next/prev для связки страниц пагинации между собой;

一 Если первая страница пагинации дублируется с основной, необходимо на первую страницу пагинации поставить тег rel=”canonical” со ссылкой на основную;

一 Добавить на все страницы пагинации тег:

Данный тег не позволяет роботу поисковой системы индексировать контент, но дает переходить по ссылкам на странице.

一 Корректно настроить страницы фильтрации, чтобы они были статическими. Также их необходимо правильно оптимизировать. Если все корректно настроено, сайт будет дополнительно собирать трафик на страницы фильтрации;

一 Закрыть страницы-дубликаты в файле robots.txt с помощью директивы Disallow.

一 Склеить похожие товары с помощью тега rel=”canonical”;

一 Реализовать новый функционал на странице карточки товара по выбору характеристики. Например, если есть несколько почти одинаковых товаров, которые различаются только, к примеру, цветом изделия, то рекомендуется реализовать выбор цвета на одной карточке товара, далее – с остальных настроить 301 редирект на основную карточку.

一 Закрыть в файле robots.txt.

一 Настроить корректный 404 код ответа сервера.

一 Настроить 301 редирект со страниц старой структуры на аналогичные страницы в новой структуре.

一 Закрыть в файле robots.txt;

一 Настроить 301 редирект со страниц дубликатов на основные.

一 Cклеить страницы с помощью тега rel=”canonical”;

一 Лучшим решением будет вынести все страницы товаров под отдельный параметр в URL-адресе, например “/product/”, без привязки к разделам, тогда все товары можно раскидывать по разделам, и не будут “плодиться” дубликаты карточек товаров.

一 В данном случае необходимо проставить на всех страницах тег rel=”canonical” со ссылкой страницы на саму себя, так как закрытие таких страниц в файле robots.txt может повредить корректному отслеживанию эффективности рекламных кампаний.

Устранение дублей позволит поисковым системам лучше понимать и ранжировать ваш сайт. Используйте советы из этой статьи, и тогда поиск и устранение дублей не будет казаться сложным процессом.

И повторюсь: малое количество дубликатов не так значительно скажется на ранжировании вашего сайта, но большое количество (более 50% от общего числа страниц сайта) явно нанесет вред.