Edge computing что это

Edge-ик в тумане и другие приключения периферийных вычислений

Меня зовут Игорь Хапов. Я руководитель разработки в Научно-техническом центре IBM. И сегодня я хотел бы вам помочь окунуться в мир периферийных вычислений, или edge computing, как его ещё называют. Я расскажу о том, что же такое edge computing и как он может повлиять на наш с вами мир. Также хотелось бы пояснить различия между edge computing и fog computing, какие преимущества даёт этот подход. В статье я также описал референсную архитектуру приложения на edge computing. И под конец немного расскажу о проекте с открытым исходным кодом Open Horizon, который совсем недавно присоединился к Linux Foundation.

Что же такое edge computing

Согласно определению Гартнера, edge computing — это подвид распределенных вычислений, в котором обработка информации происходит в непосредственной близости к месту, где данные были получены и будут потребляться. Это основное отличие edge computing от облачных вычислений, при которых информация собирается и обрабатывается в публичных или частных датацентрах. Основным отличием от локальных вычислений является то, что обычно edge computing — это часть большей системы, которая включает в себя сбор статистики, централизованное управление и удаленное обновление приложений на edge устройствах.

Что же такое edge устройство? Многие считают, что edge computing — это когда приложение работает на Raspberry Pi или других микрокомпьютерах. На самом деле edge computing может быть и на мобильных устройствах, персональных ноутбуках, умных камерах и других устройствах, на которых можно запустить приложение по обработке данных.

Edge computing и IoT

Довольно часто звучит вопрос — «Чем же отличается edge computing от IoT». IoT можно назвать дедушкой edge computing. IoT — это множество устройств, связанных между собой, и способных передавать информацию друг другу. А edge computing это скорее подход к организации вычислений и управлению edge устройствами. Как вы отлично понимаете, любое приложение необходимо обновлять, мониторить и осуществлять прочие обслуживающие функции. В результате edge computing подразумевает использование определенных подходов и фреймворков, о которых я расскажу чуть позже.

edge computing vs fog computing

Когда я однажды рассказал коллеге про edge computing, он ответил — ”так это же fog computing”. Давайте попробуем разобраться, в чём же разница. С одной стороны, edge computing и fog computing часто используются как синонимы, однако fog computing, или «туманные вычисления», все-таки немного отличаются.

И edge computing, и fog computing — это вычисления, которые находятся в непосредственной близости к получаемым данным. Различие заключается в том, что при туманных вычислениях обработка осуществляется на устройствах, которые постоянно подключены к сети. В edge computing вычисления осуществляются как на сенсорах, умных устройствах – без передачи на уровень gateway, так и на уровне gateway и на микрокластерах.

Для меня было открытием, что edge computing может работать в кластерах Kubernetes или OpenShift. Оказывается, что существует достаточно много задач, где кроме оконечных устройств необходимо выполнять обработку информации в локальном кластере и передавать в централизованные дата центры только результирующие данные. И такие вычисления — тоже edge computing.

Преимущества и недостатки edge computing

При выборе технологий для своего проекта я в первую очередь основываюсь на двух критериях — «Что я от этого получу?» и «Какие проблемы я от этого получу?».

Начнём с преимуществ:

Хотя, конечно, проектируя систему с edge computing, не стоит забывать, что как и любую другую технологию её стоит использовать в зависимости от требований к системе, которую вам необходимо реализовать.

Среди недостатков edge computing можно выделить следующие:

С одной стороны, последний пункт является наиболее критичным, но, к счастью, консорциум Linux Foundation Edge (LF EDGE) включает в себя всё больше и больше проектов с открытым исходным кодом, а их зрелость стремительно растет.

Принципы компании IBM при создании платформы edge computing

Компания IBM, являясь одним из лидеров в области гибридных облаков, использует определённые принципы при разработке решений для edge computing:

IBM применяет эти принципы при декомпозиции задачи построения фреймворка edge computing.

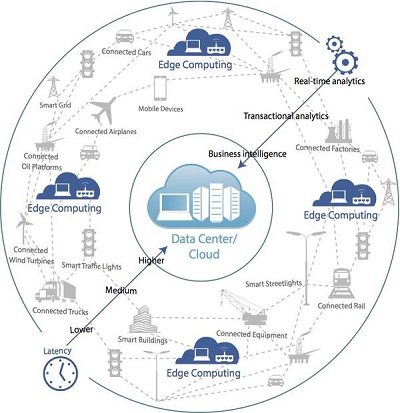

Как вы можете видеть, всё решение разбито на 4 сегмента использования:

Помимо основных принципов и подходов, IBM разработала референсную архитектуру для решений, основанных на edge computing. Референсная архитектура — это шаблон, показывающий основные элементы системы и детализированный настолько, чтобы иметь возможность адаптировать его под конкретное решение для заказчика. Давайте рассмотрим такую архитектуру более подробно.

Референсная архитектура edge computing

Edge devices

В первую очередь, у нас есть какое-либо встроенное или дискретное edge-устройство, к которому подключены сенсоры, датчики или управляющие механизмы, например, для координации движения роборуки. Из сервисов/данных на таком устройстве могут находиться:

Hybrid multicloud

Если мы говорим об использовании ML-модели, которая будет запускаться на десятках или тысячах устройств, то нам необходимо облако, которое сможет отвечать за обучение такой модели, обработку статистики, отображение сводной информации (правая часть архитектуры).

Edge server and Edge micro data center

Как мы уже говорили, можно встретить промежуточные (близкие) кластеры обработки данных на уровне шлюзов или микро-датацентров с установленной поддержкой кластерных технологий.

Edge framework

Когда мы осознаем, что есть необходимость в управлении большим количеством сервисов на тысячах устройств и сотнями приложений в разных кластерах, наступает понимание, что надо бы использовать какой-то фреймворк для управления всем этим зоопарком и синхронизации между устройствами.

Именно наличие данного фреймворка раскрывает преимущества edge computing перед разнородными разнесёнными вычислениями.

Как мы видим, кроме центральной части по управлению сервисами и моделями в данном фреймворке присутствуют агенты, обеспечивающие контроль за управлением жизненным циклом сервисов на устройствах/кластерах на каждом из уровней использования.

Open Horizon и IBM Edge Application Manager

Именно для решения задач в области edge computing IBM разработала и выложила в open-source проект Open Horizon. Если вы помните, один из принципов, которые IBM заложила в edge computing – все компоненты должны быть основаны на open source технологиях. В мае 2020 года проект Open Horizon вошел в Linux Foundation Edge — Международный фонд open-source технологий для созданий edge-решений. Также Open Horizon является ядром нового продукта от RedHat и IBM — IBM Edge Application Manager, решения для управления приложениями на всех устройствах edge computing: от Raspberry Pi до промежуточных кластеров обработки данных.

Несмотря на то, что проект Open Horizon вошел в консорциум только в мае, он уже достаточно давно развивается как open-source проект. И мы в Научно-техническом центре IBM не только успели его попробовать, но и довести свое решение до промышленного использования. О том, как мы разрабатывали проект с использованием edge computing, и что у нас получилось — будет отдельная статья, которая выйдет в ближайшие несколько недель.

Сценарии использования

С одной стороны, edge computing framework — это специализированное решение для определённого круга задач, но оно нашло применение во многих индустриях.

В своё время, когда я изучал работу московских камер “Стрелка”, я понял, что это в чистом виде edge computing, с вычислениями «прямо на столбе» и промежуточной обработкой данных в раздельных вычислительных кластерах у различных ведомств.

Сценарии нашлись в финансовом секторе, в продажах при самообслуживании, в медицине и секторе страхования, торговле и конечно при производстве. Именно в создании решения для автоматизации и оценки качества произведённого оборудования, основанного на edge computing, мне с коллегами из Научно-технического центра IBM и посчастливилось принять участие. И на своем опыте попробовать, как создаются решения edge computing.

Если Вас заинтересовала данная тематика, следите за обновлениями в хабраблоге компании IBM и смотрите видео в разделе Ссылки. Наши зарубежные коллеги к настоящему моменту уже осветили многие технические вопросы и описали, какие сценарии уже работают и применяются в различных отраслях.

Где и как применяются граничные серверы

При разработке сетевой инфраструктуры обычно рассматривают либо локальные вычисления, либо облачные. Но этих двух вариантов и их комбинаций мало. Например, что делать, если от облачных вычислений отказаться нельзя, а пропускной способности не хватает или трафик стоит слишком дорого?

Добавить промежуточное звено, которое выполнит часть вычислений на границе локальной сети или производственного процесса. Эта периферийная концепция называется Edge Computing — «граничные вычисления». Концепция дополняет текущую облачную модель использования данных, и в этой статье мы рассмотрим необходимое оборудование и примеры задач для него.

Уровни edge computing

Допустим, у вас дома установлена целая куча датчиков: термометр, гигрометр, датчик освещения, протечек и прочее. Логический контроллер обрабатывает поступающую от них информацию, реализует сценарии автоматизации, выдает облачному сервису обработанную телеметрию и получает от него обновленные сценарии автоматизации и свежие прошивки. Таким образом, непосредственно на объекте выполняются локальные вычисления, но оборудование контролируется из узла, объединяющего множество таких устройств.

Это пример очень простой системы граничных вычислений, но на нем уже видны все три уровня edge computing:

Особенности граничных серверов

На уровне периферийных узлов в Edge Computing используют граничные серверы, которые ставят непосредственно там, где производится информация. Обычно это производственные или технические помещения, в которых нельзя установить серверную стойку и обеспечить чистоту. Таким образом, граничные серверы выполняются в компактных пыле- и влагозащищенных корпусах с расширенным температурным диапазоном, их нельзя поставить в стойку. Да, такой сервер спокойно может висеть на двухстороннем скотче анкерах где-нибудь под лестницей или в подсобке.

Так как граничные серверы ставятся вне защищенных ЦОД, у них выше требования к физической безопасности. Для них предусматривают защитные контейнеры:

На уровне работы с данными в граничных серверах предусмотрено шифрование дисков и защищенная загрузка. Само шифрование отнимает 2-3% вычислительной мощности, но в граничных серверах обычно используют процессоры Xeon D со встроенным модулем ускорения AES, который минимизирует потери мощности.

Когда применяются граничные серверы

При Edge Computing в дата-центр поступают на обработку лишь те данные, которые невозможно или нерационально обрабатывать по-другому. Таким образом, граничные серверы применяют, когда требуется:

Edge computing для экономии трафика

Датская компания Maersk — один из лидеров морских грузовых перевозок в мире — решила сократить потребление топлива у своих судов и снизить выбросы загрязняющих веществ в атмосферу.

Для решения этой проблемы использовалась технология Siemens EcoMain Suite, датчики на двигателях и основных узлах корабля, а также локальный сервер BullSequana Edge для вычислений «на месте».

Благодаря датчикам система EcoMain Suite постоянно мониторит состояние критических узлов корабля и их отклонение от заранее вычисленной нормы. Это позволяет быстро диагностировать неисправность и локализовать ее вплоть до проблемного узла. Так как телеметрия постоянно передается «в центр», сервисный техник может выполнить анализ удаленно и дать рекомендации бортовой команде. И главный вопрос тут — сколько данных и в каком объеме передавать на центральный ЦОД.

Так как подключить дешевый проводной интернет к морскому контейнеровозу весьма проблематично, передача большого объема сырых данных на центральный сервер получается слишком дорогой. На центральном сервере BullSequana S200 просчитывается общая логическая модель корабля, а обработка данных и непосредственное управление передается локальному серверу. Как результат, внедрение этой системы окупилось за три месяца.

Edge computing для экономии ресурсов

Еще один пример граничных вычислений — это видеоаналитика. Так, у производителя оборудования для технических газов Air Liquide одной из локальных задач производственного цикла является контроль качества окраски газовых баллонов. Он осуществлялся вручную и составлял около 7 минут на один баллон.

Чтобы ускорить этот процесс, человека заменили блоком из 7 видеокамер высокого разрешения. Камеры снимают баллон с нескольких сторон, генерируя около 1 ГБ видео в минуту. Видео отправляется на граничный сервер BullSequana Edge c Nvidia T4 на борту, на котором нейронная сеть, натренированная на поиск дефектов, анализирует стрим в онлайн-режиме. В результате среднее время на осмотр сократилось с нескольких минут до нескольких секунд.

Edge computing в аналитике

Аттракционы в Диснейленде — это не только веселье, но и сложный технический объект. Так, на «Американской горке» установлено порядка 800 различных датчиков. Они постоянно отправляют на сервер данные о работе аттракциона, а локальный сервер обрабатывает эти данные, вычисляет вероятность выхода аттракциона из строя и сигнализирует об этом на центральный ЦОД.

На основе этих данных определяется вероятность технического отказа и запускается превентивный ремонт. Аттракцион продолжает работать до конца рабочего дня, а тем временем уже оформлен наряд на ремонт, и рабочие оперативно чинят аттракцион ночью.

BullSequana Edge

Серверы BullSequana Edge являются частью большой инфраструктуры для работы с «большими данными», они уже протестированы с платформами Microsoft Azure и Siemens MindSphere, VMware WSX и имеют сертификаты NVidia NGC/EGX. Эти серверы разработаны специально для граничных вычислений и выпускаются в корпусах форм-фактора U2 в вариантах для установки в стандартную стойку, на DIN-рейку, на стену и в напольном исполнении.

BullSequana Edge построены на материнской плате собственной разработки и процессоре Intel Xeon D-2187NT. Они поддерживают установку до 512 Гб оперативной памяти, 2 SSD по 960 Гб либо 2 HDD по 8 или 14ТБ. Также в них можно установить 2 GPU Nvidia T4 16 ГБ для работы с видео; Wi-fi, LoRaWAN и 4G модули; до 2-х 10-гигабитных модулей SFP. В самих серверах уже установлен датчик открытия крышки, который подключен к BMC, управляющему модулем IPMI. Его можно настроить на автоматическое отключение питания при срабатывании датчика.

Полностью технические характеристики серверов BullSequana Edge можно найти по ссылке. Если вам интересны подробности, мы будем рады ответить на наши вопросы в комментариях.

ИТ База знаний

Полезно

— Онлайн генератор устойчивых паролей

— Онлайн калькулятор подсетей

— Руководство администратора FreePBX на русском языке

— Руководство администратора Cisco UCM/CME на русском языке

— Руководство администратора по Linux/Unix

Навигация

Серверные решения

Телефония

FreePBX и Asterisk

Настройка программных телефонов

Корпоративные сети

Протоколы и стандарты

Edge Computing – что это и какой профит?

Или как человечество оказалось «на грани»

Полный курс по Сетевым Технологиям

В курсе тебя ждет концентрат ТОП 15 навыков, которые обязан знать ведущий инженер или senior Network Operation Engineer

Что такое граница сети?

Для устройств, подключенных к сети Интернет, границей будет точка, где это устройства непосредственно подключается к Интернету. Конечно, определение экстремально размытое; к примеру, компьютер пользователя или процессор внутри IoT камеры могут быть теми самыми точками, однако, сетевой маршрутизатор также вполне попадает под это определение. Но важно одно: граница будет гораздо ближе к устройству (с географической точки зрения), нежели к облачным серверам.

Приведем пример edge computing-а

А теперь представьте себе, что сервер, определяющий движение был помещен на границу сети (той самой, в которой находится наше воображаемое здание). Что если каждая камера будет использовать свои собственные вычислительные мощности для запуска там приложения, которое будет определять движение? Очевидно, тогда в облако будет уходить только «полезный» трафик. Кроме того, на облачные сервера ляжет только задача по хранению важной информации, что де-факто означает возможность этого облака поддерживать связь с гораздо большим количеством камер без перегрузки. Вот примерно так и выглядит пример edge computing.

Преимущества концепции edge computing

Как видно в примере выше, данный концепт позволяет минимизировать загрузку Интернет-канала и нагрузку на вычислительные мощности облака. Полоса пропускания и вычислительные мощности, к сожалению, конечны и стоят реальных денег. С каждым зданием и офисом, которые будут оборудованы «умными» камерами, принтерами, термостатами и даже тостерами, аналитики предсказывают, что к 2025 году в мире будет установлено 75 миллиардов IoT устройств. Чтобы все эти устройства корректно работали, большой процент вычислений должен быть перенесен на edge-и.

Также, когда пользователи используют тонны веб-приложений, которые постоянно подключаются к внешним серверам, они могут чувствовать эти самые задержки. Длительность задержек будет зависеть от того, какова их полоса пропускания и где находятся сервера, но этих задержек можно легко избежать. Правильно, если воткнуть все эти сервера на границу этой сети.

Если подытожить, то общие плюсы этого концепта таковы:

Минусы данного подхода

Полный курс по Сетевым Технологиям

В курсе тебя ждет концентрат ТОП 15 навыков, которые обязан знать ведущий инженер или senior Network Operation Engineer

Что такое периферийные вычисления?

Перемещайте быстрее, храните больше, обрабатывайте любые данные — и все это на периферии.

Основные выводы для периферийных вычислений

Перемещая мощные периферийные вычисления ближе к точке генерирования данных, компании и поставщики услуг могут определять новые возможности для получения доходов, предлагать инновационные услуги и экономить время и средства на эксплуатацию.

Периферийные вычисления снижают уровень задержек при обработке данных, повышают скорость реагирования и обеспечивают более эффективное управление сетевым трафиком, а также соблюдение требований безопасности и конфиденциальности.

Периферийные вычисления — это одна из составляющих частей распределенной вычислительной архитектуры, которая требует учета инфраструктуры — от периферийных устройств, локальных устройств, до сети и облака — при проектировании совместимых решений от периферии до облака.

Экспоненциальный рост данных, собираемых миллиардами устройств Интернета вещей и мобильными устройствами, приводит к переходу от отправки данных в облако для обработки и хранения к использованию распределенной модели, при которой некоторые вычисления проводятся на периферии сети, ближе к месту генерирования данных. Технологии Intel® могут помочь ускорить развертывание решений для периферийных вычислений для использования в самых различных областях на многих рынках.

Экспоненциальный рост данных, собираемых миллиардами устройств Интернета вещей и мобильными устройствами, приводит к переходу от отправки данных в облако для обработки и хранения к использованию распределенной модели, при которой некоторые вычисления проводятся на периферии сети, ближе к месту генерирования данных. Технологии Intel® могут помочь ускорить развертывание решений для периферийных вычислений для использования в самых различных областях на многих рынках.

Что такое периферийные вычисления?

Периферийные вычисления относятся к обработке, анализу и хранению данных ближе к точке их генерирования для быстрого анализа и отклика, которые происходят практически в режиме реального времени. В последние годы некоторые компании консолидируют операции путем централизованного хранения и обработки данных в облаке. Однако необходимость в новых вариантах использования, которые возникают на базе миллиардов распределенных устройств — от передовых складских решений до роботизированных производственных линий на базе машинного зрения и расширенных систем контроля трафика для умных городов, делают эту модель нерациональной.

Кроме того, более широкое использование периферийных устройств, от Интернета вещей, например умных камер, мобильных киосков продаж, медицинских датчиков и промышленных ПК, до шлюзов и вычислительной инфраструктуры, для более быстрой аналитики, которая происходит практически в режиме реального времени и в источнике данных, приводит к росту объемов генерируемых и собираемых данных в геометрической прогрессии.

Движущие факторы развития периферийных вычислений

Возможности облачных вычислений приближаются к своему пределу в том, что касается хранения, обработки данных и быстродействия системы при работе с соответствующими сервисами и приложениями. Во многих случаях уже не достаточно увеличить пропускную способность или вычислительную мощность, чтобы обеспечить более быструю обработку данных, полученных от подключенных устройств, а также немедленный анализ и ответные действия в режиме реального времени. Необходимость устранить эти пробелы способствует внедрению и использованию периферийных вычислений.

Основные факторы, требующие решения в облаке:

Преимущества периферийных вычислений

Перемещение некоторых процессов, связанных с данными, таких как хранение, обработка и анализ, из облака на периферию, ближе к точке возникновения данных, может обеспечить несколько основных преимуществ.

От периферии до облака

Хотя периферийные вычисления предоставляют организациям беспрецедентную возможность раскрыть ценность данных, облачные системы продолжают играть важную роль в качестве центрального хранилища данных и центра обработки. На изображении ниже видно, как периферийные устройства для сбора данных, вычислений, хранения и сетевых технологий объединяются для возможности использования организациями данных на каждом этапе.

Edge computing заменит Cloud computing?

Мы с коллегами не так давно обсуждали динамичность развития технологий и перспективы развития облачных вычислений. И как раз наткнулась на статью.

Каждая новая технология приходит на смену старой. Иногда, как и в случае с облаком, проводится ребрендинг старых технологий, чтобы сделать их более привлекательными для потребителей и, тем самым, создать иллюзию нового продукта. Облачные вычисления ранее существовали в той или иной форме. На одном из этапов они назывались «on demand computing» (компьютерные ресурсы по требованию), а затем преобразовались в «application service provider» (ASP).

Теперь существует edge computing (прим. устоявшегося русского термина еще нет, но можно перевести, как «концепция граничных вычислений» или «периферийные вычисления»). которому отраслевые обозреватели и эксперты пророчат способность заменить облако. Но вот вопрос: произойдет ли это на самом деле? Ведь тоже самое говорили о радио, когда было изобретено телевидение. Тем не менее, миллионы людей каждый день включают радиоприемники, но оно изменило формат, теперь его слушают в основном в машине.

Конечно, есть некоторые технологии, которые действительно осуществляют переворот в том, что меняют привычки людей и их образ мышления. Когда-то люди слушали музыку с Sony Walkmans, а сегодня мы повсеместно используем для этого смартфон.

Пророчество Левина

Так почему же люди думают, что edge computing победит облако? Это утверждение было заявлено во многих статьях. Например, Клинт Бултон в марте этого года пишет об этом в статье «edge computing заменит облако». Он ссылается на венчурного капиталиста Эндрю Левина, генерального партнера Andreessen Horowitz, который считает, что больше вычислительных ресурсов будут двигаться в направлении оконечных устройств — таких, как беспилотный автомобиль и дроны, — которые составляют, по меньшей мере, часть Интернета вещей. Левин прогнозирует, что это будет означать то, что облаку пришел конец, т.к. процесс обработки данных будет двигаться назад по направлению к edge computing.

Другими словами, сейчас идет тенденция централизации вычислений в ЦОДах, в то время, как в прошлом они часто были децентрализованы или находились ближе к месту использования. Левин видит беспилотный автомобиль, как центр обработки данных: они имеют более чем 200 процессоров, способных обеспечить полную отказоустойчивость, чтобы не привести к несчастному случаю на дороге. Характер автономных транспортных средств означает, что их вычислительные мощности должны быть независимыми и для того, чтобы обеспечить безопасность нужно свести к минимуму любую связь, которую они имеют с облаком. Тем не менее, они не смогут полностью обойтись без него.

Взаимодополняющие модели

Эти два подхода могут дополнять друг друга. Часть аргументов за edge computing просто отпадает, когда речь заходит об увеличении объемов данных, которые приводят к еще более удручающей и медленной сети. Задержка – виновник. Данных становится все больше: увеличивается количество данных на одну транзакцию, «тяжелые» видео и много данных разных датчиков. Виртуальная и дополненная реальность будет играть все большую роль в его росте. При таком росте объема данных, решить проблемы задержки представляется более сложной задачей, чем это было раньше. Сейчас имеет смысл размещать данные ближе к устройствам типа беспилотного автомобиля для того, чтобы устранить задержку, но тем не менее большая часть данных всё-еще находится удаленно в облаке. Облако по-прежнему будет использоваться в качестве поставщика сервисов, таких как СМИ и развлечения. Оно также может быть использовано для резервного копирования данных и для обмена данными, исходящих от транспортного средства.

Немного отойдем от автономных транспортных средств и вернемся к более привычному бизнесу. Создание ряда небольших ЦОДов или площадок аварийного восстановления может уменьшить эффект масштаба, как следствие, увеличить затраты и сделать работу менее эффективной. Да, задержка может быть уменьшена, но в случае катастрофы последствия будут не менее плачевными; поэтому для обеспечения непрерывности бизнеса некоторые данные следует хранить и обрабатывать в другом месте – в облаке. В случае беспилотных машин, в частности, потому что они должны работать независимо от того, есть сетевое соединение или его нет, имеет смысл, чтобы определенные типы вычислений и анализа были совершены самим транспортным средством. Однако эти данные по-прежнему будут бэкапиться в облако, когда соединение доступно. Подход будет гибридным: edge и cloud computing будут взаимодополнять друг друга, а не использоваться по одиночке.

От периферии до облака

Сейджу Скария, старший директор консалтинговой фирмы TCS, предлагает несколько примеров, где edge computing может оказаться полезным. В своей статье на LinkedIn Pulse, «Edge computing vs. Облачные вычисления: за кем будущее?». Он не считает, что с облаком будет покончено.

«Edge computing не заменит облачные вычисления… на самом деле, аналитическая модель или правила могут быть созданы в облаке и затем применяться оконечными устройствами… и некоторые [из них] способны делать анализ». Затем он продолжает говорить о fog computing (туманные вычисления), которая включает в себя обработку данных от периферии до облака. Он считает, что люди не должны забывать о хранилищах данных, так как они используется для «медленных аналитических запросов и массивного хранения данных».

Edge победит облако

Несмотря на этот аргумент, аналитик компании Gartner Томас Битман считает, что «Edge computing «съест» облако». «Сегодня облачные вычисления пожирают центры обработки данных предприятий, все больше и больше нагрузок приходится на облако, а некоторые преобразовываются и перемещаются в облако… но есть еще одна тенденция, которая переместит рабочие нагрузки, данные и стоимость бизнеса далеко от облака… И тенденция перехода к edge computing еще более важная и сильная, чем когда-то была тенденция облачных вычислений.

Позже в своем блоге Битман пишет: «Не хватает одной только быстроты облачных решений. Массивная централизация, экономия от масштаба, самообслуживание и полная автоматизации преодолевает только полпути — но все это не преодолеет физику — вес данных, скорость света. Как люди должны взаимодействовать с цифровой реальностью в режиме реального времени, если происходит задержка от центра обработки данных, расположенного за тысячи километров. Задержка имеет большое значение. Я существую здесь и прямо сейчас. Воспроизвести правильную рекламу, прежде чем я не отвернулся, указать на магазин, который я ищу, когда я за рулём, помочь моему беспилотному автомобилю выбрать верный путь через оживленный перекресток. И все это мне нужно получить СЕЙЧАС».

Ускорение данных

Битман делает некоторые справедливые замечания, но он употребляет аргумент, который часто используется в отношении задержек и ЦОДов: они должны быть расположены близко друг к другу. Истина заключается в том, что глобальные сети всегда будут фундаментом edge computing и облачных вычислений. Во-вторых, Битману явно не попадались инструменты ускорения данных, такие, как PORTrockIT и WANrockIT. В то время как физика, безусловно, является ограничивающим и сложным фактором, который всегда будет иметь место в сетях всех видов – включая WANs, сегодня можно разместить свои центры обработки данных на расстоянии друг от друга. Задержка может быть уменьшена, и его воздействие может быть нивелировано, независимо от того, где происходит обработка данных, и независимо от того, где хранятся данные.

Поэтому, edge computing это не новое прорывное решение. Это лишь одно из решений, как и облако. Вместе эти две технологии могут поддержать друг друга. Различие между edge computing и облачными вычислениями, в том, что «edge являются методом ускорения и повышения производительности облачных вычислений для мобильных пользователей». Таким образом, аргумент, что edge computing заменит облачные вычисления является очень неубедительным. По маркетинговым соображениям, облачные вычисления могут быть переименованы, но суть останется та же.