Expose hardware assisted virtualization to the guest os что это

Блокнот ночного сисадмина

вторник, 17 сентября 2013 г.

Создание стенда в виртуальной среде VMware vSphere 5.1 и выше, установка ESXi на ESXi (nested)

Иногда появляется необходимость отработать настройки виртуальной среды VMware перед внедрением в эксплуатацию. Для таких целей может понадобится стенд из нескольких серверов ESXi и машины для SSO, vCenter Server и другой обвязки. Но что делать, если мы не имеем дополнительного железа в нужном количестве? Можно использовать уже готовую виртуальную среду, освободив или разгрузив один из ESXi серверов.

Порядок действий по созданию стенда следующий:

1. Выделяем сервер с установленным ESXi.

2. Создаем виртуальный коммутатор(vSwitch) для нашей среды и переводим его в Promiscuous Mode (Accept), иначе гостевые гипервизоры не смогут корректно работать с сетью.

3. Заходим на консоль ESXi или подключаемся по SSH, выполняем следующую команду, которая допишит строку в конфигурационный файл config:

и перегружаем управляющий сервис для применения настроек:

4. Установленные гостевые гипервизоры клонировать нельзя, поэтому создадим шаблон чистой виртуальной машины, чтобы каждый раз не проходилось повторять следующие настройки:

— создаем виртуалку из шаблона Red Hat Enterprise Linux 5 (64-bit);

— выбираем минимум 2 процессора;

— минимум 2Гб оперативной памяти;

— все остальное можно оставить по-умолчанию;

— сразу после создания машину не включаем, заходим в свойства(Edit Settings. );

— переходим во вкладку Options;

— поле General Options, изменяем Guest Operation System на VMware ESXi 5.x (experimental);

— в поле CPU/MMU Virtualization установите переключатель в нижнее положение, согласно рисунку;

— повышаем версию «виртуального железа» до 9-ой минимум: в контекстном меню выбираем пункт Upgrade Virtual Hardware и подтверждаем операцию в диалоговом окне (виртуальная машина должна быть выключена);

— сохранив сделанные настройки, используем данную машину в качестве шаблона при последующей установке гипервизора с iso-образа или сети.

5. Для того чтобы заработал Fault Tolerance необходимо в настройках виртуальных гипервизоров установить параметр Migrate.VMotionStreamDisable в единицу. Делается это в Configuration->Software->Advenced Settings.

Кроме того, в конфигурации виртуалки (Edit Settings->Options->Advanced->General->Configurations Parameters), которую будем переводить в режим FT, делаем следующие изменения:

Как изменить параметры виртуальной машины?

В разделе Compute в пункте Virtual Machines выбираем необходимую и нажимаем Details.

Открывается окно с четырьмя основными вкладками: General, Hardware, Guest OS Customization, Advanced. Рассмотрим каждую из них подробнее. В инструкции будут описаны только те опции, которые вы сможете редактировать самостоятельно.

1. Параметры вкладки General:

2. Параметры вкладки Hardware:

3. Параметры вкладки Guest OS Customization рассмотрены в инструкции «Как кастомизировать виртуальную машину».

4. Параметры вкладки Advanced позволяют создать дополнительные параметры ВМ, например, для создания сценариев автоматизации. Также тут определяются параметры управления конкуренцией за ресурсы CPU и RAM, однако данный функционал недоступен для пользователей в нашей инфраструктуре.

Expose hardware assisted virtualization to the guest os что это

Topic Name : Change CPU/MMU Virtualization Settings in the vSphere Client

Publication Name : vSphere Administration with the vSphere Client

Product/Version : VMware vSphere/6.0

Hi there, Would you please be more specific on relation between CPU/MMU configuration and the Hardware virtualization: Expose Hardware assisted Virtualization to the guest OS button activation? Thanks!

Thnaks for your time.

In understood MMU hardware assisted will avoid the use of guest shadow tables, and roughly, the result is to reduce latency to access to page tables.

But what about the CPU? Why can we activate CPU hardware virtualization here (» CPU/MMU virtualization: Hardware CPU, software MMU «) and also on the other parameters (» Hardware virtualization: Expose hardware assisted virutalization to the guest os «)?

What are the differences between the two CPU features? Because when i red documentation for » CPU/MMU virtualization: Hardware CPU, software MMU » and » Hardware virtualization: Expose hardware assisted virutalization to the guest os » they are talking together about using VT-X.

So my understanding is the following:

— Do your VM are 64 bits are need to make nested virtualization? Check Expose hardware assisted virutalization to the guest os

— Do you have VT-X/AMD-V instructions? To optimize VMWare VMM mechanisms, select CPU Hardware.

— Do you have Intel EPT/AMD NPT instructions? To optimize VMWare VMM mechanisms, select MMU Hardware.

AM I correct & do you agree?

Thanks A LOT for your time

Windows Server 2019 — роль Hyper-V

На сервере Windows Server 2019 потребовалось запустить виртуальную машину посредством Hyper-V. Установим роль Hyper-V на сервер Windows Server 2019 и создадим какую-нибудь виртуальную машину.

Я буду все действия выполнять на свежем сервере Windows Server 2019 Standard Evaluation. Сервер развёрнут на гипервизоре VMware ESXi. Да-да, я понимаю, что на виртуалке поднимать систему виртуализации не самая здравая идея, но всё это в тестовых целях.

Установка роли Hyper-V на сервере Windows Server 2019

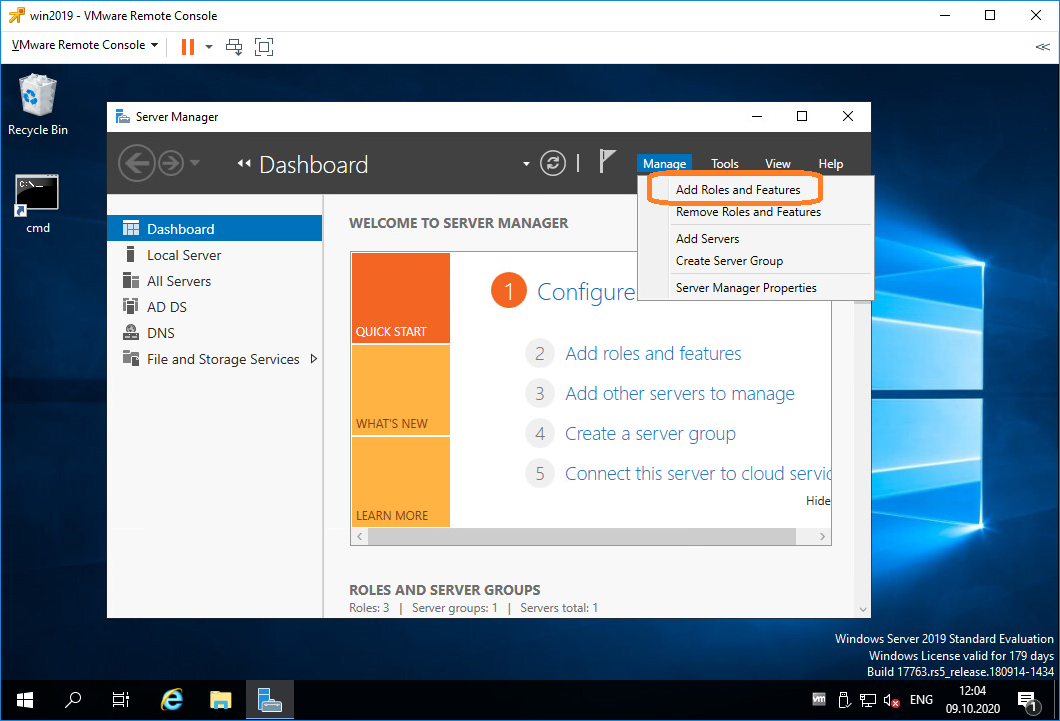

Открываем Server Manager. Manage > Add Roles and Features

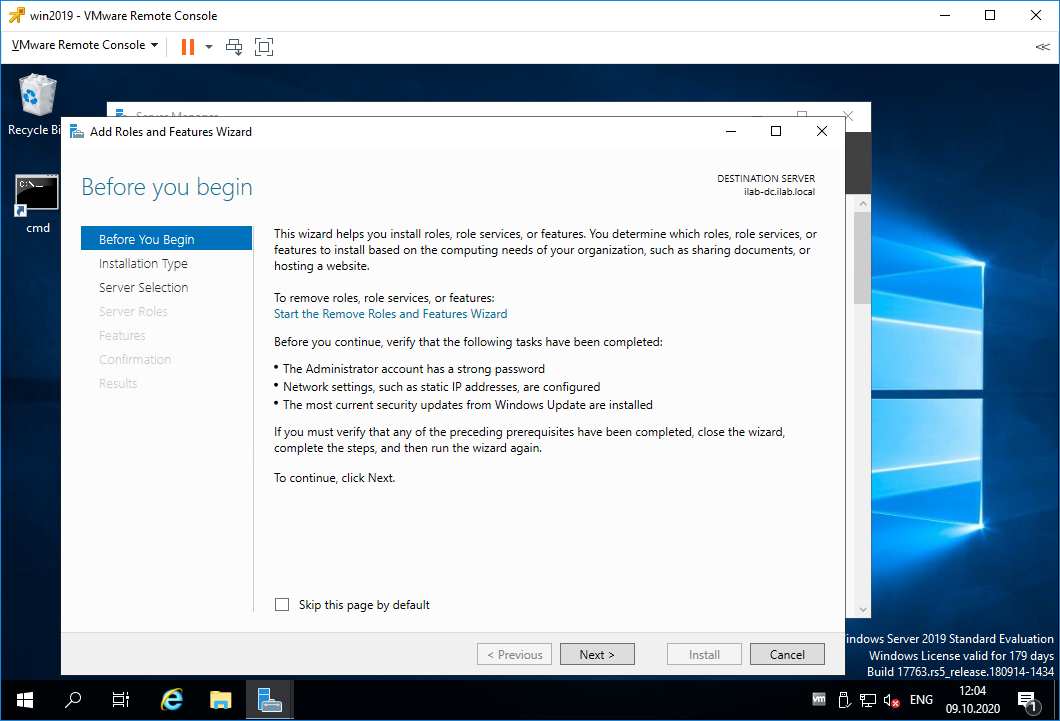

Открывается мастер установки ролей. Попадаем в раздел Before You Begin.

Это информационная страница, Next.

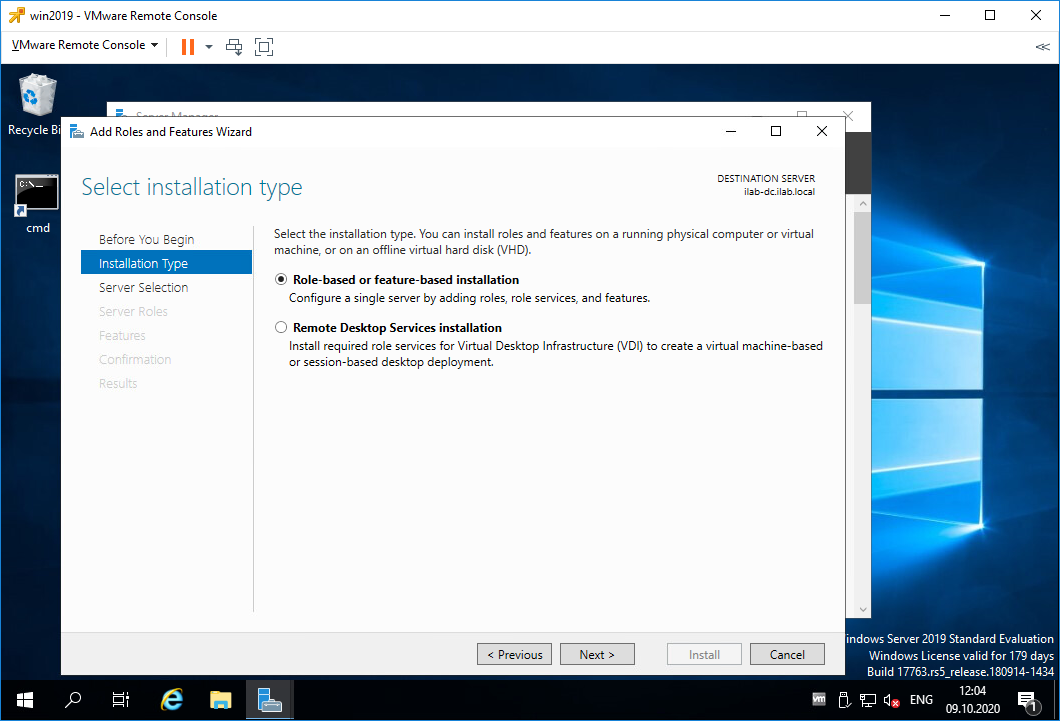

Попадаем в раздел Installation Type. Здесь нужно выбрать тип установку. Выбираем «Role-based or feature-based installation». Next.

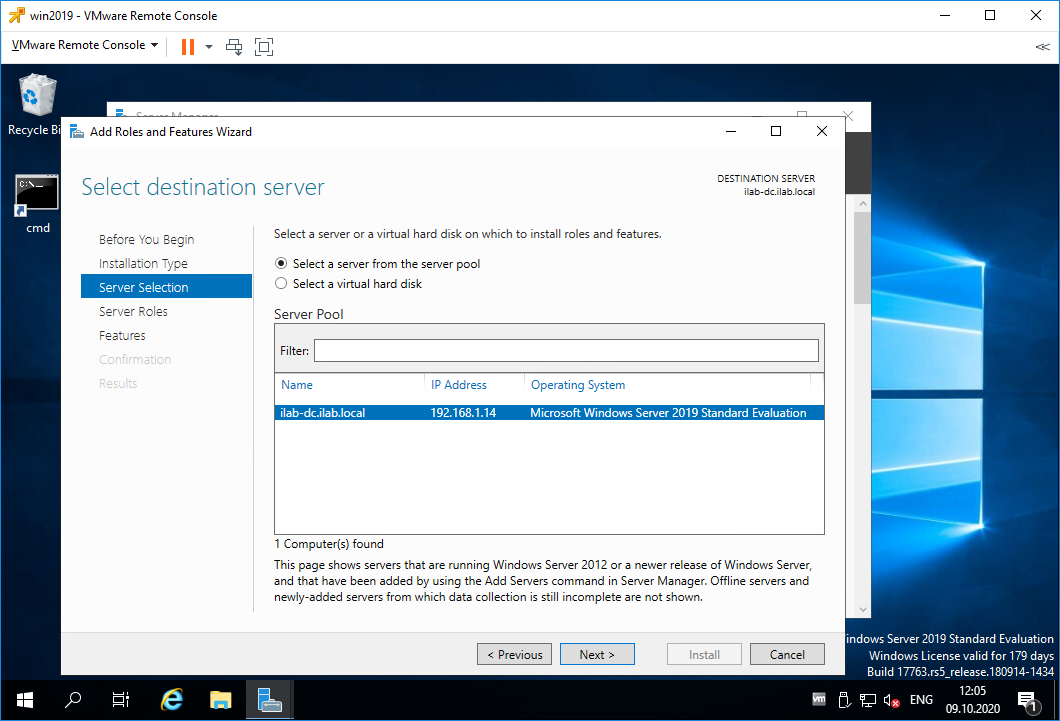

Попадаем в раздел Server Selection. Здесь нужно выбрать сервер, на который будем устанавливать роль. Я выбираю текущий сервер. Next.

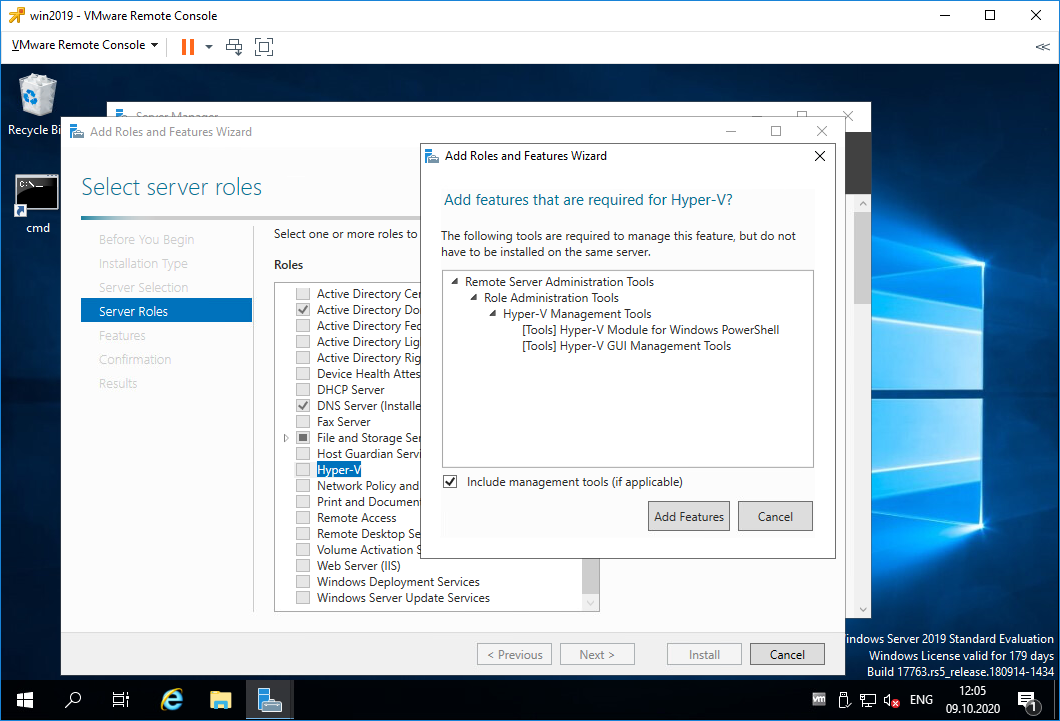

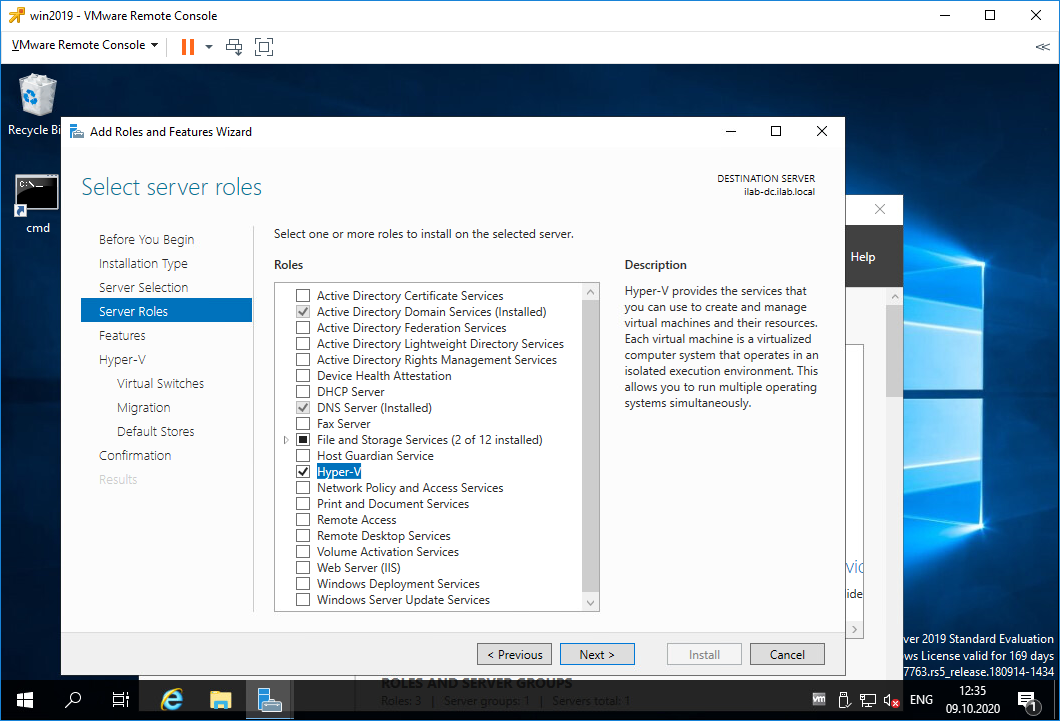

Попадаем в раздел Server Roles. Находим роль Hyper-V, выделяем галкой. Нам предлагают установить фичи, которые необходимы для работы Hyper-V, соглашаемся. Add Features.

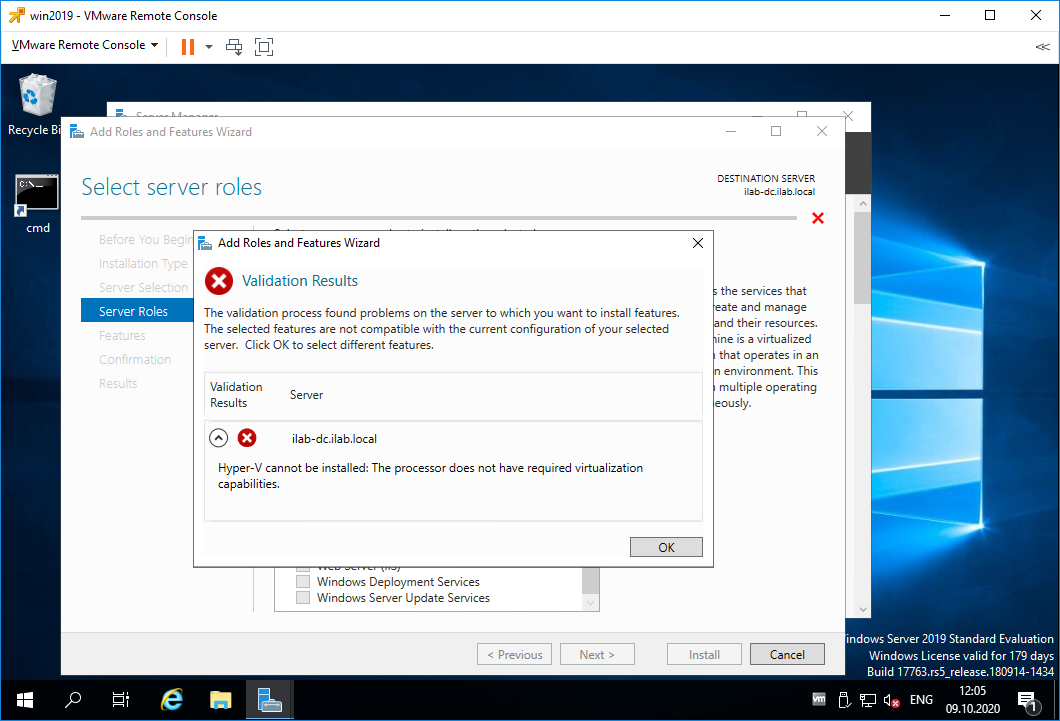

Облом. Я словил ошибку:

Hyper-V cannot be installed: The processor does not have required virtualization.

Для роли Hyper-V требуется процессор, поддерживающий функции виртуализации. Поддержка аппаратной виртуализации может быть отключена в BIOS, в этом случае нужно перезагрузить сервер и в BIOS включить поддержку виртуализации. Это могут быть опции:

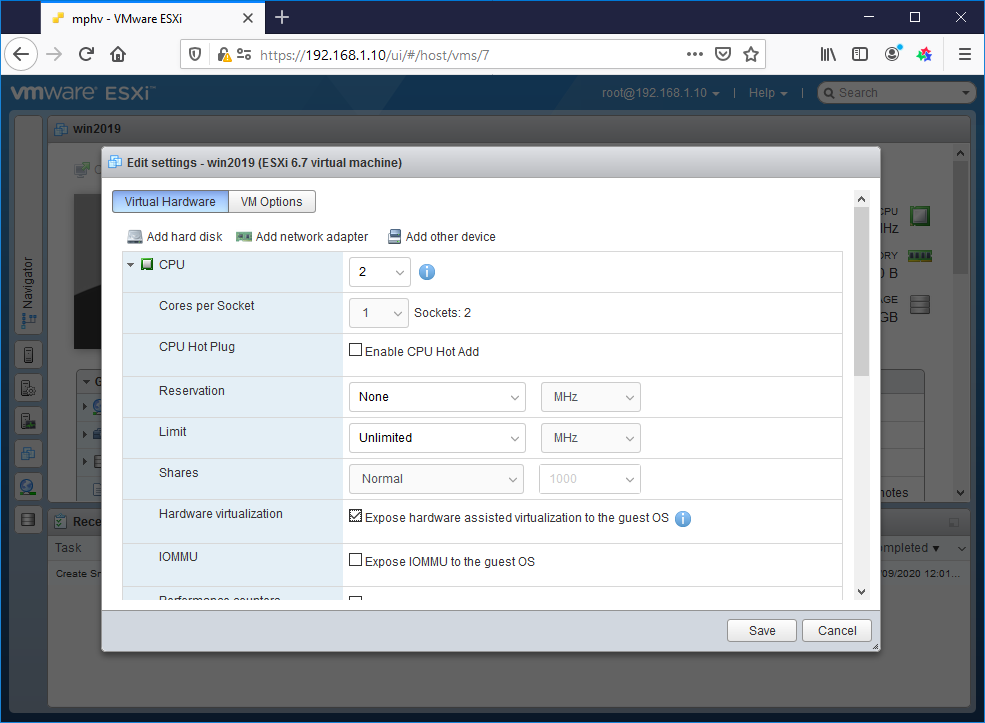

У меня сервер аппаратный на базе VMware, я выключаю его и перехожу к настройкам виртуальной машины.

В настройках CPU включаю галку «Expose hardware assisted virtualization to the guest OS».

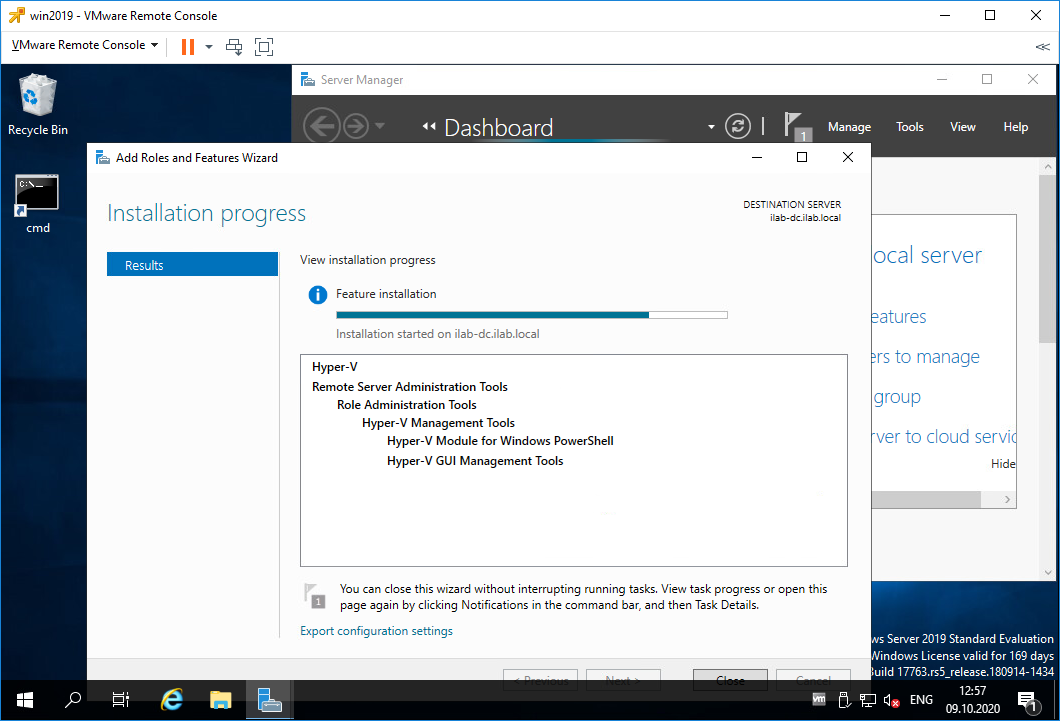

Включаю сервер. Снова проходим ту же процедуру. Открываем Server Manager. Manage > Add Roles and Features. Выбираем «Role-based or feature-based installation». Находим роль Hyper-V, выделяем галкой. Нам предлагают установить фичи, которые необходимы для работы Hyper-V, соглашаемся. Add Features.

В этот раз всё проходит успешно. Next.

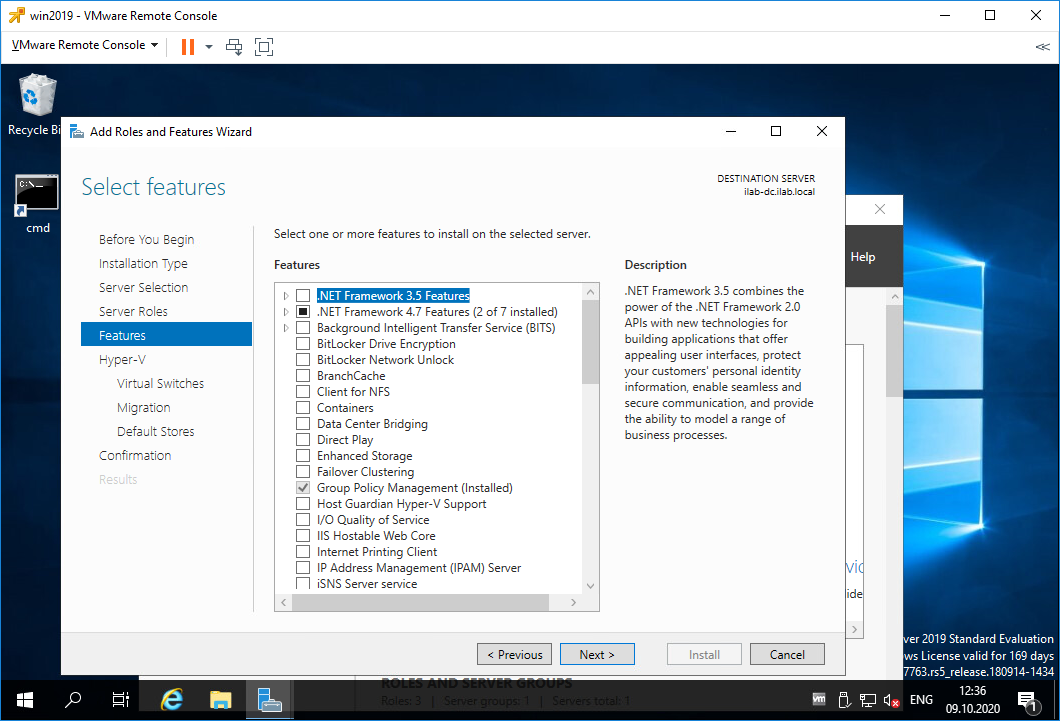

Попадаем в раздел Features, здесь нам ничего не нужно. Next.

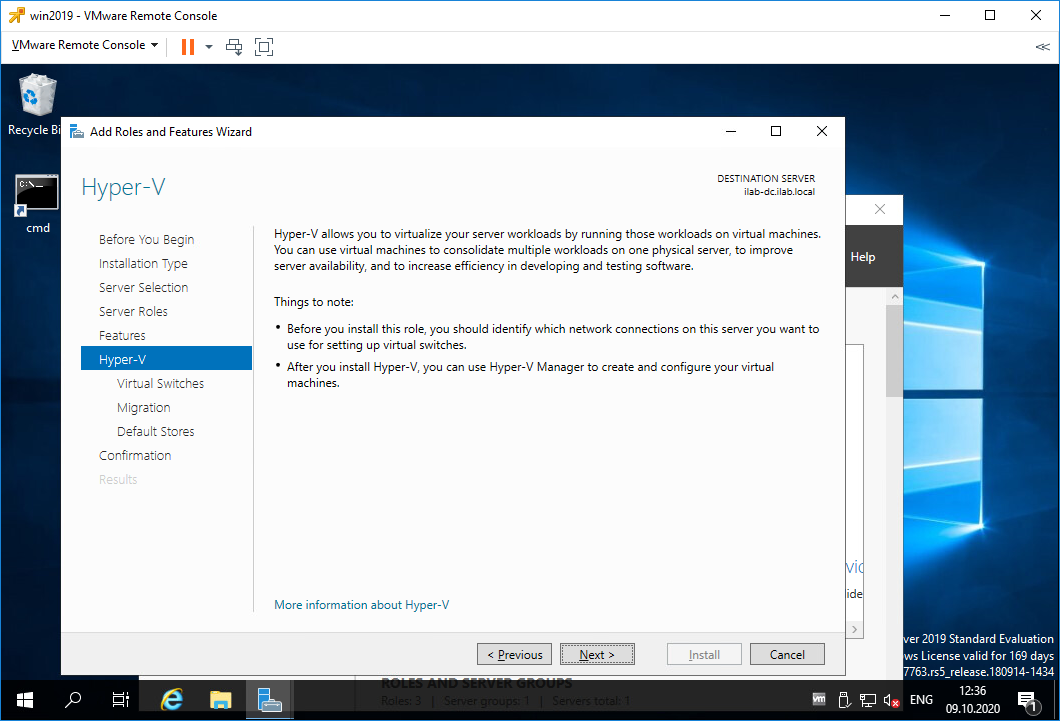

Попадаем в раздел Hyper-V. Здесь рассказывается для чего используется Hyper-V. Кроме того, на этой странице есть важная информация.

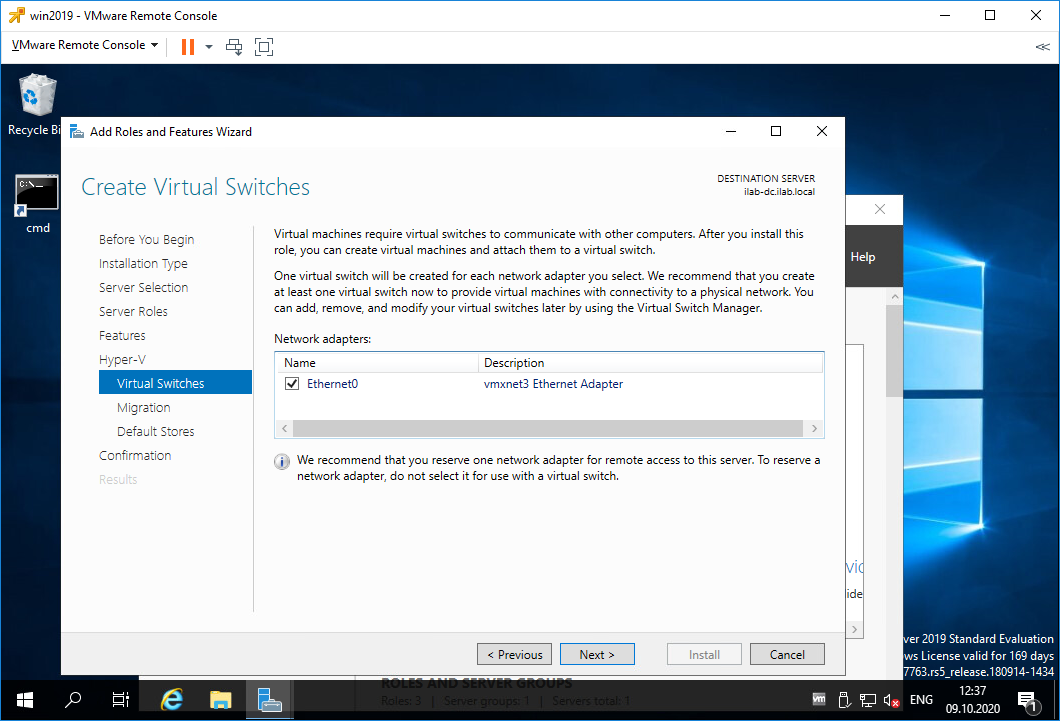

Попадаем в раздел Virtual Switches. Для работы виртуальных машин требуется связать виртуальный коммутатор в сетевой картой сервера, если вы хотите выпустить виртуальный машины в сеть. У меня выбор не очень большой, выделяю единственную сетевую карту. Next.

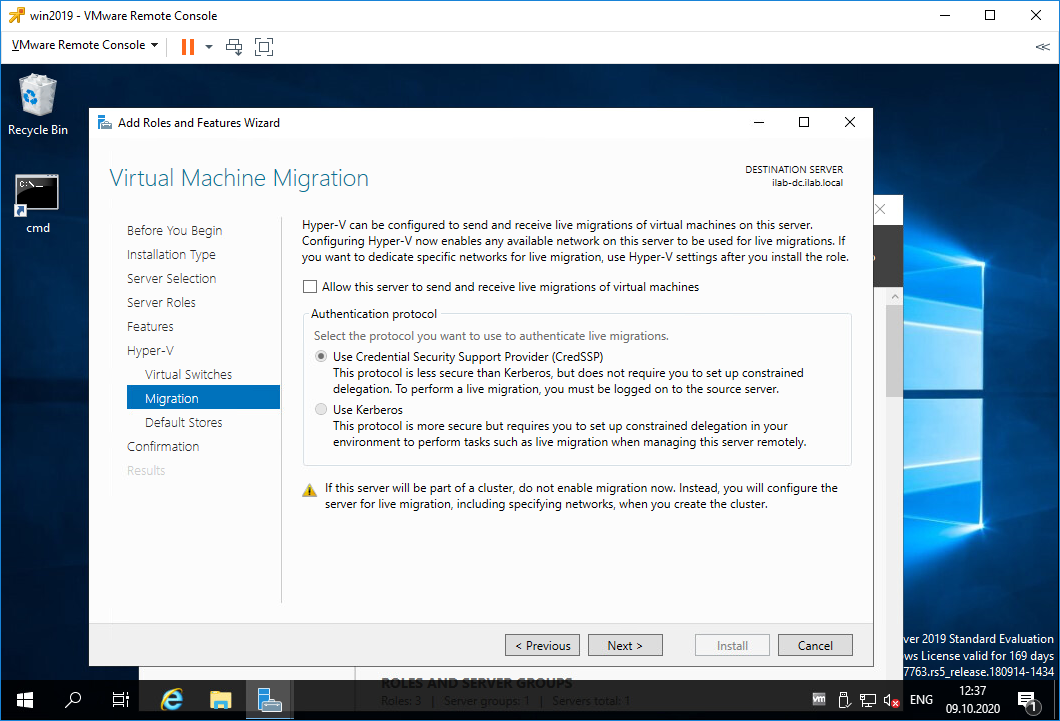

Попадаем в раздел Migration. Здесь настраивается миграция виртуальных машин. У меня будет один сервер с Hyper-V, поэтому никаких миграций не предусмотрено. Next.

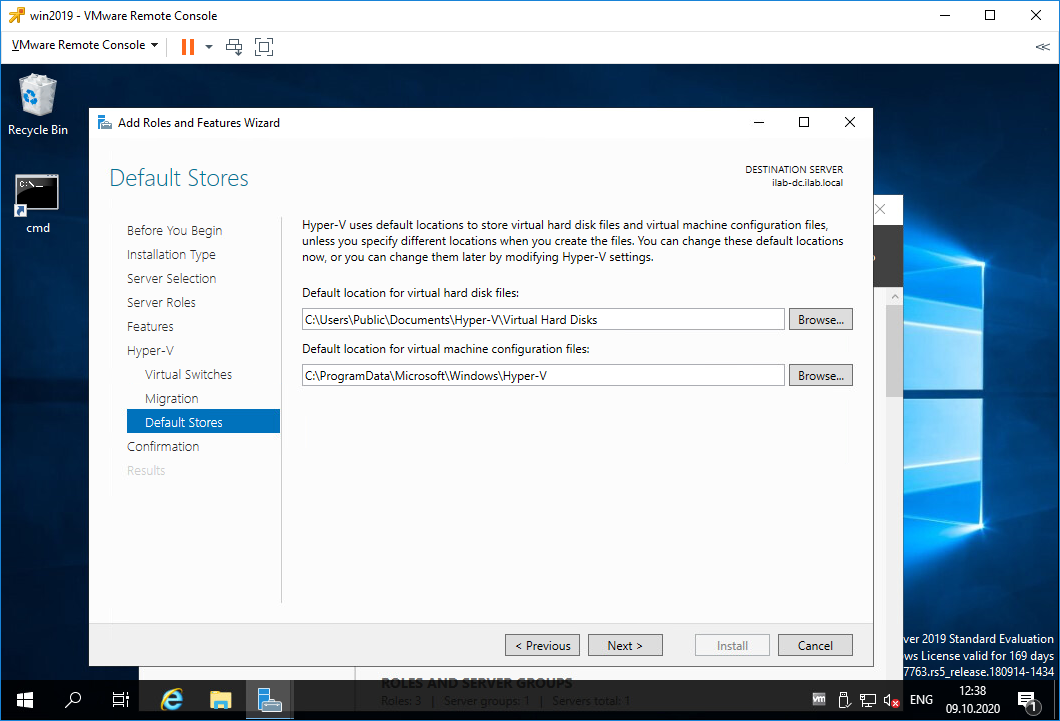

Попадаем в раздел Default Stores. Здесь можно настроить папки по умолчанию для хранения виртуальных дисков и файлов настроек виртуальных машин. Next.

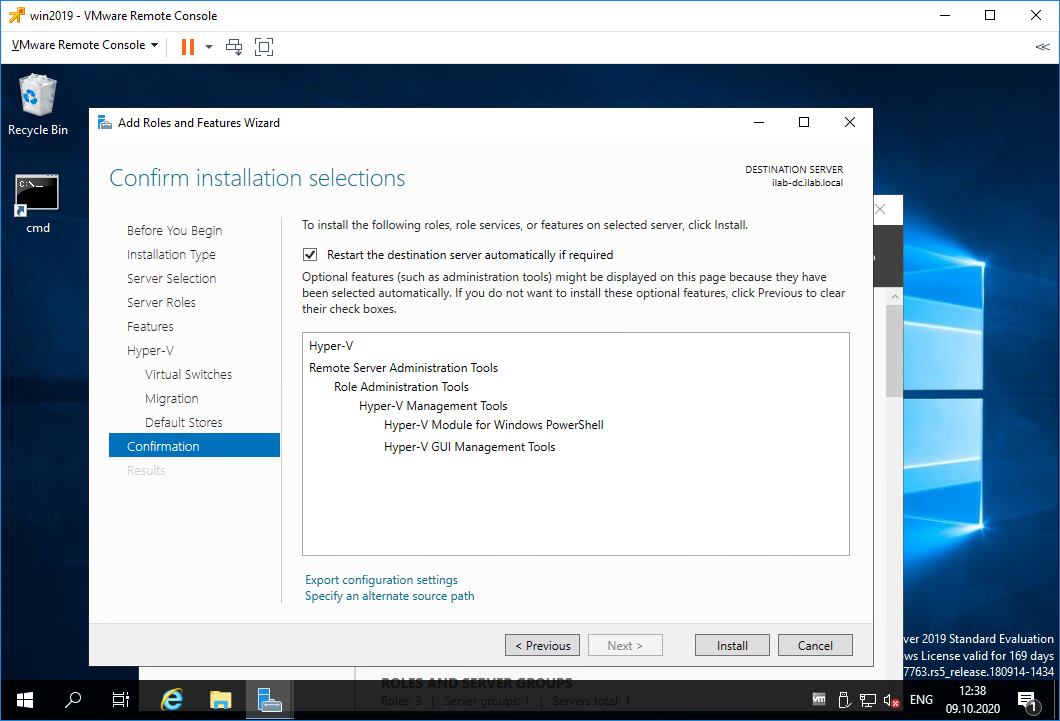

Попадаем в раздел Confirmation. Проверяем что у нас будет установлено. Здесь же ставим галку, чтобы сервер при необходимости перезагрузился. Install.

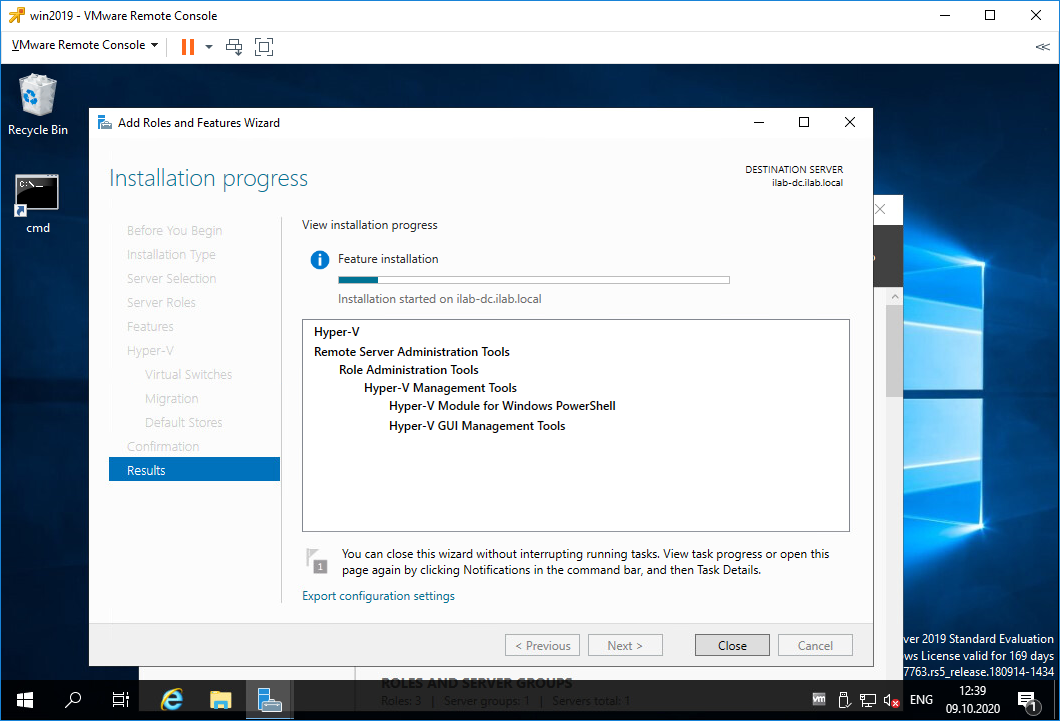

Начинается процесс установки роли Hyper-V.

После перезагрузки роль продолжает устанавливаться.

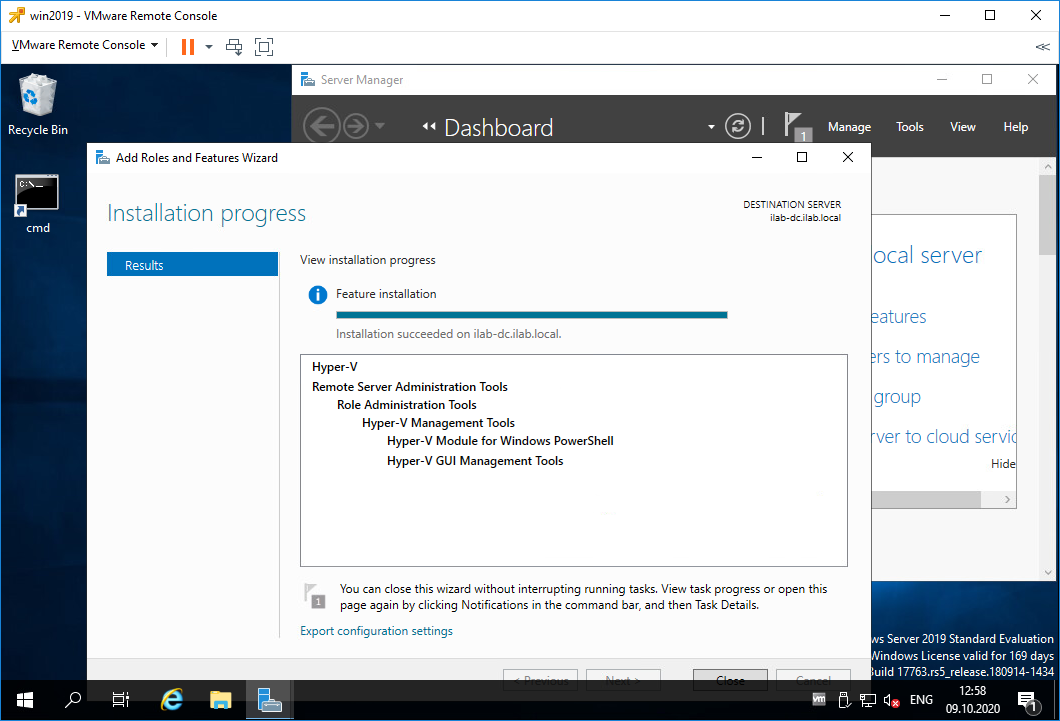

Установка роли Hyper-V успешно завершена. Close.

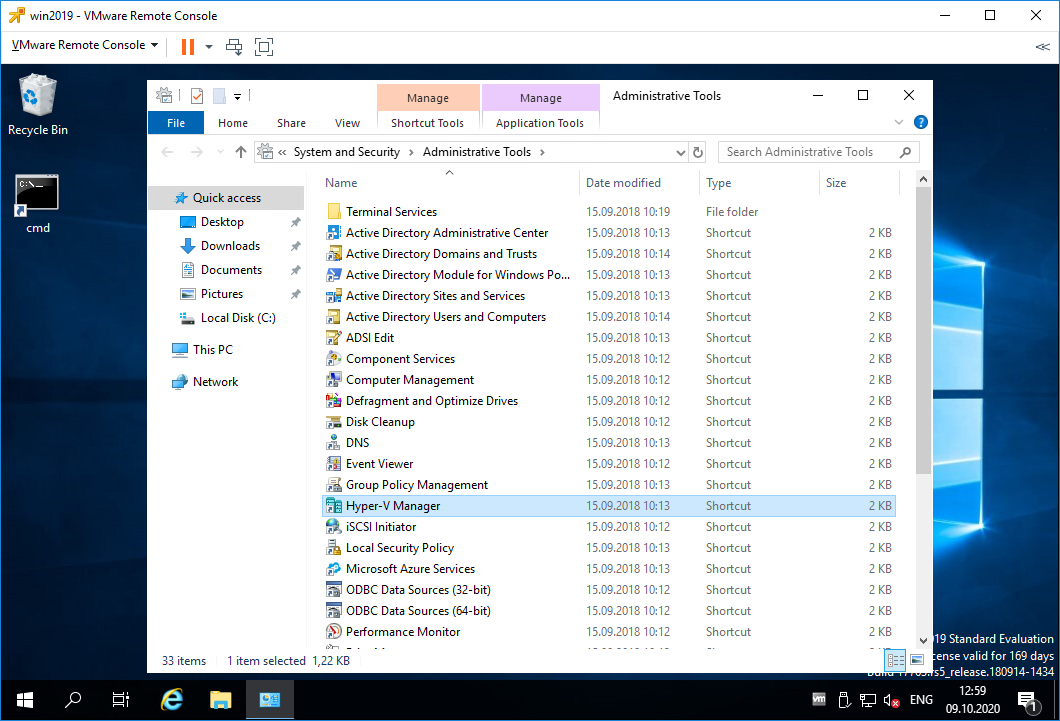

В Administrative Tools появляется Hyper-V Manager.

Настройка виртуального коммутатора Hyper-V

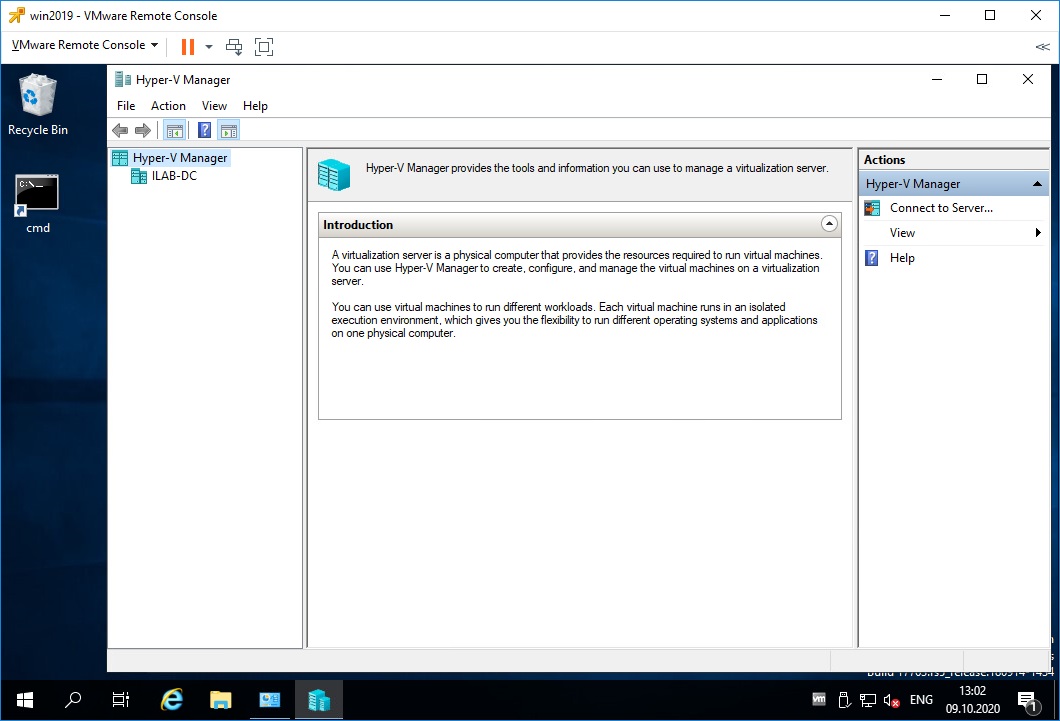

Запускаем Hyper-V Manager.

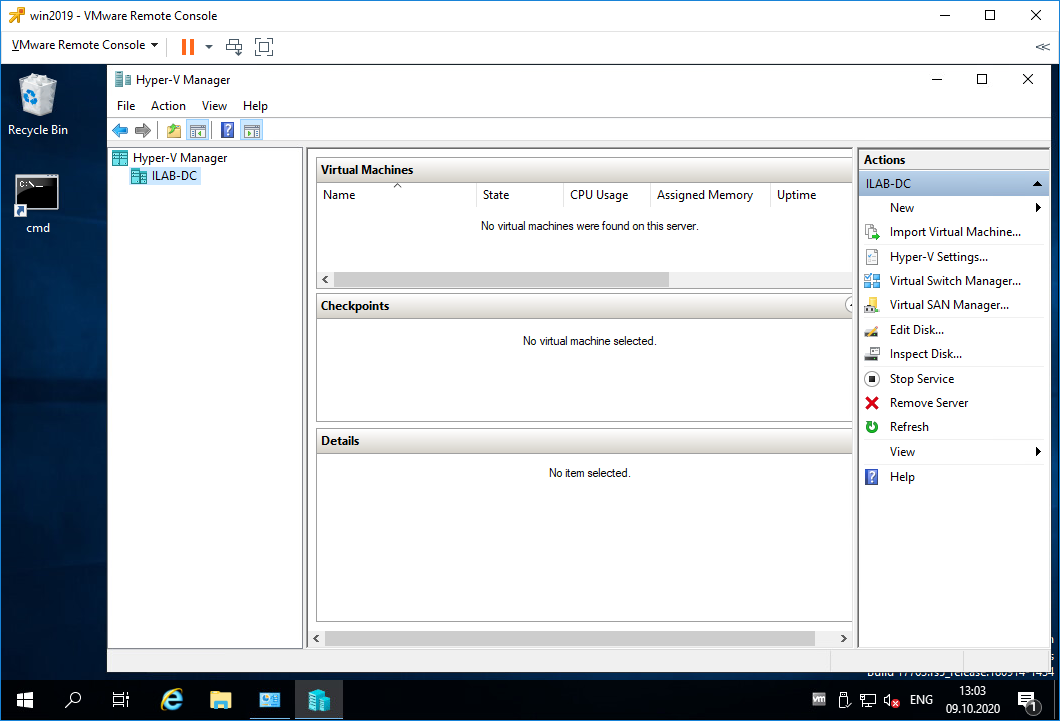

В списках серверов Hyper-V есть текущий сервер ILAB-DC. Нажимаем на него.

Список виртуальных машин пуст. Перед созданием новой виртуалки нужно настроить виртуальный коммутатор. По идее он уже должен быть настроен, т.к. мы при установке роли Hyper-V ставили галку для привязки виртуального коммутатора к физическому сетевому адаптеру. Но проверить не помешает, были случаи, когда виртуальный коммутатор на привязывался к физическому адаптеру. Такое случается, когда роль Hyper-V устанавливается несколько раз. В этом случае зайдите в настройки физического адаптера и снимите галку со всего где есть слово «Hyper-V», после этого физический адаптер можно снова привязать к виртуальному коммутатору из оснастки Hyper-V Manager.

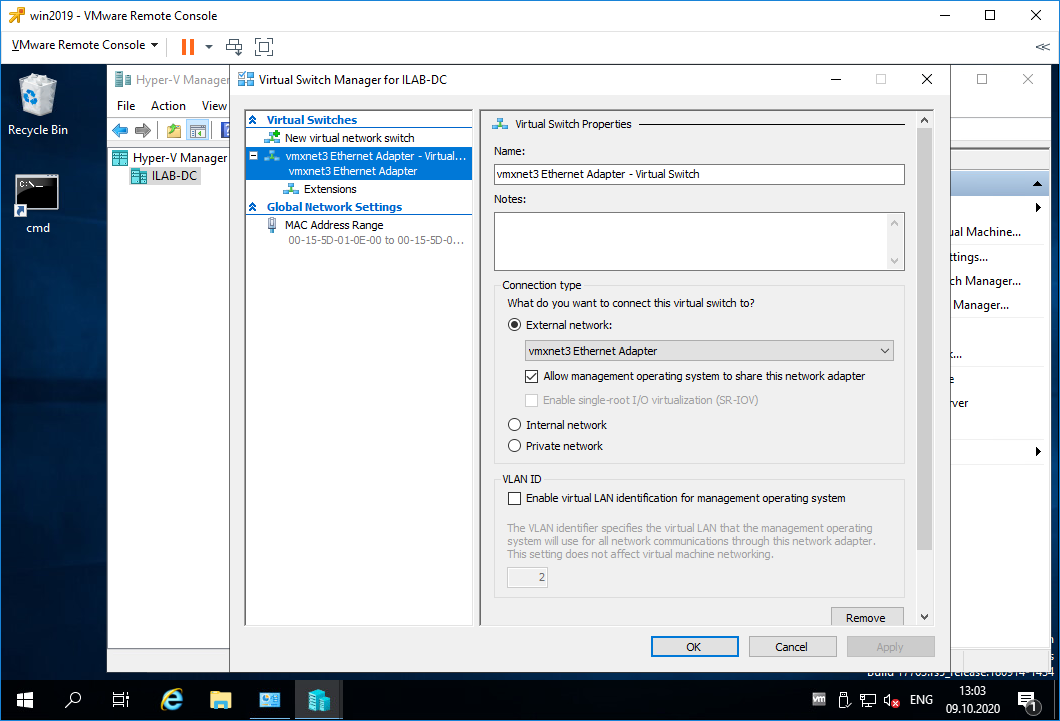

Нажимаем Virtual Switch Manager.

SR-IOV (Single Root Input/Output Virtualization, виртуализация ввода-вывода с единым корнем) — технология виртуализации устройств, позволяющая предоставить виртуальным машинам прямой доступ к части аппаратных возможностей устройства.

При необходимости можно включить поддержку VLAN.

Настраиваю виртуальный коммутатор, вернее, ничего не меняю, меня устраивают текущие настройки. OK.

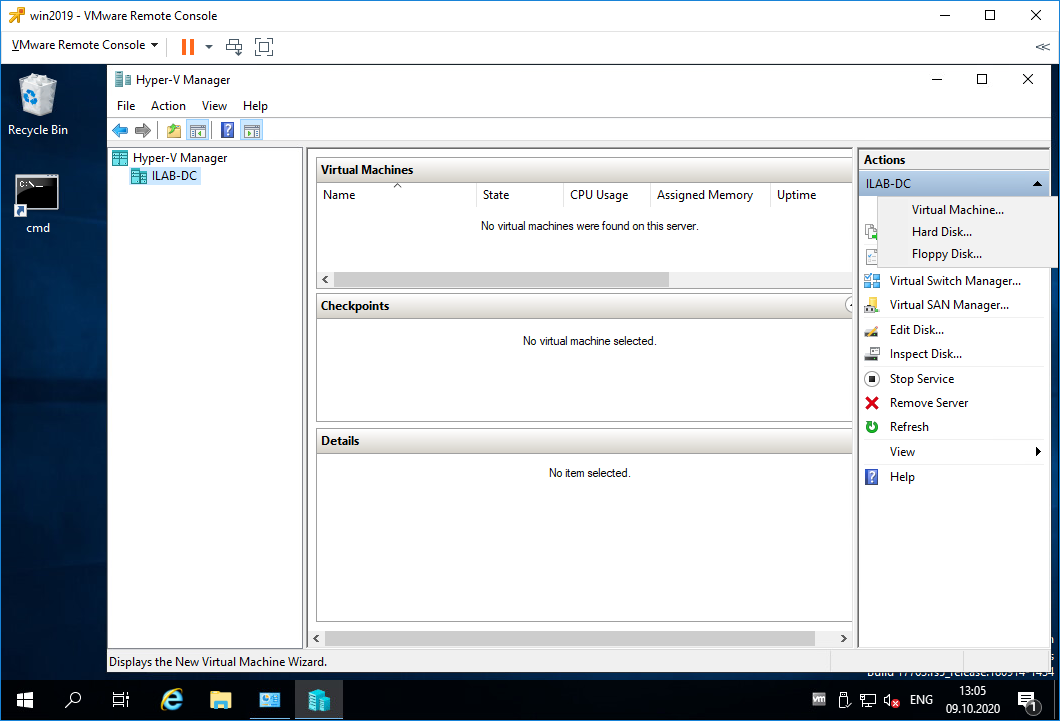

Создание виртуальной машины в Hyper-V

Пришло время создать первую виртуальную машину. Открываем Hyper-V Manager.

New > Virtual Machine.

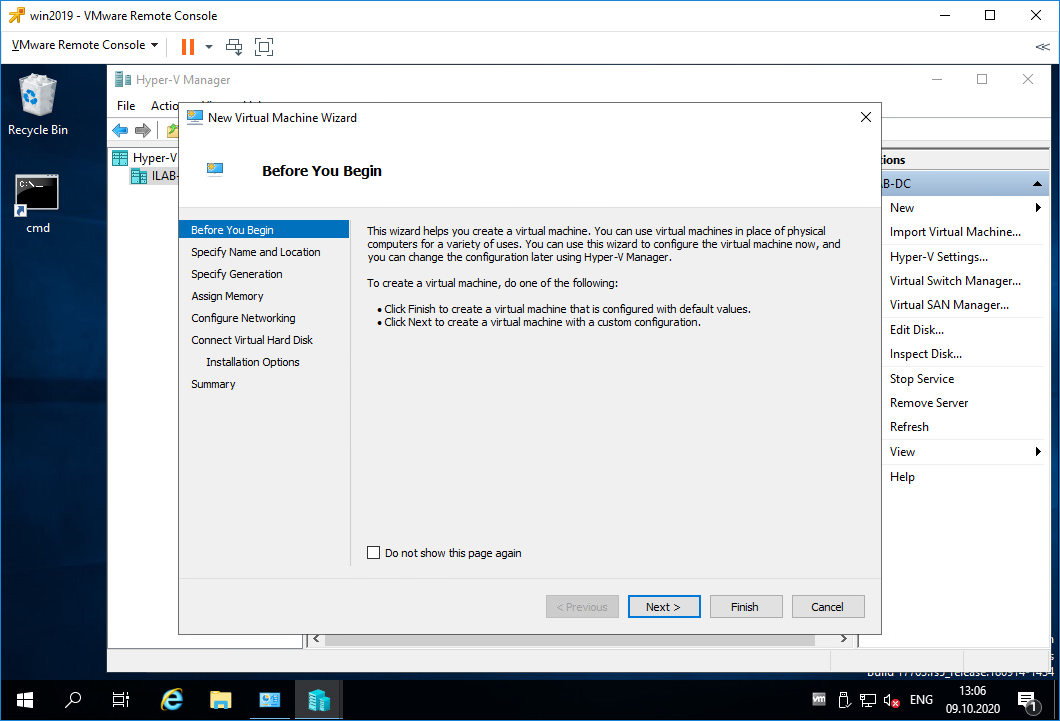

Открывается мастер создания виртуальных машин. Попадаем в раздел Before You Begin. Здесь нет ничего интересного. Next.

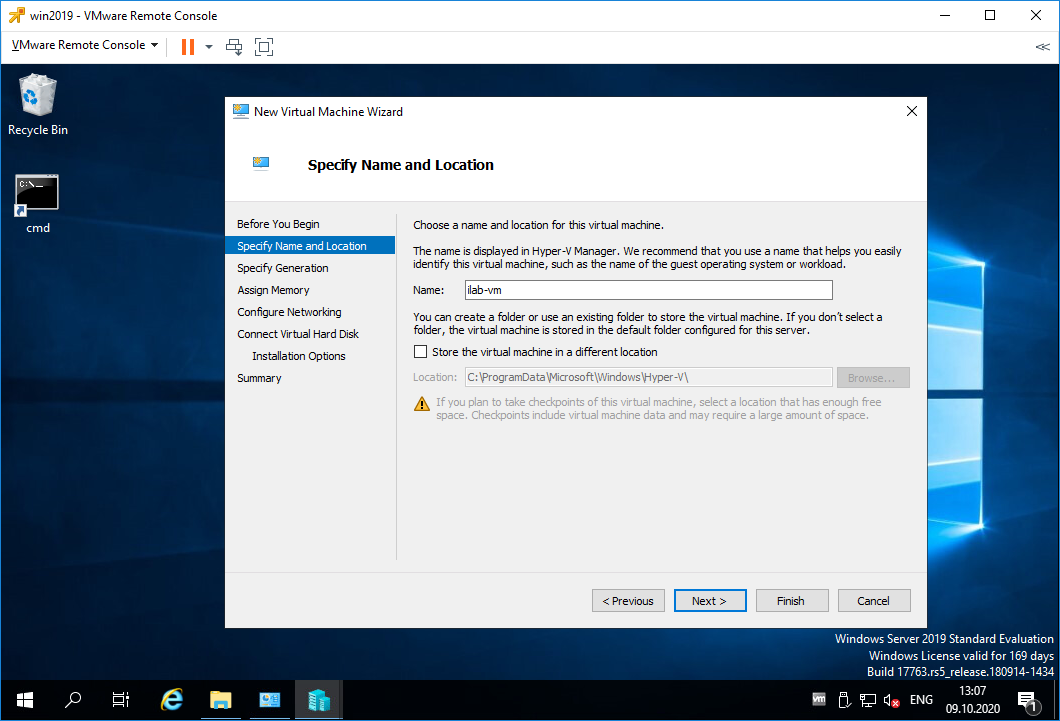

Попадаем в раздел Specify Name and Location. Указываем имя виртуалки. При необходимости можно изменить папку, в которой будут храниться файлы виртуалки. Next.

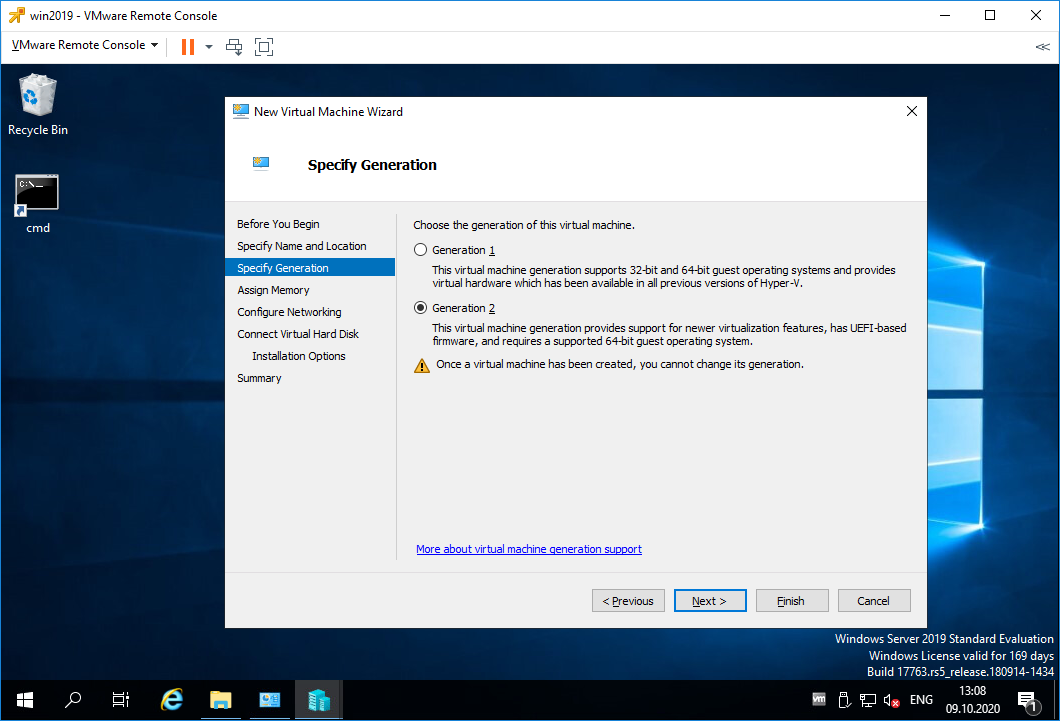

Попадаем в раздел Specify Generation. Выбор поколения зависит от того, какую операционную систему на виртуальной машине вы хотите установить, и метод загрузки, который вы хотите использовать для развертывания виртуальной машины. Виртуальные машины поколения 1 поддерживают большинство гостевых операционных систем. Виртуальные машины поколения 2 поддерживают большинство 64-разрядных версий Windows, Linux и FreeBSD. Рекомендуется выбрать поколение 2 за исключением случаев когда:

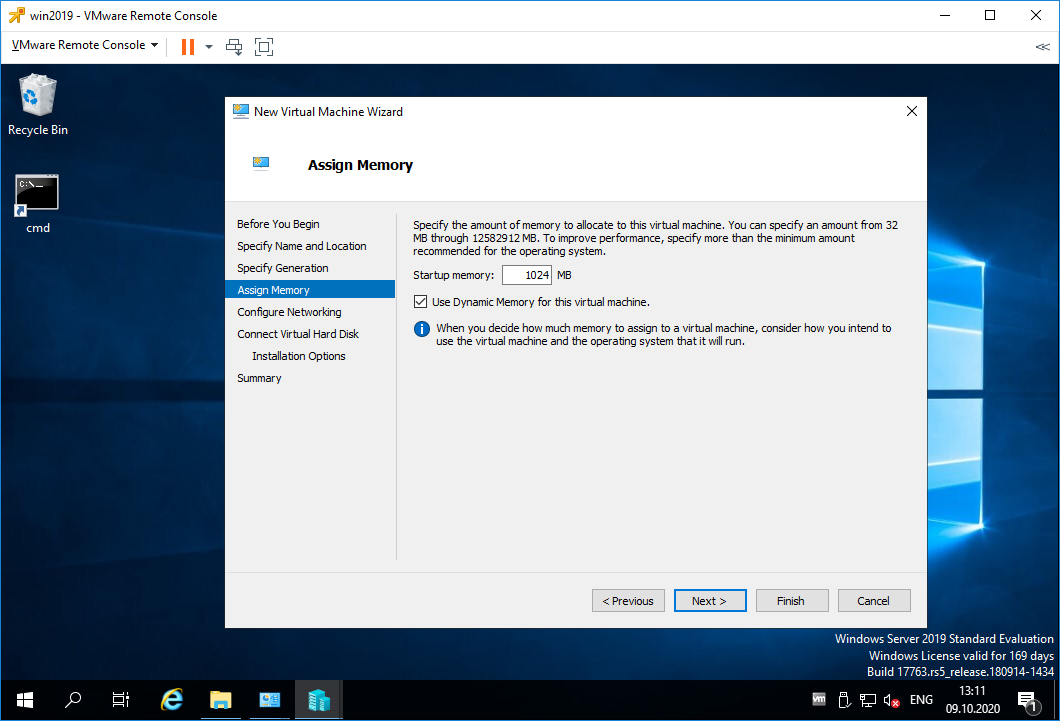

Попадаем в раздел Assign Memory. Выделяем память для виртуалки. Динамическая память забирается у сервера, как ни странно, динамически, т.е. сколько нужно, столько и забирается. Если галку не поставить, то вся выбранная память серверу будет недоступна. Next.

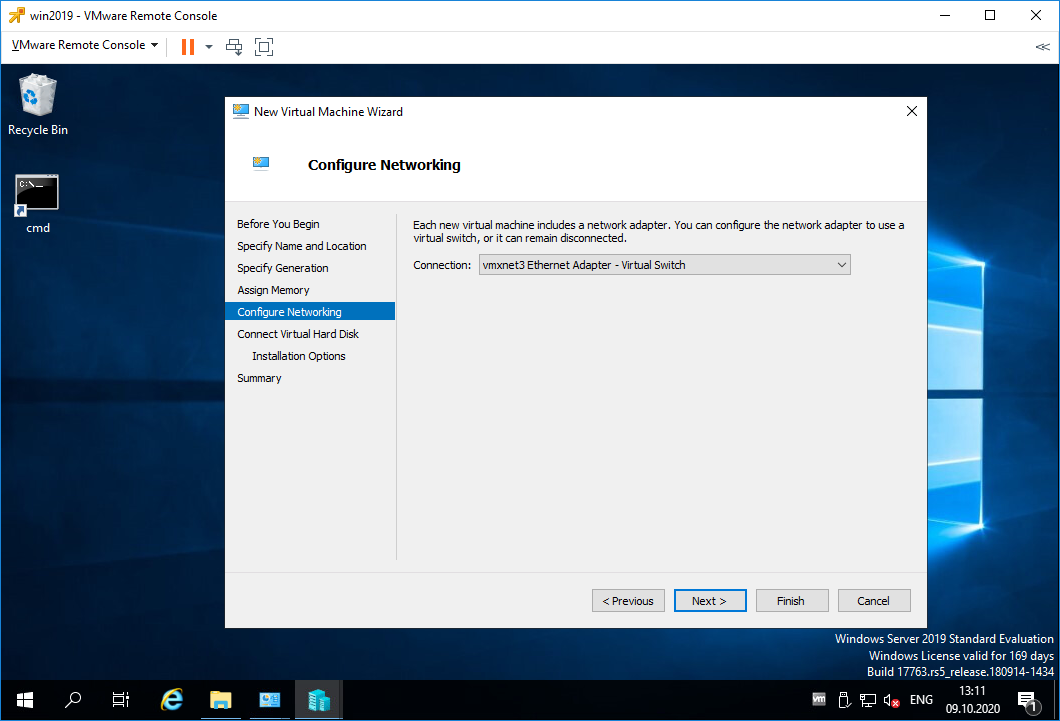

Попадаем в раздел Configure Networking. Выбираем виртуальный коммутатор. У меня он один. Next.

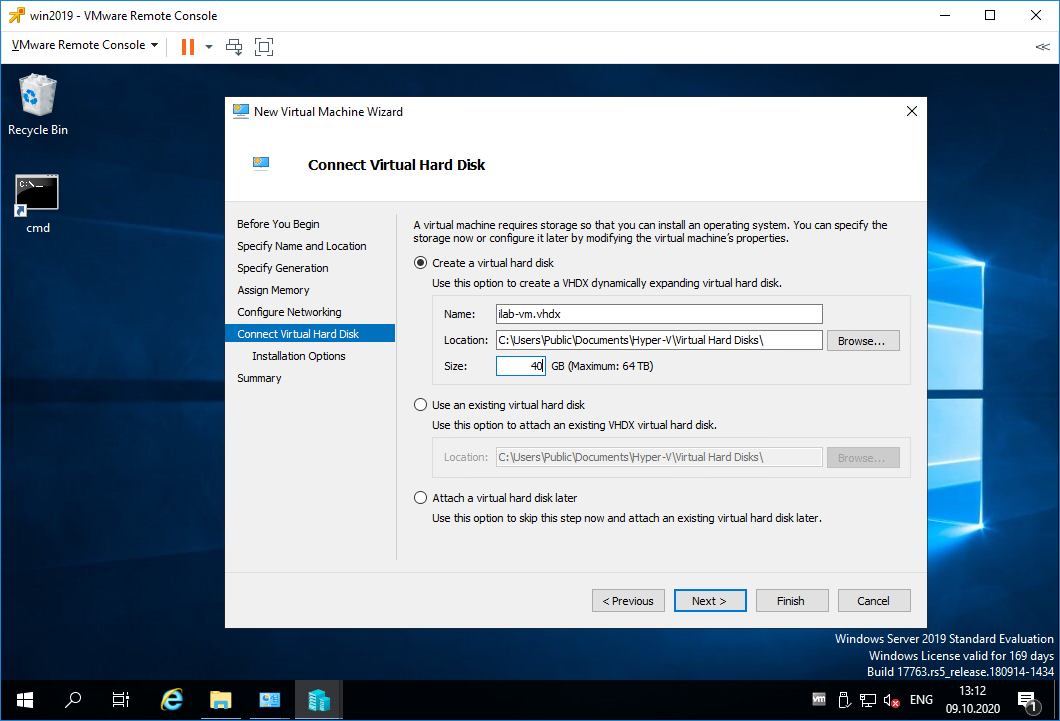

Попадаем в раздел Connect Virtual Hard Disk. Здесь создаём жёсткий диск, можно выбрать папку для его хранения. Можно подключить существующий жёсткий диск. Можно не подключать жёсткий диск. Я создаю новый диск объёмом 40 ГБ. Next.

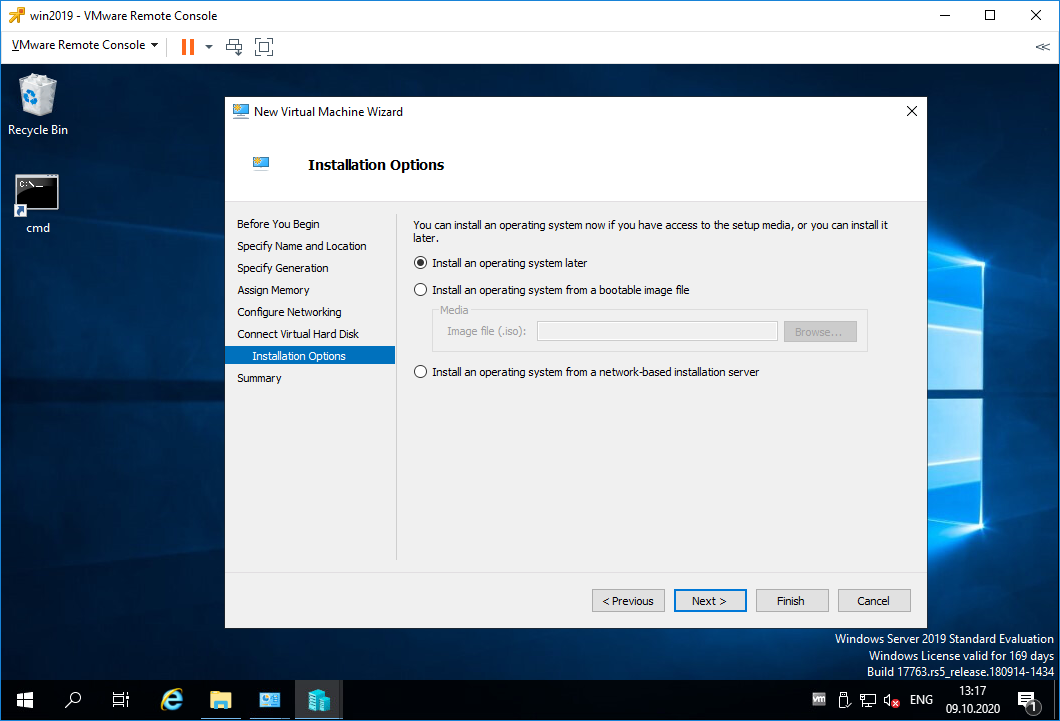

Попадаем в раздел Installation Options. Здесь можно примонтировать образ установочного диска, я сделаю это позже. Next.

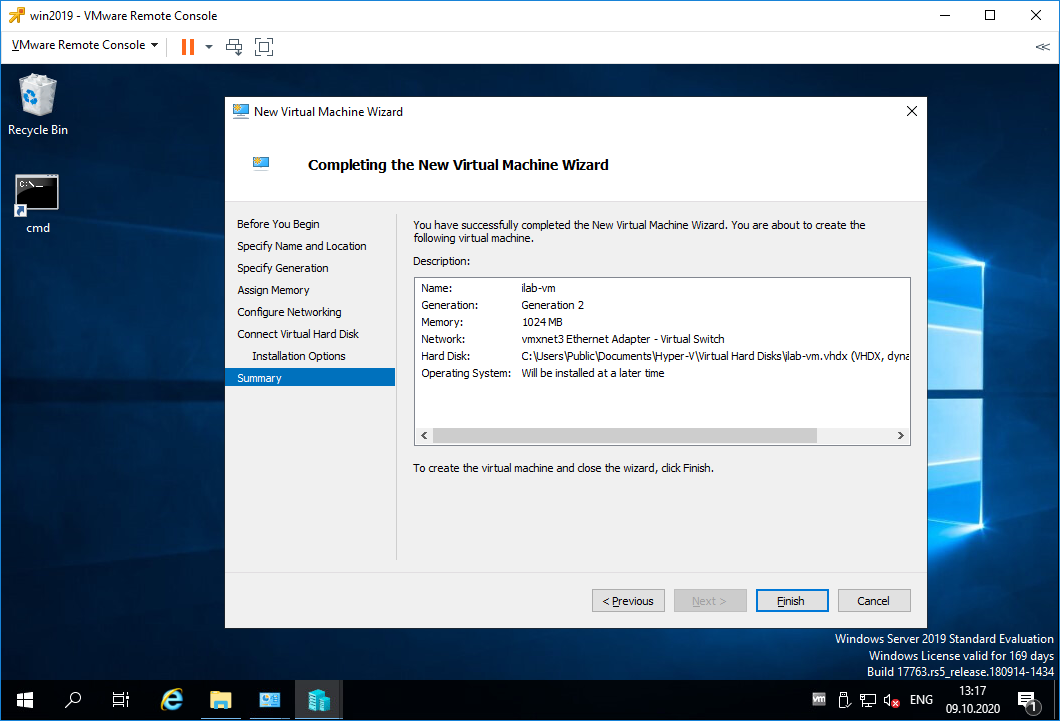

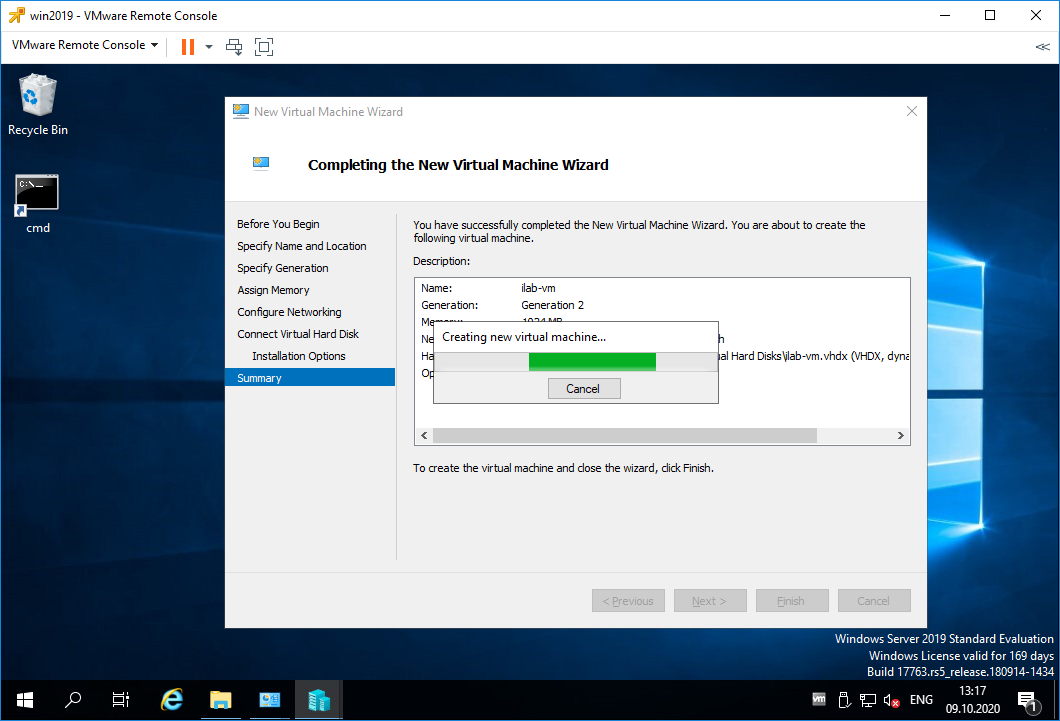

Попадаем в раздел Summary. Проверяем параметры. Finish.

Начинается процесс создания виртуальной машины.

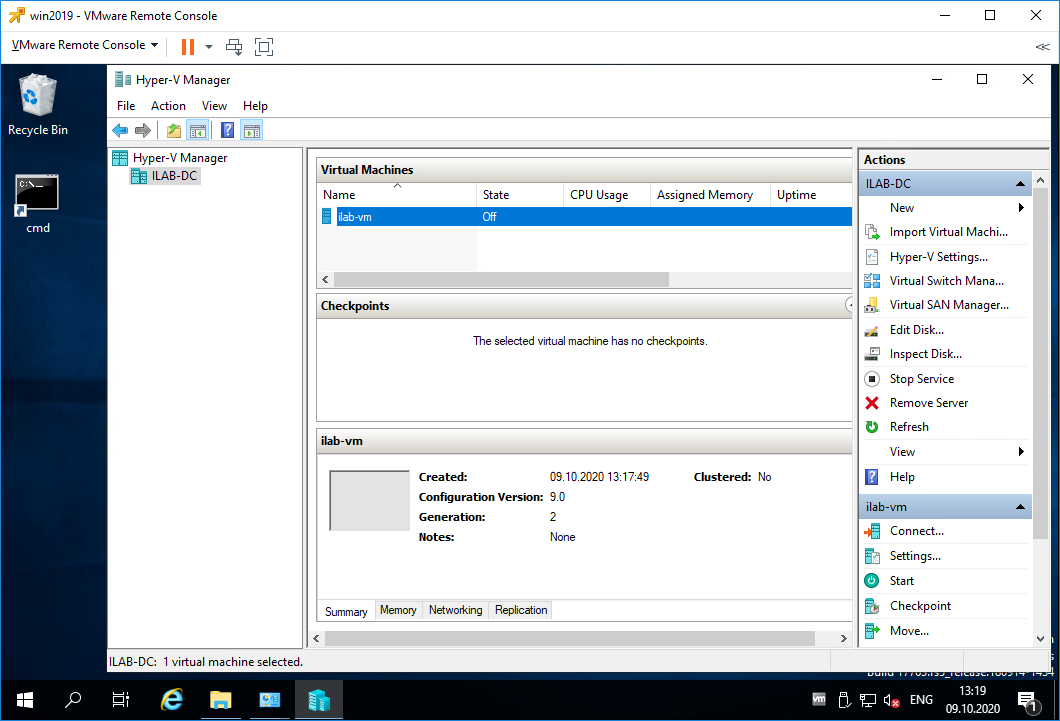

Виртуальная машина создана, она выключена (State = Off).

Установка операционной системы на виртуальную машину Hyper-V

Теперь примонтируем ISO образ к виртуальной машине и попробуем начать процесс установки операционной системы.

Выделяем виртуалку, нажимаем Settings.

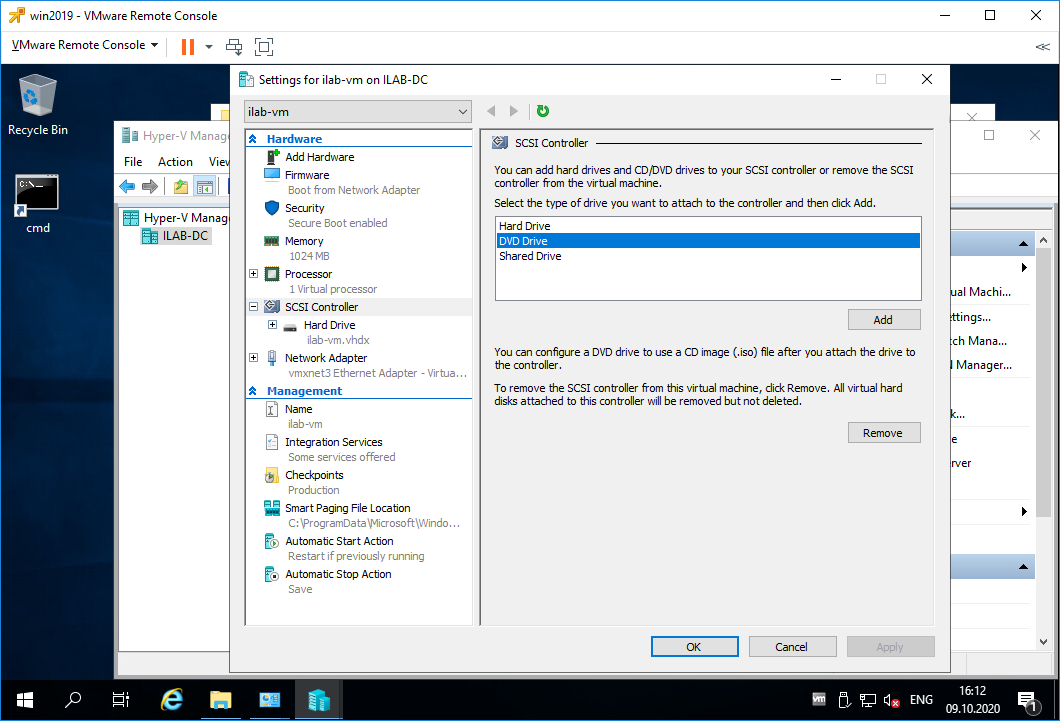

Переходим в раздел SCSI Controller. Видим, что в нём находится только жёсткий диск. Справа выбираем DVD Drive, Add.

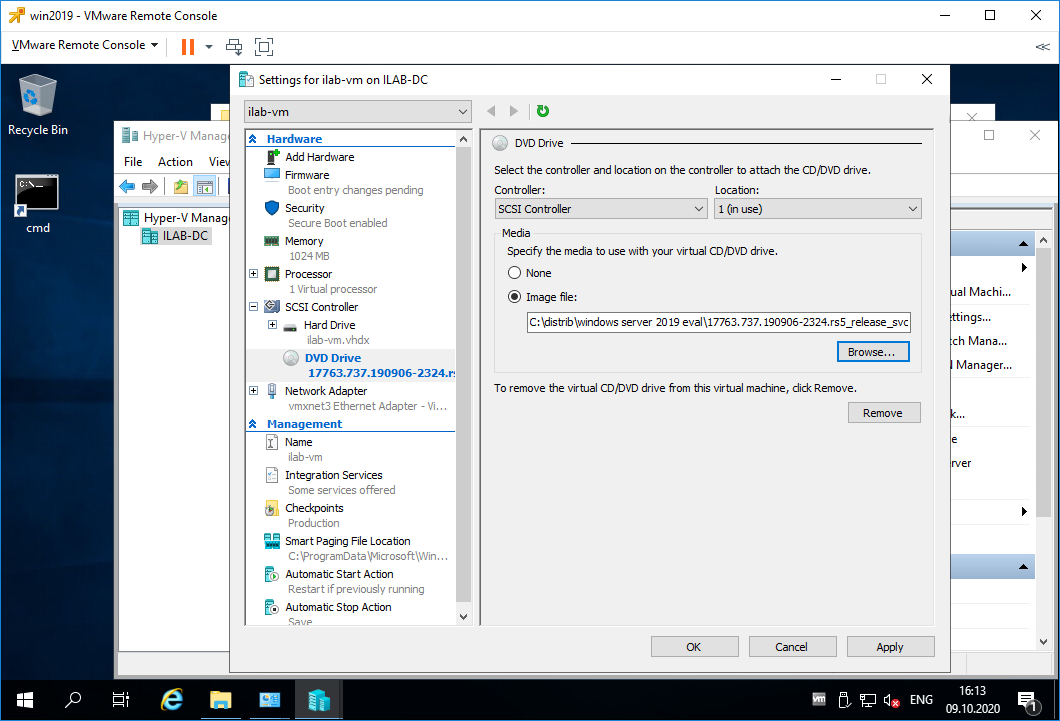

У виртуальной машины появляется виртуальный DVD Drive. Выбираем Image file, выбираем ISO образ для установки операционной системы. Apply.

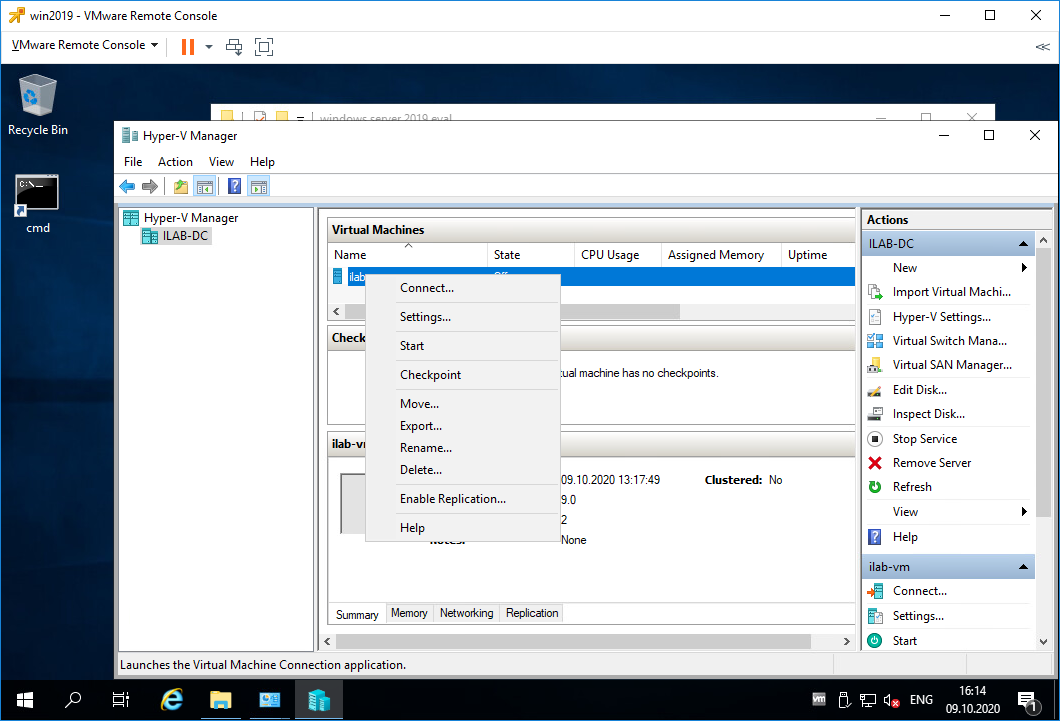

Правой кнопкой на виртуалку, Connect.

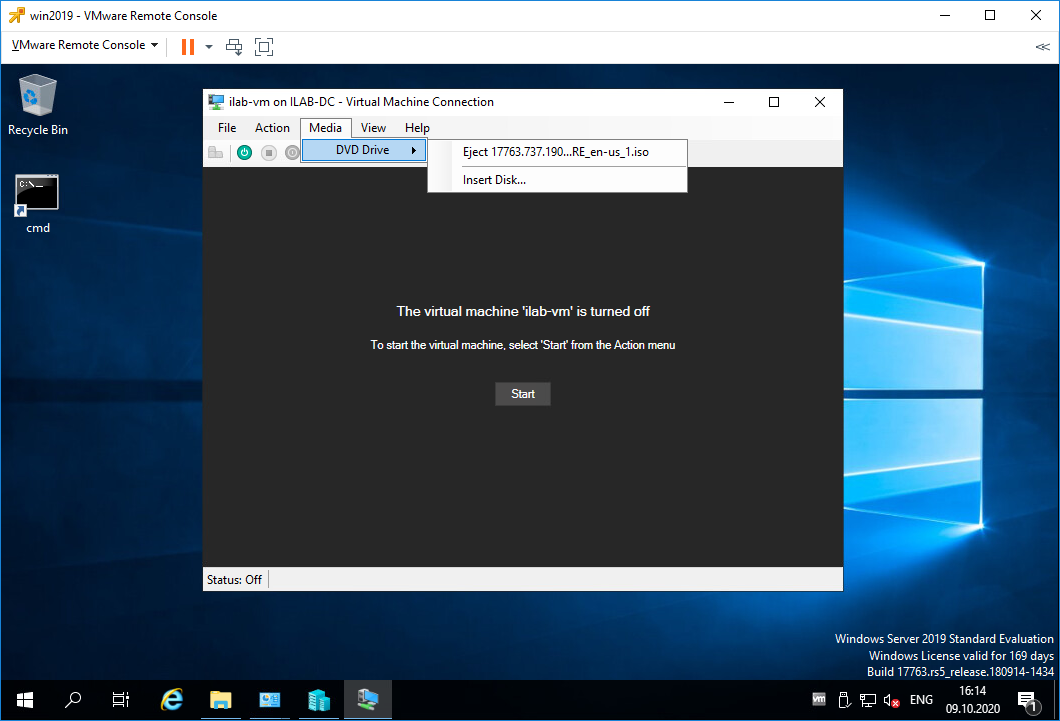

Открывается консоль виртуалки. ISO образ можно также вставить/извлечь в меню Mediz > DVD Drive. Включаем виртуалку, Start.

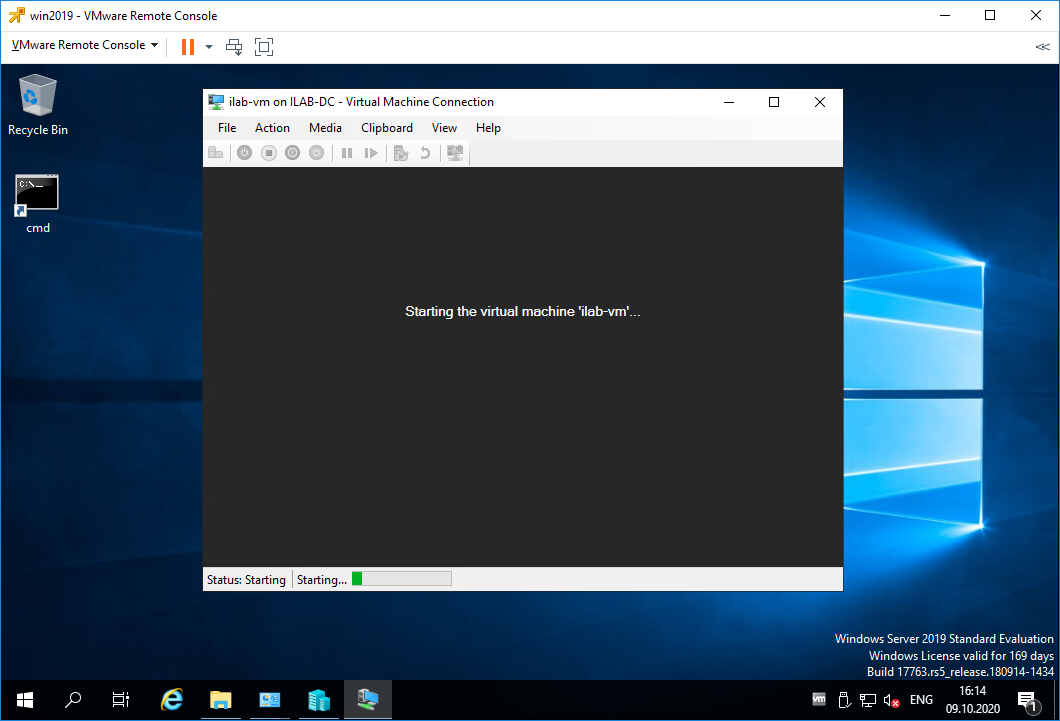

Виртуальная машина включается.

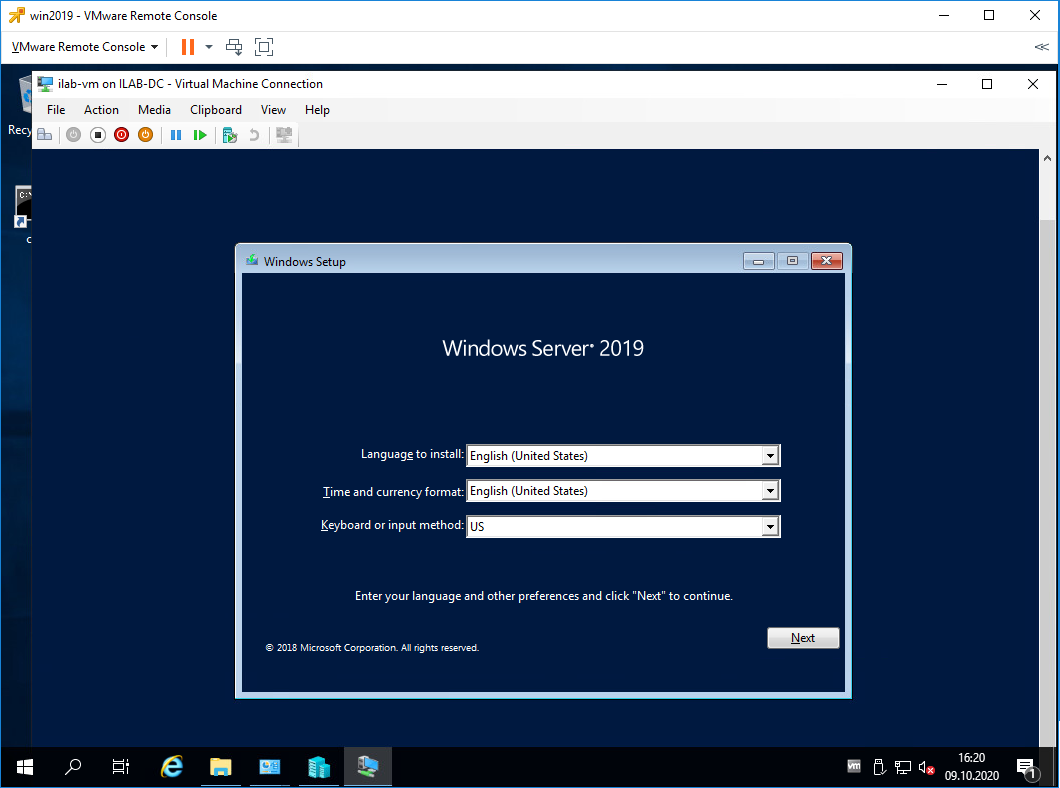

Загружается ISO образ и мы можем установить операционную систему, дальше вы справитесь.

Заключение

Мы с вами на сервере Windows Server 2019 установили роль Hyper-V, настроили виртуальный коммутатор и создали первую виртуальную машину. Подключили виртуальный дисковод и загрузились с установочного ISO образа операционной системы.

Добро пожаловать в волшебный мир виртуализации Hyper-V.

ESXI 6.7 GPU PassThrough and «Expose hardware assisted virtualization to the guest OS» not working.

Kristian

Active Member

I am evaluating ESXI 6.7.

When activating «expose hardware assisted virtualization to the guest OS» (hope I am translating correct) (CPU Options, one line above IOMMU)

it is possible to additionaly add a PassThrough GPU to my Windows 10 VM guest,

but the VM is not starting, showing error

«It is not possible to pass through devices, while nested virtualization is active».

Is this «normal» behaviour?

Or am I doing something wrong here?

whitey

Moderator

Kristian

Active Member

I have a Baremetal machine running a super micro x 10SLH with a Xeon E3 1241 V3.

I am running ESXI 6.7 in eval mode.

On top there is a Windows 10 vm

This machine runs an application called Bluestacks (Android Emu)

When I start Bluestacks the performance is horrible and in settings I can only assign one core.

If I enable Hardware virtualization (see picture above) I can assign all 4 cores, but I can no longer pass through a video card (well I can select pass through, but the vm is no longer starting up, displaying an instant error message)

what is another performance killer.

Have I understood you correctly: This is the normal behavior?