Fast data transit что это

Бизнес хочет быстрые данные вместо больших и уходит в онлайн-обработку

Пакетная обработка данных стала слишком медленной и не удовлетворяет потребностям бизнеса. На российский рынок пришли решения класса Fast Data, основанные на потоковой обработке и использующие методы машинного обучения. О том, как большие данные становятся быстрыми и какую практическую пользу смогут извлечь из этого отечественные компании, в совместном интервью CNews рассказали Геннадий Волков, главный архитектор, и Лина Чуднова, руководитель направления Fast Data компании «Неофлекс».

«Пакетная обработка больших данных — это слишком медленно»

Обработка больших данных дала возможность для решения целого класса новых задач. Это задачи e-commerce и персонализации в реальном времени, NBO (Next Best Offer — поиск оптимального предложения для клиента) и NBA (Next Best Action — ML-алгоритм, предсказывающий дату следующей покупки), задачи интернета вещей, предиктивной аналитики, борьбы с киберпреступлениями и выявления аномальных отклонений.

Для многих компаний пакетная обработка больших данных, при которой они собираются в больших масштабируемых хранилищах, а обрабатываются уже позже, стала слишком медленной. Поэтому архитектура и технологии больших данных развиваются в сторону Fast Data — потоковой обработки, при которой данные обрабатываются по мере их поступления, что обеспечивает конкурентное преимущество современным компаниям.

Fast Data — это основной тренд в современной обработке данных и те российские компании, которые хотят выиграть в конкурентной борьбе, должны следовать этим тенденциям, становиться предприятиями «реального времени», ведь их конкуренты — ведущие компании мира — движутся в эту сторону.

До недавнего времени хранилище данных (DWH) или, позже, Data Lake в технологиях больших данных были ориентированы на пакетную обработку. При этом данные собирались в распределенных файловых системах, таких как HDFS или базах данных, а затем обрабатывались пакетами и изучались в интерактивном режиме с использованием средств аналитики. Сейчас, как я уже отметил, зависимость исключительно от пакетной обработки данных становится конкурентным недостатком. Таким образом, DWH и системы обработки больших данных эволюционируют к решениям, ориентированным на немедленную обработку данных по мере их поступления.

Решения, обрабатывающие потоки данных, предъявляют гораздо более жесткие требования к отказоустойчивости, доступности и масштабируемости приложений, чем традиционная пакетная обработка в архитектуре больших данных. Это связано с тем, что такие решения должны работать непрерывно недели и месяцы с постоянно меняющейся нагрузкой.

Другое важное отличие Fast Data от больших данных — это требования к обеспечению интеграции с другими системами и источниками данных в онлайн-режиме и, соответственно, к малому времени отклика.

Таким образом, подход Fast Data объединяет в себе технологии потоковой обработки данных, когда мы работаем с потоком данных, как с одной бесконечной таблицей баз данных, и технологии микросервисов, которые позволяют реагировать на отдельные события и интегрироваться с внешними системами-источниками данных.

Такие решения востребованы во всех современных отраслях. В первую очередь — в тех предприятиях, которые осуществляют цифровую трансформацию. Предлагая продукты и услуги через новые цифровые каналы, такие компании сталкиваются с необходимостью обрабатывать большее количество данных, делать это быстрее, применять к данным более сложную логику. Если обязательно выделять какие-то отрасли, то я бы назвала банки, финтех, ритейл, логистику и промышленность.

«Неофлекс» работает преимущественно с финансовым сектором, в котором к Fast Data уже сформировался предметный интерес, мы уже реализовали проекты в этой области.

Лина Чуднова:

«Fast Data наиболее эффективна в связке с машинным обучением»

Частично Геннадий их уже назвал, говоря о больших данных: это принятие решений, например, в банковских рисках, NBO и NBA в электронной коммерции, банках и ритейле. Помимо этого, я бы отметила выявление аномалий (в области интернета вещей, детектирование фрода в банках, другие задачи в сфере информационной безопасности), predictive maintenance (предиктивный ТОиР) на базе промышленного интернета вещей, аналитика в режиме реального времени, анализ логов приложений (Systems Management), обработка транзакций.

В современных реалиях увеличились не только объемы и скорости обработки данных, но и сложность этой обработки. Многие вышеперечисленные задачи невозможно решать, используя традиционный подход с заданной и запрограммированной заранее логикой. Куда более эффективным представляется объединение Fast Data и методов машинного обучения, которыми мы в «Неофлекс» активно занимаемся. Скажу больше: без машинного обучения большую часть этих задач решить практически невозможно.

ИТ-решения вообще стали структурно сложными после наступления эпохи больших данных. Не существует единой технологии, которая подходит для решения различных классов задач обработки данных. То же самое относится и к решениям класса Fast Data. Создавая их, приходится учитывать множество часто взаимоисключающих требований, искать между ними компромисс. Насколько необходимо малое время отклика? Какие объемы данных обрабатываются? С какими типами задач они связаны? Какие обрабатывать события — одним пакетом или каждое в отдельности? Задействована ли сложная обработка событий? С какими другими инструментами необходимо интегрироваться и как это сделать? На все эти вопросы приходится давать ответы. При этом мы в «Неофлекс» сталкиваемся с тем, что бизнес-заказчики ждут от решений Fast Data времени отклика менее одной секунды при обработке десятков и сотен тысяч сообщений в секунду, объемом до нескольких терабайтов в день.

Для построения Fast Data-решений существует большое количество платформ, технологий и инструментов. Сейчас они как раз достигли уровня зрелости и готовы к применению при решении самых сложных и ответственных задач. Какие бы технологии ни были выбраны, предполагается, что они должны иметь возможность исполняться в современной облачной среде, то есть быть cloud-ready. Для этого мы используем платформы оркестрации контейнеров OpenShift и Kubernetes. Кроме того, компания «Неофлекс» использует такие open source-решения, как Apache Kafka, CloudFlow, Apache Spark, Apache Flink, Akka и ряд других.

Здесь стоит отметить, что «Неофлекс» обладает глубокой экспертизой в перечисленных технологиях и является партнером компании Lightbend, в том числе по внедрению Lightbend Fast Data Platform на российском рынке.

Важно, что неотъемлемыми компонентами Fast Data-решений стали платформы управления жизненным циклом моделей машинного обучения. Мы интегрируем в наши решения такие платформы как MLflow и Kubeflow, которые позволяют построить автоматизированный процесс создания модели, ее обучения и ее эксплуатации. Используя построенные нами CI/CD-процессы, мы интегрируем модели машинного обучения и потоковую обработку данных в единое решение. В настоящее время такой класс CI/CD-задач получил в ИТ-мире название MLOps.

Компания «Неофлекс» уже несколько лет ведет разработку подобных решений, а с начала этого года мы выделили экспертизу Fast Data в отдельное направление. Мы уверены, что это позволит сконцентрировать наш опыт, чтобы эффективнее решать задачи заказчиков.

Один из последних интересных проектов — внедрение аналитической платформы для мониторинга событий информационной безопасности в банке «Открытие». Это решение дает возможность непрерывно и в реальном времени регистрировать, анализировать и реагировать на различного рода инциденты. Всего с помощью потоковой аналитики Spark Streaming происходит захват логов и непрерывный анализ порядка 60 тыс. сообщений в секунду на предмет потенциально опасных или аномальных ситуаций.

Еще один любопытный проект был реализован в 2019 году в «Первой экспедиционной компании» (ПЭК). Мы создали там «Центр управления перевозками» (ЦУП). Это система онлайн-планирования и прогнозирования перевозки грузов, которой охвачено без малого 200 складов, загрузка которых теперь известна на месяц вперед с достаточно высокой степенью точности. Технологической основой запущенного ЦУП стали решения класса Fast Data с открытым кодом. Микросервисы написаны с использованием Akka Framework, а Spark Streaming отвечает за потоковую обработку данных. Микросервисный подход значительно упростил масштабирование и внедрение доработок. Ключевым итогом внедрения стало то, что теперь ПЭК доставляет 97% грузов в оговоренные с клиентом сроки. Из программных плюсов стоит выделить время доставки информации от учетных систем до ЦУП, которое составляет менее минуты!

Сейчас отечественный рынок несколько отстает от западного. За рубежом уже есть интересные примеры внедрений таких решений известными финансовыми институтами, например в Capital One — американской банковской холдинговой компании, специализирующийся на кредитных картах и автокредитах. Здесь была выстроена работающая в режиме реального времени система предложений в области автокредитования. Причем речь не только про принятие решения. В частности, благодаря описанным выше технологиям, клиентам Capital One доступен онлайн-выбор комплектации автомобиля, который сопровождается моментальным отображением новой стоимости.

Если говорить о российском опыте, то я бы отметила, что у нас в стадии реализации находятся масштабные проекты, не уступающие по всем параметрам самым интересным и сложным зарубежным кейсам. Уже к концу года мы сможем рассказать о них широкой публике.

Быстрые, малые, умные. Какие еще бывают большие данные?

Термин Big Data или «большие данные» получил широкое распространение в середине 2000-х и приходится на развитие эпохи «свободного интернета» или технологии Web 2.0. В Web 2.0 ключевыми акторами являются сами пользователи и их личный опыт: смешная картинка, которой они решили поделиться; отзыв на недавно приобретенную покупку, совершенную онлайн; семейная фотография с поездки на море. К признакам «раннего» Web 2.0 можно отнести многочисленные веб-форумы, имиджборды, массовые онлайн чаты. Сегодня на смену веб-форумам пришли социальные сети и тематические блоги.

За развитием концепции Web 2.0 последовала другая — концепция Big data. Изначально этот термин использовался в контексте проблем обработки многочисленных неструктурированных данных. Сегодня же под «большими данными» все чаще подразумевают совокупность подходов к обработке постоянно накапливающейся информации и поиску в ней различных закономерностей.

Для более четкого определения обратимся к энциклопедии журнала PC Magazine:

Большие — это сколько?

Слово «большие» не отражает размерность данных. Сказать, что 100 Гб текста, это «большие данные» — некорректно. Кроме того, классифицировать набор данных из 10 пользователей как «маленький» — также некорректно. Если необходимо подчеркнуть количество информации в одном наборе, то используют термин Lot of Data или «много данных».

Подход «большие данные» применяется там, где стандартные методы обработки информации являются неэффективными.

В качестве классического примера можно привести социальные сети: Instagram, Twitter, YouTube и др. Ежедневно миллионы пользователей, заходя в сеть, оставляют огромное количество цифровых следов: просмотры записей, переходы по ссылкам, лайки, репосты. При этом каждая операция содержит отметку о времени. В результате имеется постоянно обновляемый набор данных о пользовательских действиях, анализируя который, можно более эффективно настроить рекламу или, например, формировать персональную (другими словами — умную) ленту для пользователя.

Если есть большие, значит есть и маленькие?

Есть — маленькие, малые или, более привычно — Small Data. Единого определения для термина нет. Но в обиходе можно встретить несколько от части связанных между собой концепций. Вот некоторые из них:

В академической сфере для определения понятия «Small Data» используется первый вариант. Принято считать, что до 2008 года все научные данные, по сути, были тем, что сейчас называют как «малые». Требования для сбора и хранения больших массивов информации до 2010 года были выше имеющихся тогда технических возможностей.

Малые данные — это часть больших данных, их некоторая подвыборка с условием ограничения по времени и/или по количеству представленной информации.

С другой стороны, малые данные — это массив такой размерности, который в большей степени «подвластен» исследователям без использования высоких вычислительных мощностей. Кроме того, при работе с малыми данными предоставляется больше возможностей для их укомплектования на подготовительном этапе, так что информацию о каждом объекте можно расширить. По аналогии с социальными сетями из примера о больших данных, можно выделить пользовательские действия за ограниченный период, затем по каждому из них в личном порядке (например методом рассылки опроса) уточнить настроение человека, его чувства и эмоции во время работы с системой.

Стоит отметить, что малые данные не обязательно являются отсекаемой частью больших данных и могут быть сформированы без них.

С размером понятно. А что еще?

Кроме «размерных» определений выделяют и другие концепции представления данных, лежащих как в научной, так и в предпринимательской плоскости. Рассмотрим некоторые из них.

Smart data

Smart Data или «умные данные» — это модель данных, имеющая смысл и/или ценность. В отличие от больших и малых, умные данные представляются следующим этапом филигранной постобработки собранной информации.

Американский деловой журнал Inc. приводит определение понятие Smart Data:

Умные данные данные, которые имеют действительную, четко определенную, значимую информацию, которая может ускорить обработку информации и принятие решений.

Простыми словами, умные данные содержат в себе лишь полезную информацию, удобную не только для считывания машиной, но и для обработки человеком.

Продолжая пример с социальными сетями: умные данные — это четко структурированная информация о том, какие тематики записей (политика, экономика, спорт и т.д.) нравятся различным группам пользователей (детям, подросткам, девушкам, молодым людям и т.д.).

Fast data

Подход «быстрые данные» или Fast Data ставит своей задачей оперативное обнаружение релевантной информации в постоянно поступающем и возрастающем потоке Big Data. Быстрые данные являются звеном между этапами сбора и обработки информации и выявлению из нее полезных свойств за максимально короткий промежуток времени.

Таким образом, понятие «обеспечение Fast Data» — это выявление Smart Data в Big Data в режиме реального времени для дальнейшего анализа.

Data, Data, Data, DATAAA.

Первоочередной причиной для подготовки этого материала послужило довольно распространенное и, зачастую, неправильное использование понятия Big Data. Необходимо признать, что сегодня возможности для обработки больших данных обусловлены не только техническими ограничениями, но и потенциальным наличием этих данных. Использование подхода Big Data оправдано только тогда, когда имеется достаточное количества объектов и их признаков.

Кроме того, для работы в области больших данных необходим целый штат рабочих, включая аналитиков, разработчиков, администраторов баз данных, менеджеров всех уровней и др., что наводит на мысль о реальности применении этих методов только крупными игроками на рынке.

Научным исследователям стоит присмотреться к более мелким концепциям, вроде Small Data или Smart Data и, возможно, затронуть понятие Capta Data (Johanna Drucker), на котором я подробно остановлюсь в следующий раз.

Fast Data на практике: как новые технологии помогают бизнесу

Последние пять лет рынок электронной коммерции показывает экспоненциальный рост. В отчете New digital divide компания Deloitte фиксировала агрессивный рост этого сектора экономики и прогнозировала его дальнейшее проникновение в нашу жизнь.

Мы все стали свидетелями начала цифровой трансформации в области коммерции. На ее раннем этапе заметным было появление новых цифровых каналов продаж для широкой группы потребительских товаров, таких как книги, одежда или обувь, которые сегодня не выходят за рамки привычного. Другие категории продуктов, такие как музыка или фильмы, полностью исчезли из физических магазинов, оставив только след во времени. Потребительское поведение начало меняться достаточно давно, и этот процесс продолжается до сих пор.

В условиях глобальной конкуренции специальные предложения массового характера для привлечения внимания потребителей уходят на задний план. Возникает потребность в качественной сегментации рынка и возможности быстро реагировать на поведение целевой аудитории. Таргетированный контент, показ персонализированных предложений и персональные бонусы — лишь часть инструментов для привлечения клиентов и повышения их лояльности. Сегодня для создания подобных предложений необходимы данные из различных разнородных источников. При этом формировать предложения зачастую необходимо в режиме реального времени.

На примере двух реализованных проектов для заказчиков из сферы финансового сектора и логистики хочу рассказать о технологиях, которые делают эти процессы возможными.

Применение онлайн витрин данных для e—banking

Онлайн витрины — неотъемлемая часть электронной коммерции и e-banking не исключение. В e-banking онлайн витрины позволяют формировать для клиента все те же персональные предложения, предоставляют возможность мониторить продажи, производить финансовый анализ, получать оперативную отчетность и многое другое.

На примере одной из наших задач для крупного российского банка мы столкнулись с проблемой формирования продуктового профиля клиентов из числа физлиц. На момент проведения обследования существующей IT-системы время обновления каждого профиля клиента было очень большим. У заказчика была необходимость в представлении информации потребителям в режиме онлайн, и задержка даже в одну-две секунды серьезно влияла на бизнес. Апробацию нового подхода мы начали в своей лаборатории. Для диагностики проблемы мы воссоздали клиентское окружение и нагрузили систему на основе синтетических данных. За три месяца нам удалось построить решение с использованием подходов микросервисной архитектуры и применением opensource технологий Fast Data. Новый подход показал себя очень эффективно: использованный технологический стек Apache Kafka, Cassandra, Spark Streaming позволил создать унифицированный согласованный буферный слой бизнес‑данных, наполняющийся автоматически и параллельно по всем информационным каналам, формирующим продуктовый профиль в режиме онлайн.

Анализ информации в сфере логистики

Еще одну задачу по построению онлайн витрины данных мы решали уже в сфере логистики. Заказчиком стала одна из крупнейших транспортно-логистических компании России. Первоначально цель была обозначена как сбор и визуализация данных. Но после полного сбора требований и составления десятков пользовательских историй, задача изменилась. Стало понятно, что заказчику необходимо решение, которое позволит получать прогноз по загрузке складов и доступности машин в ближайшем будущем, а также реагировать на события, происходящие в режиме реального времени. Существовавшая в компании архитектура и используемые технологии с трудом позволяли получать прогноз на следующий день. Поскольку коробочных продуктов, решающих аналогичную задачу нет, специалисты «Неофлекс» разработали персональное бизнес-решение с использованием новых подходов и технологий. За год совместной работы по методологии Scrum нам удалось разработать и внедрить систему управления перевозками. На этот раз в основу легла in‑memory база данных SnappyData, а все инфо-потоки были реализованы на привычных для нас технологиях Apache Kafka и Akka. Помимо решения основной задачи по real-time обработке данных с сенсоров, установленных на транспорте, и формирования онлайн витрины логиста, мы установили рабочие места для выполнения Ad-hoc запросов и интерактивного анализа данных, поступающих в режиме реального времени, с возможностью применения алгоритмов машинного обучения на основе Apache Zeppelin. Использованный подход и технологии, кстати, могут быть актуальны и в других сферах, например, в ретейле. Ведь помимо перевозок ретейлерам приходится решать и другие задачи, к ним относится, например, своевременная диагностика и обслуживание холодильного оборудования. В этом случае real-time мониторинг позволяет предвидеть отказы холодильного оборудования и улучшить контроль их рабочих параметров.

Бизнес и анализ информации: перспективы направления

Задачи по аналитической обработке данных исторически сводились к анализу бизнес‑драйверов. В последние годы потребность в анализе меняется – предприятия анализируют информацию не только с целью отражения производительности своего бизнеса, но и с целью выявления новых стратегий развития. Бизнес становится ориентированным на данные, а бизнес-операции все больше начинают зависеть от грамотной аналитики.

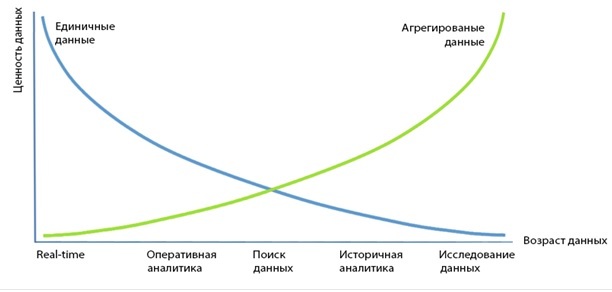

Кривые, отражающие ценность данных во времени, показывают максимальный интерес к данным на своих границах (см. рис. 1).

Рис. 1.

Бизнес находит для себя все новые источники информации, а совокупный объем обрабатываемых данных растет. Сами данные меняются, становясь более неоднородными и вариативными.

Привычные подходы к обработке информации перестают работать. Все чаще возникают технические барьеры, не позволяющие удовлетворить потребности компаний, которые не получают вовремя, или даже полностью лишаются важной информации, и это негативно отражается на их конкурентоспособности.

Необходима своевременная качественная трансформация IT-архитектуры, которая позволит оперировать данными предприятия по всей их глубине, охватывая бизнес целиком. На примере наших проектов и запросов со стороны клиентов из различных отраслей, могу отметить, что технологии больших данных являются наиболее удобными инструментами для достижения этих целей. Они способны обеспечить комплексный подход к обработке разнородных данных на протяжении всего их жизненного цикла, позволяя не просто оперировать полученной информацией, но и превращать ее в актив в борьбе за конкурентные преимущества.

Способы передачи финансовых данных #2: протокол FAST

В одном из прошлых топиков мы рассмотрели протокол FIX, который был создан для передачи финансовой информации и автоматизации коммуникаций на фондовом рынке. Однако этот протокол оказался не самым идеальным инструментом в условиях все увеличивающихся объёмов финансовых данных, поэтому в качестве его развития был создан новый стандарт — протокол FAST (FIX Adapted for STreaming). Сегодня мы поговорим об этой технологии.

История

В ноябре 2004 года тогдашний CEO финансового холдинга Acrhipelago Holding Майк Кормак на конференции сообщества FIX под названием FPL (FIX Protocol Limited) в Нью-Йорке заявил о том, что текущая версия протокола не справляется с возросшим объёмом финансовой информации, генерируемой на фондовом рынке. При передачи больших объёмов данных с помощью FIX возникали значительные задержки в их обработке, что приносило трейдерам убытки и лишало их возможности разработки действующих торговых стратегий.

Классический формат передачи сообщений Tag=Value, использовавшийся в FIX, оказался слишком громоздким для его быстрой обработки. Вскоре после этого выступления, были сделаны первые шаги к исправлению ситуации.

При создании протокола FAST разработчики преследовали цель добиться возможности передачи больших объёмов данных, избегая появления задержек в получении информации. Разработкой протокола занималась рабочая группа сообщества FIX под названием «Группа оптимизации передачи рыночных данных» (Market Data optimization working group — mdowg), которая была сформирована в 2004 году.

В 2005 году эксперты группы представили пилотный проект (proof of concept) протокола, а уже через год был осуществлен релиз первой версии FAST 1.0. В дальнейшем было выпущено несколько обновлений, и в настоящий момент большинством игроков финансового рынка используется версия протокола 1.2. Также существует несколько открытых реализаций протокола (например, OpenFAST, OpenFAST.NET и QuickFAST).

Как это работает

Согласно стандарту FIX-протокола каждое сообщение имеет формат Tag = Value SOH, где Tag — это номер передаваемого поля, Value — его значение, а SOH — символ-разделитель (подробнее — в нашем прошлом материале). Пример записи сообщения в синтаксисе Tag = Value:

35=x|268=3 (message header) 279=0|269=2|270=9462.50|271=5|48=800123|22=8 (trade) 279=0|269=0|270=9462.00|27

Протокол FAST позволяет избавиться от избыточности с помощью шаблона, который описывает структуру сообщения целиком. Этот метод называется «неявным тегированием» (implicit tagging), поскольку теги FIX в передаваемых данных только «подразумеваются». Итого, синтаксис Tag = Value меняется следующим образом:

На каких биржевых площадках есть FAST

Протокол FAST поддерживается целым рядом крупнейших мировых фондовых площадок, среди которых:

Реализация «Московской Биржи»

«Московская Биржа» реализовала возможность предоставления доступа к финансовой информации по протоколу FAST. Трейдеры могут получать по FAST таблицы финансовых инструментов (цены, объёмы торгов и т.п.), котировки, все сделки, индексы, а также информацию обо всех активных обезличенных заявках. Согласно информации на сайте Биржи, средняя задержка публикации обновлений составляет менее 300 микросекунд (для фондового и валютного рынков).

Для передачи финансовых данных используются UDP-каналы, а по TCP передаются наборы недоставленных данных. Данные структурированы на группу потоков (каналов или «фидов»), которые содержат в себе информацию о группе финансовых инструментов. Эти инструменты автоматически группируются торговой системой Биржи в соответствии с определенным параметрами.

UDP позволяет сократить задержки при передаче информации, а их дублирование снижает потери сообщений. Если описывать схему более подробно, то сервис FAST состоит из следующих каналов:

Изображение / moex.com (по клику откроется в полном размере)

Все сообщения, отправляемые с торговой системой «Московской биржи» кодируются в формате FAST. Особенностью формата «Московской Биржи» заключается в добавлении к сообщению преамбулы из 4 байт. Эта преамбула содержит тег под номером 34 (SeqNum), который позволяет получать номер последовательности сообщений без необходимости декодирования всего сообщения — это выливается в дополнительную экономию времени на обработку потоков данных.

Как правило, передача шаблона FAST осуществляется с помощью XML. Типичный сценарий использования протокола (подключение до начала торгового дня) можно описать следующей последовательностью действий:

Как подключиться по FAST

ITinvest предоставляет своим клиентам доступ к рынкам «Московской биржи» с помощью прямого подключения по протоколуам FIX и FAST Кроме того, для высокочастотных торговцев и алготрейдеров созданы специальные ИТ-услуги от колокации серверов в дата-центре M1 до предоставления доступа к виртуальным машинам для размещения торгового робота (тарифы указаны на сайте).

Для тех, кто не читал наш предыдущий материал о протоколе FIX снова прикрепляем видео с рассказом о решениях по получению прямого доступа на фондовый рынок.

Другие протоколы

Помимо протоколов FIX и FAST, поддерживаемых международным сообществом, для прямого подключения к отечественным рынкам используются и так называемые нативные протоколы, которые возникли еще до объединения бирж ММВБ и РТС в «Московскую биржу».

На рынках, относившихся к бирже РТС (FORTS – фьючерсы и опционы, Standard), для прямого совершения операций и получения данных в режиме подключения используется протокол Plaza II. Для выполнения торговых операций и получения биржевых данных на площадках, ранее относившихся к бирже ММВБ (валютный и фондовый рынки) используется двунаправленный шлюз MICEXBridge (TEAP).

Об этих протоколах пойдет речь в наших следующих статьях. Кроме того, мы расскажем о протоколе Simple Binary Encoding, который, в определенной степени, является продолжателем дела FIX.

На сегодня все, спасибо за внимание, будем рады ответить на вопросы в комментариях.

P. S. Если вы заметили опечатку или ошибку — напишите личным сообщением, и мы оперативно все исправим.