Eco pc complex solutions что это

Донос в студию: Герман Клименко просил отложить закрытие «пиратских» сайтов, так как сам владеет торрент-трекером

На прошлой неделе Герман Клименко высказался по вопросу преследования «пиратов» на просторах рунета. Когда власти, казалось бы, загнали их в угол, новоиспеченный советник предложил дать им «пожить» хотя бы до конца экономического кризиса.

Он объяснил это тем, что не нужно дополнительно злить рядовых интернет пользователей. Ведь они лишатся бесценных (читай: бесплатных) коллекций фильмов, музыки, книг и прочего нелегально распространяемого контента.

Но теперь, благодаря внимательным «доброжелателям» с обостренным чувством справедливости, Россия узнала любопытные факты, идущие вразрез со светлым образом «борца за развитие интернет инициатив»:

• «Пиратский» торрент-трекер Torrnado.ru рекламируется на заглавной странице Liveinternet;

• Домен Torrnado.ru принадлежит OOO «ECO PC — Complex Solutions», в «СПАРК-Интерфаксе» значится, что ООО «ECO-PC-Комплексные решения» принадлежит Алевтине Якобсон;

• В 2015 Роскомнадзор зарегистрировал в качестве СМИ телеканал Mediametrics, аффилированный с сервисом Mediametrics Германа Клименко;

• Учредителем СМИ Mediametrics выступило ООО «ЕСО РС-Комплексные решения»;

• Владелец 100% фирмы — Алевтина Якобсон;

• По словам Германа Клименко, которого цитирует ресурс Firrma, Якобсон является его «старым сотрудником».

На основании этих фактов «Ведомости», не без подсказки «доброжелателей», делают вывод, что Герман Клименко владеет выше означенным трекером. Torrnado.ru предлагает пользователям нелегальный видеоконтент. Анонимные собеседники «Ведомостей» утверждают, что когда-то после 4 января 2016 года Германом Клименко передал Torrnado своему сыну — Юрию Клименко.

Клименко-старший ушел от прямого ответа на вопрос, принадлежит ли ему ресурс Torrnado.ru, и не стал отвечать на вопросы, связанные с легальностью контента на этом ресурсе. Однако в одном из постов в Facebook он признал, что «никогда не отрицал» своей причастности к Torrnado, пишут «Ведомости».

Естественно, что после назначения советником президента по интернету Герман Клименко привлек внимание общественности. Можно сказать, под увеличительным стеклом вдумчивых «доброжелателей». Ясно, что открылись интересные факты про его бизнес и прошлые заслуги. Выяснилось, что первые большие деньги Клименко заработал на МММ.

Проблема в том, что президент застал его врасплох своим предложением. Видимо, новоиспеченный советник просто не успел замести следы и вступить в ряды государственных чиновников с «кристально чистой» репутацией, переписав все (сомнительные и не очень) бизнесы на родственников и «старых сотрудников». В итоге на него донесли, куда следует, и даже куда не следует.

Инжиниринг производительности систем хранения данных

Всем привет! Каждый день наша большая и дружная команда инженеров решает сложные задачи и вносит вклад в создание высокотехнологичных продуктов — систем обработки и хранения данных. Мы решили познакомить вас с их рутиной поближе, и сегодня начинаем серию интервью с коллегами, чтобы от первого лица рассказать обо всех нюансах их работы.

Производительность — одна из ключевых характеристик качественного программного обеспечения: прочие характеристики систем хранения данных не будут оценены по достоинству, если она работает медленно или нестабильно. Сегодня мы беседуем с Сергеем Качкиным kachini — руководителем отдела технической экспертизы департамента прикладных исследований и технической экспертизы компании YADRO.

У его профессии несколько названий: аналитик производительности, performance engineer, performance tester. И все они достаточно мало распространены в России. Между тем инжиниринг производительности помогает создавать эффективные компьютерные системы, которые работают быстро и надежно. Его задача — изучить, почему система функционирует не так, как хотелось бы, разобраться в причинах медленной или не соответствующей целевым параметрам работы, выявлять и находить проблемные места, помогать их устранять.

Сергей Качкин рассказал о поиске узких мест в программном стеке и оптимизации производительности СХД, о том, чем занимается его команда.

Сергей, как вы пришли в компанию YADRO? Был ли у вас уже опыт работы с OpenPOWER?

До этого я работал у другого вендора, занимался поддержкой проприетарной версией ОС UNIX на IA64 (не путать с x86) процессорах в части производительности ядра. Архитектура EPIC не похожа на RISC, она совсем другая. Так что опыт работы с OpenPOWER в компании YADRO у меня первый, и перестройка заняла какое-то время. Но идея у OpenPOWER, несмотря на некоторый минимализм, та же самая, поэтому всё можно освоить.

Чем занимаются performance–инженеры? Какие методы применяют в работе? Сложно ли вам набирать новых сотрудников?

Основная специализация нашей команды — инжиниринг производительности или performance engineering. Это отдельная дисциплина, нацеленная на то, чтобы убедиться: разрабатываемое решение удовлетворяет нефункциональным требованиям, в частности — производительности. Она включает в себя набор практик, знаний, методов и техник, которые могут применяться на разных этапах разработки программного обеспечения: подготовительном, этапе программирования, тестирования и эксплуатации системы.

В России эта дисциплина не очень распространена, по крайней мере, такое впечатление создается по результатам поиска сотрудников. Однако в мире, это сформировавшееся направление. Эта IT специализация редко связана с непосредственным написанием кода. Мы мало программируем и, собственно, и не умеем делать это так, как профессиональные программисты. При этом требуются специфические навыки, для локализации «горячих точек» в софте, влияющих на нефункциональные требования. С одной стороны, это помогает создавать продукт, удовлетворяющий требованиям, с другой — предотвращать затраты на дальнейшую оптимизацию или переделку.

Как вы обеспечиваете контроль качества и выявление узких мест в стеке программного обеспечения?

Методы можно разделить на два подвида. Первый — это системно-ориентированный подход (system centric approach). Он ориентирован на ресурсы: мы анализируем загрузку отдельных компонентов системы и на основании полученных результатов делаем предположение, где имеется узкое место.

Второй — это подход, ориентированный на приложение (application centric approach), когда объектом исследования становятся приложения целиком или отдельные процессы в Linux. Мы смотрим, что делает приложение, какую работу выполняет. Полезная эта работа, или оно делает что-то бесполезное, то есть попусту тратит время. Если приложение в состоянии ожидания, мы смотрим, чего оно ждёт. Обычно это аппаратные или программные ресурсы, механизмы синхронизации.

В реальной жизни приходится переключаться между этими методами. То есть, с одной стороны, мы смотрим на ресурсы: есть ли там какие-то явные проблемы, ошибки. Делаем выводы. Потом смотрим на приложение: как оно себя чувствует. В данном случае приложение — это программный код СХД или иное, что является объектом оптимизации.

Как понять, что СХД работает «на пределе»? Как определить, что запас производительности исчерпан? Какие параметры об этом свидетельствуют? Какие основные метрики используются для оценки производительности СХД?

Обычному пользователю доступно несколько метрик. Основная — это время отклика. Важно его абсолютное значение. Кроме времени отклика важна также пропускная способность. Если с ростом нагрузки время отклика начинает расти, при этом показатели IOPS и объем передаваемых данных не увеличиваются, то это означает, что какой-то ресурс СХД близок к насыщению. Как известно, система хранения работает настолько быстро, насколько быстро может функционировать ее самый медленный ресурс.

При этом разные приложения могут быть критичны либо ко времени отклика, либо к пропускной способности. Например, если мы говорим о базе данных, то обычно это произвольный доступ мелкими блоками, много чтения, и ей важны производительность в IOPS и минимальное время отклика. Для других нагрузок типа потоковых при бэкапах, записи с видеокамер или интернета вещей важнее пропускная способность, возможность записать большой поток данных.

Оптимизируется ли система хранения под конкретную задачу, или создается как универсальное решение?

Уже долгое время системы хранения, по крайней мере общего назначения, универсальны. Они не «затачиваются» под какую-то конкретную нагрузку и стараются «угодить» наиболее распространенным приложениям. Ведь примерно известно, какой профиль нагрузки у базы данных, системы резервного копирования, видеонаблюдения и так далее. Система хранения должна адекватно реагировать на такие нагрузки без каких-либо дополнительных настроек.

Поэтому системы хранения общего назначения изначально проектируются так, чтобы удовлетворить наиболее типовым задачам. Для этого применяются синтетические тесты c набором «критичных» профилей, моделирующих реальную ситуацию. В большинстве случаев работает, но реальность всегда гораздо сложнее.

Реальные нагрузки моделируются синтетикой весьма приблизительно. Это вообще наукоемкая область, потому что кроме IOPS, пропускной способности, размера блока и соотношения операций чтения и записи у нагрузки гораздо больше характеристик. Это и локализация пятна данных на диске, наличие «горячих областей», распределение запросов во времени, и равномерность их поступления. Поэтому есть вероятность, что конкретная нагрузка не попадёт ни в один из профилей. Может быть из-за особенностей программного обеспечения или специфики самой бизнес-задачи. В этом случае нужна настройка системы под конкретные задачи.

Исследуют приложение, как оно работает. И может потребоваться изменить либо работу приложения, либо настройки системы хранения. Иногда гораздо проще решить проблемы на стороне приложения с помощью какой какой-то настройки, чем заниматься изменением СХД.

А настраивается под задачу система автоматически? Нужны ли для этого искусственный интеллект? Может ли администратор или пользователь сам выбирать профиль нагрузки?

Системы хранения уже давно делают это автоматически — администратора такой задачей не загружают. Обычно стараются достигать этого без использования искусственного интеллекта —традиционными алгоритмами. Однако у ИИ большой потенциал. Если он позволит предсказывать, какие блоки данных и в какой момент времени может запросить приложение, то можно заранее к этому готовиться.

Если раньше алгоритмы оптимизации были достаточно простыми, типа упреждающего чтения, то есть при последовательном чтении данных система заранее загружала данные в кэш, или наоборот освобождала кэш-память для других данных, то теперь возможности расширяются: система сможет подготовиться к пику запросов или сложно организованному «пятну горячих данных».

Каковы должны быть масштабы оптимизации СХД? Охватывает ли она также ПО/оборудование серверов, инфраструктуру (SAN)? Предполагает ли обязательную тесную интеграцию программного и аппаратного стеков?

С точки зрения performance engineering система рассматривается целиком, в комплексе, то есть приложение, хост (сервер), инфраструктура хранения данных, (SAN), СХД. Важно представлять, как работает приложение, потому что именно оно генерирует запросы к СХД. Всё это, конечно, учитывается и используется.

Считается, что самый оптимальный вариант использования накопителей разных типов в СХД — многоуровневое хранение данных. Можно ли тиринг рассматривать как средство увеличения производительности системы хранения?

Вообще говоря, тиринг похож на кэширование — у них есть общие элементы. Разница лишь в том, что при кэшировании данные дублируются, то есть они находятся и на SSD (в кэше), и на диске, а при тиринге хранятся только в одном месте. То есть, если кэширование — это способ оптимизации производительности, то и тиринг тоже можно рассматривать как метод оптимизации.

В чем вы видите преимущества/недостатки программно-определяемых СХД (SDS) с точки зрения анализа производительности и оптимизации системы? Может быть, это более простые, более гибкие решения?

На самом деле, как раз наоборот. SDS — это распределенная система, состоящая из множества серверов, которые взаимодействуют между собой. Если используются специальные операционные системы, какие-то файловые системы, то это тоже добавляет сложности. С точки зрения инжиниринга это сложнее, но в чем-то интереснее. С другой стороны, к SDS обычно не применяются какие-то жесткие требования по производительности, в то время как к классическим системам хранения подход более строгий. То, что прощается программно-конфигурируемым системам, традиционной СХД не простят.

Одна из целей компании — разработка оптимизированных продуктов для искусственного интеллекта, интернета вещей и сетей пятого поколения. Как вы считаете, насколько сложная это задача? Что будут представлять собой такие продукты?

На данный момент для хранения сырых данных в ИИ часто используют файловые хранилища, для тренинга и построения моделей — SDS, то есть это почти всегда распределенные решения. По моему ощущению, во многих компаниях ИИ сейчас используется как некий эксперимент, на него смотрят и пытаются понять, чем он может быть полезен. Поэтому и требования к железу не очень жесткие. Если работает — хорошо, не работает — можно подождать день-другой. По мере того, как работа ИИ в компаниях будет более критичной, возрастут и требования к дисковым подсистемам. Мы увидим новые СХД решения для ИИ и интернета вещей уже mission critical-класса.

Какую роль в оптимизации ПО играет партнерство YADRO с мировыми технологическими компаниями?

С точки зрения технического специалиста оно, конечно, помогает. Такое сотрудничество способствует общению инженеров друг с другом, их доступу к информации, готовым разработкам, и не приходится каждый раз «изобретать велосипед».

Как вам видится роль виртуализации в СХД? Способствует ли она устранению узких мест в ПО или наоборот? И как взаимосвязаны производительность и надежность системы? Можно ли сохранить надежность, увеличивая производительность?

Конечно, виртуализация добавляет сложности, но она может быть полезна для изоляции одной функциональности СХД от другой. В целом это дополнительные издержки и усложнения, поэтому рассматривать ее следует критически, с осторожностью.

Что касается увеличения производительности, то на этом пути, в самом деле, легко потерять надежность. Это своего рода дуализм. Например, когда мы говорим о серверах, то для высокопроизводительного сервера (HPC) надежность обычно на втором месте. Системы хранения, как правило, должны в первую очередь обеспечивать высокую доступность, обладать соответствующей функциональностью и приемлемой производительностью. При увеличении надежности уровня резервирования, система становится сложнее. Возникает необходимость синхронизации элементов. При этом производительность системы неизбежно будет страдать. Задача разработки, свести этот эффект к минимуму.

Сейчас появляются новые классы памяти типа Storage Class Memory, Persistent Memory, совершенствуются флэш-накопители. Как это влияет на архитектуру систем? Успевает ли программное обеспечение за этими изменениями?

Ну, по крайней мере, старается. Вообще, появление быстрой памяти в значительной степени изменило работу performance-инженеров вообще в отрасли. До появления SSD подавляющее большинство проблем с производительностью ИТ систем были связаны с вводом-выводом систем хранения. Потому что есть быстрые процессоры и диски (HDD) с механическими элементами, которые на много порядков медленнее процессора. Поэтому приходилось за счёт алгоритмов пытаться сгладить задержки от медленных дисков.

С появлением быстрой памяти и алгоритмы должны меняться. Если алгоритм достаточно тяжёлый, раньше он всё равно помогал, потому что диск намного медленнее. Если удалось скрыть задержки механики – уже хорошо. С появлением SSD софт должен работать иначе. Он должен вносить минимальную задержку, чтобы получить от SSD максимум скорости. То есть снизилась необходимость в сложных алгоритмах, скрывающих задержки от дисков. Особо критичную к времени отклика базу данных с интенсивным вводом-выводом можно перенести на SSD.

Поменяет ли это архитектуру системы хранения? И да, и нет. Потому что никуда не делись диски. С одной стороны, код должен уметь работать с SSD, то есть быть очень быстрым. С другой, механические диски используются для нагрузок, которые они хорошо выдерживают, типа потоковых. При этом размер дисков многократно вырос, а скорость осталась, как и 10 лет назад.

Eco pc complex solutions что это

Современная ИТ-индустрия состоит в сложных взаимоотношениях с сообществом разработчиков Open Source, посредником в этих отношениях выступают различные альянсы, фонды и другие организации, занимающиеся стандартизацией открытых технологий.

Привет, я Аня, отвечаю за международные технологические партнерства и альянсы.

В этой статье расскажу, что такое технологический альянс, какие альянсы наиболее значимы и интересны в мире ИТ-разработки, чем они занимаются на глобальном уровне и какая в этом может быть польза для участников и всей индустрии в целом. Еще расскажу про то, в каких альянсах участвуем мы.

Портал инженерной культуры

Привет, меня зовут Полина Максимчук, я руковожу департаментом прикладных исследований и технической экспертизы в YADRO. Сегодня мы запустили научно-популярный образовательный портал Истовый инженер, где будем публиковать материалы о технологиях, которые влияют на повседневность, меняют ход истории, формируют современное общество, ну и конечно, прикладных сторонах их разработки.

Кто и о чем будет рассказывать?

Наши авторы — инженеры, ученые и исследователи из ведущих российских и мировых компаний. Сейчас на портале выложены статьи и лекции Дэвида Паттерсона, коллег из Wargaming, S7, IVI, Яндекса, РАН, Сколково и многих других.

Они рассказывают, как промышленные дизайнеры определяют нашу реальность, как выглядит современное полупроводниковое производство, как создавались и эволюционировали высоконагруженные распределенные платформы крупнейших российских компаний, как со спутниковой связью работают частные космические компании, и чем космическая бортовая микроэлектроника отличается от наземных аналогов.

А в ближайшее время мы опубликуем материалы нового блока про нейроморфные вычисления.

Кто такой DocOps-инженер

Привет! Меня зовут Наталья и я DocOps-инженер в компании Yadro.

Я планирую выпустить цикл статей об этой профессии на примере Yadro. Первая статья носит обзорный характер, последующие будут более техническими и содержать примеры реальных кейсов, с которыми приходится сталкиваться во время работы.

Немного о себе

Я окончила механико-математический факультет, во время учёбы занималась матмоделированием в области авиастроения, затем семь лет работала инженером по локализации и техническим писателем в Xsolla, потом полтора года в роли руководителя команды автоматизации, и вот я DocOps в компании Yadro.

Инжиниринг производительности систем хранения данных

Всем привет! Каждый день наша большая и дружная команда инженеров решает сложные задачи и вносит вклад в создание высокотехнологичных продуктов — систем обработки и хранения данных. Мы решили познакомить вас с их рутиной поближе, и сегодня начинаем серию интервью с коллегами, чтобы от первого лица рассказать обо всех нюансах их работы.

Производительность — одна из ключевых характеристик качественного программного обеспечения: прочие характеристики систем хранения данных не будут оценены по достоинству, если она работает медленно или нестабильно. Сегодня мы беседуем с Сергеем Качкиным kachini — руководителем отдела технической экспертизы департамента прикладных исследований и технической экспертизы компании YADRO.

У его профессии несколько названий: аналитик производительности, performance engineer, performance tester. И все они достаточно мало распространены в России. Между тем инжиниринг производительности помогает создавать эффективные компьютерные системы, которые работают быстро и надежно. Его задача — изучить, почему система функционирует не так, как хотелось бы, разобраться в причинах медленной или не соответствующей целевым параметрам работы, выявлять и находить проблемные места, помогать их устранять.

Сергей Качкин рассказал о поиске узких мест в программном стеке и оптимизации производительности СХД, о том, чем занимается его команда.

Тюнинг переходных отверстий печатных плат

Давайте поговорим про проектирование переходных отверстий — для серьёзной электроники их качество очень важно. В начале статьи я осветил факторы, влияющие на целостность сигнала, а потом показал примеры расчёта и тюнинга импеданса одиночных и дифференциальных переходных отверстий.

Коды Рида-Соломона. Часть 2 — арифметика полей Галуа

Здравствуйте, друзья! В прошлый раз мы с вами начали говорить о том, как коды Рида-Соломона помогают обеспечивать необходимый уровень надежности хранения данных. Сегодня остановимся немного подробнее на арифметике полей Галуа, которая используется в расчётах.

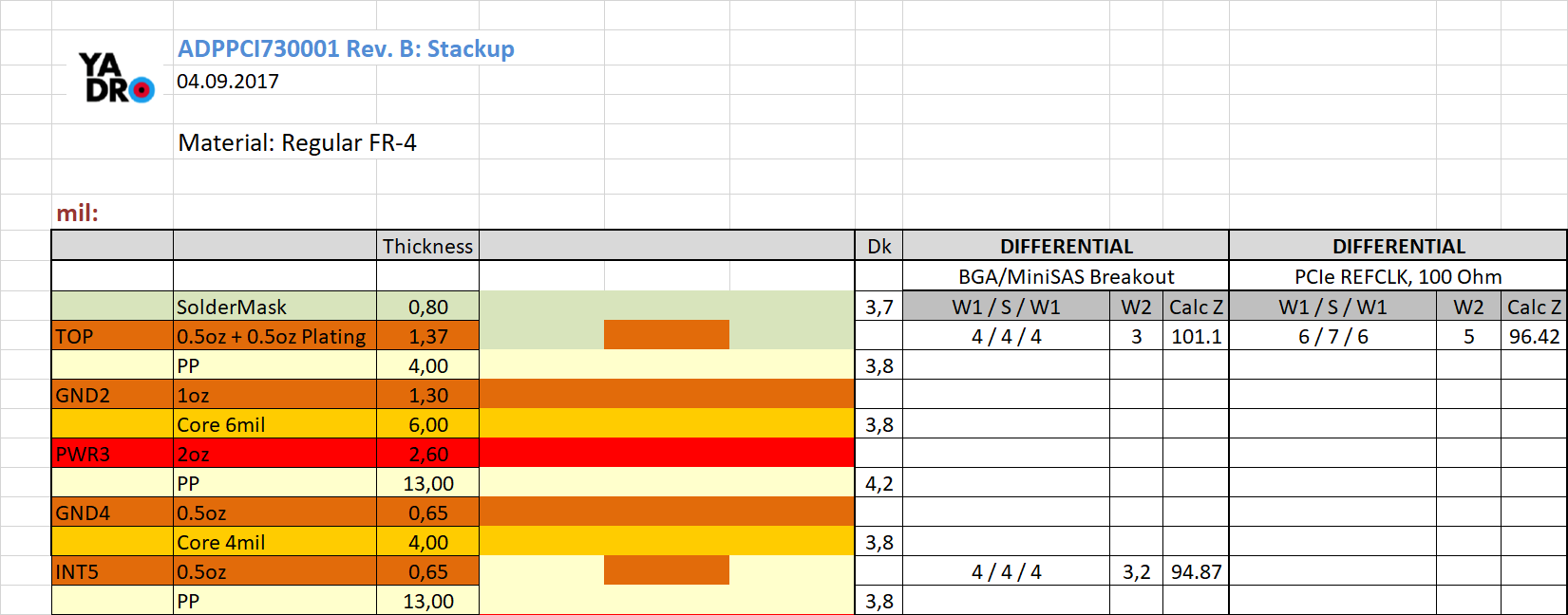

Наша методика расчета стека печатных плат

Пока мы заканчиваем последние приготовления к серийному выпуску сервера VESNIN, хочу провести образовательный эксперимент — опишу наши внутренние методики и рекомендации для расчёта стека печатных плат. С одной стороны, приятно, если наш опыт будет кому-то полезен. С другой, мы сами рады получить дельные комментарии, чтобы улучшить нашу практику. Если интересно прочитать и обсудить — добро пожаловать под кат.

Тестирование на фабрике: «Чёрный ящик» и короткий цикл тестирования

Всем привет, меня зовут Александр, и я занимаюсь QA (обеспечением контроля качества) разрабатываемой нами продукции. Наши контрагенты-фабы в юго-восточной Азии, особенно китайцы — ребята резкие, шустрые, и готовы сделать много, быстро, но вот с качеством выходит не всегда. Как мы с этим боремся, попутно экономя деньги компании — написано под катом.

Коды Рида-Соломона. Часть 1 — теория простым языком

Добрый день! Меня зовут Максим, в YADRO, кроме всего прочего, я занимаюсь разработкой подсистемы, отвечающей за надежное хранение данных. Готовлю небольшой цикл статей про коды Рида-Соломона — теоретическую основу, практическую реализацию, применяемые на практике программные и аппаратные оптимизации. На Хабре и в остальной сети есть хорошие статьи по вопросам этой области — но по ним сложно разобраться, если ты новичок в теме. В этой статье я попытаюсь дать понятное введение в коды Рида-Соломона, а в следующих выпусках напишу, как все это запрограммировать.

Несколько слов о тестировании сложных аппаратных комплексов

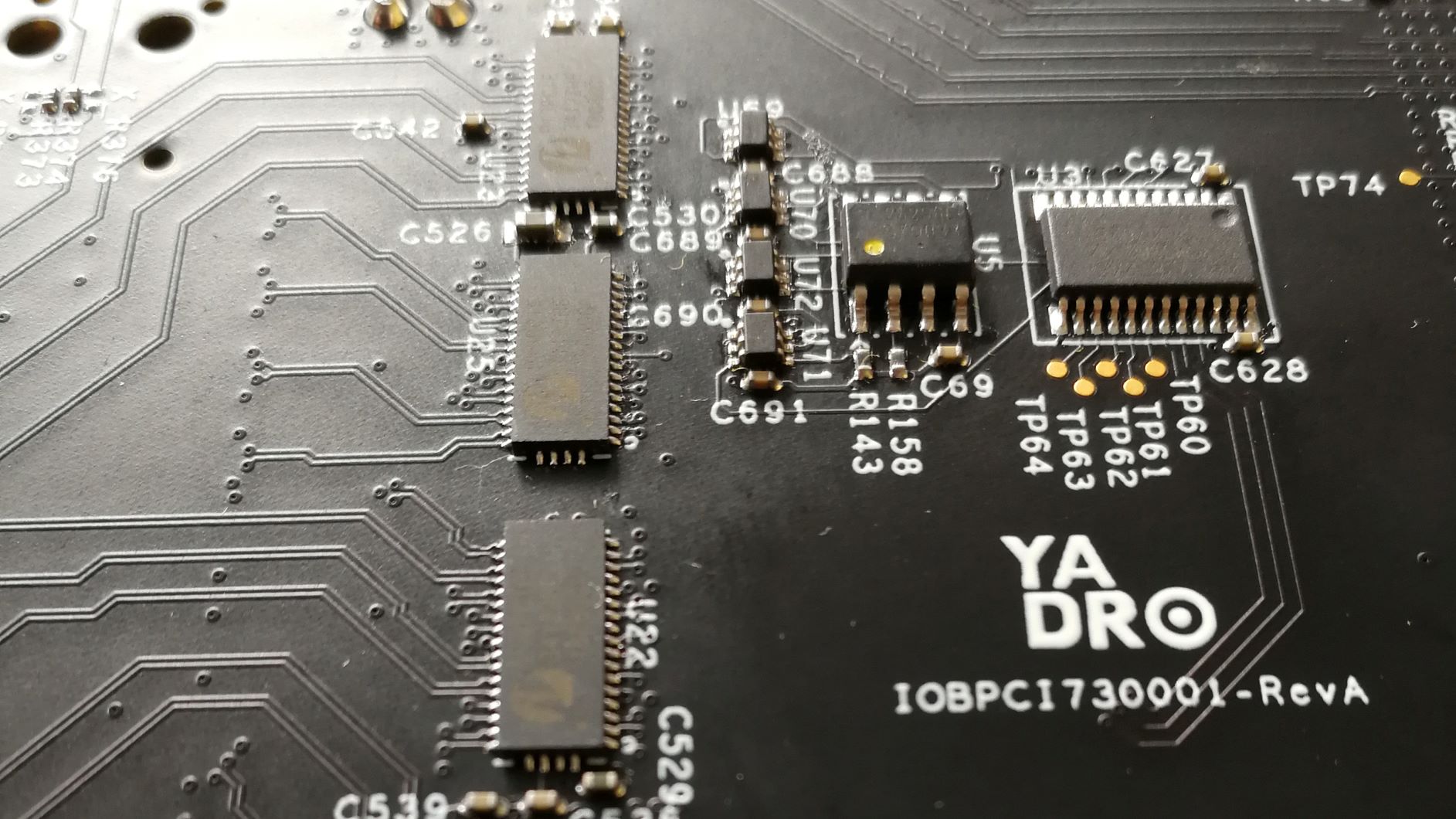

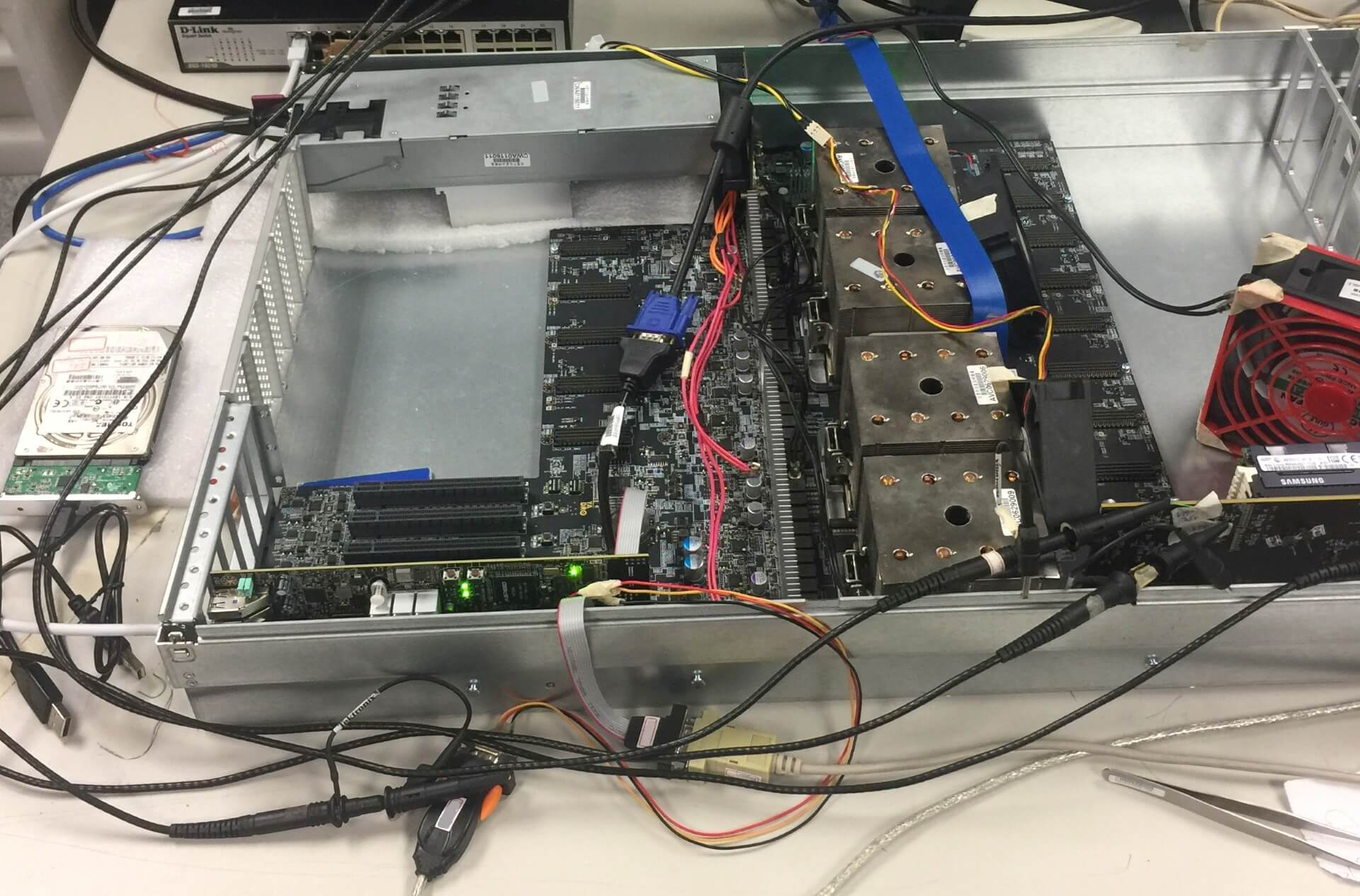

Привет. Сегодня я хочу поговорить с вами о тестировании железа — с болезненными примерами и фотографиями из обыденной практики. Эту суровую реальность с пайкой, дебагом и сожженными чипами обычно все беспощадно лакируют, рассказывая только об успехах — ответственные за пиар и маркетинг люди обычно как огня боятся любых упоминаний об ошибках и сбоях. Но инженеры понимают, что сложные комплексы сразу безупречными не рождаются, поэтому мы не боимся рассказать вам про тестирование как есть. Ну и поделиться опытом, что делать, а чего избегать.

Сервер VESNIN: первые тесты дисковой подсистемы

Отлаживая экземпляр сервера первой ревизии, мы частично протестировали скорость работы подсистемы ввода-вывода. Кроме цифр с результатами тестов, в статье я постарался отразить наблюдения, которые могут быть полезны инженерам при проектировании и настройке ввода-вывода приложений.

Ревизия #1. Ключ на старт

Довольно долго от нас не было вестей — превращали схемы и чертежи сервера в реальное железо. Теперь у нас появилась рабочая первая ревизия, и в преддверии майских праздников можно порадовать вас рассказом, чем занимались наши разработчики последние полгода. И конечно, показать результат — в этой статье впервые опубликуем фотографии, а не только схемы и модели.

Взгляд изнутри на OpenBMC применительно к системам OpenPOWER

В одной из предыдущих статей Максим затронул аппаратную часть платы BMC (Baseboard Management Controller). Я хочу продолжить повествование и рассказать о нашем подходе к BMC и участии в проекте OpenBMC.

Для полноты истории придётся начать немного издалека и рассказать о назначении сервисных процессоров и роли BMC в работе сервера, затронуть протокол IPMI и программную часть. После этого кратко опишу, как BMC участвует в загрузке систем на POWER8. Закончу обзором проекта OpenBMC и нашим отношением к вопросу. Опытные в теме сервисных процессоров читатели могут сразу отмотать на нижние разделы.

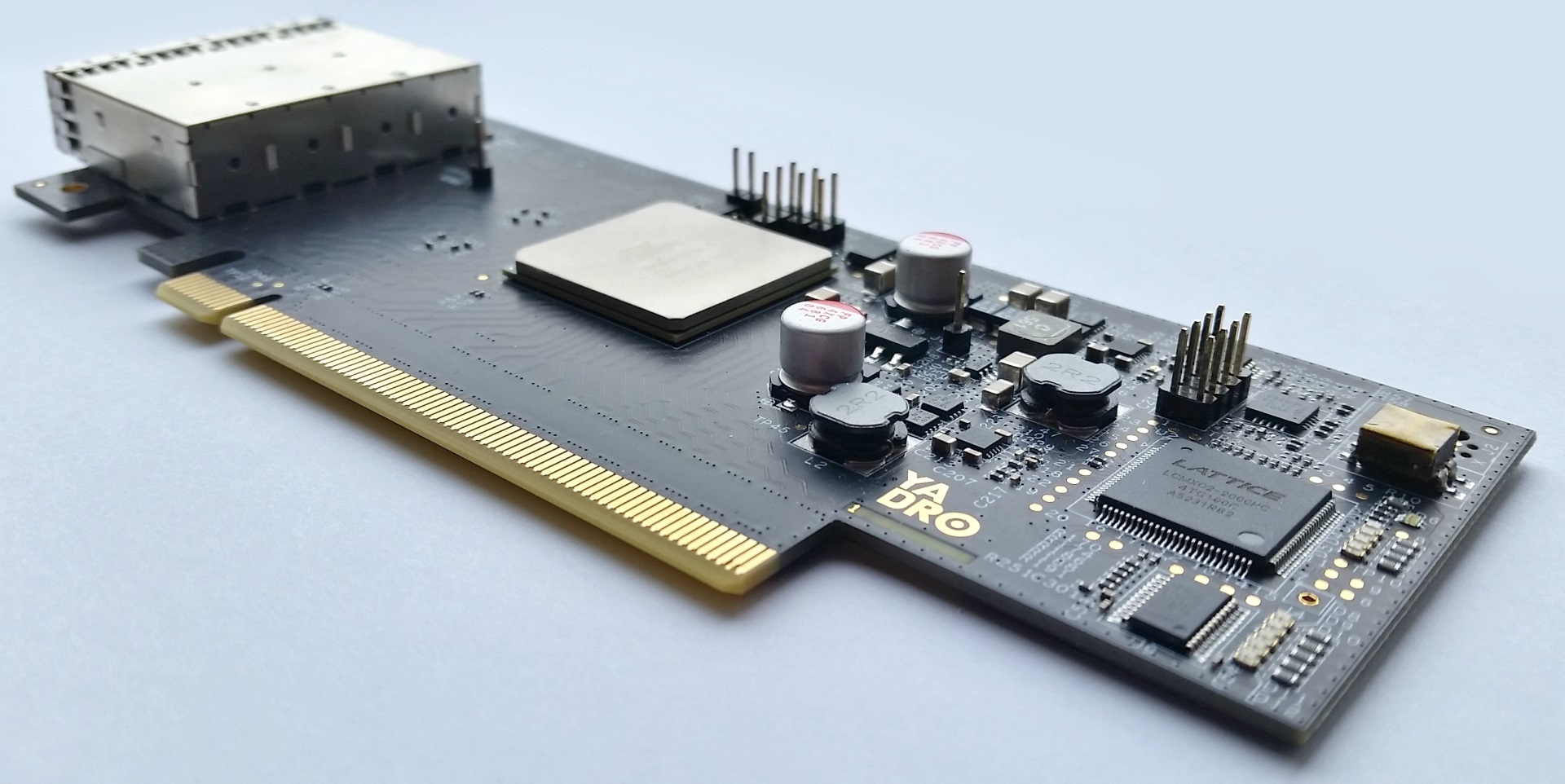

Как подружить PCIe с 10-метровыми медными кабелями и 100-метровой оптикой

Добрый день! Меня зовут Антон. В компании YADRO я занимаюсь хардверной разработкой.

В конце обзорной статьи про историю и развитие PCI Express Алексей упомянул о нашем собственном адаптере для внешнего подключения PCI Express (далее для краткости — PCIe) устройств посредством кабеля. Сегодня я расскажу, как мы его тестировали и отлаживали для правильной работы с разными типами и длинами кабельных соединений.

Плата управления сервером — зачем она и что внутри

PCI Express 4.0, кабели и все-все-все

Раз уж мы затронули немножко в комментариях к предыдущей статье тему расширения PCI Express и вывода шины за пределы шасси, следует наверное рассказать об этом чуть подробнее.

Небольшой дисклеймер – информацию обо всем, о чем говорится ниже, можно найти используя Google. Мы, конечно, про некоторые вещи знаем гораздо больше подробностей, чем можем рассказывать исходя из условий NDA.

О процессе создания сервера – от идеи к деталям

Здравствуйте! Меня зовут Алексей, я руковожу созданием оборудования в компании YADRO – координирую работу всех, кто так или иначе вовлечен в процесс разработки.

В конце прошлой статьи Максим maxf75 немного коснулся особенностей расположения разъёмов памяти. Сегодня я расскажу в целом про то, как мы пришли к тому варианту архитектуры и компоновки, над которыми работаем сейчас.

Вид проектируемого сервера сзади со снятой задней решёткой.

Современное искусство на экране инженера хардверной компании

Всем привет! Меня зовут Максим, я работаю инженером в одной компании. Фирма делает серверы и другое железо на POWER-архитектуре (какое и почему именно такое — позже расскажут другие), а я пока хочу показать участок системной платы сервера — это моя зона ответственности.

Вообще здесь будет нечто вроде рабочего журнала (worklog-а)— вместе с коллегами будем постить рассказы о зарождении жизни в железках. Сначала про сервер, а дальше и про остальное.