Edge устройства что это

Edge-ик в тумане и другие приключения периферийных вычислений

Меня зовут Игорь Хапов. Я руководитель разработки в Научно-техническом центре IBM. И сегодня я хотел бы вам помочь окунуться в мир периферийных вычислений, или edge computing, как его ещё называют. Я расскажу о том, что же такое edge computing и как он может повлиять на наш с вами мир. Также хотелось бы пояснить различия между edge computing и fog computing, какие преимущества даёт этот подход. В статье я также описал референсную архитектуру приложения на edge computing. И под конец немного расскажу о проекте с открытым исходным кодом Open Horizon, который совсем недавно присоединился к Linux Foundation.

Что же такое edge computing

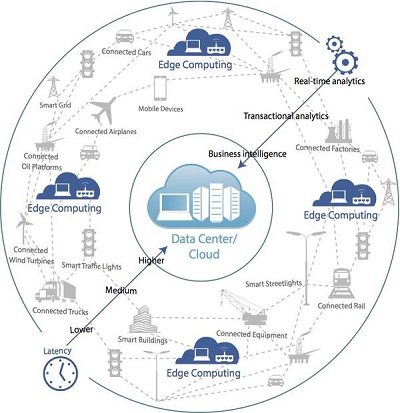

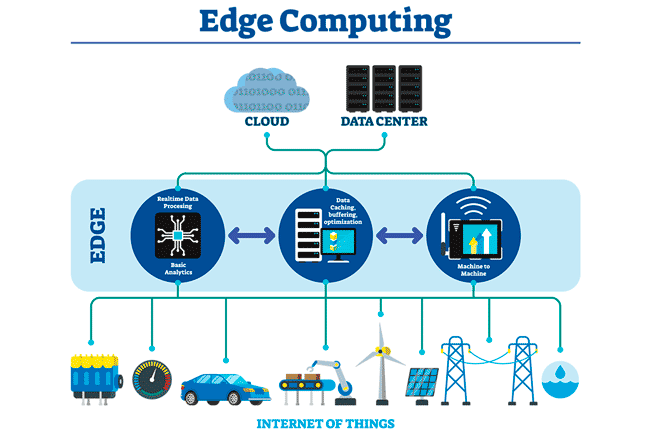

Согласно определению Гартнера, edge computing — это подвид распределенных вычислений, в котором обработка информации происходит в непосредственной близости к месту, где данные были получены и будут потребляться. Это основное отличие edge computing от облачных вычислений, при которых информация собирается и обрабатывается в публичных или частных датацентрах. Основным отличием от локальных вычислений является то, что обычно edge computing — это часть большей системы, которая включает в себя сбор статистики, централизованное управление и удаленное обновление приложений на edge устройствах.

Что же такое edge устройство? Многие считают, что edge computing — это когда приложение работает на Raspberry Pi или других микрокомпьютерах. На самом деле edge computing может быть и на мобильных устройствах, персональных ноутбуках, умных камерах и других устройствах, на которых можно запустить приложение по обработке данных.

Edge computing и IoT

Довольно часто звучит вопрос — «Чем же отличается edge computing от IoT». IoT можно назвать дедушкой edge computing. IoT — это множество устройств, связанных между собой, и способных передавать информацию друг другу. А edge computing это скорее подход к организации вычислений и управлению edge устройствами. Как вы отлично понимаете, любое приложение необходимо обновлять, мониторить и осуществлять прочие обслуживающие функции. В результате edge computing подразумевает использование определенных подходов и фреймворков, о которых я расскажу чуть позже.

edge computing vs fog computing

Когда я однажды рассказал коллеге про edge computing, он ответил — ”так это же fog computing”. Давайте попробуем разобраться, в чём же разница. С одной стороны, edge computing и fog computing часто используются как синонимы, однако fog computing, или «туманные вычисления», все-таки немного отличаются.

И edge computing, и fog computing — это вычисления, которые находятся в непосредственной близости к получаемым данным. Различие заключается в том, что при туманных вычислениях обработка осуществляется на устройствах, которые постоянно подключены к сети. В edge computing вычисления осуществляются как на сенсорах, умных устройствах – без передачи на уровень gateway, так и на уровне gateway и на микрокластерах.

Для меня было открытием, что edge computing может работать в кластерах Kubernetes или OpenShift. Оказывается, что существует достаточно много задач, где кроме оконечных устройств необходимо выполнять обработку информации в локальном кластере и передавать в централизованные дата центры только результирующие данные. И такие вычисления — тоже edge computing.

Преимущества и недостатки edge computing

При выборе технологий для своего проекта я в первую очередь основываюсь на двух критериях — «Что я от этого получу?» и «Какие проблемы я от этого получу?».

Начнём с преимуществ:

Хотя, конечно, проектируя систему с edge computing, не стоит забывать, что как и любую другую технологию её стоит использовать в зависимости от требований к системе, которую вам необходимо реализовать.

Среди недостатков edge computing можно выделить следующие:

С одной стороны, последний пункт является наиболее критичным, но, к счастью, консорциум Linux Foundation Edge (LF EDGE) включает в себя всё больше и больше проектов с открытым исходным кодом, а их зрелость стремительно растет.

Принципы компании IBM при создании платформы edge computing

Компания IBM, являясь одним из лидеров в области гибридных облаков, использует определённые принципы при разработке решений для edge computing:

IBM применяет эти принципы при декомпозиции задачи построения фреймворка edge computing.

Как вы можете видеть, всё решение разбито на 4 сегмента использования:

Помимо основных принципов и подходов, IBM разработала референсную архитектуру для решений, основанных на edge computing. Референсная архитектура — это шаблон, показывающий основные элементы системы и детализированный настолько, чтобы иметь возможность адаптировать его под конкретное решение для заказчика. Давайте рассмотрим такую архитектуру более подробно.

Референсная архитектура edge computing

Edge devices

В первую очередь, у нас есть какое-либо встроенное или дискретное edge-устройство, к которому подключены сенсоры, датчики или управляющие механизмы, например, для координации движения роборуки. Из сервисов/данных на таком устройстве могут находиться:

Hybrid multicloud

Если мы говорим об использовании ML-модели, которая будет запускаться на десятках или тысячах устройств, то нам необходимо облако, которое сможет отвечать за обучение такой модели, обработку статистики, отображение сводной информации (правая часть архитектуры).

Edge server and Edge micro data center

Как мы уже говорили, можно встретить промежуточные (близкие) кластеры обработки данных на уровне шлюзов или микро-датацентров с установленной поддержкой кластерных технологий.

Edge framework

Когда мы осознаем, что есть необходимость в управлении большим количеством сервисов на тысячах устройств и сотнями приложений в разных кластерах, наступает понимание, что надо бы использовать какой-то фреймворк для управления всем этим зоопарком и синхронизации между устройствами.

Именно наличие данного фреймворка раскрывает преимущества edge computing перед разнородными разнесёнными вычислениями.

Как мы видим, кроме центральной части по управлению сервисами и моделями в данном фреймворке присутствуют агенты, обеспечивающие контроль за управлением жизненным циклом сервисов на устройствах/кластерах на каждом из уровней использования.

Open Horizon и IBM Edge Application Manager

Именно для решения задач в области edge computing IBM разработала и выложила в open-source проект Open Horizon. Если вы помните, один из принципов, которые IBM заложила в edge computing – все компоненты должны быть основаны на open source технологиях. В мае 2020 года проект Open Horizon вошел в Linux Foundation Edge — Международный фонд open-source технологий для созданий edge-решений. Также Open Horizon является ядром нового продукта от RedHat и IBM — IBM Edge Application Manager, решения для управления приложениями на всех устройствах edge computing: от Raspberry Pi до промежуточных кластеров обработки данных.

Несмотря на то, что проект Open Horizon вошел в консорциум только в мае, он уже достаточно давно развивается как open-source проект. И мы в Научно-техническом центре IBM не только успели его попробовать, но и довести свое решение до промышленного использования. О том, как мы разрабатывали проект с использованием edge computing, и что у нас получилось — будет отдельная статья, которая выйдет в ближайшие несколько недель.

Сценарии использования

С одной стороны, edge computing framework — это специализированное решение для определённого круга задач, но оно нашло применение во многих индустриях.

В своё время, когда я изучал работу московских камер “Стрелка”, я понял, что это в чистом виде edge computing, с вычислениями «прямо на столбе» и промежуточной обработкой данных в раздельных вычислительных кластерах у различных ведомств.

Сценарии нашлись в финансовом секторе, в продажах при самообслуживании, в медицине и секторе страхования, торговле и конечно при производстве. Именно в создании решения для автоматизации и оценки качества произведённого оборудования, основанного на edge computing, мне с коллегами из Научно-технического центра IBM и посчастливилось принять участие. И на своем опыте попробовать, как создаются решения edge computing.

Если Вас заинтересовала данная тематика, следите за обновлениями в хабраблоге компании IBM и смотрите видео в разделе Ссылки. Наши зарубежные коллеги к настоящему моменту уже осветили многие технические вопросы и описали, какие сценарии уже работают и применяются в различных отраслях.

Edge computing заменит Cloud computing?

Мы с коллегами не так давно обсуждали динамичность развития технологий и перспективы развития облачных вычислений. И как раз наткнулась на статью.

Каждая новая технология приходит на смену старой. Иногда, как и в случае с облаком, проводится ребрендинг старых технологий, чтобы сделать их более привлекательными для потребителей и, тем самым, создать иллюзию нового продукта. Облачные вычисления ранее существовали в той или иной форме. На одном из этапов они назывались «on demand computing» (компьютерные ресурсы по требованию), а затем преобразовались в «application service provider» (ASP).

Теперь существует edge computing (прим. устоявшегося русского термина еще нет, но можно перевести, как «концепция граничных вычислений» или «периферийные вычисления»). которому отраслевые обозреватели и эксперты пророчат способность заменить облако. Но вот вопрос: произойдет ли это на самом деле? Ведь тоже самое говорили о радио, когда было изобретено телевидение. Тем не менее, миллионы людей каждый день включают радиоприемники, но оно изменило формат, теперь его слушают в основном в машине.

Конечно, есть некоторые технологии, которые действительно осуществляют переворот в том, что меняют привычки людей и их образ мышления. Когда-то люди слушали музыку с Sony Walkmans, а сегодня мы повсеместно используем для этого смартфон.

Пророчество Левина

Так почему же люди думают, что edge computing победит облако? Это утверждение было заявлено во многих статьях. Например, Клинт Бултон в марте этого года пишет об этом в статье «edge computing заменит облако». Он ссылается на венчурного капиталиста Эндрю Левина, генерального партнера Andreessen Horowitz, который считает, что больше вычислительных ресурсов будут двигаться в направлении оконечных устройств — таких, как беспилотный автомобиль и дроны, — которые составляют, по меньшей мере, часть Интернета вещей. Левин прогнозирует, что это будет означать то, что облаку пришел конец, т.к. процесс обработки данных будет двигаться назад по направлению к edge computing.

Другими словами, сейчас идет тенденция централизации вычислений в ЦОДах, в то время, как в прошлом они часто были децентрализованы или находились ближе к месту использования. Левин видит беспилотный автомобиль, как центр обработки данных: они имеют более чем 200 процессоров, способных обеспечить полную отказоустойчивость, чтобы не привести к несчастному случаю на дороге. Характер автономных транспортных средств означает, что их вычислительные мощности должны быть независимыми и для того, чтобы обеспечить безопасность нужно свести к минимуму любую связь, которую они имеют с облаком. Тем не менее, они не смогут полностью обойтись без него.

Взаимодополняющие модели

Эти два подхода могут дополнять друг друга. Часть аргументов за edge computing просто отпадает, когда речь заходит об увеличении объемов данных, которые приводят к еще более удручающей и медленной сети. Задержка – виновник. Данных становится все больше: увеличивается количество данных на одну транзакцию, «тяжелые» видео и много данных разных датчиков. Виртуальная и дополненная реальность будет играть все большую роль в его росте. При таком росте объема данных, решить проблемы задержки представляется более сложной задачей, чем это было раньше. Сейчас имеет смысл размещать данные ближе к устройствам типа беспилотного автомобиля для того, чтобы устранить задержку, но тем не менее большая часть данных всё-еще находится удаленно в облаке. Облако по-прежнему будет использоваться в качестве поставщика сервисов, таких как СМИ и развлечения. Оно также может быть использовано для резервного копирования данных и для обмена данными, исходящих от транспортного средства.

Немного отойдем от автономных транспортных средств и вернемся к более привычному бизнесу. Создание ряда небольших ЦОДов или площадок аварийного восстановления может уменьшить эффект масштаба, как следствие, увеличить затраты и сделать работу менее эффективной. Да, задержка может быть уменьшена, но в случае катастрофы последствия будут не менее плачевными; поэтому для обеспечения непрерывности бизнеса некоторые данные следует хранить и обрабатывать в другом месте – в облаке. В случае беспилотных машин, в частности, потому что они должны работать независимо от того, есть сетевое соединение или его нет, имеет смысл, чтобы определенные типы вычислений и анализа были совершены самим транспортным средством. Однако эти данные по-прежнему будут бэкапиться в облако, когда соединение доступно. Подход будет гибридным: edge и cloud computing будут взаимодополнять друг друга, а не использоваться по одиночке.

От периферии до облака

Сейджу Скария, старший директор консалтинговой фирмы TCS, предлагает несколько примеров, где edge computing может оказаться полезным. В своей статье на LinkedIn Pulse, «Edge computing vs. Облачные вычисления: за кем будущее?». Он не считает, что с облаком будет покончено.

«Edge computing не заменит облачные вычисления… на самом деле, аналитическая модель или правила могут быть созданы в облаке и затем применяться оконечными устройствами… и некоторые [из них] способны делать анализ». Затем он продолжает говорить о fog computing (туманные вычисления), которая включает в себя обработку данных от периферии до облака. Он считает, что люди не должны забывать о хранилищах данных, так как они используется для «медленных аналитических запросов и массивного хранения данных».

Edge победит облако

Несмотря на этот аргумент, аналитик компании Gartner Томас Битман считает, что «Edge computing «съест» облако». «Сегодня облачные вычисления пожирают центры обработки данных предприятий, все больше и больше нагрузок приходится на облако, а некоторые преобразовываются и перемещаются в облако… но есть еще одна тенденция, которая переместит рабочие нагрузки, данные и стоимость бизнеса далеко от облака… И тенденция перехода к edge computing еще более важная и сильная, чем когда-то была тенденция облачных вычислений.

Позже в своем блоге Битман пишет: «Не хватает одной только быстроты облачных решений. Массивная централизация, экономия от масштаба, самообслуживание и полная автоматизации преодолевает только полпути — но все это не преодолеет физику — вес данных, скорость света. Как люди должны взаимодействовать с цифровой реальностью в режиме реального времени, если происходит задержка от центра обработки данных, расположенного за тысячи километров. Задержка имеет большое значение. Я существую здесь и прямо сейчас. Воспроизвести правильную рекламу, прежде чем я не отвернулся, указать на магазин, который я ищу, когда я за рулём, помочь моему беспилотному автомобилю выбрать верный путь через оживленный перекресток. И все это мне нужно получить СЕЙЧАС».

Ускорение данных

Битман делает некоторые справедливые замечания, но он употребляет аргумент, который часто используется в отношении задержек и ЦОДов: они должны быть расположены близко друг к другу. Истина заключается в том, что глобальные сети всегда будут фундаментом edge computing и облачных вычислений. Во-вторых, Битману явно не попадались инструменты ускорения данных, такие, как PORTrockIT и WANrockIT. В то время как физика, безусловно, является ограничивающим и сложным фактором, который всегда будет иметь место в сетях всех видов – включая WANs, сегодня можно разместить свои центры обработки данных на расстоянии друг от друга. Задержка может быть уменьшена, и его воздействие может быть нивелировано, независимо от того, где происходит обработка данных, и независимо от того, где хранятся данные.

Поэтому, edge computing это не новое прорывное решение. Это лишь одно из решений, как и облако. Вместе эти две технологии могут поддержать друг друга. Различие между edge computing и облачными вычислениями, в том, что «edge являются методом ускорения и повышения производительности облачных вычислений для мобильных пользователей». Таким образом, аргумент, что edge computing заменит облачные вычисления является очень неубедительным. По маркетинговым соображениям, облачные вычисления могут быть переименованы, но суть останется та же.

Недавно мы писали о том, как нефтегазовая отрасль использует IoT для размещения сотен и тысяч датчиков на своих объектах. При таком количестве входных данных, которые передают все эти многочисленные IoT устройства, уже нецелесообразно передавать данные в облако или общий ЦоД для обработки: какие-то механизмы анализа и реагирования на данные с IoT можно реализовать локально, в месте где эта телеметрия снимается, и собственно данные производятся. То есть, под термином «Edge Computing» или «Граничные вычисления» подразумевается не какая-то физическая граница, не какая-то абстрактная типа «передовой край технологий», а то, что все действия происходят «где-то там, на земле», а не в локальном ЦОДе и не в облаке.

К типичным примерам граничных вычислений относятся:

То есть то, что долго/дорого/бессмысленно передавать куда-то, загружая каналы связи в то время, когда приложение работает «в реальном времени». Кроме того, в определённом смысле локальная обработка данных экономит средства за счёт сокращения объёмов данных, передаваемых и хранимых в облачном расположении. Концепция Edge computing появилась благодаря экспоненциальному росту устройств IoT, которые подключаются к интернету либо для получения информации из облака, либо для доставки данных обратно в облако. И многие устройства Интернета вещей генерируют огромные объемы данных в ходе своей работы, которые по своей сути остаются ненужными после их обработки.

Подумайте об устройствах, которые следят за производственным оборудованием на заводе, или подключенной к интернету видеокамере, которая отправляет видеозапись в реальном времени из удаленного офиса. В то время как одно устройство, производящее данные, может передавать их по сети довольно легко, с ростом числа таких устройств уже возникают проблмы с задержками. Вместо одной видеокамеры, передающей живые кадры, умножьте их на сотни или тысячи устройств. Не только качество пострадает из-за задержки, но и затраты на пропускную способность могут быть огромными.

Периферийное вычислительное оборудование и службы помогают решить эту проблему, являясь локальным источником обработки и хранения данных для многих из этих систем. Пограничный шлюз, например, может обрабатывать данные с пограничного устройства,а затем отправлять только нужные данные обратно через облако, уменьшая потребность в пропускной способности каналов связи. Или он может отправлять данные обратно на пограничное устройство в случае потребностей приложения, работающего в реальном времени.

Что относится к устройствам Edge

Вообще, здесь нет ничего нового: с точки зрения «железа» оборудование для Edge Computing больше напоминает олдскульное железо, созданное до эпохи виртуализации и перехода в облака. К устройствам «Edge» могут относиться и смартфон, и ноутбук, и датчики IoT и настольный сервер, и микроволновая печь. Естественно, если у вас есть пограничный ноутбук, то у вас должен быть и пограничный сетевой шлюз, с помощью которого осуществляется связь локальной сети объекта с облаком и централизованным дата-центром. Как несложно догадаться, это обычный себе сетевой шлюз, скорее всего с интегрированным контроллером управления точками доступа Wi-Fi.

Чем отличается Edge-оборудование?

То есть, Edge-оборудование отличает:

Ярким примером Edge-сервера можно считать Lenovo ThinkSystem SE350:

Практически, современные процессоры стали настолько мощными, что на Edge Computing можно выносить не только складской учёт, но и бухгалтерию, создание отчётов, обработку телеметрии и даже задачи машинного обучения на готовых моделях, или там, где использование GPU нецелесообразно.

Для многих компаний использование облака нецелесообразно из-за высоких затрат на каналы данных. Все чаще самым большим преимуществом Edge Computing является возможность обрабатывать и хранить данные быстрее, чем в облаке, что позволяет создавать более эффективные приложения в реальном времени.

Когда-то давно смартфон, сканирующий лицо человека, должен был бы запустить алгоритм распознавания лиц через облачную службу, что заняло бы много времени. С помощью модели граничных вычислений алгоритм может работать локально на пограничном сервере или шлюзе или даже в самом смартфоне, учитывая растущую мощность смартфонов. Такие приложения, как виртуальная и дополненная реальность, самоуправляемые автомобили, умные города и даже системы автоматизации зданий, требуют быстрой обработки и реагирования.

Такие компании, как NVIDIA, признали необходимость большей обработки «на земле», поэтому мы видим новые системные модули, которые включают в себя функции искусственного интеллекта. Последний модуль компании Jetson Xavier NX, например, меньше, чем кредитная карта, и может быть встроен в более мелкие устройства, такие как дроны, роботы и медицинские устройства. Алгоритмы искусственного интеллекта требуют больших вычислительных мощностей, поэтому большинство из них работают через облачные сервисы.

Конфиденциальность и безопасность

Однако, как и в случае со многими новыми технологиями, решение одной проблемы может привести к возникновению других. По мере роста числа устройств IoT крайне важно понимать потенциальные проблемы безопасности вокруг этих устройств и чтобы убедиться, что эти системы могут быть защищены. Это включает в себя проверку того, что данные зашифрованы, и что используются правильные методы контроля доступа и даже туннелирование VPN.

А как насчет 5G?

По всему миру операторы развертывают беспроводные технологии 5G, которые обещают преимущества высокой пропускной способности и низкой задержки для приложений. Вместо того, чтобы просто предлагать более быстрые скорости и говорить компаниям продолжать обработку данных в облаке, многие операторы связи разрабатывают стратегии пограничных вычислений в своих развертываниях 5G, чтобы обеспечить более быструю обработку данных на объектах режиме реального времени, что особенно важно для мобильных устройств, автомобилей и роботов.

Очевидно, что в то время как первоначальная цель edge computing заключалась в снижении затрат на пропускную способность для устройств IoT на больших расстояниях, рост приложений реального времени, требующих локальной обработки и хранения данных, будет стимулировать развитие технологии в ближайшие годы.

Технология EDGE: что это и зачем это нужно?

Минувший конгресс 3GSM World Congress, а вслед за ним и выставка CeBIT 2006 в Ганновере принесли с собой массу анонсов новых сотовых телефонов с поддержкой технологии EDGE (Enhanced Data for Global Evolution или, как еще иногда можно услышать, Enhanced Data rates for GSM Evolution). Это не случайно хотя вендоры мобильных телефонов уделяют все больше внимания поддержке стандартов третьего поколения (3G), таких как CDMA2000 1x, W-CDMA и UMTS, развитие 3G-сетей идет крайне медленно, а интерес к сетям второго поколения (2G) и второго с половиной (2,5G) не ослабевает, а, наоборот, растет, причем как на рынках развивающихся стран, так и на рынках развитых стран.

Эволюция стандартов сотовой связи

Во имя «пропедевтики без кровопролития» вернусь немного в историю и расскажу о том, какие поколения стандартов сотовой связи известны сейчас науке. Те же из вас, кто уже знаком с этим вопросом, могут сразу перейти к следующему разделу, посвященному непосредственно технологии EDGE.

iТак, стандарты первого поколения сотовой связи (1G), NMT-450 (разработан в 1978, внедрен в эксплуатацию в 1981 году) и AMPS (внедрен в 1983 году), были аналоговыми: низкочастотный голос человека передавался на высокочастотной несущей (

450 МГц в случае NMT и 820-890 МГц в случае AMPS) с применением схемы амплитудно-частотной модуляции. Для того, чтобы обеспечить связь одновременно нескольких человек, в стандарте AMPS, например, частотные диапазоны разбивались на каналы шириной 30 кГц такой подход получил название FDMA (Frequency Division Multiple Access). Стандарты первого поколения создавались для и обеспечивали исключительно голосовую связь.

Стандарты второго поколения (2G), такие как GSM (global system for mobile communications) и CDMA (Code Division Mutiple Access), принесли с собой сразу несколько нововведений. Кроме частотного разделения каналов связи FDMA, голос человека теперь проходил оцифровку (кодирование), то есть, по каналу связи, как и в 1G-стандарте, передавалась модулированная несущая частота, но уже не аналоговым сигналом, а цифровым кодом. В этом общая черта всех стандартов второго поколения. Различаются они методами «уплотнения» или разделения каналов: в GSM используется подход с временным уплотнением TDMA (Time Division Multiple Access), а в CDMA кодовое разделение каналов связи (Code Division Mutiple Access), из-за чего этот стандарт так и называется. Стандарты второго поколения также создавались для обеспечения голосовой связи, но в силу их «цифровой природы» и в связи с возникшей в ходе распространения Глобальной Паутины необходимости обеспечить доступ в интернет по мобильному телефоны, предоставляли возможность передачи цифровых данных по мобильному телефону, как по обычному проводному модему. Изначально, стандарты второго поколения не обеспечивали высокой пропускной способности: GSM мог предоставить лишь 9600 бит/с (ровно столько требуется для обеспечения голосовой связи в одном «уплотненном» с помощью TDMA канале), CDMA несколько десятков Кбит/с.

В стандартах третьего поколения (3G), главным требованием к которым, согласно спецификациям Международного Телекоммуникационного Союза (ITU) IMT-2000, стало обеспечить видеосвязь хотя бы в разрешении QVGA (320х240), необходимо было достичь пропускной способности передачи цифровых данных не менее 384 Кбит/с. Для решения этой задачи используются полосы частот увеличенной ширины (W-CDMA, Wideband CDMA) или большее количество задействованных одновременно частотных каналов (CDMA2000). К слову, изначально стандарт CDMA2000 не мог обеспечить требуемой пропускной способности (предоставляя всего 153 Кбит/с), однако с введением новых модуляционных схем и технологий мультиплексирования с использованием ортогональных несущих в «надстройках» 1х RTT и EV-DO, порог в 384 Кбит/с был успешно преодолен. А такая технология передачи данных, как CDMA2000 1x EV-DV так и вовсе должна будет обеспечить пропускную способность до 2 Мбит/с, в то время как разрабатываемая и продвигаемая сейчас в сетях W-CDMA технология HSDPA (High-Speed Downlink Packet Access) до 14,4 Мбит/с.

Кроме того, в Японии, Южной Корее и Китае сейчас ведутся работы над стандартами следующего, четвертого поколения, которые смогут, в перспективе, обеспечивать скорость передачи и приема цифровых данных свыше 20 Мбит/с, став, таким образом, альтернативой проводных широкополосных сетей.

Однако, несмотря на все перспективы, которые сулят сети третьего поколения, перейти на них спешат далеко не многие. Причин тому много: это и дороговизна телефонных аппаратов, вызванная необходимостью вернуть вложенные в исследования и разработки средства; и дороговизна эфирного времени, связанная с высокой стоимостью лицензий на частотные диапазоны и необходимостью перехода на несовместимое с существующей инфраструктурой оборудование; и малое время автономной работы из-за чрезмерно высокой (по сравнению с аппаратами второго поколения) нагрузки при передаче больших объемов данных. Одновременно с этим, стандарт второго поколения GSM в силу изначально заложенной в него возможности глобального роуминга и меньшей стоимости аппаратов и эфирного времени (тут политика лицензирования главного поставщика CDMA-технологий, компании Qualcomm, сыграла с ней злую шутку), получил поистине глобальное распространение, и уже в прошлом году число абонентов GSM превышало 1 млрд. человек. Не воспользоваться ситуацией было бы неправильно как с точки зрения операторов, которым хотелось бы увеличить среднюю выручку с одного абонента (ARPU), и обеспечить предоставление сервисов, конкурентоспособных с сервисами 3G-сетей, так и со стороны пользователей, которым хотелось бы иметь мобильный доступ в интернет. То же, что произошло с этим стандартом в дальнейшем, вполне можно назвать небольшим чудом: был придуман эволюционный подход, конечной целью которого было превратить GSM в стандарт третьего поколения, совместимый с UMTS (Universal Mobile Telecommunications System).

Строго говоря, мобильный доступ в интернет был доступен давно: технология CSD (Circuit-Switched Data) позволяла осуществлять модемное соединение на скорости 9600 бит/с, но, во-первых, это было неудобно из-за малой скорости, а во-вторых из-за поминутной тарификации. Поэтому сначала была придумана и внедрена технология передачи данных GPRS (General Packet Radio Service), ознаменовавшая начало перехода к пакетному подходу, а потом технология EDGE. К слову, есть еще альтернативная GPRS технология HSCSD (High-Speed Circuit Switched Data), но она менее распространена, так как тоже подразумевает поминутную тарификацию, в то время как в GPRS учитывается трафик пересылка пакетов. В этом главная разница между GPRS и различными технологиями на базе CSD-подхода: в первом случае абонентский терминал пересылает в эфир пакеты, которые идут произвольными каналами до адресата, во втором между терминалом и базовой станцией (работающей как маршрутизатор) устанавливается соединение типа точка-точка с использованием стандартного или расширенного канала связи. Стандарт GSM с технологией GPRS занимает промежуточное положение между вторым и третьим поколениями связи, посему нередко называется вторым с половиной поколением (2,5G). Называется он так еще и потому, что GPRS знаменует собой половину пути GSM/GPRS-сетей к совместимости с UMTS.

Технология EDGE, как нетрудно догадаться из ее названия (которое можно перевести как «улучшенные скорости передачи данных для эволюции GSM-стандарта») играет сразу две роли: во-первых, обеспечивает более высокую пропускную способность для передачи и приема данных, а во-вторых, служит еще одним шагом на пути от GSM к UMTS. Первый шаг внедрение GPRS, уже сделан. Не за горами и второй шаг внедрение EDGE уже началось в мире и в нашей стране.

Карта покрытия EDGE-сети оператора «Мегафон» в г. Москве (на конец февраля 2006 г.)

EDGE что это такое и с чем её едят?

Технология EDGE может внедряться двумя разными способами: как расширение GPRS, в этом случае ее следует называть EGPRS (enhanced GPRS) или как расширение CSD (ECSD). Учитывая, что GPRS распространена намного шире, чем HSCSD, остановимся на рассмотрении EGPRS.

1. EDGE не является новым стандартом сотовой связи.

Однако, EDGE подразумевает дополнительный физический уровень, который может быть использован для увеличения пропускной способности сервисов GPRS или HSCSD. При этом, сами сервисы предоставляются точно так же, как и раньше. Теоретически, сервис GPRS способен обеспечивать пропускную спосность до 160 Кбит/с (на физическом уровне, на практике же поддерживающие GPRS Class 10 или 4+1/3+2 аппараты обеспечивают лишь до 38-42 Кбит/с и то, если позволяет загруженность сети сотовой связи), а EGPRS до 384-473,6 Кбит/с. Для этого необходимо использование новой модуляционной схемы, новых методов кодирования каналов и коррекции ошибок.

2. EDGE, по сути, является «надстройкой» (вернее, подстройкой, если считать, что физический уровень находится ниже остальных) к GPRS и не может существовать отдельно от GPRS. EDGE, как уже было сказано выше, подразумевает использование иных модуляционных и кодовых схем, сохраняя совместимость с CSD-сервисом голосовой связи.

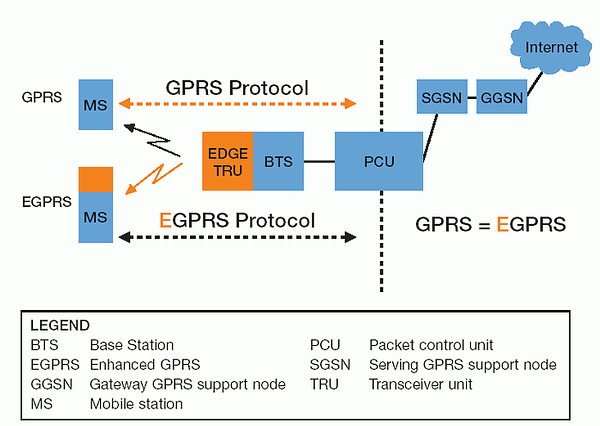

Рисунок 1. Измененные узлы показаны желтым цветом.

Таким образом, с точки зрения клиентского терминала, с внедрением EDGE не должно измениться ничего. Однако, инфраструктура базовой станции претерпит некоторые изменения (см. рис. 1), хотя и не такие уж серьезные. Помимо увеличения пропускной способности для передачи данных, внедрение EDGE увеличивает емкость сети сотовой связи: в один и тот же тайм-слот можно теперь «упаковать» большее количество пользователей, соответственно, можно надеяться не получать сообщение «сеть занята» в самые неподходящие моменты.

| Таблица 1. Сравнительные характеристики EDGE и GPRS | ||

| GPRS | EDGE | |

| Модуляционная схема | GMSK | 8-PSK/GMSK |

| Скорость передачи символов | 270 тыс. в секунду | 270 тыс. в секунду |

| Пропускная способность | 270 Кбит/с | 810 Кбит/с |

| Пропускная способность на тайм-слот | 22,8 Кбит/с | 69,2 Кбит/с |

| Скорость передачи данных на тайм-слот | 20 Кбит/с (CS4) | 59,2 Кбит/с (MCS9) |

| Скорость передачи данных с использованием 8 тайм-слотов | 160 (182,4) Кбит/с | 473,6 (553,6) Кбит/с |

Таблица 1 иллюстрирует разные технические характеристики EDGE и GPRS. Хотя и в EDGE, и в GPRS в единицу времени отправляется одинаковой число символов, благодаря использованию другой модуляционной схемы, число бит данных в EDGE втрое больше. Сразу оговоримся здесь, что приведенные в таблице значения пропускной способности и скорости передачи данных отличаются друг от друга из-за того, что в первой также учитываются заголовки пакетов, пользователю ненужные. Ну, а максимальная скорость передачи данных в 384 Кбит/с (требуемая для соответствия спецификациям IMT-2000) получается в том случае, если используется восемь тайм-слотов, то есть, на каждый тайм-слот приходится по 48 Кбит/с.

Модуляционная схема EDGE

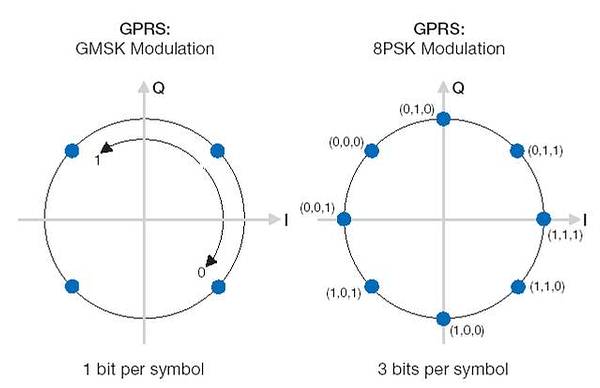

Рисунок 2. Разные модуляционные схемы в GPRS и EDGE.

В технологии EDGE применяется модуляционная схема 8PSK (8-phase shift keying, сдвиг фазы, как видно из рисунка, равен p /4), используя все те же спецификации структуры частотных каналов, кодирования и ширины полос, как в GSM/GPRS. Соответственно, соседние частотные каналы создают ровно те же взаимные помехи, как и в GSM/GPRS. Меньший сдвиг фазы между символами, в которые теперь кодируется не один бит, а три (символы соответствует комбинациям 000, 001, 010, 011, 100, 101, 110 и 111), делает задачу детектирования сложнее, особенно если уровень сигнала невысок. Впрочем, в условиях хорошего уровня сигнала и стабильного приема, дискриминировать каждый символ не составляет большого труда.

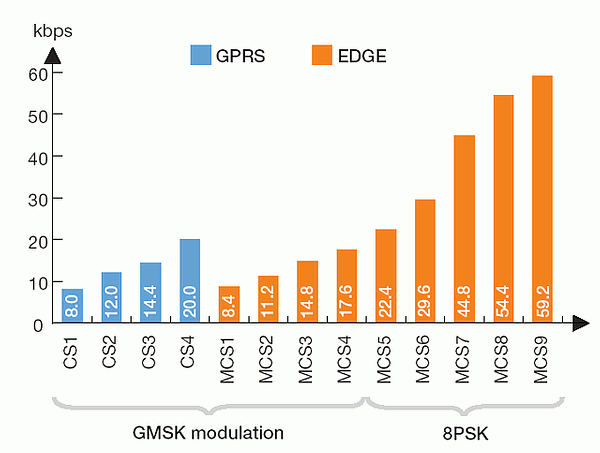

Кодирование

В GPRS возможно применение четырех разных схем кодирования: CS1, CS2, CS3 и CS4, в каждой из которых используется свой алгоритм коррекции ошибок. Для EGPRS разработано девять схем кодирования, MCS1..MCS9, соответственно, назначение которых также в обеспечении коррекции ошибок. Причем в «младших» MSC1..MSC4 используется модуляционная схема GMSK, в «старших» MSC5..MSC9 модуляционная схема 8PSK. На рисунке 3 представлена зависимость скорости передачи данных от использования разных модуляционных схем вкупе с разными схемами кодирования (скорость передачи данных меняется в зависимости от того, как много требуемой для работы алгоритмов коррекции ошибок избыточной информации закладывается в каждый кодируемый пакет). Нетрудно догадаться, что чем хуже условия приема (отношение сигнал/шум), тем больше приходится закладывать избыточной информации в каждый пакет, а значит, тем меньше скорость передачи данных. Небольшое отличие в скорости передачи данных, наблюдаемое между CS1 и MCS1, CS2 и MCS2, и т. д., связано с разницей в величине заголовков пакетов.

Рисунок 3. Разные кодовые схемы в GPRS и EDGE.

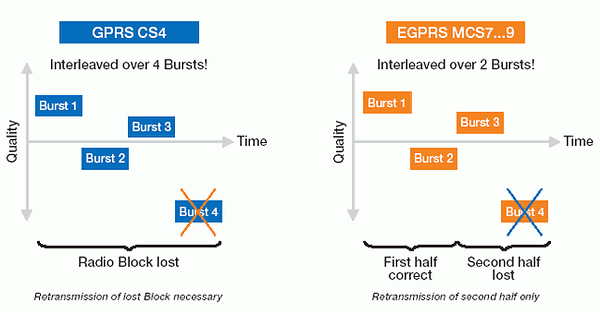

Впрочем, если соотношение сигнал/шум невелико, не все потеряно: в старших модуляционно-кодовых схемах EGPRS MCS7, MCS8, MCS9 предусмотрена процедура «наложения»: так как стандарт способен отправлять группы пакетов на разных несущих (внутри частотного диапазона), для каждой из которых условия (и прежде всего «зашумленность») могут быть разными, в этом случае повторной передачи всего блока можно избежать, если знать, в какой группе произошел сбой и повторно транслировать именно эту группу. В отличие от старшей кодовой схемы GPRS CS4, где не используется аналогичный алгоритм коррекции ошибок, в EGPRS MCS7, MCS8, MCS9 разные блоки данных «накладываются» друг на друга, поэтому при сбое в одной из групп (как показано на рисунке), повторной пересылке подлежит лишь половина пакетов (см. рис. 4).

Рисунок 4. Использование наложения групп пакетов в EDGE.

Обработка пакетов

Если по каким-то причинам пакет, отправленный с использованием «старших» схем кодирования, не был корректно принят, EGPRS позволяет его ретранслировать заново с использованием «пониженной» кодировочной схемы. В GPRS такой возможности, названной «ресегментацией» (resegmentation), предусмотрено не было: некорректно принятый пакет отправляется вновь по той же модуляционно-кодировочной схеме, что и в предыдущий раз.

Окно адресации (addressing window)

Прежде чем последовательность кодированных (то есть, в которые закодированы «слова», состоящие из нескольких бит) пакетов (фрейм) может быть передана по радиочастотному интерфейсу, передатчик присваивает пакетам идентификационный номер, включенный в заголовок каждого пакета. Номера пакетов в GPRS составляют от 1 до 128. После того, как последовательность пакетов (например, 10 штук) отправлена адресату, передатчик ждет от приемника подтверждения того, что они были приняты. В отчете, который приемник отправляет обратно передатчику, содержатся номера пакетов, которые были успешно декодированы, и которые получатель декодировать не смог. Важный нюанс: номера пакетов принимают значения от 1 до 128, а ширина адресного окна всего 64, вследствие чего вновь передаваемый пакет может получить такой же номер, как в предыдущем фрейме. В этом случае протокол вынужден повторно отправлять весь текущий фрейм, что отрицательно сказывается на скорости передачи данных в целом. Для снижения риска возникновения такой ситуации в EGPRS номер пакета может принимать значения от 1 до 2048, а адресное окно увеличено до 1024.

Точность измерения

Для обеспечения корректного функционирования технологии GPRS в среде GSM приходится постоянно измерять радиоусловия: уровень сигнал/шум в канале, частоту появления ошибок и т. п. Эти измерения никак не сказываются на качестве голосовой связи, где достаточно постоянно использовать одну и ту же кодировочную схему. При передаче данных в GPRS измерение радиоусловий возможно лишь в «паузах» дважды за период 240 мс. Для того, чтобы не ждать каждые 120 мс, EGPRS определяет такой параметр, как вероятность возникновения ошибки на бит (BEP, bit error probability), в каждом фрейме. На величину BEP влияет как отношение сигнал/шум, так и временная дисперсия сигнала и скорость перемещения терминала. Изменение BEP от фрейма к фрейму позволяет оценить скорость терминала и «дрожание» частоты, но для более точной оценки используется среднее значение вероятности ошибки на бит на каждые четыре фрейма и его выборочное стандартное отклонение. Благодаря этому, EGPRS быстрее реагирует на изменения условий: увеличивает скорость передачи данных при снижении BEP и наоборот.

Контроль за скоростью соединения в EGPRS

В EGPRS используется комбинация двух подходов: подстройки скорости соединения и инкрементной избыточности. Подстройка скорости соединения, измеряемой либо мобильным терминалом по количеству принимаемых в единицу времени данных, либо базовой станцией по количеству, соответственно, передаваемых данных, позволяет выбрать оптимальную модуляционно-кодовую схему для последующих объемов данных. Обычно, использование новой модуляционно-кодовой схемы может быть назначено при передаче нового блока (по четыре группы) данных.

Инкрементная избыточность изначально применяется для самой старшей модуляционно-кодовой схемы, MCS9, с незначительным вниманием к коррекции ошибок и без учета условий радиосвязи. Если информация декодируется адресатом некорректно, по каналу связи передаются не сами данные, а некий контрольный код, который «добавляется» (используется для преобразования) к уже загруженным данным до тех пор, пока данные не будут декодированы успешно. Каждый такой «инкрементный кусочек» дополнительного кода увеличивает вероятность успешной расшифровки переданных данных в этом и заключается избыточность. Главным преимуществом этого подхода является то, что здесь нет необходимости следить за качеством радиосвязи, поэтому инкрементная избыточность является обязательной в стандарте EGPRS для мобильных терминалов.

Интеграция EGPRS в существующие GSM/GPRS сети UMTS не за горами!

Как уже было сказано выше, главное различие между GPRS и EGPRS в использовании иной модуляционной схемы на физическом уровне. Поэтому для поддержки EGPRS достаточно установки на базовой станции поддерживающего новые модуляционные схемы трансивера и программного обеспечения для обработки пакетов. Для обеспечения совместимости с не поддерживающими EDGE мобильными телефонами, в стандарте прописано следующее:

Внедрение EGPRS, как уже говорилось выше, позволяет достичь пропускной способности, примерно втрое больше, чем в технологии GPRS. При этом используется в точности такие же профили QoS (quality of service, качество сервиса), как в GPRS, но с учетом увеличившейся пропускной способности. Помимо необходимости установки трансивера на базовой станции, для поддержки EGPRS требуется обновление программного обеспечения, которое должно будет обрабатывать измененный протокол передачи пакетов.

Следующим эволюционным шагом на пути систем сотовой связи GSM/EDGE к «полноценным» сетям третьего поколения будет дальнейшее улучшение сервисов пересылки пакетов (данных) для обеспечения их совместимости с UMTS/UTRAN (UMTS terrestrial radio access network). Эти улучшения в настоящее время проходят рассмотрениеи, скорее всего, будут включены в будущий вариант спецификаций 3GPP (3G Partnership Project). Главное отличие GERAN от внедряемой в настоящий момент технологии EDGE будет поддержка QoS для интерактивных, фоновых, потоковых и переговорных классов. Поддержка этих QoS-классов уже есть в UMTS, благодаря чему в сетях UMTS (скажем, W-CDMA 2100 или 1900 МГц) наличествует возможность, например, видеосвязи. Кроме этого, в будущем поколении EDGE планируется обеспечить одновременную параллельную обработку потоков данных с разным приоритетом QoS.