Fast initialization raid что это

Что из себя представляет инициализация RAID-массива

Инициализация — это процесс преобразования исходного массива физических дисков в состоятельные логические тома (с целостными, внутренне непротиворечивыми данными). Выполняется для повышения производительности и надежности хранения.

У разработчиков аппаратных и программных RAID свои алгоритмы инициализации, быстрой (затиранием данных «нулями») или полной (с проверками и исправлением целостности и чётности данных).

Прирост производительности достигается за счет обновления метаданных на физических дисках, в том числе, освобождением места под будущие операции записи.

Надежности способствует:

Построение RAID-массива без инициализации или с быстрой инициализацией, экономит время на старте, но чревато ошибками в будущем. Дело в том, что при первичной настройке дисков, не прошедших инициализацию, ни один из секторов логического тома на самом деле ни для чего не используется, и когда Вы записываете первую группу данных в каждый из этих секторов, RAID-контроллер сгенерирует для них и запишет правильную чётность. Таким образом, даже если информация о четности для большей части диска недействительна, она должна быть в порядке для всех секторов, которые фактически использовались для записи. Однако, при попытке запуска процедуры проверки целостности (Consistency Check) на неинициализированном виртуальном диске, будет выведено сообщение об ошибке. Что делает невозможным также и контроль за состоянием дисков в массиве, в режиме фоновой проверки чётности. Поэтому многие аппаратные контроллеры не позволяют создавать массивы без инициализации.

Рекомендована полная инициализация, хотя на нее может уйти несколько суток. Она может быть фоновой (background initialization), с изменяемым приоритетом исполнения массивом основных задач над инициализацией. При нулевом приоритете инициализация выполняется в паузах активности.

http://superuserdo.info/?p=732

Добавить комментарий Отменить ответ

Для отправки комментария вам необходимо авторизоваться.

Fast initialization raid что это

Всем привет! В первой части цикла статей, мы с вами рассмотрели, как производится «Установка RAID контроллера LSI 9361 8i на сервер HP ProLiant DL380 G7». Следующим шагом идет рассмотрение того, как создать RAID 0, RAID1, RAID 5, RAID 50, RAID 10 на контроллере LSI 9381 8i. Вы должны выбрать для своей задачи, тот тип, что подходит именно для вашего проекта. Советую перед тем, как запускать сервер в продакшен, все протестировать, посмотреть как происходит перестройка массив, при выходе диска из строя, какая будет нагрузка на дисковую подсистему. Вы как системный инженер, обязаны это знать.

Настройка LSI 9381 8i

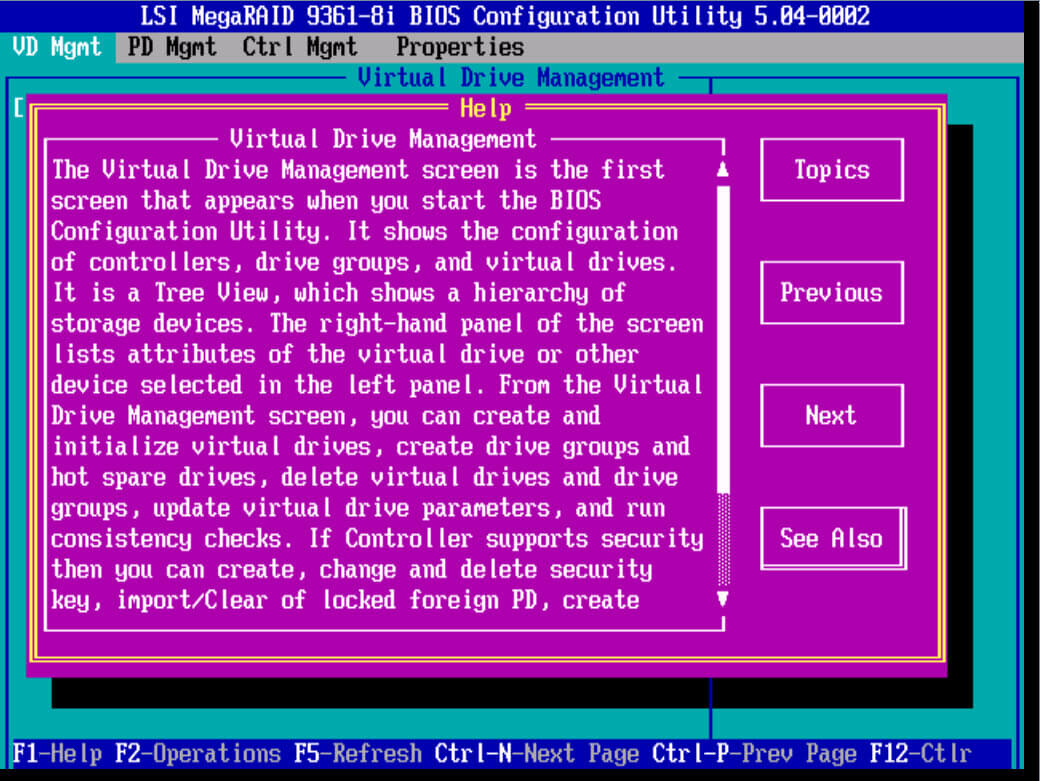

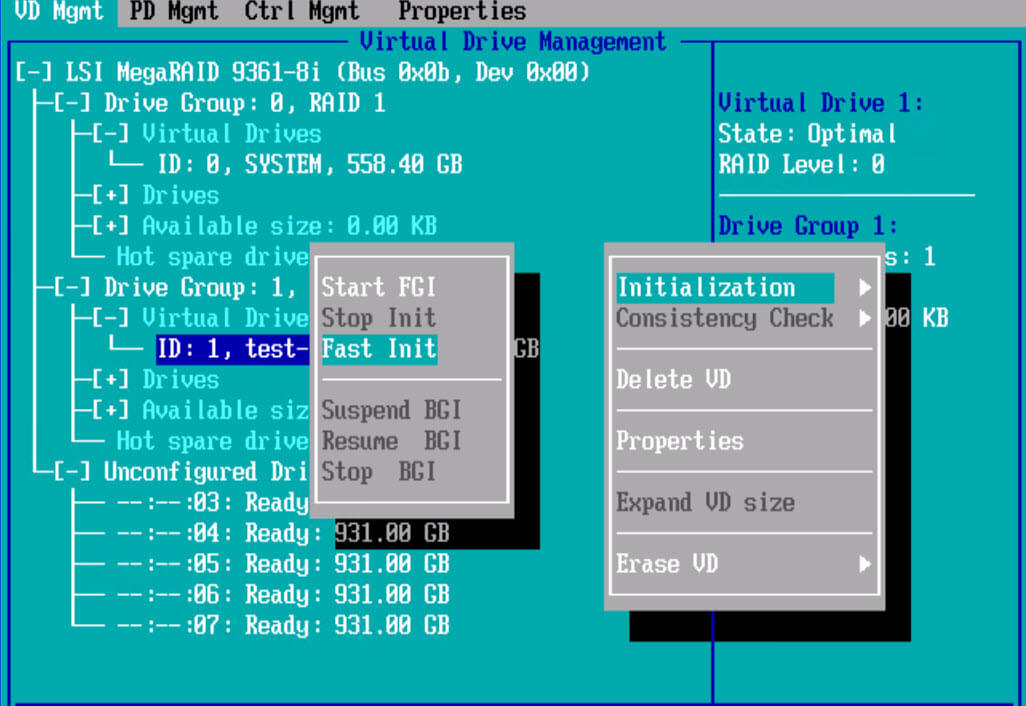

И так мы с вами попали в утилиту LSI MegaRAID 9361-8i BIOS Configuration Utility.

Первое что я вам советую сделать это нажать клавишу F1 и прочитать небольшой мануал с помощью и функциями RAID контроллера.

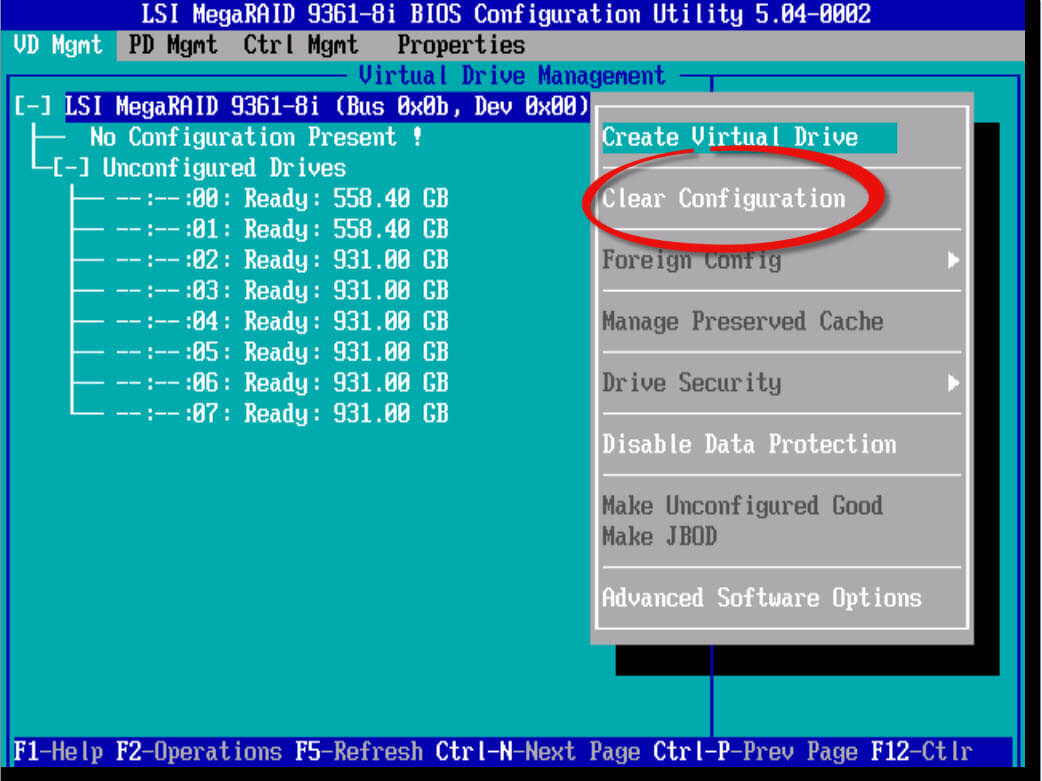

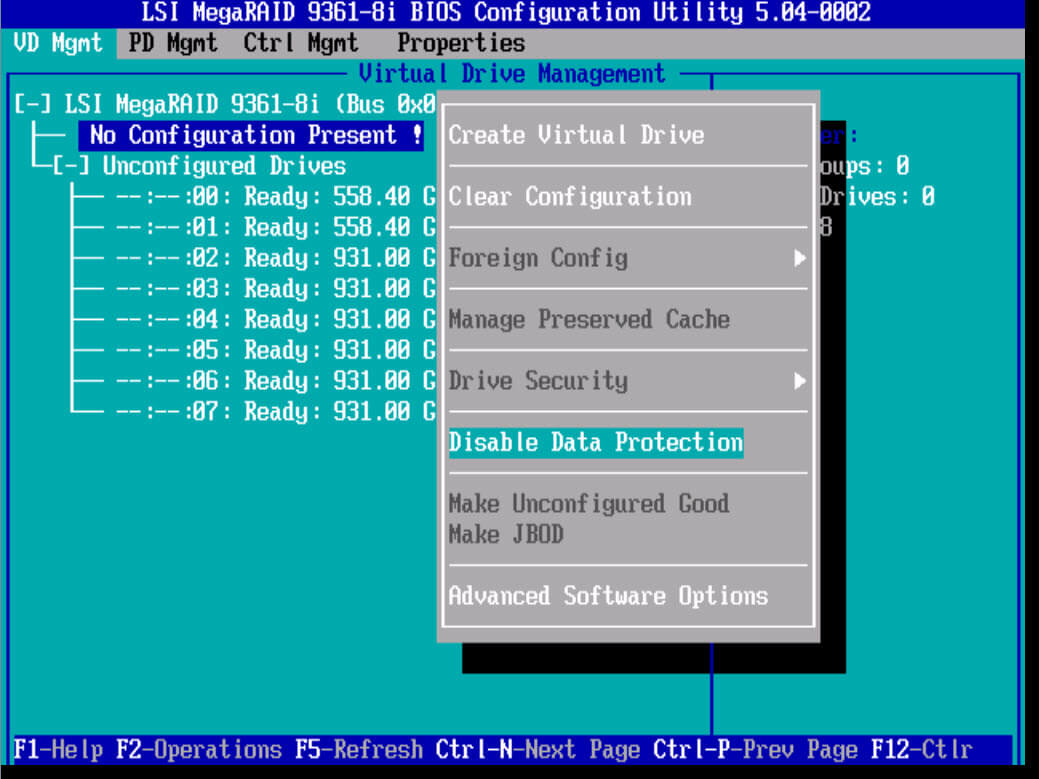

Прочитав help, выберите самый верхний пункт LSI MegaRAID 9361-8i и нажмите F2. У вас откроется контекстное меню, с возможными действиями. Первое что нужно сделать это затереть конфигурацию, на всякий случай. Выбираем Clear Configuration.

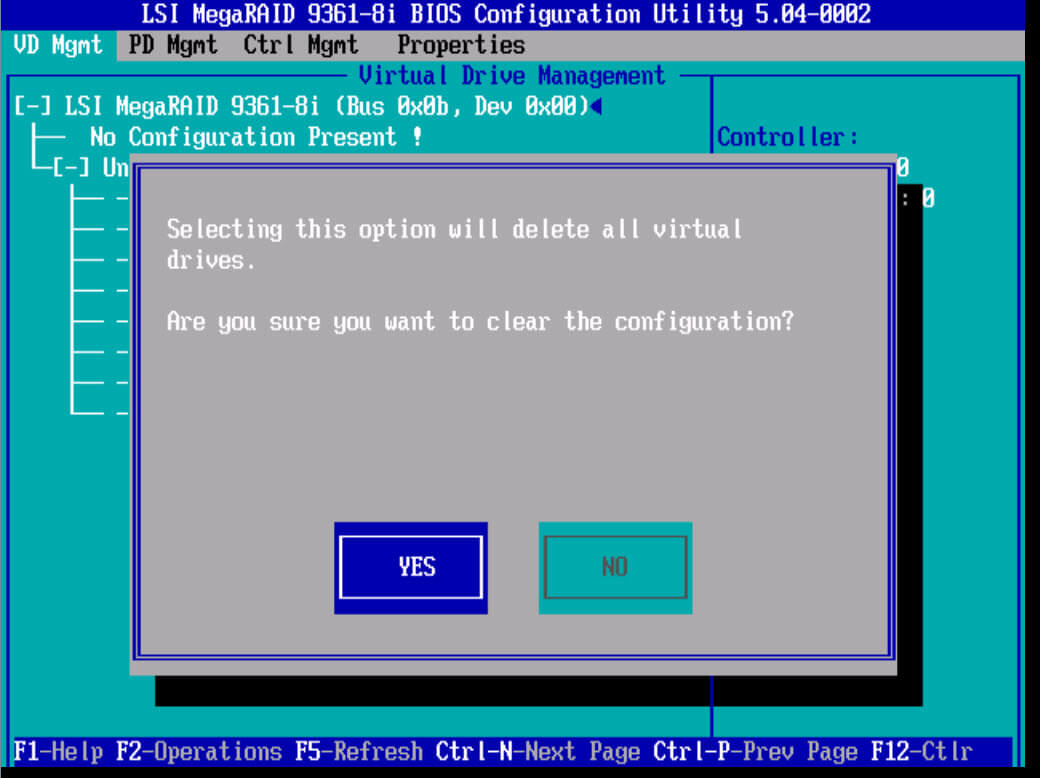

На вопрос хотите ли вы удалить жмем Yes.

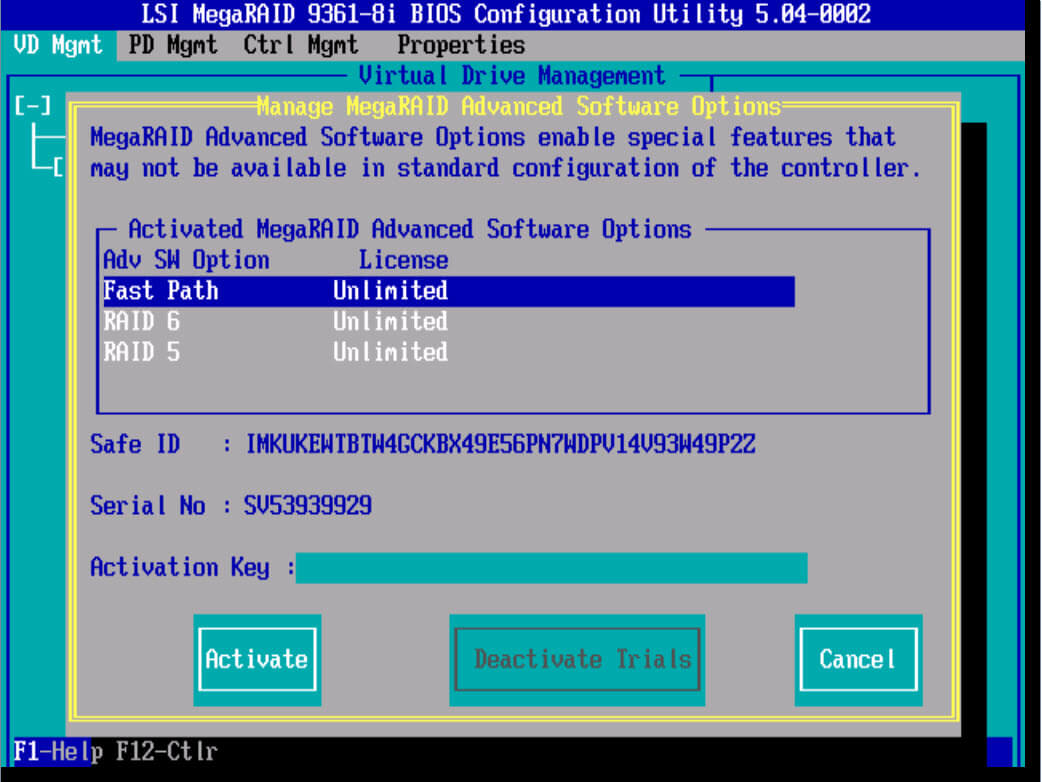

Теперь, когда у вас уже чистая конфигурация, давайте пробежимся по доступным опциям, для этого жмем клавишу F2. Первое на что хочу обратить внимание это пункт Advanced Software Options (Дополнительные настройки)

Тут можно активировать специальным ключиком, дополнительные плюшки, типа Fast Path и что то расширяющее функционал RAID 5 и RAID 6. Если у вас есть ключ, то вволим его и жмем Activate.

Если у вас RAID контроллер идет с модулем защиты от внезапного выключения, то проверьте,ч то у вас включена защита Data Protection.

Доступные виды RAID

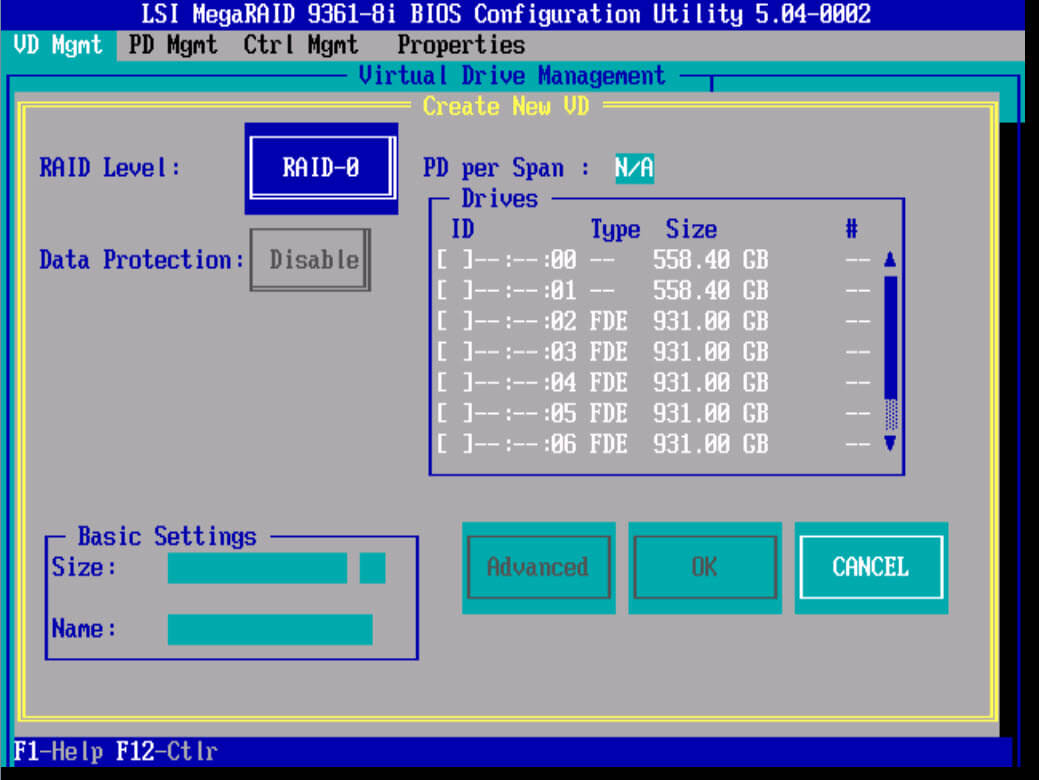

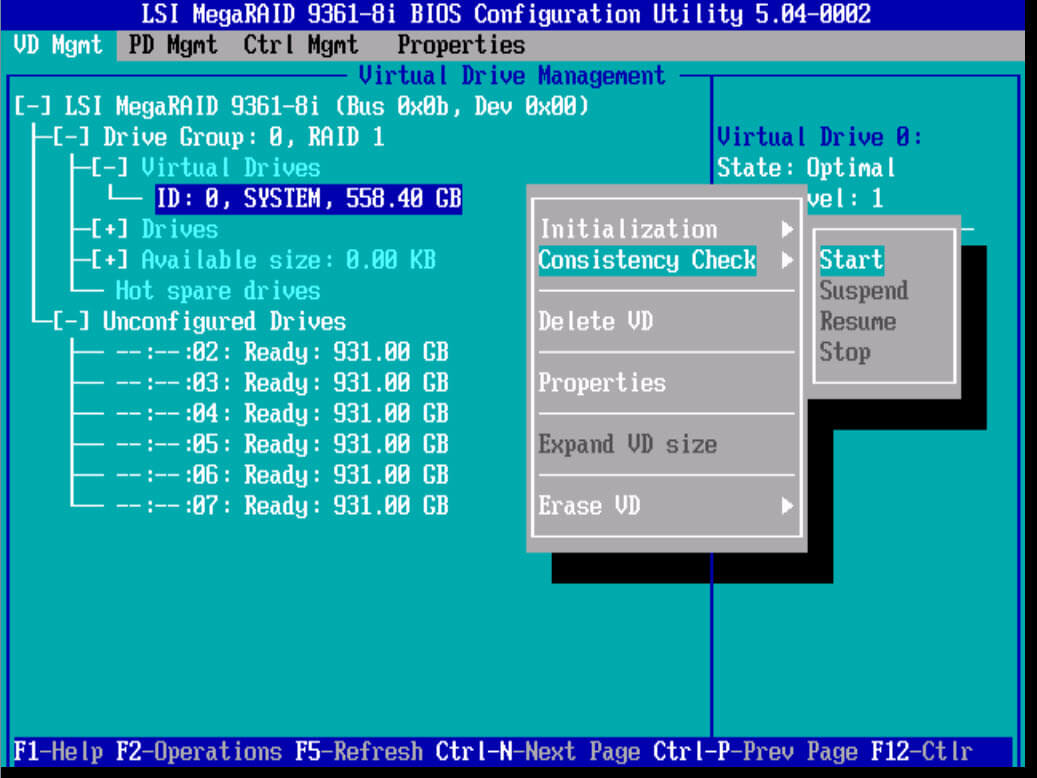

И так выберем теперь пункт Create Virtual Drive, для создания системного LUN, на который будет установлен VMware ESXI 5.5. Откроется окно Virual Drive Management. В нем нас интерисует пункт RAID Level.

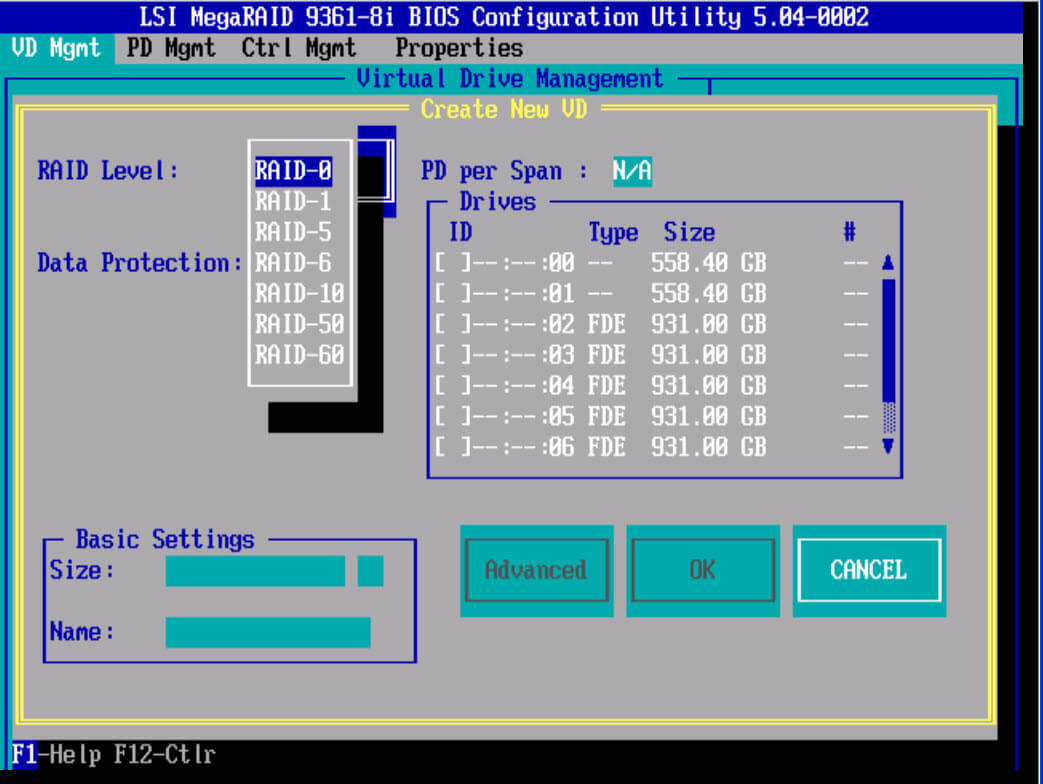

нажав на нем Enter у вас появится выбор доступных видов RAID. Среди них все самые известные виды RAID (0,1,5,6,10,50,60). Так как у меня для системы установлены в 1 и 2 слоты два SAS HDD, то я из них создам RAID 1 зеркало, под систему. Выбираем RAID 1. Более подробно про виды RAID читайте тут.

Создаем RAID1

Выделяем в пункте Drives два HDD диска, для нашего зеркала, напомню диски должны быть одинаковыми. Вы видите размер в пункте Size, помните,что на одном lun можно создать много логических разделов, совет при тестировании нет смысла создавать раздел максимального размера, советую делать его на порядок меньше, на тестирование производительности это ни как не повлияет. Можете задать имя разделу.

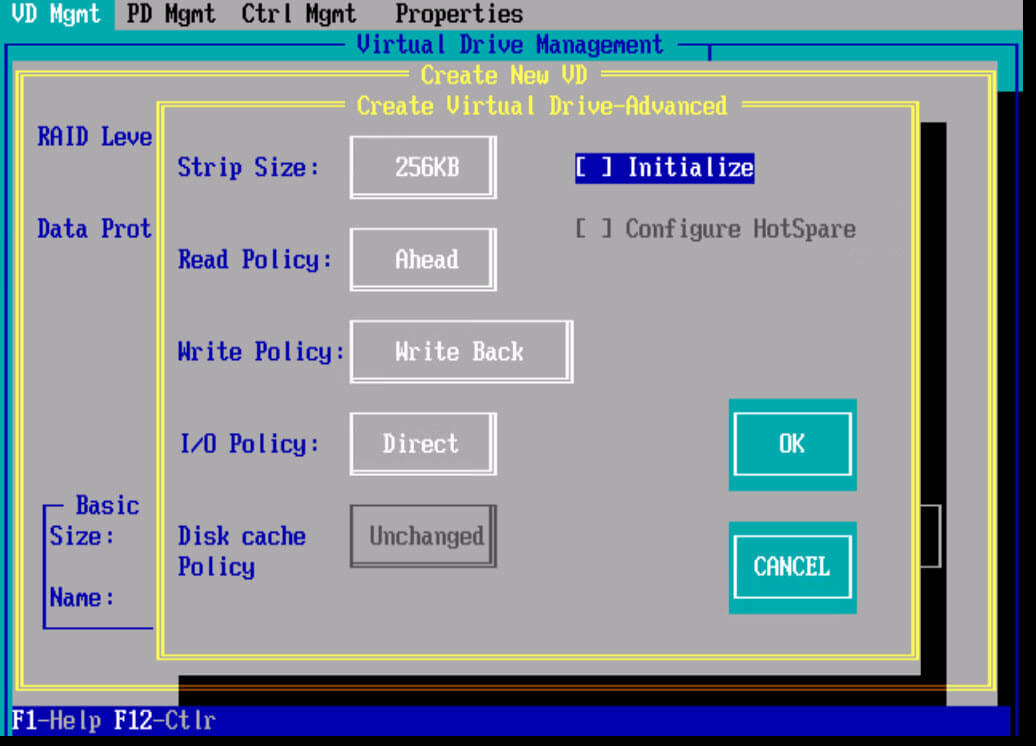

Далее жмете пункт advanced. Тут можно поиграться с видами кэша на LSI контроллере. Более подробно почитать про виды кэширования и best prictice можно тут. Во время создания советую сразу инициализировать раздел, сделать это можно в окне задания stripe size, поставив птичку initialize.

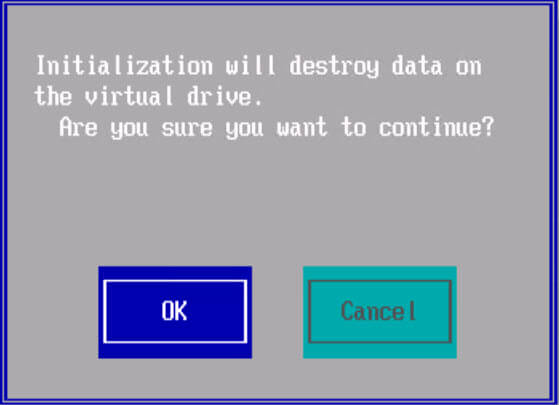

Как только инициализация пройдет вы увидите вот такое сообщение

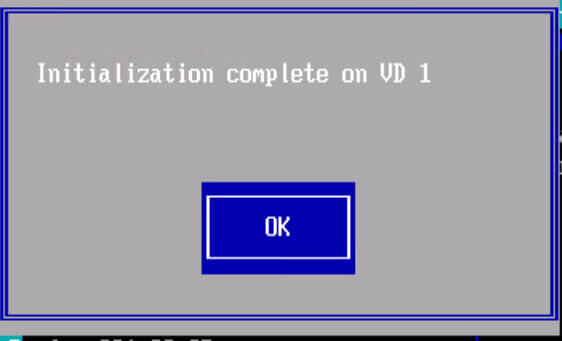

Если во время выбора размера stripe вы не не поставили галку инициализации, то сделать это можно в пункте меню VD Mgmt,выбрав ваш virtual drive ID и нажав Initialization-Fast init

тут же можно сразу сделать Consistency Check, проверку целостности.

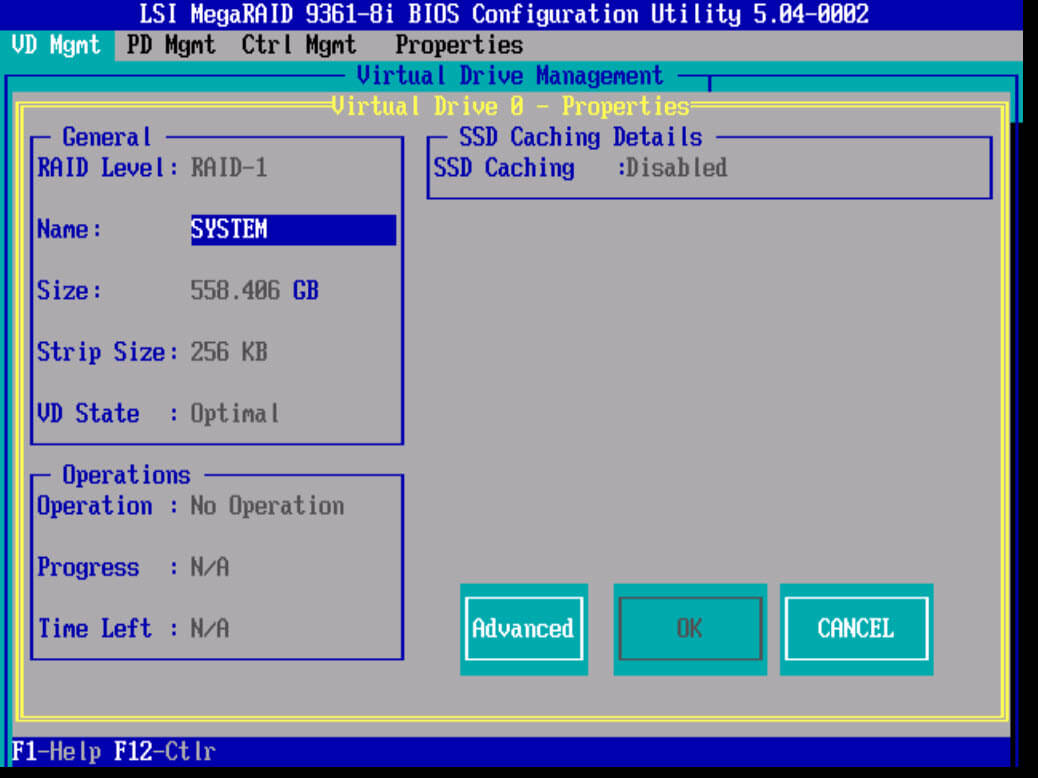

Если нажать Properties то вы сможете поменять настройки задаваемые при создании

Себе я задам на RAID1 вид кэширования Write Back.

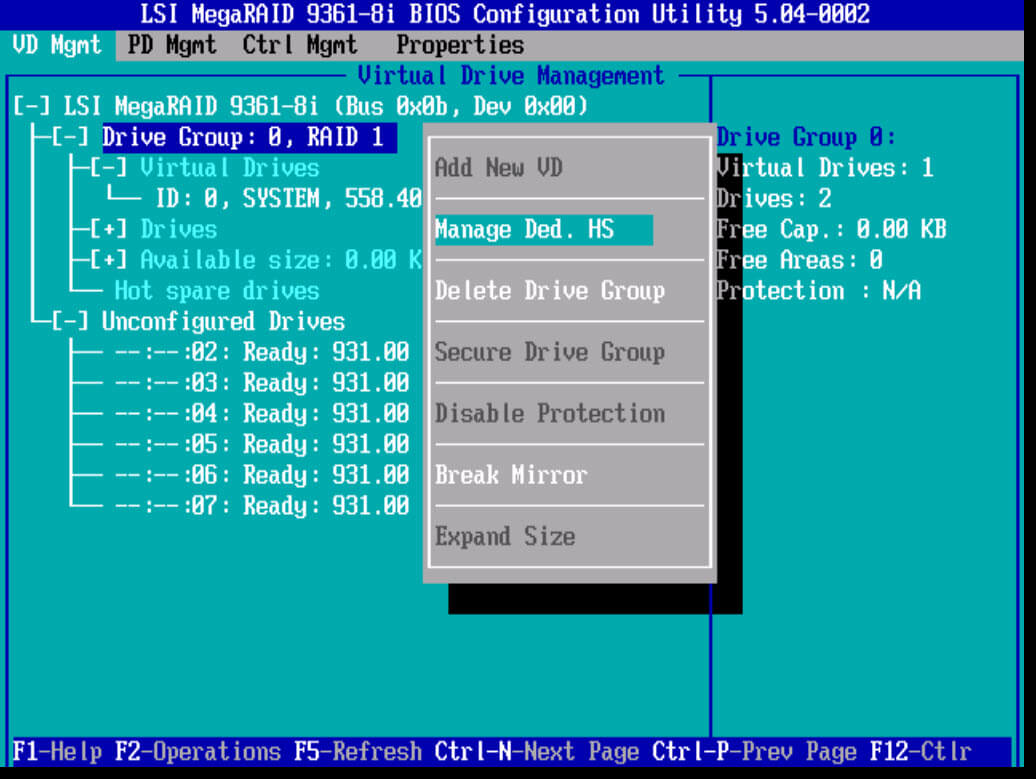

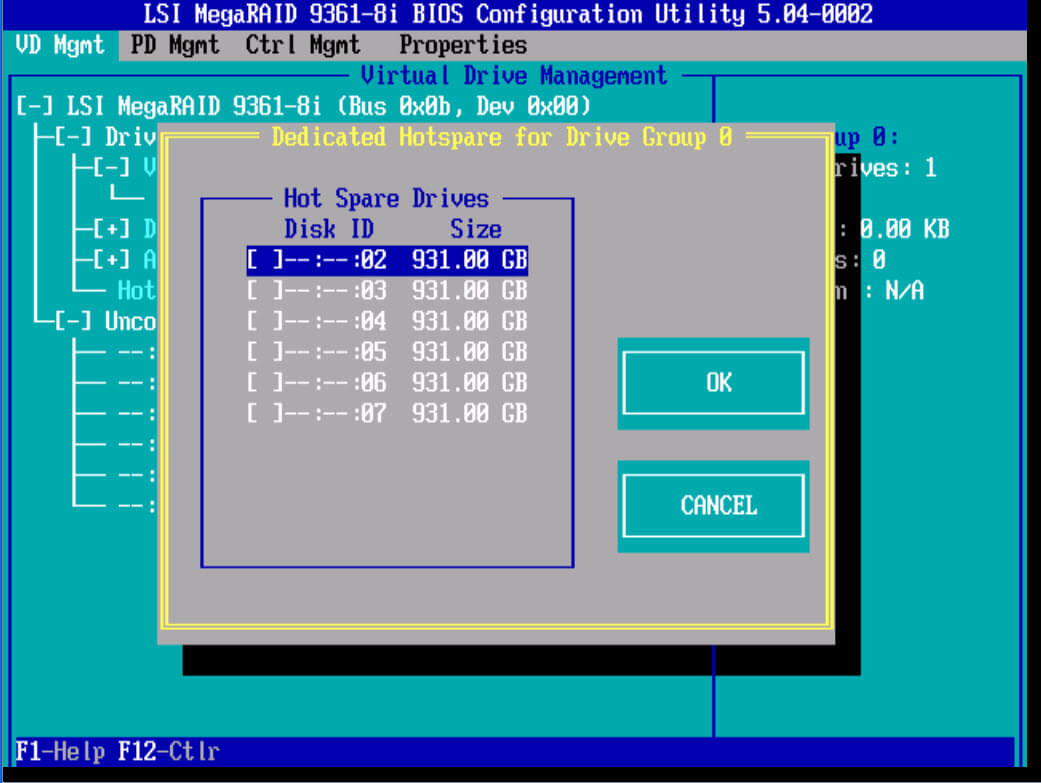

Если выбрать Manage Ded. HS

То вы сможете добавить Hot Spare.

Вот так легко создается RAID 1 зеркало, далее во второй части мы рассмотрим создание RAID 0, RAID 10, RAID 5, RAID 50, RAID 60 на контроллере LSI 9361 8i.

Простая конфигурация встроенного RAID контроллера LSI

Чем отличаются типы массивов и вообще, что такое RAID рассказывается здесь.

После перезагрузки утилита выведет список доступных физических дисков

2. Нажать CTRL+M или Enter для продолжения конфигурации

4. Сконфигурировать массив:

5. Проинициализировать вновь созданный виртуальный диск — пункт меню Initialize.

6. Диск создан и готов к использованию.

Другие пункты меню конфигурации контроллера:

Виды RAID массивов, настройка RAID и характеристики.

Виды RAID массивов (часто используемые).

RAID 0 (stripe) – диски объединяются в один, который может быть размечен на несколько логических.

RAID 1 (mirror) – такой вид массива также называют “зеркальный массив”.

Плюсы.

Надежность хранимых данных, диски дублируют друг друга.

При выходе из строя одного из дисков RAID 1, данные остаются в полном объеме на втором.

Минусы.

Высокая стоимость за счет использование половиной места под резервирование, высокая надежность.

Производительность не увеличивается.

Пример.

Имеются два диска по 1 Tb, скорость чтения и записи каждого по 150 Мбайт/с. Объединяем их в RAID 1, получаем в итоге один диск объемом 1 Tb и скоростью записи, чтения диска 150 МБайт/c (150*2). Но данные записываются одновременно на оба диска, полностью копируя друг друга.

RAID 5 – дисковый массив, который может вести параллельную запись на диски массива, что увеличивает его быстродействие.

Есть резервирование данных. При выходе из строя одного из дисков массив продолжает работать.

Плюсы.

Экономичность, высокая надёжность, неплохая производительность

Минусы.

Производительность ниже RAID 0

RAID 10 – массив RAID 0, построенный из массивов RAID 1, минимальное количество жестких дисков 4. Совмещение RAID 1 и RAID 0.

Плюсы.

Высокая производительность за счет RAID 0.

Высокая надежность за счет RAID.

Минусы.

Высокая стоимость

Пример.

Берем четыре диска по 1 Tb, скорость чтения и записи каждого по 150 Мбайт/с. Объединяем их в RAID 10, получаем в итоге один диск объемом 2 Tb. Скорость записи, чтения становится диска 150 МБайт/c (150*2). Данные копируются на оставшиеся два диска.

Настройки RAID

Stripe size – определяет объем данных записываемых за одну операцию ввода/вывода. размер strip задается в момент создания RAID массива и не может быть изменен позднее без пересоздания всего массива. Запись производится поочередно на каждый диск массива по указанному размеру stripe.То есть файл размещается сразу на двух дисках по по кусочкам указанных в stripe. Больший размер страйпа обеспечивает прирост производительности при работе с большими последовательными файлами (например, видео), меньший – обеспечивает большую эффективность в случае работы с большим количеством небольших файлов. В большинстве случаев рекомендуется оставлять значение по умолчанию.

Read Policy – определяет, запускать или нет процедуру упреждающего чтения. Рекомендуется здесь выбирать Adaptive, если RAID предназначен для решения широкого спектра задач и отдать тем самым принятие решения на откуп RAID контроллеру. Если RAID массив рассчитан на “переваривание” максимально возможного количества IOPS, то этот параметр обычно устанавливается в Off.

Normal – упреждающее чтение отключено

Read-Ahead – использовать механизм упреждающего чтения. Эта функция помогает увеличить скорость чтения при операциях с большими файлами.

Adaptive (Адаптивно) – контроллер сам решает использовать ли упреждающее чтение, включается только при последовательном чтении одинаковых блоков. При произвольном чтении автоматически не используется.

Write Policy – способ записи данных, полученных RAID контроллером, на дисковый массив. По другому эти способы еще называются так: прямая запись (Write Through) и отложенная запись (Write Back).

Write Through – данные записываются непосредственно на дисковый массив. Как только данные получены, они сразу же записываются на диски и после этого контроллер подает сигнал управляющей ОС о завершении операции.

Write Back – данные записываются сначала в cache, и только потом (либо по мере заполнения cache, либо в моменты минимальной загрузки дисковой системы) из cache на диски. При этом, сигнал о завершении операции записи передается управляющей ОС сразу же по получении данных cache контроллера. Write Back работает быстрее, но при этом надо помнить, что в случае сбоя питания все данные, которые находились в этот момент в cache, будут потеряны. Причем, управляющая ОС (а следовательно и приложение, записывавшее эти данные) ничего об этом “не узнают”, так как они уже получили сообщение от контроллера об успешном завершении записи. Например, если в cashe находились данные транзакции сервера СУБД, то СУБД будет уверенна, что с данными все хорошо, хотя на самом деле это не так. Избежать описанной проблемы можно или с помощью установки на RAID контроллер BBU, или посредством подключения всего сервера через источник бесперебойного питания (UPS) с функцией программируемого выключения. RAID контроллеры не позволяют включить функцию Write Back без установленного BBU.

Always Write Back – всегда включена политика записи через cache, не зависимо от присутствия/отсутствия BBU

Write Back with BBU – работает только при наличии исправной BBU, переключится в режим Write Through при отсутствии BBU или ее не достаточном заряде

IO Policy – влияет на работу cache при операциях чтения и не зависит от состояния read-ahead.

Cache I/O — все операции чтения кешируются.

Direct I/O — операции чтения не кешируются. При использовании этого режима данные из дисковой подсистемы параллельно направляются в cache и в ОС. В случае повторного чтения того же блока, сперва блок берётся из cache.

Drives Cache – кэширование дисков

Enable – включено

Disable – выключено, лучше выбирать это если нет online ИБП или bbu

Unchanged – не изменять текущую политику кэширования

Disable BGI (Disable background initialization)

No – background initialization включено. Значение по умолчанию.

Yes – background initialization отключено.

BBU (Battery Backup Unit) необходим для предотвращения потери данных находящихся в cache RAID контроллера и еще не записанных на диск (отложенная запись – “write-back caching”), в случае аварийного выключения компьютерной системы. Существуют такие виды BBU:

Просто BBU – аккумулятор, который обеспечивает резервное питание cache через RAID контроллер.

Переносимые (Transportable) BBU (tBBU) – аккумулятор, который размещен непосредственно на модуле cache и питает его независимо от RAID контроллера. В случае выхода из строя RAID контроллера, это позволяет перенести данные, сохраненные в cache, на резервный контроллер и уже на нем завершить операцию записи данных.

Flash BBU – в случае сбоя питания RAID контроллер копирует содержимое cache в энергонезависимую память. Питание, необходимое для завершения этого процесса, обеспечивается встроенным супер-конденсатором. После восстановления питания, данные из flash-памяти копируются обратно в cache контроллера.

Современные RAID контроллеры Adaptec от А до Я. Часть 1

Собственно, Часть 1.

Подсистема хранения информации современного сервера

На сегодняшний день внутренняя система хранения современного сервера базируется на технологиях SAS/SATA. И здесь, по сравнению со старой классической технологией SCSI, которая сейчас уже не используется, добавилось не так уж и много нового. По сути, только SAS экспандер, который позволяет создавать сетевой сегмент второго уровня для обмена информацией между контроллером и дисками на основе коммутатора второго уровня (научно говоря, сегмент типа “switched media” для общения targets и initiators).

И, как правило, внутренняя система хранения сервера строится на основе одного или нескольких SAS RAID контроллеров или HBA (в ряде случаев они могут быть интегрированы на материнскую плату) и SAS/SATA HDD или SSD дисков.

Внешние системы хранения дополнительно могут использовать и другие технологии, такие как FibreChannel, iSCSI, PCI-E. Системы хранения для центров обработки данных могут использовать современные решения типа NVRAM (виртуальные диски, созданные на основе быстрой оперативной памяти, которая имеет защиту от потери питания) и PCI-E (когда доступ к жесткому диску обеспечивается через сетевой сегмент технологии PCI-Express).

На рисунке показана современная внутренняя подсистема хранения сервера

RAID стек последнего поколения.

В самом общем смысле стек — это операционная система RAID контроллера.

В узком смысле стек – это виртуализатор контейнеров (проще – виртуализатор дисков). Он создает контейнер нужного типа, распределяет его по нужному количеству дисков и из большого числа контейнеров «выпекает» виртуальный диск, которые в стеке Adaptec называется “RAID том”.

Примечание: на момент сборки сервера (создания системы хранения) на RAID контроллер надо загрузить самую последнюю версию его ОС или прошивки (firmware). Для RAID контроллеров Adaptec они предоставляются бесплатно.

Как ни странно, но на сегодняшний день RAID стеки это частные решения, не подчиняющиеся стандартам. Можно снять все физические диски с созданными на них RAID томами, например, с контроллера Adaptec 6805 и перенести их на контроллер 8885 и тома будут видны. Но если попробовать перенести таким образом тома на контроллер другого производителя, то чуда не случится, и ни будет никакой возможности увидеть данные и эти RAID тома. Почему так происходит? Потому что контроллер другого производителя поддерживает свой собственный стек, не совместимый со стеком Adaptec.

Каждый RAID том представляется операционной системе компьютера как «SCSI диск», который и будет виден как отдельный объект в дисковых утилитах типа disk manager.Выглядит это так.

Таким образом, в менеджере дисков можно увидеть 4 виртуальных диска: RAID0, RAID1 и два диска RAID5.

При создании томов работает каждый уровень.

Задача уровня физических дисков – создать специальную область на дисках, где будет храниться информация о создаваемых томах. Такая область называется областью метаданных и представляет из себя сложный контейнер хранения, где хранится служебная информация. В эту область имеет доступ только операционная система контроллера и больше никто. В стеке Adaptec этот процесс создания служебной области называется – инициализация и выполняется через команду – initialize.

В RAID контроллерах, которые поддерживают режим HBA, есть и обратная команда – deinitialize (это контроллеры 7 и 8 серии). Эта команда полностью удаляет с физического диска такую структуру данных и переводит данный диск в режим HBA. Т.е., для того чтобы контроллер 7 или 8 серии начал работать как обычный HBA на нем достаточно деинициализировать все диски. Тогда они все будут видны в утилите центральной операционной системы типа DISK MANAGER и никакие другие операции не требуются.

На физическом уровне выполняется и другая известная функция, называемая – coercion. В стеке Adaptec она производится одновременно с initialize. Эта функция немного «подрезает» емкость жесткого диска. Дело в том, что диски одной и той же категории по емкости от разных производителей все же имеют неодинаковую емкость. Чтобы диск одного производителя можно было в будущем в случае необходимости заменить диском другого производителя и выполняется функция coercion. Отрезанная емкость просто навсегда “теряется” и никак не используется.

На физическом уровне возможно размещение различных сервисных функций – проверка диска деструктивным или недеструктивным методом, форматирование, полное стирание данных, заполнение диска нулями и т.д.

Логический уровень необходим по двум причинам:

Во-первых, он значительно уменьшает дискретность емкостей, которые Вы выбираете для создания томов. Это делается через возможность создавать несколько логических дисков (просто отрезая часть емкости) на одном физическом или создавать один логический диск с помощью двух или более физических. При этом емкости различных физических будут просто складываться. Сначала данными будет заполняться одна область одного физического диска, потом другая другого физического диска и т.д. Такой метод объединения дисков называется Chain (в некоторых других стеках используется слово Span).

Во-вторых, при создании таких объектов информация о них попадает в метаданные, и они перестают быть привязанными к физическим координатам. После этого диски можно переносить с одного порта контроллера на другой, переносить тома с одного контроллера на другой и это будет по-прежнему замечательно работать.

Дальше наступает очередь уровня RAID. Как правило, современные стеки имеют два подуровня на этом уровне. На каждом подуровне располагаются элементарные RAID, такие как: chain или span (это не совсем RAID, это просто “суммирование” емкостей с разных дисков), RAID0, RAID1, RAID1E, RAID5, RAID6 и т.д.

Самый нижний подуровень принимает логические диски, например, LD1, LD2, LD3, как на рисунке, и «выпекает» из них том RAID5. То же самое происходит и с LD4, LD5, LD6. Из них получаем второй RAID5. Два RAID5 тома подаются на еще более высокий уровень, где к ним применяют функцию RAID0. На выходе мы получаем комплексный том, называемый RAID50 (где 5 означает тип RAID, используемый на нижнем подуровне, а 0 – тип функции RAID с верхнего уровня). Единственное, чего не хватает в определении – сколько RAID5 (в данном случае 2) было использовано для создания RAID50. В стеке Adaptec это называется second level device. Этот параметр будет нужен, если Вы будете создавать сложные тома типа 50 или 60.

На рисунке — Виртуальный контейнер типа RAID1. Операция build.

Если у Вас новые диски, с фабрики, то в их секторах записаны нули. Поэтому результат действия обеих функций будет одинаковым.

Отличие между SimpleVolume и HBA режимом.

Эти два режима крайне похожи друг на друга. Оба могут использоваться для создания Software RAID решений.

При работе диска в HBA режиме на нем не создаются метаданные. И нет «подрезания» ёмкости функцией coercion. Это может вызвать проблему при необходимости замены диска на диск другого производителя. Диск напрямую передаётся операционной системе. При этом кэш контроллера с ним работать не будет!

В случае создания Simple Volume через конфигурацию томов, на диске создается область метаданных, “подрезается” емкость функцией coertion. Далее через утилиту конфигурации создается Simple Volume том с использованием всей свободной емкости диска. И после этого данный объект передается в работу центральной операционной системе.

Сегодня стеки RAID контроллеров постоянно совершенствуются. Компания Adaptec в своей функции MaxCache plus устанавливала еще один уровень в стек, так называемый уровень tier, c подуровнями. Это позволяло взять один RAID5 том, созданный на SSD дисках, и другой том, например, RAID60, созданный на дисках SATA с 7200 rpm и собрать из них комплексный, виртуальный том, где наиболее востребованные данные хранились на RAID5, а наименее востребованные на RAID60. При этом тома можно было брать с разных контроллеров. Сегодня эта функция не поддерживается в силу перехода таких возможностей в серверные операционные системы. Естественно, стек контроллеров, как виртуализационный механизм, не стоит на месте и постоянно совершенствуется и на уровне виртуализации и на уровне основных и сервисных функции.

Устройство современного RAID контроллера.

Современный RAID контроллер представляет из себя информационную систему (упрощенно – компьютер), которая в силу выполнения своих основных функций: создания виртуального контейнера, размещения и обработки информации в контейнерах (по сути, ЧТЕНИЕМ – ЗАПИСЬЮ информации) обменивается данными с двумя другими типами информационных систем:

1. C операционной системой;

2. С HDD или SSD дисками.

С точки зрения внутренней архитектуры, современный RAID контроллер представляет из себя следующий набор основных подсистем:

Таблица — Основные подсистемы RAID контроллера.

Основные функции современных RAID контроллеров Adaptec.

Поддержка режима HBA.

Мы уже рассмотрели выше, какие модели RAID контроллеров поддерживают режим HBA. Важно отметить, что это делается независимо для каждого диска. Т.е., на контроллере, если вы не будете инициализировать часть дисков на физическом уровне, они автоматически попадут в программу типа «disk manager» и будут там видны и доступны для работы с ними. Вы можете одну часть таких дисков в режиме HBA использовать как одиночные диски, а другую часть использовать для создания software RAID средствами операционной системы. Проинициализированные диски будут использоваться для создания RAID томов средствами RAID контроллера.

На последних версиях прошивки контроллер Adaptec автоматически создает Hybrid RAID-массив, когда вы создаете RAID 1/10 из одинакового количества SSD и HDD (но в старых прошивках было важно, чтобы в RAID1 парах SSD диск стоял «мастером», а HDD диск «слейвом»). Если Вы не знаете, как это проверить – обратитесь с службу тех. поддержки Adaptec. Контроллер Adaptec делает запись одновременно на HDD и SSD. В режиме гибридного тома чтение идет только с SSD! (для тома из двух HDD дисков при превышении некоторого порога операций ввода-вывода чтение происходит с двух дисков. В этом главное отличие гибридного режима RAID1/10). Результат – надежный массив с отличной производительностью чтения. Чтение как у одиночного SSD диска. Это на несколько порядков выше чему у HDD. Функция стандартно поставляется со всеми контроллерами Adaptec Series 2, 5,6, 7, 8.

Поддержка типов томов, являющихся заменой RAID5.

Надеюсь, вы хорошо представляете себе контейнер RAID5 — это достаточно классическое решение.

Красным показан контейнер хранения информации, созданный RAID контроллером. Это контейнер типа RAID5. Сам том RAID5 состоит из большого количества таких виртуальных контейнеров, сложенных в некоторую «пачку». Контейнер RAID5 состоит из набора секторов отдельных физических дисков. Особенность контейнера RAID5 заключается в том, что он может «пережить» проблемы в ряде контейнеров жестких дисков, из которых он состоит, т.е., секторы жестких дисков, которые входят в состав RAID5 контейнера, теряют свою информацию, но сам RAID5 контейнер ее хранит. Это происходит до определенного предела. При некотором количестве «испорченных» секторов сам RAID5 контейнер уже не сможет гарантировать 100% хранение информации. Из-за перехода с технологии SCSI на технологию SAS предлагаемое базовое качество хранения информации контейнером RAID5 очень сильно ухудшилось, буквально, на несколько порядков.

Все это увеличивает вероятность возникновения проблем в одном контейнере RAID5, что значительно уменьшает вероятность сохранения информации в томе RAID5. По этой причине в современные стеки RAID контроллеров добавлены решения, которые позволяют исключить использование RAID5. Это RAID1E, RAID5EE и RAID6.

Раньше единственной альтернативой RAID5 был RAID10. Поддержка RAID 10, естественно, сохранилась.

Варианты замены RAID5:

Раньше, если даже один контейнер контроллера (страйп) терял информацию или не мог гарантировать ее сохранность, это приводило к ситуации перевода всего тома в режим offline со стороны RAID контроллера (остановка доступа, буквально, означала – контроллер не может гарантировать 100% целостность пользовательских данных на томе).

Современный контроллер “отрабатывает” такую ситуацию по-другому:

1. Доступ к тому не останавливается;

2. На томе выставляется специальный маркер “bad stripe”, которые означает, что в RAID томе есть специальные контейнеры, которые потеряли информацию;

3. О таких «испорченных контейнерах» сообщается операционной системе, чтобы она могла оценить возможные меры по предотвращению потери информации или ее восстановлению.

Маркер bad stripe невозможно удалить с тома. Можно только такой том удалить и создать заново. Появление тома с флагом «bad stripe» говорит о СЕРЬЕЗНЫХ ошибках или проблемах на этапе проектирования системы хранения или на этапе ее эксплуатации. Как правило, за такой ситуацией стоит серьезная некомпетентность проектировщика или системного администратора.

Основной источник проблем такого рода — неправильно спроектированный RAID5.

Некоторые реализации RAID 5 (например, RAID5 на десктопных дисках) запрещены для томов с пользовательскими данными. Требуется, как минимум, RAID5 + Hot Spare, что не имеет смысла при наличии RAID6. Получается, что там, где надо было создать RAID6, был создан RAID5, что через несколько лет эксплуатации привело к появлению маркера BAD STRIPE.

Функция SSD кэширования является одной из самых востребованных функций для оптимизации производительности RAID томов мощных систем хранения с большим количеством пользователей без значительного увлечения стоимости, количества юнитов решения, без потери емкости системы хранения и обеспечения оптимального энергопотребления.

Для применения SSD кэширования на запись, следует убедиться в выполнении двух условий:

1. Приложение работает в режиме «случайного чтения»;

2. Запросы к данным имеют неравномерную природу – есть контейнеры уровня RAID, к которым обращаются чаще, чтобы считать оттуда данные, а есть те, к которым обращения идут реже.

Надо отметить, что чем больше пользователей у системы, тем вероятнее, что запросы к отдельным контейнерам примут форму стандартного статистического распределения. По параметру «количество запросов в единицу времени» можно выделить условно «горячие данные» (количество обращений к ним будет больше заданного параметра) и «холодные данные» (количество обращений к ним меньше заданного параметра).

Работа SSD кэш на чтение заключается в копировании «горячих данных» на SSD диски и дальнейшем чтении с SSD, что ускоряет процесс в разы. Поскольку это копирование, то кэш на чтение имеет естественную защиту, если SSD диск, формирующий область SSD кэш, выходит из строя, это приводит только лишь к потере производительности, но никак не к потере данных.

Основные настройки функции SSD кэширования для контроллеров 7Q, 8Q:

1. Прежде всего убедиться, есть ли у Вас «горячие данные» и какой они имеют размер. Лучше всего это сделать экспериментально, поместив достаточно большой SSD диск в область кэша и сконфигурировав его в режиме Simple Volume. Такую работу могут сделать для Вас компании-интеграторы. Примерно через неделю через функцию управления можно снять статистику SSD кэширования. Она покажет есть ли у Вас «горячие данные» и какой объем они занимают.

2. К данному объему желательно добавить10-50 % емкости и на основании этих данных настроить Вашу схему кэширования на случай увеличения объема «горячих данных» в будущем, если такая тенденция есть.

Настройки позволяют от емкости ваших SSD дисков «отрезать» нужную емкость, забрать ее в RAID том нужного типа, а оставшуюся емкость можно перевести в обычный RAID том.

Далее следует оценить, есть ли смысл использовать SSD кэш на запись. Как правило, интернет приложения работают на чтение. Кэш на запись, в основном, используется как дополнение к кэшу на чтение, если приложение помимо чтения использует и запись. И в случае использования кэша на запись требуется обеспечить защиту кэша. Если что-то случается с областью кэша, то данные, помещенные туда при кэшировании записи, будут потеряны. Для защиты достаточно использовать RAID том, дающий избыточность по дискам, например, RAID1.

Возможные режимы конфигурации SSD кэш области.

Для отдельных томов на контроллере можно независимо включать и выключать SSD кэш на чтение и на запись в зависимости от потребностей и типов приложений, работающих с каждым томом.

Все контроллеры и HBA текущей линейки продуктов Adaptec поддерживают режим uEFI биоса материнских плат. Переход с MBR на uEFI позволил, например, создавать системные и загрузочные тома больше 2TB, что было невозможным на платах с MBR BIOS (отметим, что все продукты Adaptec полностью поддерживают тома >2TB, со стороны контроллеров и HBA этой проблемы не существует). Есть много других преимуществ использования uEFI режима. Например, при поддержке дисков с размером сектора 4K. Все продукты Adaptec текущей линейки поддерживают диски с сектором 4К, кроме 6-ой серии контроллеров.

Важно помнить, что если материнская плата использует режим MBR, то утилита конфигурации контроллера вызывается через Cntrl +A.

На рисунке стандартная утилита конфигурации Adaptec, вызываемая через комбинацию клавиш Cntrl +A.

В случае режима uEFI конфигуратор контроллеров и HBA интегрируется в BIOS материнской платы. Эту утилиту легко найти по строчкам, содержащим слово «Adaptec» или «PMC». И, как видно на примере ниже, uEFI утилита имеет более расширенный функционал, чем утилита, вызываемая через Cntrl + A.

Функции Hot Spare.

Hot Spare диск выполняет роль пассивного элемента RAID тома, и «забирается» в RAID том, если с каким-то из дисков в составе тома что-то случилось, и он больше недоступен для выполнения своей работы. HOT SPARE называется диск, который установлен на контроллер, раскручен и назначен к одному или нескольким томам.

Относительно последней части определения HOT SPARE, можно создать 3 вида дисков:

Hot Spare диски используются в стеке Аdaptеc для ручного «ремонта» томов, у которых по разным причинам вышел из строя один диск. Например, Ваш RAID5 том потерял один диск и перешел в состояние «degraded». Вы вставляете новый диск вместо старого или в любой другой свободный слот, нажимаете функцию rescan и теперь видите новый диск на уровне физических дисков стека. Далее – объявляете его как HOT SPARE (неважно какого типа, например, Global Hot Spare) и ждете, когда это диск на 100% «встроится» в том. Том переходит в состояние – Optimal. После этого, Вы выбираете команду – delete hot spare. Эта команда снимает статус HOT SPARE с данного диска, и он становится полноценным участником данного RAID тома.

Функция Power Management.

RAID тома работают по-разному. Например, тома, созданные для резервного копирования данных, могут использоваться для перемещения данных, к примеру, два – три дня за месяц. Возникает вопрос: насколько хорошо подавать питание на жесткие диски и держать диски раскрученными, если фактически все оставшееся время они не используются?

Решением этого вопроса занимается функция power management. Ее философия – если диски не используются, их вращение можно замедлить (если такая функция поддерживается дисками), а потом полностью остановить и держать, пока они не понадобятся, в выключенном состоянии. Настройки данной функции крайне простые.

Сначала целиком на контроллер задается время по дням недели, когда эта функция активирована, а когда нет. Эта настройка привязана к работе типичной компании. Задаются параметры введения в работу внутренних и внешних дисков – попарно, по три, по четыре и т.д., чтобы распределить нагрузку на блоки питания. Кроме этого, задаются три значения таймера. По истечении первого, если нет операций ввода-вывода на диски данного тома, то эти диски перейдут в состояние «stand by», т.е. уменьшат свои обороты на 50%. Не все диски поддерживают этот режим, если он не поддерживается, то с диском ничего происходить не будет. По истечении второго таймера диски полностью остановятся и перейдут в состояние «power off». Третий таймер используется для периодической проверки дисков, которые выключились надолго. Контроллер включает диски, проводит их недеструктивную проверку и, если все ОК, то переводит их снова в «power off» состояние.

После этих настроек Вы можете активировать power management схему для каждого тома, где это будет полезным. Такие тома в системе управления будут помечаться зеленым цветом. Максимум преимуществ данная функция дает при использовании в центрах обработки данных, позволяя не только прямую экономию энергии за счет остановки дисков, но и вспомогательную экономию за счет уменьшения оборотов вентиляторов, обдувающих диски, когда последние переводятся в выключенное состояние.

Управление системами хранения Adaptec.

Утилиты управления, которые входят в пакет Max View Storage Manager (MSM) построены на самых передовых стандартах и используют самые последние тенденции в совершенствовании принципов и улучшении эффективности управления. Поэтому мы легко можем использовать Adaptec Max View Storage Manager как базовую модель, чтобы посмотреть на основные функции и методы в области управления системами хранения. В качестве основного элемента управления используется RAID контроллер, который может обмениваться служебной информацией с дисками, экспандерами и корзинами и, таким образом, поддерживать функции управления для всей подсистемы хранения в целом.

• Высокий уровень детализации, визуализации и вложенности объектов управления. Администратор может видеть, что весь сегмент сети стал красным, это означает – существует неисправность. Если раскрыть иконку сетевого сегмента, то будут видны все сервера. Проблемный сервер будет отмечен красным цветом. Если кликнуть мышкой на этом сервере будут видны RAID контроллеры, установленные в этой системе. Красный цвет одного из них означает какую-то проблему. При дальнейшей детализации будут видны тома, созданные на этом контроллере и проблемный том. И так с точностью до проблемного физического диска. Теперь администратор точно знает, что случилось, к каким последствиям это привело, и какой диск надо заменить.

• Высокий уровень безопасности систем управления при использовании стандартных сетевых протоколов. Механизмы управления системами хранения, очевидно, нуждаются в защите. Ведь при несанкционированном доступе или при открытом канале управления пользовательские данные могут быть уничтожены без возможности восстановления. С этой целью MSM использует базу пользователей и паролей из самой операционной системы. Кроме этого, на канале между браузером и сервером управления используется шифрование трафика через протокол HTTPS. В других компонентах системы управления вопросы безопасности также решаются на самом высоком уровне.

• Возможность отправки важных сообщений из системы хранения администратору. Чтобы не «приковывать» навеки взгляд администратора к экрану с MS в WEB браузере, система управления может быть настроена на отправку сообщений по E-mail. MSM имеет возможность отправлять все типы сообщений, включая тестовые. Наибольшую важность имеют сообщения типа Warning и Error, которые напрямую связаны с переходами RAID томов в состояние Degrade и Failed. Такие сообщения через почтовые приложения могут быть легко переданы на мобильный телефон администратора.

Все эти и многие другие функции делают системы управления устройствами хранения незаменимыми помощниками в ежедневной работе.

Продолжение следует.

Вас ждет классификация контроллеров Adaptec.Подробное описание 6, 7 и 8 серии RAID контроллеров Adaptec, 6 и 7 серии HBA Adaptec.Подписывайтесь на хаб Тринити

Информация предоставлена компанией Adaptec by PMC (Россия). Полный текст статьи можно найти на сайте Adaptec